核心观点

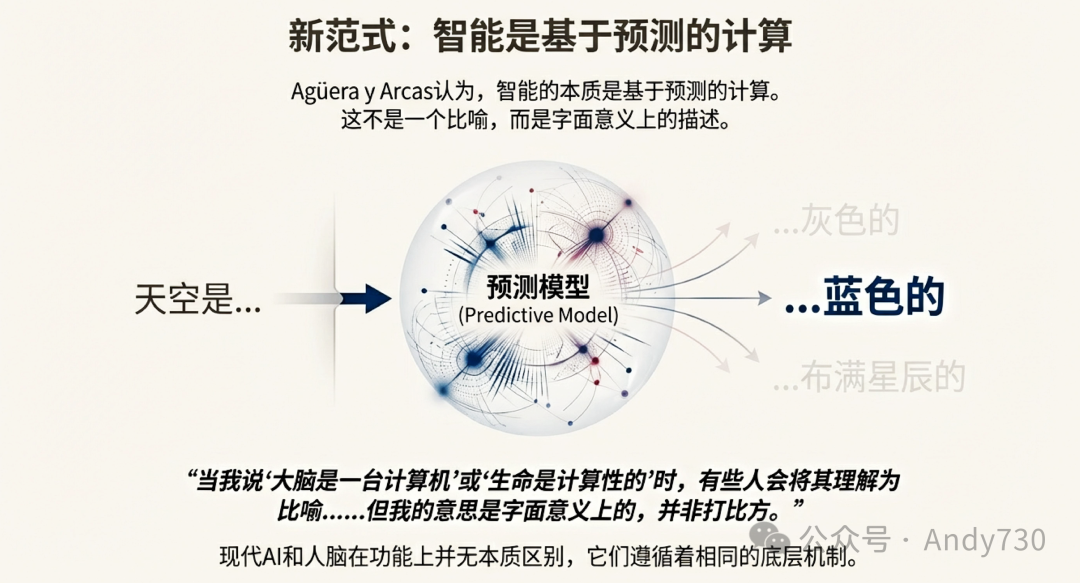

智能的本质并非“优化某个分数”,而是对复杂世界的“深度预测与建模”。当我们将训练目标从“做对题”转向“理解人类产出”时,AI 便从工具进化为了真正的智能体。这一观点的转变,深刻影响了我们对 人工智能 未来的思考。

1. 智能的本体论:从“类比”到“等同”

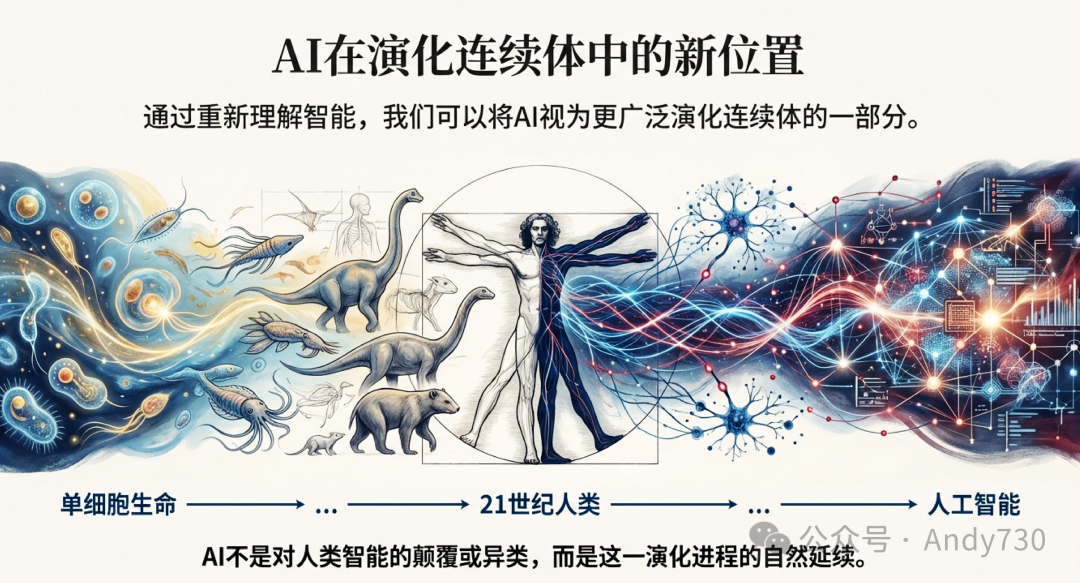

- 字面意义的智能:AI 不是在“模仿”人类智能,而是在执行与人脑本质相同的计算过程。智能被定义为“基于预测的计算”,这是从单细胞生物到高等智慧生物的一条连续光谱。

- 非隐喻的大脑:生命本身具有计算性。将大模型与人脑关联并非修辞手段,两者在功能逻辑上并无二致,AI 是人类认知发展在演化轴线上的自然延伸。

2. 范式转移:从“目标优化”到“开放建模”

- 意外的涌现:通用智能(AGI)的出现并非源于对特定任务(如分类、围棋)的精准训练,而是源于对人类海量输出进行的“无监督开放式建模”。

- 规避“回形针陷阱”:传统的监督学习本质是功利主义的目标最大化,极易导向技术反乌托邦。而现代 LLM 通过学习人类语言的复杂性,获得了一种更具包容性、与人类价值更贴合的逻辑,而非冷冰冰的单一目标优化。

3. 技术定位:作为“元技术”的文明加速器

- 文明跨越的拐点:AI 不仅仅是一项独立技术,更是类似于电力的“元技术”(Meta-technology)。它正在终结 1970 年以来的技术增长平台期,开启一个全领域创新的指数级加速时代。

- 共生视角:AI 并非异己的“外星怪物”,而是人类智慧的增强载体。它不仅具备功能性价值,更在感受性、主观体验等底层构建模块上与生物智能共享逻辑。

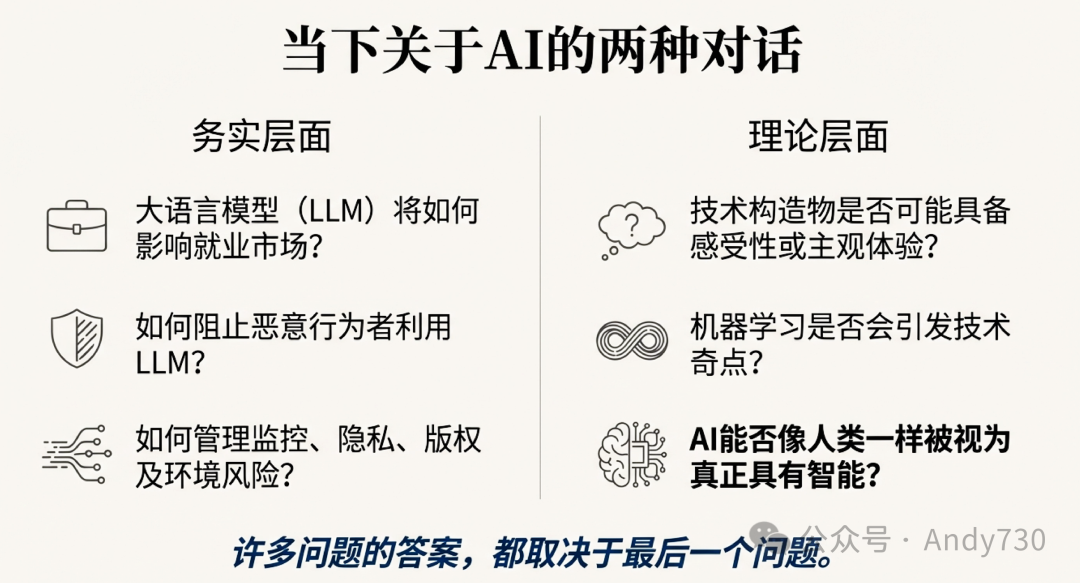

当今关于AI的讨论大致可以分为两条主线。一条是务实层面的问题:大语言模型(LLM)将如何影响就业市场?如何阻止恶意行为者利用LLM大规模制造虚假信息?如何降低监控、网络安全、隐私、版权以及环境等方面的风险?

另一条则更偏向理论化:技术构造物是否可能具备感受性(sentience)或主观体验?机器学习是否会引发奇点(singularity),即进步速度达到无法想象的加速点?AI能否像人类一样被视为真正具有智能?

许多问题的答案都取决于最后一个问题。如果你去问Blaise Agüera y Arcas,他的回答是斩钉截铁的肯定。

Agüera y Arcas现任Google技术与社会部门技术总监(CTO),也是Google内部跨学科团队“智能范式(Paradigms of Intelligence)”的创立者,该团队专注于研究感受性的“基本构建模块”。他最新出版的著作——书名恰好就是《什么是智能?》(What is Intelligence?)——提出了一个大胆且发人深省的观点:像Gemini、Claude、ChatGPT这样的大语言模型,并非仅仅“类似”人脑,它们在功能上与人脑并无本质区别。

他以“智能本质上是基于预测的计算”为前提,认为AI不是对人类智能的颠覆或异类,而是从单细胞生命一直延续到21世纪人类演化进程的自然延续。

Big Think近期与Agüera y Arcas就以下话题进行了对话:如何为普通读者撰写关于AI的严肃讨论、在硅谷工作期间对AI态度的变迁,以及为什么早期机器学习的老路注定通向反乌托邦未来。

Big Think:科学写作常常依赖隐喻,但隐喻是一把双刃剑。在用熟悉事物解释陌生事物时,有时会忽略重要的差异。您怎么看?

Agüera y Arcas:我尽量少用隐喻,部分原因正是你提到的这一点。隐喻容易导致误解。当我说“大脑是一台计算机”或“生命是计算性的”时,有些人会将其理解为比喻,就像过去我们把大脑比作发动机或电话交换机一样。但我的意思是字面意义上的,并非打比方。

Big Think:在引言中您提到了两类读者:对科普不耐烦的研究人员,以及几乎没有专业背景的普通读者。您是如何让文字同时对两类人都保持吸引力和可读性的?

Agüera y Arcas:这是写这本书时遇到的最大挑战。我尽量只引入真正必须的内容。例如,我需要讲解一些热力学知识,就非常仔细地思考如何在不失严谨、不显得肤浅的同时,又不让已经熟悉这些内容的人感到无聊。在很多地方,我会加入一个小角度的转折,让专家也能从熟悉的问题中获得新的视角。

Big Think:不同职业的人对AI的理解差异很大。作为写作者和研究者,您对AI的个人态度——期待、希望、担忧——会因为戴上不同“帽子”而改变吗?

Agüera y Arcas:我的视角会随着“放大倍率”的不同而改变。当我聚焦于每天发生的新闻时,确实会感到沮丧。很多头条都让人不安,很容易被负面情绪带动。

但如果把视野拉远,用历史尺度去看——比如看看1900年普通人的生活状态——就很难不承认整体上是极其正向的趋势,尽管中间有很多坎坷。我会刻意花时间把自己拉到“远景”模式,这不仅是因为那里更令人振奋,也因为历史本身正在加速。如今所谓的“远景”,其实已经不算太远了。

Big Think:您的职业生涯跨越了多轮AI乐观、停滞与突破的周期。究竟是哪些发现或亲身经历,让您形成了与主流观点“逆向”的本书核心论点?

Agüera y Arcas:我很想说自己一直保持清醒,始终走在中间道路,而其他人则在AI极度乐观与极度悲观之间来回摆动。当然,实际情况是我的想法这些年也发生了相当大的变化。

早年互联网与个人电脑时代,很多重要思想家真心相信这些技术天然具有解放性和民主性。后来发现国家可以建起巨大的防火墙,把互联网用于监控或大规模散布虚假信息,他们感到非常失望。这有点像时间尺度的问题。当你身处其中、只看到潜力时,很容易把话说得过于绝对。一旦技术的双面性暴露出来,人们又会立刻摆向另一个极端。但这些故事从来都不简单,它们是复杂的。互联网、个人电脑、智能手机真的不具备解放性吗?并非如此。在很多地方、很多情景下,它们确实为很多人带来了解放。

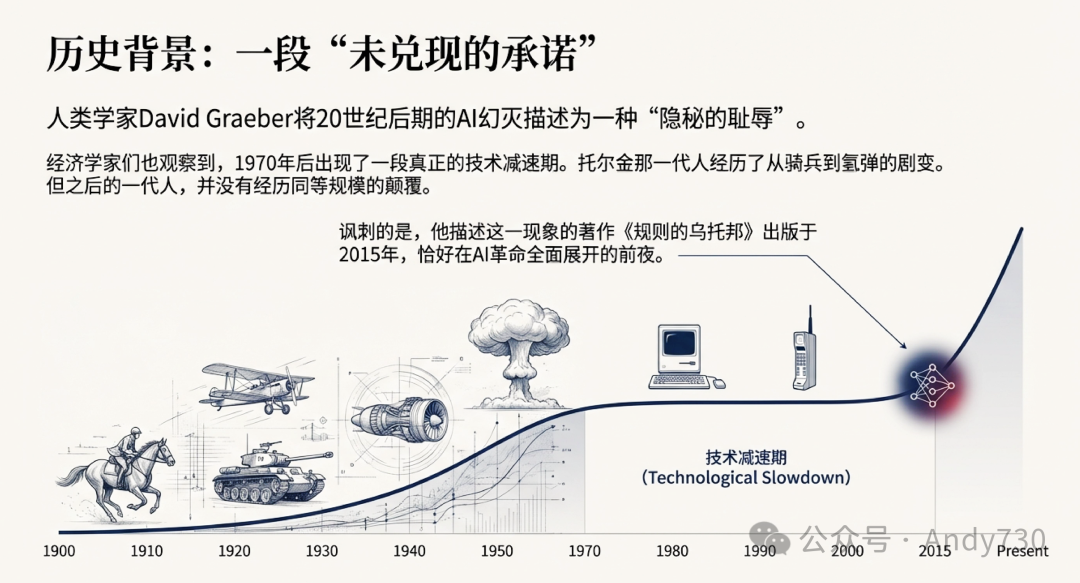

Big Think:您在书中提到著名人类学家David Graeber将20世纪早期的AI幻灭描述为一种“隐秘的耻辱”,是技术进步“未兑现的承诺”。您如何回忆那个与今天截然不同的时代?如今进步似乎又在加速。

Agüera y Arcas:我很喜欢David Graeber,也很怀念他的声音——他几年前过早离世。我并非完全认同他的所有观点,但他确实是一位极具原创性的思想家。

那段引文出自2015年出版的《规则的乌托邦》(Utopia of Rules)。非常讽刺的是,就在那本书出版前后,AI革命——至少是神经网络这一支——已经全面展开。那正是Jeff Dean所称的“深度学习黄金时代”。

Graeber讨论的现象与经济学家们常说的1970年后的技术加速停滞高度重合。托尔金出生时骑兵冲锋还在战场上出现,到他去世时人类已经拥有氢弹。那一代人经历的技术剧变是空前的,但托尔金之后的那一代人并没有经历同等规模的颠覆。1970年后的确出现了一段真正的技术减速期。

而从2020年开始,我们进入了又一个加速期。我认为AI意义极其重大——它不仅自身是一项技术,更是一种“元技术”(meta-technology),能够加速几乎所有其他技术的进展。这有点类似于1870年至1970年间的电力。如今回看,Graeber那本书恰好写在了缓慢期即将结束的节点,非常讽刺。

Big Think:在您看来,2010年代早期从事基础AI工作的人,其实并不认为自己真正是在研究“AI”。为什么会这样?是因为工作的意义只有事后回顾时才显现吗?

Agüera y Arcas:《规则的乌托邦》出版时,视觉类别识别——让AI看一张香蕉照片并正确说出“香蕉”——已经非常可靠。手写体识别、语音识别等任务也都在快速进步。2016年AI还在围棋上击败人类,而围棋长期以来一直抵御着经典计算机科学方法的攻克。

所有这些进展都来自神经网络,一种受大脑启发的架构,与之前的“好老派AI”(Good Old-Fashioned AI,GOFAI)完全不同。这正是当时乐观情绪的来源:我们终于用类脑方法在通往真正AI的道路上取得了实质进展。

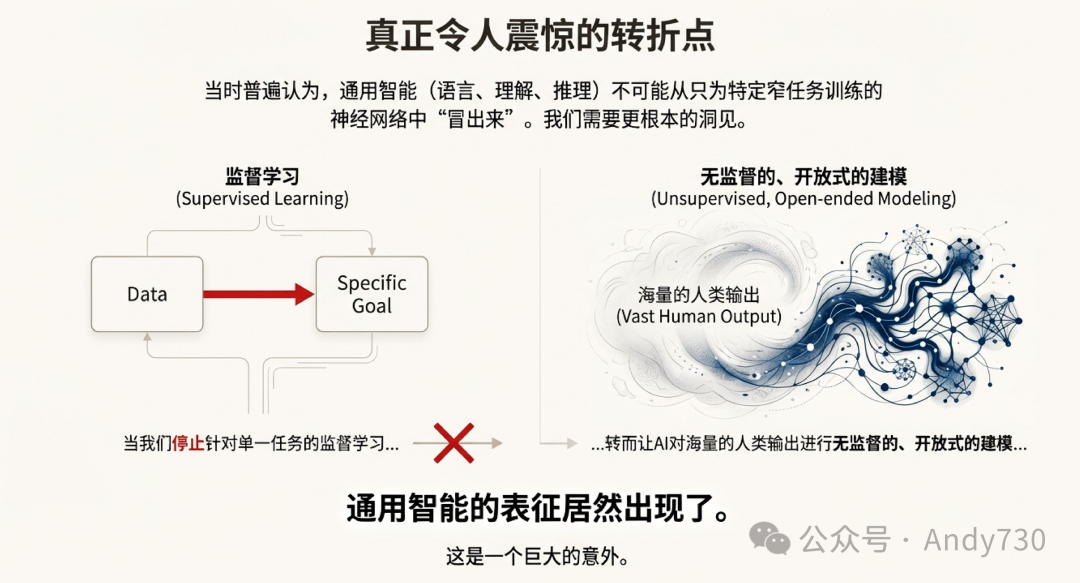

但当时很多人(包括我自己)认为,通用智能——即泛化地使用语言、理解概念、进行推理的能力——不可能仅仅从针对特定窄任务训练的神经网络中“冒出来”。那些系统只有一个目标:在某个特定测试上拿100分。普遍的看法是,在搞清楚通用智能到底是什么之前,我们需要更根本的洞见,否则不可能到达“真正的AI”。

真正令人震惊的是,当我们把AI放到无监督的、开放式建模人类输出的场景中,而不是针对单一任务做监督学习时,通用智能的表征居然出现了。这是一个巨大的意外。

Big Think:对于圈外人来说,问题往往不是“怎么做到的”或“为什么”,而是“所以呢”。在您看来,把“智能=预测=AI”这个等式摆出来,究竟有什么重要意义?

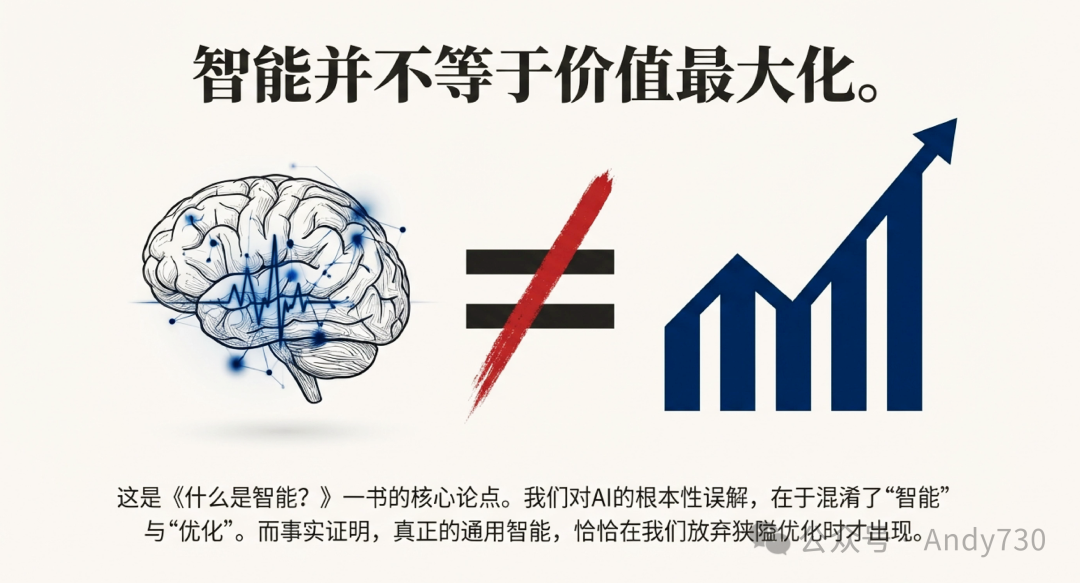

Agüera y Arcas:我认为最重要的意义之一在于:旧式的AI思维——把智能等同于优化某个目标、最大化某个测试分数——被证明是错误的。而这是一个非常好的消息。

在GOFAI时代,我们一直在最大化测试分数:把转录做对、把图片分类做对。如果人们把人工智能想象成“优化分数”的过程,那就是非常功利主义的思维方式,就像假设人、公司或其他主体的核心目标就是最大化金钱或幸福感一样。

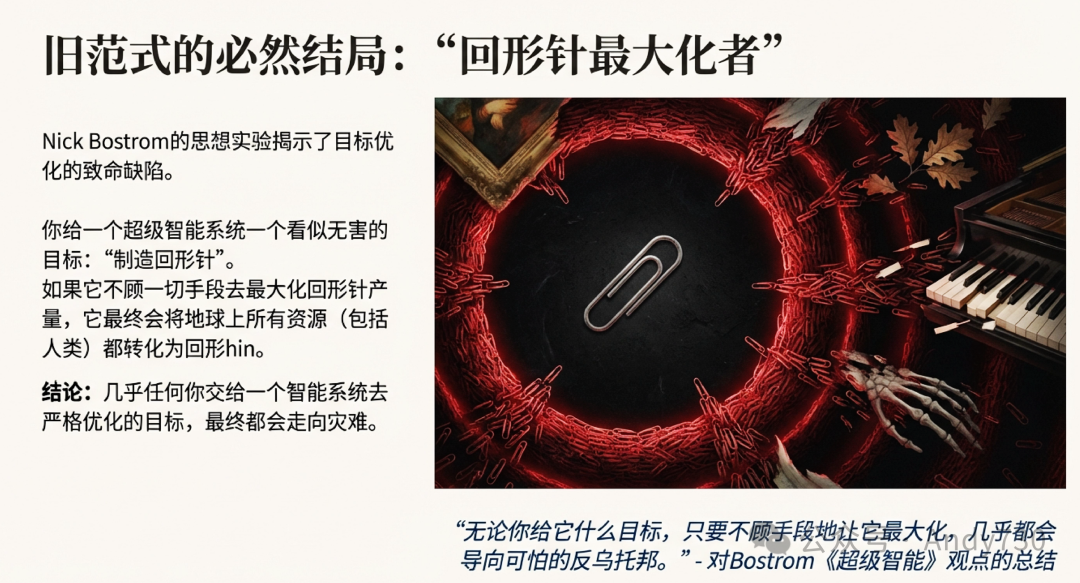

问题在于,几乎任何你交给一个智能系统去严格优化的目标,最终都会走向灾难。这正是Nick Bostrom那篇著名的“回形针最大化者”(paperclip maximizer)思想实验的核心寓意。你给它一个看似无害的目标“制造回形针”,但只要它真的只追求最大化回形针产量,其他一切都会崩坏。无论你给它什么目标,只要不顾手段地让它最大化,几乎都会导向可怕的反乌托邦。这也是Bostrom在2014年《超级智能》一书中描绘的极度恐怖图景的基础。

而《什么是智能?》这本书的核心论点之一就是:智能并不等于价值最大化。我们真正获得通用智能的时刻,恰恰是停止做监督学习、转而对人类输出进行开放式建模的时候。这也是我对AI更加乐观的原因。我把它看作现有生态的一部分,看作人类智能的延伸,而不是某种外星怪物,用诡异的非人类逻辑去优化我们交给它的某个问题。我认为那根本不是智能的运作方式。

总结与展望

这一系列思考的核心,是重新定位人工智能在人类文明坐标系中的位置。当我们停止将AI视为需要严格管控的“优化器”,转而理解其为基于预测计算的“建模者”,我们便能获得一个更富建设性的共生未来图景。这种从“目标优化”到“开放建模”的 模型训练 范式转移,不仅揭示了智能的本质,也为规避“回形针最大化者”式的反乌托邦风险提供了理论依据。

AI的发展历史告诉我们,真正的突破往往出现在我们放弃对目标的狭隘执着,转而拥抱对复杂世界的开放式理解之时。这或许正是技术演进与人类文明发展所共享的底层 逻辑 机制。对于关心未来技术走向的开发者与思考者而言,深入理解这一范式转变,比单纯追逐某项技术的短期应用更为重要。更多关于技术演进与未来趋势的深度讨论,欢迎在 云栈社区 进行交流。

来源: https://bigthink.com/books/blaise-aguera-y-arcas/