导读:自由软件基金会的创始人不断进行巡回演讲。在慕尼黑,他呼吁更多地使用开源软件——尤其是在国家层面;同时,他也指出了 ChatGPT 的问题,并写下了相关文章。

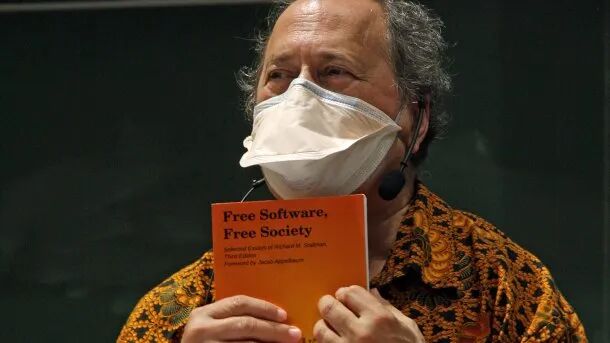

自由软件(Free Software)之父、GNU 计划创始人理查德・斯托曼(Richard Stallman,简称 RMS)最近在他的个人网站上发布了一篇引人注目的文章,题为《Reasons not to use ChatGPT》。

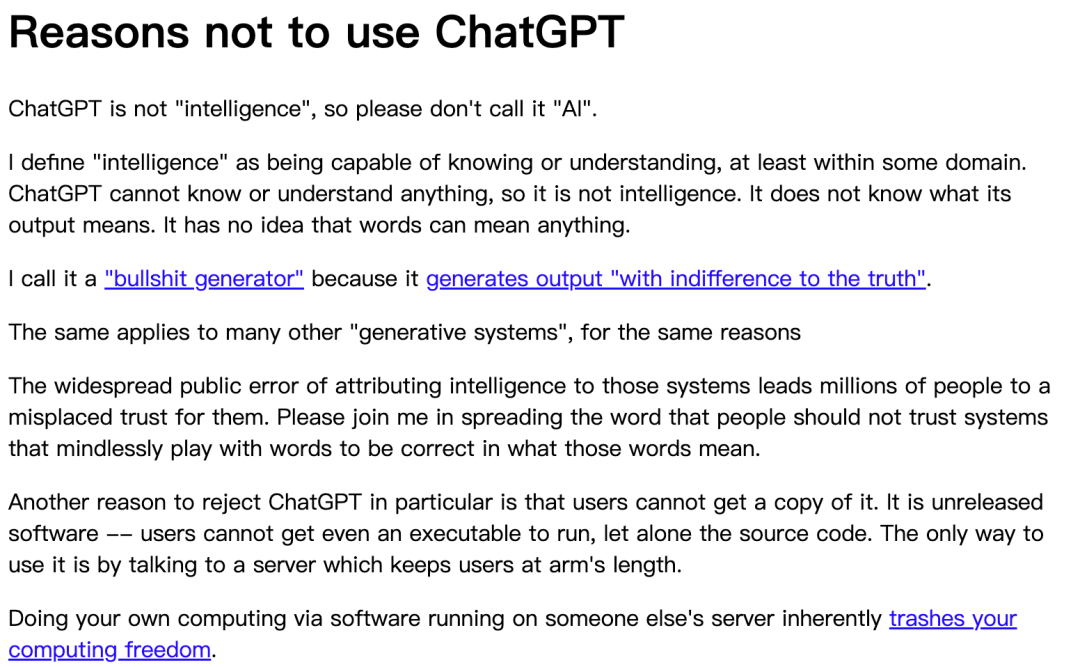

不使用 ChatGPT 的原因

在这篇文章中,他明确表达了对当前热门的人工智能聊天工具 ChatGPT 的强烈反对意见。斯托曼开篇指出,ChatGPT 并不是真正的“智能”,因此不应该被称为“人工智能”。

他再次强调了对 ChatGPT 的强烈反对态度,并把讨论的焦点放在两个层面:它是否真的“理解”,以及使用它会带来怎样的计算自由成本。

“胡说八道生成器”:它能输出,但不等于理解

斯托曼在文章开篇就指出,ChatGPT 并不是真正的“智能”,因此不应该被称为“人工智能”。在他的定义里,“智能”意味着能够在某一领域内认知、理解并掌握知识;而 ChatGPT 并不具备这种能力。

他认为,这个工具无法理解自己的输出内容。它的生成过程更像是在随机拼凑文字,而不是基于意识或意图进行思考。

也正因如此,他称其为“胡说八道生成器”:因为它产生的内容常常与事实无关,并且可能完全无视真实。问题不在于它“会不会写”,而在于它可能写得很像、却并不可靠——当读者把这种流畅表达误当成可信结论时,风险就出现了。

计算自由的代价:私有云端服务意味着失去控制

除了对 ChatGPT 的“智能性”提出质疑,斯托曼还指出:使用这个工具,意味着用户在计算自由方面的损失。

他强调,ChatGPT 是一款私有软件,运行在云端服务器上,用户无法获得它的源代码或执行文件。这样的使用方式,会让用户在与服务器互动时,失去对自己计算过程的掌控。

在他看来,依赖别人的服务器完成计算,本质上是在削弱自己的计算自由:你不知道系统内部如何运作,也无法验证它如何处理你的输入与输出,更无法用自己的方式去修改、审计或约束它的行为。这一点,与他长期倡导的自由软件理念直接冲突,也与他对云计算/云原生形态下“控制权转移”的担忧相呼应。

面向生成式系统的提醒:别把“文字游戏”当成可信知识

在这篇文章中,斯托曼呼吁公众对这些“生成式系统”保持警惕。他认为,很多人对这类工具的误解,会带来不必要的信任。

他希望传播一个重要信息:不要相信那些仅仅是文字游戏的系统。因为它们对语言含义的理解是极为有限、并且可能是错误的。换句话说,当一个系统缺乏“理解”的基础,却能持续生成看起来合理的句子时,用户就更需要提高鉴别与校验意识。

从更广义的角度看,这也是对人工智能应用边界的一次提醒:在真实业务与公共决策场景里,“能说”不等于“可信”,“像答案”也不等于“是答案”。

小结:换个视角看 AI 的应用与影响

斯托曼的观点提供了一个不同的观察角度,让我们重新审视当下技术发展的方向,尤其是生成式系统在“可信度”和“控制权”两方面的长期影响。

如果你关心开源与软件自由相关讨论,可在 云栈社区 持续跟进更多一线观点与实践经验。 |