前端的字节数据处理能力,常常被开发者忽视,但它正成为支撑现代复杂应用的关键基础。在传统 Web 开发中,我们与字符串、JSON 打交道更多,很少触碰底层“原始数据”。然而,当业务开始涉及音视频处理、文件系统交互、实时通信、数据加密时,这种能力就变得不可或缺。特别是在 AI 时代,无论是流式数据的接收、语音交互的实现、文件上传的优化,还是向量存储的底层操作,都与字节数据处理息息相关。

ArrayBuffer、Uint8Array、Blob、File、Buffer、Stream……这些概念并不新,但在项目中常常是“临时补课”的状态,知识零散割裂。本文将系统梳理前端处理字节数据的核心概念、典型场景,并探讨其在 AI 应用开发中的具体实践。

一、从“字节”开始理解数据本质

在 JavaScript 的日常开发中,我们熟悉的数据形态往往是这样的:

"hello"

{ a: 1 }

[1, 2, 3]

但这仅仅是语言层面的高级抽象。在计算机的底层,所有数据最终都表现为 一段连续的字节序列。一个字节由 8 个二进制位组成,取值范围是 0 到 255。无论是文本、图片、音频还是 AI 模型参数,其本质都是按照特定规则排列的字节序列:

0, 1, 2, …, 255

因此,所谓“字节数据处理”,指的就是在 JavaScript 中,以可控且明确的方式去操作这些底层的二进制数据。

二、浏览器基石:ArrayBuffer 与 TypedArray

2.1 ArrayBuffer:原始的二进制内存

ArrayBuffer 是 ECMAScript 标准中定义的一个对象,用于表示一块固定长度的原始二进制数据缓冲区。你可以将它理解为浏览器提供的一块“原始内存”:

const buffer = new ArrayBuffer(8); // 分配 8 字节的内存空间

创建后,你得到了 8 个字节的连续内存,但需要注意几个关键点:

ArrayBuffer 只负责分配内存,它本身不提供任何读写接口。- 它不关心这段内存里的字节代表什么含义(文本、数字还是图片)。

- 直接通过索引访问会得到

undefined(例如 buffer[0])。

这是一个刻意的设计。因为内存本身是“无类型”的,直接读写会引入大量隐式类型转换和不确定性。那么,谁来解释这段内存呢?答案是 TypedArray。

2.2 TypedArray:内存的“解释器”

TypedArray 不是单一类型,而是一系列视图类型的统称,它们都基于一个 ArrayBuffer,并按照固定的数值类型来读写内存。常见的有:

Uint8Array (8位无符号整数,对应一个字节)Int16Array (16位有符号整数)Float32Array (32位浮点数)

在实际项目中,Uint8Array 的使用频率最高,原因很简单:Uint8Array 中的每个元素都直接对应一个字节,这使得它在处理原始二进制数据时最为直观。

const buffer = new ArrayBuffer(4);

const view = new Uint8Array(buffer);

view[0] = 255; // 第一个字节设置为 255

view[1] = 1; // 第二个字节设置为 1

view[2] = 2;

view[3] = 3;

因此,在文件读写、网络协议、加密解密、音视频处理等场景中,Uint8Array 几乎是默认选择。

我们可以这样总结 ArrayBuffer 与 TypedArray 的关系:ArrayBuffer 负责“存”(分配内存),TypedArray 负责“读和写”(定义解释规则),两者通常成对出现。

三、浏览器中的文件语义:Blob 与 File

ArrayBuffer 和 Uint8Array 解决了内存层面的操作问题,但在浏览器中,我们经常需要处理具有“文件”语义的数据,例如上传、下载或创建临时资源链接。这时,Blob(Binary Large Object)就登场了。

Blob 对象表示一个不可变的、原始数据的类文件对象。它是对二进制数据的“文件化”封装。

const blob = new Blob([

new Uint8Array([1, 2, 3])

], { type: 'application/octet-stream' });

Blob 的特点包括:

- 内部封装二进制数据。

- 带有 MIME 类型属性(

type)。

- 可以直接用于

fetch 上传、URL.createObjectURL() 创建下载链接等。

File 对象继承自 Blob,在后者基础上增加了文件名、最后修改时间等元信息,通常来自 <input type=“file”> 或拖拽上传。

const file = new File([blob], ‘demo.bin‘, { type: ’application/octet-stream‘ });

四、浏览器实战场景

掌握了核心概念,我们来看看它们在前端工程中的典型应用。

4.1 大文件分片上传

在处理大文件上传时,直接上传整个文件可能导致超时或内存压力。分片上传是常见优化方案,其核心就是利用 Blob.slice() 和 File API 对文件进行切割,并计算分片哈希用于校验或秒传。

async function uploadInChunks(file, chunkSize = 1024 * 1024) {

const totalChunks = Math.ceil(file.size / chunkSize);

// 可以使用 Web Worker 进行哈希计算,避免阻塞主线程

const worker = new Worker(‘/hash-worker.js’);

for (let i = 0; i < totalChunks; i++) {

const start = i * chunkSize;

const end = Math.min(start + chunkSize, file.size);

const chunk = file.slice(start, end); // 关键:切片

const buffer = await chunk.arrayBuffer(); // 转换为 ArrayBuffer

const bytes = new Uint8Array(buffer); // 得到字节视图

// 计算该分片的哈希值(例如用于秒传校验)

const hash = await computeHash(bytes);

// 发送分片数据及元信息

await fetch(‘/upload’, {

method: ’POST‘,

body: JSON.stringify({ chunkIndex: i, data: Array.from(bytes), hash })

});

}

}

4.2 WebSocket 二进制通信

对于实时性要求高的应用,如在线协作、游戏或 AI 推理流,常使用 WebSocket 进行二进制数据传输。

// 设置 WebSocket 接收二进制数据的类型

ws.binaryType = ’arraybuffer‘;

ws.onmessage = e => {

const buffer = e.data; // 接收到 ArrayBuffer

const bytes = new Uint8Array(buffer); // 转换为可操作的字节视图

// 根据自定义协议解码 bytes...

};

4.3 音频与媒体处理

Web Audio API 等媒体处理流程,每一步都可能涉及字节级别的转换。例如,从 MediaStream 获取音频,到 AudioBuffer 进行分析,最终可能输出为 Float32Array 的 PCM 数据,或编码为 Uint8Array 的 WAV 文件字节流。

五、Node.js 环境下的字节处理

在 Node.js 环境中,字节处理更为核心和普遍。

5.1 Buffer:Node.js 的二进制主力

Node.js 没有将 ArrayBuffer 作为主要接口,而是提供了功能更强大的 Buffer 类。它是 Uint8Array 的子类,并增加了许多适用于服务器端开发的实用方法。

const buf = Buffer.from([1, 2, 3]);

console.log(buf instanceof Uint8Array); // true

Buffer 可以轻松地进行编码转换(如 UTF-8、Base64、Hex)、切片、复制,并与文件系统(fs)、网络(net)等模块无缝集成。

5.2 Stream:流式字节处理

对于大文件或网络数据,一次性读入内存(Buffer)是不可取的。Node.js 的 Stream(流) 提供了分块处理数据的模型,有效控制内存峰值。

const fs = require(‘fs’);

const readStream = fs.createReadStream(‘large_video.mp4’);

readStream.on(‘data’, (chunk) => {

// chunk 是一个 Buffer 对象

console.log(`收到 ${chunk.length} 字节数据`);

// 可以边读边处理,例如计算哈希、转发等

});

流式处理的思想在 Node.js 中至关重要,广泛应用于大文件上传下载、AI 模型权重加载、实时音视频转码等场景。

六、前后端二进制模型统一视图

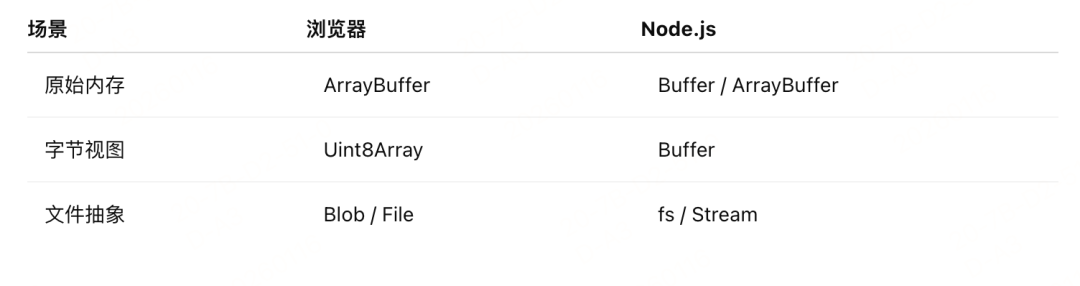

将浏览器和 Node.js 的字节处理模型放在一起看,能帮助我们建立统一认知:

上图清晰地对比了在不同场景下,浏览器与 Node.js 中处理字节数据的对应API和核心概念。

七、字节处理在 AI 应用开发中的关键作用

在 AI 应用开发中,上述字节处理能力直接关系到核心功能的实现效率与可行性。

- 语音识别与合成:前端或服务端接收的音频数据(如麦克风输入的 PCM 数据)本质上是字节流。预处理、格式转换(如采样率、位深调整)都需要通过

ArrayBuffer、Float32Array 等完成,然后才能转换为模型需要的输入张量。

- Embedding 与向量存储:大模型生成的 embedding 向量通常是

Float32Array 或 Float64Array。这些高维向量在网络间传输、存入向量数据库(如进行序列化/反序列化),底层都是高效的字节操作。

- 流式 AI 响应:无论是 Server-Sent Events (SSE) 还是 WebSocket,当 AI 模型(如大语言模型)进行流式文本生成时,前端需要实时接收并解码可能是二进制或特定编码格式的数据块,这同样依赖于底层的字节处理能力。

- 模型文件处理:在边缘计算或 前端 & 移动端推理场景中,加载 AI 模型文件(如

.onnx、.bin 权重文件)并解析,离不开 fetch 结合 ArrayBuffer,或 Node.js 中 fs 结合 Buffer 和 Stream 的流式加载。

八、常见误区与避坑指南

- 过度依赖 Base64:虽然 Base64 便于在文本协议(如 JSON)中传输二进制数据,但它会使数据体积增大约 33%,并增加编码/解码开销。在追求性能的场景(如传输大量音视频帧、模型参数),应优先考虑纯二进制传输(如

ArrayBuffer)。

- 前端完全依赖后端处理:合理的分工是必要的,但将所有的二进制预处理、格式转换都抛给后端,会增加服务端压力和网络往返延迟。前端应具备必要的数据处理能力,如文件分片、音频重采样初筛等。

- 混淆 Buffer 与 Uint8Array:在 Node.js 中,

Buffer 就是 Uint8Array,可以直接使用 TypedArray 的许多方法。但在浏览器中,不存在 Buffer 全局对象,应使用 Uint8Array。

结语

扎实的字节数据处理能力,是现代前端工程师技术栈中不可或缺的一环。它不仅是实现文件上传、多媒体编辑等功能的基石,更是连接前端与 AI、高性能计算、实时系统的关键技术桥梁。从理解 ArrayBuffer 和 TypedArray 的内存模型,到熟练运用 Blob、File 进行文件交互,再到掌握 Node.js 中 Buffer 和 Stream 的流式处理,系统性地构建这方面的知识体系,能显著提升我们在复杂应用场景下的架构能力和问题解决效率。

随着 AI 应用的深入,前端 与底层数据的交互只会越来越频繁。希望本文能帮助你梳理清这条技术脉络,在实践中更有底气。如果你对这类底层技术话题感兴趣,欢迎在 云栈社区 与其他开发者继续深入交流探讨。