本帖最后由 异或Lambda 于 2026-1-29 20:04 编辑

你有没有这种经历:跟语音助手聊天,必须等它说完一整句才能插嘴,中间还得忍受几秒钟的“思考人生”般的沉默?这种“对讲机式”的交流,真的很难让人产生“在跟人说话”的错觉。

但就在最近,NVIDIA 把这个痛点给解决了。他们开源了 PersonaPlex——一个能边听边说、还支持自定义人设和音色的全双工(Full-Duplex)语音模型。

简单说,它不仅反应快(200毫秒级),而且你终于可以像打断你朋友一样打断它了。

为什么说它是“全双工”的革命?

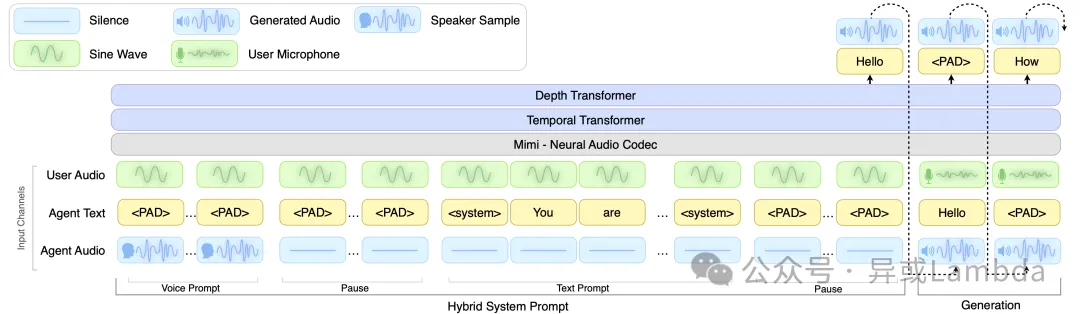

现在的 Siri 或 ChatGPT 语音模式,大多还是“识别-思考-合成”的接力赛。而 PersonaPlex 基于 Moshi 架构,它把听和说放在了两条并行的轨道上。

这意味着什么?意味着它拥有了“听觉感知”。

当你说话时,它不是在傻等录音结束,而是实时在听。如果你在它说话时插嘴,它能像真人一样停顿、犹豫(发出“呃...”的声音),或者根据你的情绪调整语调。我们在 人工智能技术栈 中常讨论的“拟人化”,在 PersonaPlex 上体现得淋漓尽致。

角色与音色的“双重克隆”

PersonaPlex 最骚的操作在于它的双重条件化机制。它不只是一个复读机,它是一个演员。

1. 文本定人设(Text Prompt)

你可以用自然语言给它写剧本。

比如:“你是一个在火星任务中遇到反应堆熔毁的宇航员 Alex,语气要焦急且专业。”

或者:“你是一个厌世的餐厅服务员,对顾客的问题爱答不理。”

2. 音频定声线(Voice Prompt)

这是最黑科技的地方。你只需要投喂一段 3 秒钟的音频,它就能零样本克隆这个人的音色。项目自带了 18 种预设声音(自然型和多样型),你也可以上传自己的声音。

想象一下,用你老板的声音来播报服务器宕机警告,是不是更有压迫感了?

硬核玩家怎么玩?

对于开发者来说,PersonaPlex 的部署门槛非常友好。

- 架构:基于 PyTorch,核心是 7B 参数的模型。

- 音频编码:使用了 Mimi 编解码器,保证了 24kHz 的高音质。

- 部署:支持 Docker 一键拉起,显存不够还能开启 CPU Offload(虽然会慢点)。

如果你是搞 后端架构 的,你会喜欢它的设计:客户端和服务端通过 WebSocket 双向流式传输,前端用的是 React + TypeScript,后端是 Python。这种分离架构非常适合集成到现有的业务系统中。

为什么这很重要?

PersonaPlex 的出现,意味着虚拟数字人的最后一块拼图被补齐了。

以前的数字人是“好看的皮囊 + 机械的灵魂”,现在它们有了性格。未来的客服可能不再是冷冰冰的“请按1”,而是一个会因为你生气而紧张、会因为你开玩笑而捧哏的“人”。

如果你对这类前沿技术感兴趣,或者想找更多关于大模型微调、语音合成的实战资源,可以多逛逛 云栈社区( https://yunpan.plus ),那里有不少硬核的开发者在分享填坑经验。

写在最后

技术在变得越来越像人。PersonaPlex 让我们看到,AI 不再只是工具,它开始有了“温度”和“脾气”。

你是更喜欢听话但机械的助手,还是这种会抢话、有性格的 AI?欢迎在评论区聊聊你的看法。

标签:#PersonaPlex #NVIDIA #全双工语音 #AI开源 #语音克隆 #大模型 #人机交互 #Moshi |