近日,一篇题为“Towards Agentic OS: An LLM Agent Framework for Linux Schedulers”的学术论文在技术社区引发了热议。它探讨了一个颇具野心的方向:让操作系统不再只依赖人类预设的、固化的调度策略,而是尝试利用人工智能来扮演一个“理解业务语义的调度专家”。

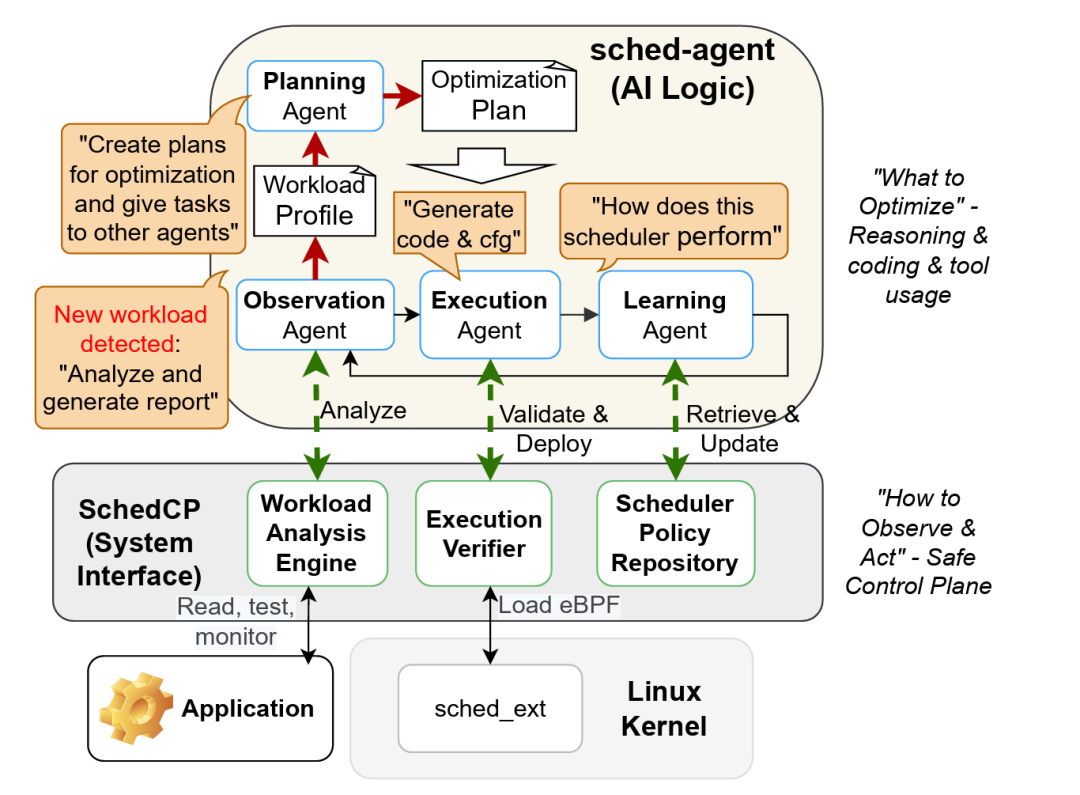

该研究提出的核心方向被称为 Agentic OS(代理化操作系统)。其核心理念是,将 LLM Agent 作为整个系统的 控制平面,使其能够自动地分析、生成、验证并部署针对特定工作负载的 Linux 内核调度策略。

这里必须首先澄清一个关键点:该框架并非让 LLM 直接进入内核执行推理,而是让 LLM 生成经过严格验证、安全可靠的内核调度策略代码,再将此代码安全地载入内核执行。

核心问题:传统调度器的“语义鸿沟”

传统的 Linux内核调度器(如 CFS、EEVDF)通常面临几个固有局限:

- 策略是静态的、普适性的,缺乏灵活性。

- 无法理解应用程序的真实意图和性能需求。

- 这导致在面对多样化、动态变化的工作负载时,往往出现尾延迟过高、吞吐量不稳定等问题。

问题的本质在于:内核层面的调度策略缺乏对应用程序语义(app-level intent)的理解,而这恰恰是进行精细化性能优化的关键所在。

为此,论文提出了 SchedCP 框架。其核心思路是借助 LLM agent 来理解工作负载的语义,并自动生成与之匹配的优化调度策略。该架构的一个重要设计原则是控制平面与执行平面的分离。

控制平面 vs. 执行平面

- 控制平面(运行于用户态):

- 由 LLM Agent 构成。

- 负责分析工作负载(Workload Analysis)。

- 负责生成和规划调度策略(Policy Synthesis)。

- 执行平面(运行于内核态):

- 仅执行已验证的、安全的 eBPF 调度逻辑。

- 不运行任何 AI 模型或执行推理过程。

简而言之,AI 负责“思考”和“规划”,内核则专注“执行”已验证的可靠策略。

SchedCP 框架主要包含三个核心组件:

1. 🧠 工作负载分析引擎 (Workload Analysis Engine)

- 负责收集和分析系统的实时行为与负载特征。

- 其目标并非提供原始数据,而是构建一个带有语义信息的“工作负载画像”(Workload Profile)。

2. 📦 调度策略仓库 (Scheduler Policy Repository)

- 用于存储由 AI 生成过的调度策略及其相关的元数据(如策略描述、历史性能指标等)。

- 支持对已有策略进行查询、复用和组合,避免重复生成,提升效率。

3. 🛡️ 执行验证器 (Execution Verifier)

- 利用静态和动态分析技术,对 AI 生成的策略代码进行安全性验证。

- 这是保障内核安全的关键防线,能够过滤掉不安全的配置或代码,防止其进入内核执行。

论文特别强调,使用 LLM Agent 的目的并非让它直接编写复杂的内核代码,而是将调度器优化问题分解为两个更可控的阶段:

- 目标推断 (Goal-inference):理解“当前的优化目标究竟是什么”(语义理解层)。

- 策略合成 (Policy-synthesis):将优化目标转化为具体、可执行的调度策略(代码生成层,如 eBPF 程序)。

这种分离至关重要:目标推断专注于高层次语义理解;而策略合成阶段则避免了将神经网络推理直接置于关键的内核执行路径中,转而输出已验证的、确定性的执行策略。

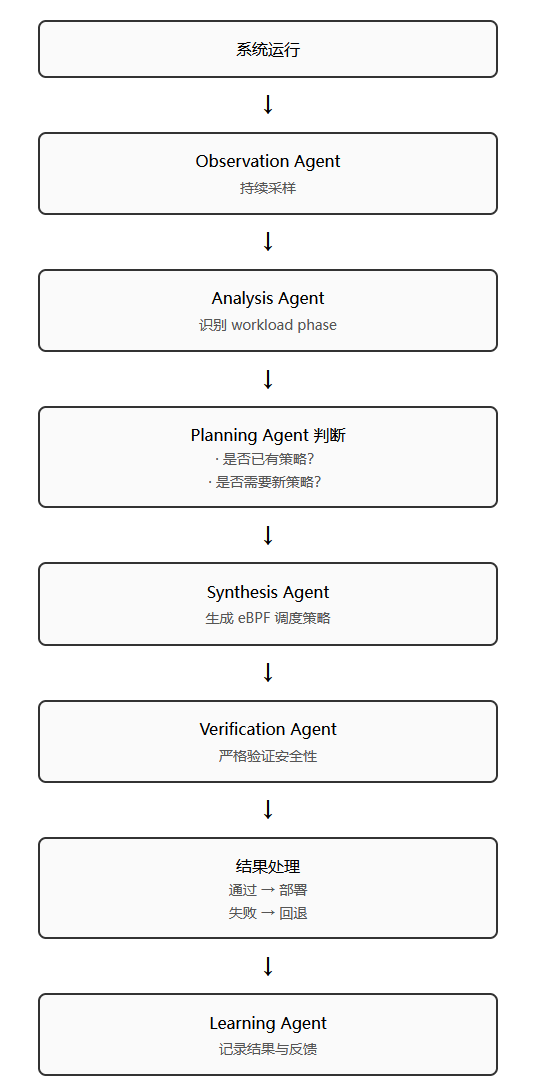

sched-agent:多智能体协作系统

SchedCP 并非一个单一的 LLM 模型,而是一个多 Agent 协作的系统。每个 Agent 各司其职,共同完成调度优化任务。

| Agent 名称 |

主要角色 |

| Observation Agent |

持续收集与分析系统负载 |

| Planning Agent |

决策合适的策略生成或选用方式 |

| Execution Agent |

生成并最终部署调度策略 |

| Learning Agent |

收集效果反馈,用于迭代提升 |

下图清晰地展示了一次完整的 sched-agent 工作周期流程:

关键技术实现:eBPF 与内核接口

论文在实现路径上做出了明确且务实的选择:

不是让 LLM 直接在内核运行推理,而是将生成的调度器逻辑输出为 eBPF 调度程序,然后通过 Linux 的调度器扩展框架 sched_ext 安全地载入内核。

这种做法确保了内核的纯净性与安全性:LLM 在内核之外生成策略代码,经过严格的验证后,再将安全的 eBPF 程序注入内核,作为调度决策的执行逻辑。

实验亮点与初步数据

论文提供了初步的定量评估,展示了 SchedCP 框架的潜力:

| 测量指标 |

SchedCP 实验结果 |

| 性能提升 |

最高达 1.79倍 |

| 生成成本 |

比简单的 Agentic 基线方法降低 13倍 |

| 对 Schbench 调度基准测试 |

P99 尾部延迟改善 2.11倍 |

| 对批处理任务 |

平均延迟降低约 20% |

这些数据表明:

- 由 AI 生成调度策略 在特定场景下确实能带来显著的性能收益。

- 这种收益是传统静态调参或简单策略所难以实现的。

这项研究为操作系统与人工智能的融合提供了一个非常具体且有价值的探索方向。它没有追求不切实际的“全知全能”,而是聚焦于利用大语言模型的语义理解与代码生成能力,去解决一个长期存在且影响广泛的系统级难题——调度优化。随着 LLM Agent 能力的不断进化,此类“代理化操作系统”的研究或许将为我们打开一扇通往更智能、更自适应基础软件系统的大门。

如果你对 Linux 内核、调度策略 或 AI 与系统 的交叉领域有更多兴趣,欢迎在云栈社区的相关板块进行深入交流与探讨。 |