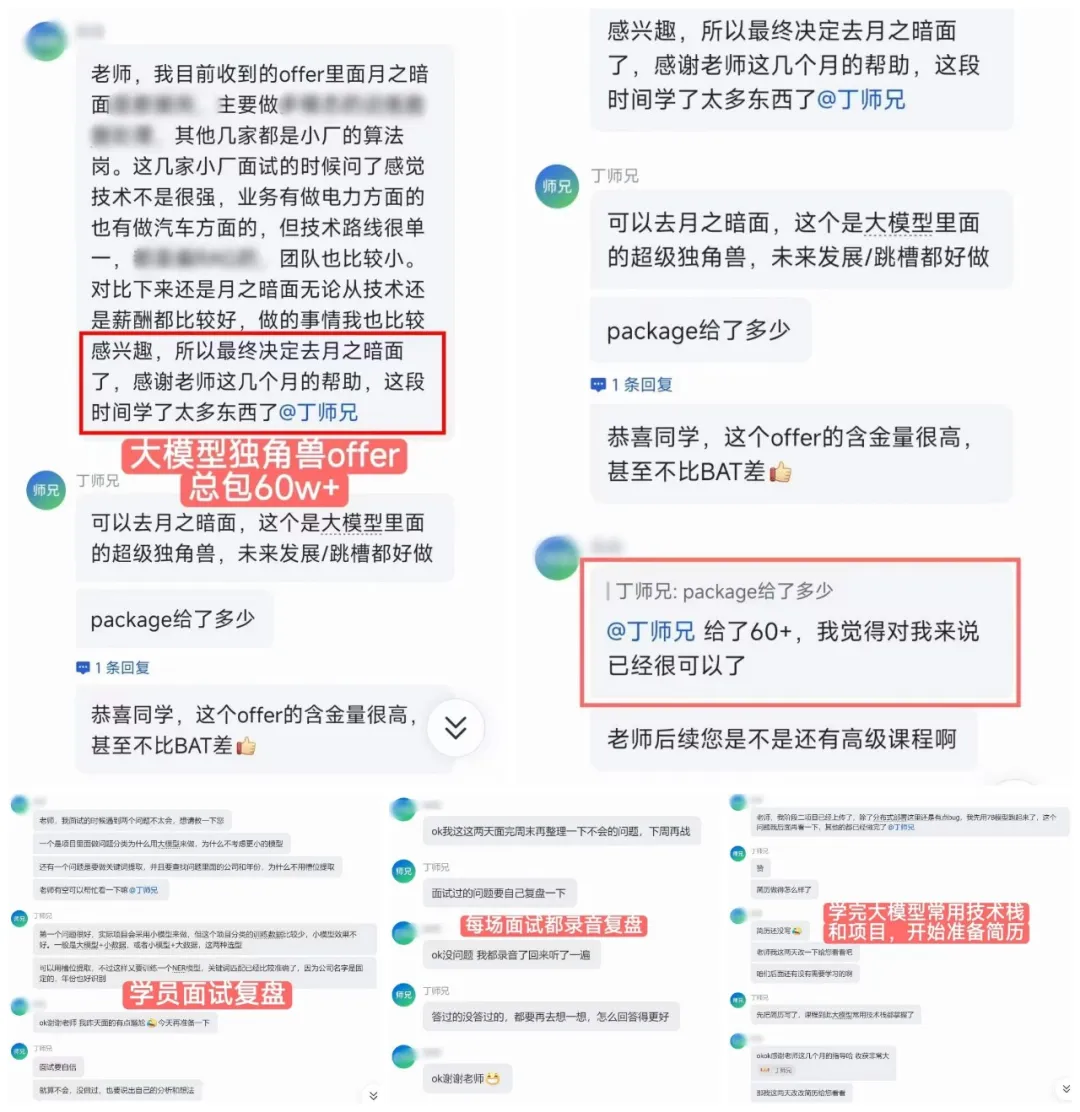

图为学员面试复盘讨论过程,强调实战练习与针对性改进的重要性。

近来,关于强化学习能否真正拓展大语言模型推理边界的争论在业界持续不断,支持和反对的声音皆有。

反对者的一个核心论点是:RL仅仅提高了模型采样到正确路径的效率,并未激发新的推理模式。一个颇具说服力的论据,就来自于对 pass@K 这个评估指标的分析。

区别于 pass@1(即针对每个问题生成1个响应,该响应解决问题的概率),pass@K 指的是针对每个问题生成K个响应,这K个响应中至少有一个能解决问题的概率。

一篇 NeurIPS 2025 的满分论文作者就指出,RL 训练可能提升了 pass@1,但 pass@k 指标却不升反降。而 pass@k 常被认为与 LLM 的推理能力边界挂钩。这是否意味着 RL 无用?

这让我联想到 AI 发展史。AlphaGo 击败李世石常被视作“AI 元年”的标志,而其核心正是强化学习。我也曾一度认为,强化学习代表了真正的人工智能,其他方法不过是模式识别。但随后,因数据样本利用率低等问题,RL 热潮迅速消退,甚至被批评为只是“蛋糕顶上的樱桃”,仅能在游戏模拟器中发挥作用。

我并不完全认同这种观点。强化学习的理念本身是好的,问题可能出在实现和算法上。尽管我个人有过一段不短的 RL 研究工作经历,但在此并无偏袒之意。

以强化学习领域的“常青树”PPO 算法为例。它自 2017 年问世至今,依然占据主流地位。这么多年过去,算法本身的核心框架进展有限,却反过来指责 RL 能力不行,这显然不太合理。

话说回来,我们不深入 PPO 的理论细节,但其设计思路带着一些“先天限制”。PPO 的前身 TRPO 为了保证策略稳步改进,定义了“置信区域”的概念——简单说,要求训练用的目标策略和采集数据的行为策略是同一个策略(即 On-policy)。

这在实际中很难做到。策略稍有更新,旧数据就“不置信”了,需要重新采样,效率极低。于是,解决方案是使用重要性采样,并用 KL 散度或 clip 函数来严格限制策略的更新幅度,让新旧策略尽可能相似,从而近似满足置信区域条件。

看,PPO 的理论本身就包含了多重近似,更重要的是,它天生带着“枷锁”——限制更新幅度,也就限制了探索能力。在这样的框架下,期望它在强调多样性的 pass@k 指标上取得突破,是否有些强人所难?

那么,pass@K 指标真的能完全代表 LLM 的推理能力边界吗?如果能,那么我们是否可以专门针对这个指标进行优化呢?这引出了本文的主题:近期一些旨在优化 pass@K 指标的研究工作梳理。

近期针对优化 pass@K 指标的研究方向

-

RL Grokking

该研究提出一种两阶段训练法:先在热身期使用密集奖励进行训练,直到性能饱和;随后切换到探索期,改用稀疏奖励。最终,模型在 pass@K 指标上实现了对基座模型的反超。

-

将 pass@K 直接作为训练目标

与优化 pass@1 不同,这种方法优化的对象是一个包含 k 个答案的组 G = {ŷ₁, …, ŷₖ}。对于一个组的奖励 R_group 被定义为:

R_group = max (R_1, R_2, ..., R_k)

也就是说,只要这个组里至少有一个答案正确,整个组就会获得正奖励。随后,这个奖励(或优势值)会平等地分配给组内的所有 k 个成员。结果显示,尽管训练成本较高,但此方法能有效提升 Pass@k 指标。

-

DARS (Difficulty-Aware Reward Shaping)

该研究认为,当前一些 RL 算法存在“难度偏好”,倾向于在中低难度问题上获得奖励,而忽视了难题。然而,恰恰是难题才可能推动模型突破原有的推理边界。这种偏好导致模型在训练后期 pass@K 增长乏力甚至下降。

DARS 的策略是动态地将更多的计算资源分配给模型认为更困难的问题,从而激励模型在难题上“用心”,最终收获更好的 pass@k 指标。

-

DPH-RL

这项研究从散度选择的角度切入。它指出,当前 RL 常搭配使用的反向 KL 散度具有“模式寻求”特性,容易导致模型多样性坍塌。而具有“质量覆盖”特性的散度(如前向 KL 散度、JS 散度)则有助于保持输出多样性,从而维持更高的 pass@k 指标。

-

SimKO

SimKO 关注的是训练过程中的梯度分配问题。它发现,在使用标准方法训练时,来自正确答案的正向梯度会将几乎所有概率质量都堆积在 top-1 候选 token 上,导致其他候选概率急剧下降,这是模型过度自信、放弃探索的主因。

因此,SimKO 设计了一种非对称的梯度调整策略:对于正确答案带来的奖励信号,不再全部赋予实际采样的 token,而是将其“分享”给排名前 K 的其他高概率候选者。这样能在不牺牲 pass@1 的前提下,有效提升 pass@K。

-

除此之外,相信还有更多相关的研究在不断涌现。

结论

因此,单就 pass@K 这一指标而言,研究人员已经提出了多种思路进行“抢救”。这表明,仅因为当前某些 RL 方法在 pass@K 上表现不佳,就断言强化学习无法拓展 LLM 的推理边界,这个结论可能下得为时过早。

算法的设计、奖励函数的塑造、训练策略的调整,都深刻影响着最终的性能表现。强化学习与大语言模型的结合仍在快速演进中,其潜力的边界,或许还未被完全触及。对于技术人而言,保持开放和探究的心态,在计算机基础原理之上持续创新,才是关键。

参考文献与相关论文链接:

https://arxiv.org/pdf/2504.13837

https://arxiv.org/abs/2505.24864

https://arxiv.org/abs/2509.24981

https://arxiv.org/pdf/2509.21016

https://arxiv.org/pdf/2508.10751

https://arxiv.org/pdf/2508.13755

https://arxiv.org/pdf/2509.07430

https://arxiv.org/pdf/2510.14807

本文观点基于公开论文讨论,欢迎在云栈社区 的 AI 技术板块进行更深入的交流。