昨天一篇关于Skill的文章发布后,有网友在评论区提出了一个非常关键的问题:skill 和 token 的消耗究竟是什么关系?这个问题直接触及了当前构建高效AI应用的核心成本考量。所以,我们今天就来彻底拆解一下Token、MCP、Skill这些概念背后的计费逻辑,帮你找到AI时代的“省钱密码”。

Web 会话 Token

对于程序员而言,“Token”这个词并不陌生。在Web开发中,Token通常指代一种身份验证机制,相当于用户的“临时身份证”。登录后服务器生成一串随机字符串(Token),之后的每次请求都携带它,服务器便能识别用户身份。

这类Web会话Token的特点很明确:

- 一次性生成,多次使用:仅在登录时消耗计算资源生成,后续校验成本极低。

- 体积小巧:通常只有几十到几百字节。

- 安全导向:核心作用是身份验证与权限控制,与AI的计算过程无关。

AI Token

而当我们在谈论大模型和AI应用时,“Token”的含义发生了根本性转变。它成为了大模型处理文本的最小单位,也是计费的核心依据。你可以将AI Token理解为模型的“脑细胞”,每处理一个Token,模型就需要完成一次计算。

因此,AI Token直接代表了计算量和成本。它与Web Token的关键区别如下:

| 维度 |

Web Session Token |

AI Token |

| 本质 |

身份凭证 |

计算单位 |

| 计费方式 |

免费(或极低成本) |

按量计费,直接关联成本 |

| 数量级 |

单次请求1个 |

单次请求数百至数百万个 |

| 生命周期 |

持续有效(小时/天) |

每次请求独立计算 |

需要特别注意,AI Token的消耗是双向的:你输入的Prompt算作输入Token,模型生成的回答算作输出Token。通常,输出Token比输入Token更贵(例如Claude 3.5 Sonnet的输出Token单价是输入的5倍)。

AI Token 是如何计算的?

理解AI Token的难点在于,它的计算并非简单的“字数统计”。不同语言、不同内容的Token化(Tokenization)效率差异巨大。

- 英文:1个Token ≈ 0.75个单词(“ChatGPT”可能被切分为1-2个Token)。

- 中文:1个汉字 ≈ 1-2个Token(技术文档中常按1.5个估算)。

- 代码:符号、缩进、换行都会占用Token,一段Python代码的Token数可能是其字符数的1.5倍。

简单对比:

英文:`“Hello world”` = 2 Tokens

中文:`“你好世界”` = 4-6 Tokens

代码:`“def hello():”` = 4-5 Tokens

计费公式通常如下(以DeepSeek、元宝等平台为例):

总费用 = (输入Token数 × 输入单价 + 输出Token数 × 输出单价) / 1,000,000

| 不同模型的单价差异显著: |

模型 |

输入单价(元/百万Token) |

输出单价(元/百万Token) |

| 通义千问-Max |

2.4 |

9.6 |

| DeepSeek-V3 |

2.0 |

8.0 |

| GPT-4 级别 |

30+ |

60+ |

已经有真实案例警示:某企业因未清理对话历史,单次请求携带了50万Token的上下文,一次对话就消耗了数十元,直到查看账单时才惊觉。

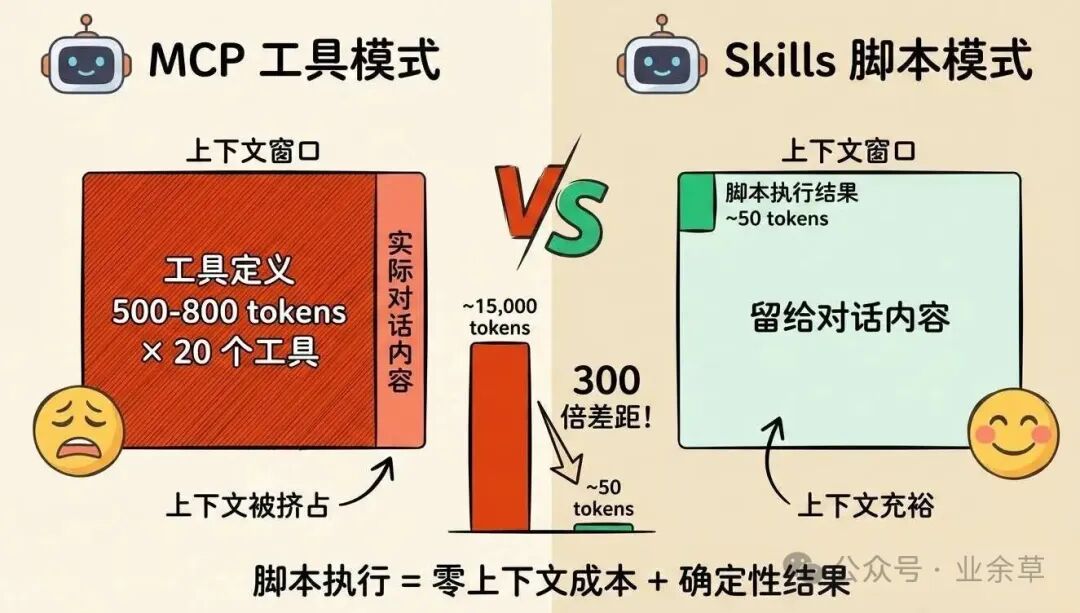

Skill vs MCP:效率之争

MCP(模型上下文协议)和Skill是当前让AI Agent 调用外部能力的两种主流方式,但它们在Token消耗上可谓“天差地别”。

MCP:能力强,但也是“Token黑洞”

MCP是Anthropic推出的开放协议,旨在让AI统一调用各种外部工具(如数据库、邮件、GitHub)。然而,它有一个致命的缺点:极高的Token消耗。

其Token陷阱在于:启动MCP时,所有工具的定义文档会被一次性完整加载到AI上下文中。这包括工具名称、描述、参数列表(JSON Schema)、返回值格式等。根据社区实测数据(Claude 3.5 Sonnet):

- 连接5个标准MCP服务器(GitHub、Slack等)就需要约 97,000 Token。

- 这直接吃掉了Claude 20万上下文窗口的 48%。对话还没开始,近一半的“思考空间”就被工具定义占用了。

更糟糕的是中间结果传递。例如,让AI“从Google Drive下载会议纪要并上传到Salesforce”,会议内容(可能长达数万Token)会在AI的上下文里流转两次,造成额外巨额消耗。

Skill:按需加载的“省钱能手”

Skill是Anthropic推出的新特性,可以看作一种按需加载的轻量级能力包。它在Token节省上优势明显:

- 启动时:只加载非常简短的描述(约12个Token)。

- 使用时:才加载完整的指令和执行代码(约300个Token)。

- 节省率:相比MCP方式,可节省高达99.6% 的Token。

| 社区对比实验数据: |

方案 |

启动Token |

使用时Token |

总消耗 |

| MCP传统方式 |

2,800 |

2,800(持续占用) |

高且固定 |

| Skill方式 |

12 |

311(按需加载) |

低且弹性 |

MCP vs Skill:如何选择?

结论是:MCP更费Token,但Skill并非万能。二者是互补关系,而非替代。

MCP的优势场景:

- 标准化:统一协议,跨平台兼容性好。

- 实时数据:能获取最新信息(如股价、天气)。

- 精确控制:工具行为可预测,适合需要严格审计的企业级流程。

Skill的优势场景:

- 极致省Token:特别适合高频、重复性的已知任务。

- 快速响应:脚本本地执行,无需等待外部服务器响应。

- 隐私安全:敏感数据可以不流出模型上下文。

社区共识是:用MCP探索“能做什么”,用Skill高效执行“已知怎么做”。

MCP 的 Token 优化策略

既然MCP不可或缺,如何优化其Token消耗?业界已有多种方案。

1. Code Execution 模式

这是Anthropic官方的优化方案。核心思想是:让AI生成一段代码脚本来串联调用多个MCP工具,而不是让AI亲自一步步调用。

- 传统方式:AI → 调用工具A → 接收结果 → 调用工具B(所有中间结果过AI上下文)。

- Code模式:AI生成脚本 → 脚本直接调用工具A和B → AI只查看最终结果。

官方测试显示,该模式能将Token消耗从150,000降至2,000,节省 98.7%。

由Speakeasy提出的方案,核心是不一次性加载所有工具。

- 语义搜索:根据用户意图,只加载最相关的少数工具定义。

- 分类大纲:先提供工具类别索引,让AI按需“深度检索”具体工具。

该方案实现了输入Token减少96.7%,总Token减少96.4%的效果。

节省 Token 的六大实战技巧

除了协议选型,日常开发中也能通过技巧显著降低成本。

1. Prompt 压缩

立竿见影的方法:去除冗余词汇,使用结构化表达。

优化前:“请按照以下非常重要的步骤操作:第一步、第二步、第三步”

优化后:“步骤:1. 2. 3.”

节省:18 Tokens → 8 Tokens(节省55%)

技巧包括:用JSON代替自然语言描述、使用缩写、删除不必要的礼貌用语。

2. 上下文管理

避免“历史包袱”导致Token指数增长。关键策略:

- 定期清理:开始新任务前,主动清除无关的旧对话历史。

- 摘要机制:将长篇对话总结成百字左右的摘要,替代原始内容送入上下文。

- 滑动窗口:只保留最近N轮对话,丢弃更早的。

3. 缓存机制

针对高频重复查询(如“公司最新股价”),建立多级缓存是“重复任务的救星”。

用户提问 → Redis缓存(精确匹配)→ 语义缓存(相似问题)→ 调用模型

某在线教育平台的AI作文批改系统采用此方案后,在99%的缓存命中率下,成本降低了99%。

4. 模型路由

好钢用在刀刃上。建立智能路由策略:

- 简单任务(问答、翻译):使用轻量模型(如GPT-3.5)。

- 复杂任务(推理、编程):才调用旗舰模型(如GPT-4)。

预估可让70%的任务由轻量模型处理,总体成本降低80%。

5. 异步与批处理

将零散的实时请求聚集起来批量处理,能大幅提升吞吐、降低成本。

- 实时处理:1000次请求 × 3秒/次 = 50分钟,成本$50。

- 批处理:使用vLLM等引擎一次生成1000个结果 = 8分钟,成本$8。

某些场景下节省比例高达84%。

6. 监控与告警

设置监控防线,警惕“账单刺客”。必须建立的指标包括:

- 按团队/项目的Token消耗分布。

- 异常检测(如单小时成本超过日均3倍时触发告警)。

- 成本归因分析,识别并优化“Token大户”。

真实案例:某团队通过监控发现一个未关闭的调试循环每小时消耗$200,及时进行了止损。

Token 经济的演进

AI圈有句调侃:“你的模型能力很强,但你的账单余额不足”。随着AI Agent的普及,Token管理正从“优化选项”变为“核心竞争力”。未来趋势值得关注:

- 上下文压缩技术:模型自动压缩历史对话,在保持关键信息的同时减少Token占用。

- 专用小模型:针对代码审查、客服等特定任务训练轻量模型,Token效率可提升10倍。

- 边缘计算:简单推理任务下沉到本地设备,仅复杂任务调用云端大模型。

结语

理解Token,就是理解AI时代的成本结构。无论是开发者还是产品经理,都需要建立Token敏感度。善用Prompt压缩和上下文清理,每月节省几十美元并非难事。在MCP和Skill间找到平衡,正成为新的技术评估能力。

毕竟,最优雅的AI应用,未必使用了最强大的模型,但一定找到了最高效的解决问题路径。

参考资料

- Atal Upadhyay《MCP Token Problem: Building Efficient AI Agents with Skills》

https://atalupadhyay.wordpress.com/2025/11/11/mcp-token-problem-building-efficient-ai-agents-with-skills/

- Speakeasy《Reducing MCP token usage by 100x》

https://www.speakeasy.com/blog/how-we-reduced-token-usage-by-100x-dynamic-toolsets-v2

- IntuitionLabs《Claude Skills vs. MCP: A Technical Comparison》

https://intuitionlabs.ai/articles/claude-skills-vs-mcp

- Anthropic《Code execution with MCP: building more efficient AI agents》

https://www.anthropic.com/engineering/code-execution-with-mcp

- Skywork AI《Claude Skills vs MCP vs General LLM Tools》

https://skywork.ai/blog/ai-agent/claude-skills-vs-mcp-vs-llm-tools-comparison-2025/

- CData《Claude Skills vs MCP: Better Together》

https://www.cdata.com/blog/claude-skills-vs-mcp-better-together-with-connect-ai

- AgiFlow

token-usage-metrics https://github.com/AgiFlow/token-usage-metrics

欢迎在 云栈社区 交流更多关于AI成本优化与Agent开发的实践经验。