引言:规模决定协议选择

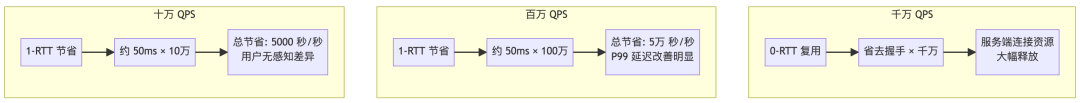

没有任何一个千万 QPS 的系统是从第一天就达到这个规模的。当你的产品还在十万 QPS 阶段时,TCP + HTTP/2 的组合完全够用,QUIC 更多是一个“技术前瞻”的选项;当你迈入百万 QPS 门槛时,QUIC 开始展现出明显的延迟收益,但此时它仍然是一个“锦上添花”的优化手段;而当你真正承载千万 QPS 时,QUIC 的 0-RTT 连接恢复和抗网络抖动能力,已经从“可选优化”变成了“架构刚需”。

本文将从一个真实的高并发架构演进视角,为你阐述为什么 QUIC 协议在千万 QPS 场景下是不可回避的技术选择。

本质差异:连接建立成本的规模效应

TCP + TLS 1.3 的标准握手需要 2-RTT(一次 TCP 握手 + 一次 TLS 握手),而 QUIC 将两者合并,首次连接只需 1-RTT,复用连接时可以做到 0-RTT。

这个差异在不同规模下的影响完全不同:

核心观点:在千万 QPS 场景下,连接建立的开销不再只是延迟问题,而是服务端资源问题。

当每秒有数百万次新建连接请求时,握手过程消耗的 CPU 周期、内存状态、以及半开连接的维护成本,都会成为系统瓶颈。QUIC 的 0-RTT 机制让回访用户(这在成熟产品中往往占 60% 以上)可以直接复用之前的加密上下文,彻底跳过握手阶段。这不仅仅是节省了50-100ms的用户延迟感知,更是对服务端计算和连接资源的根本性释放。

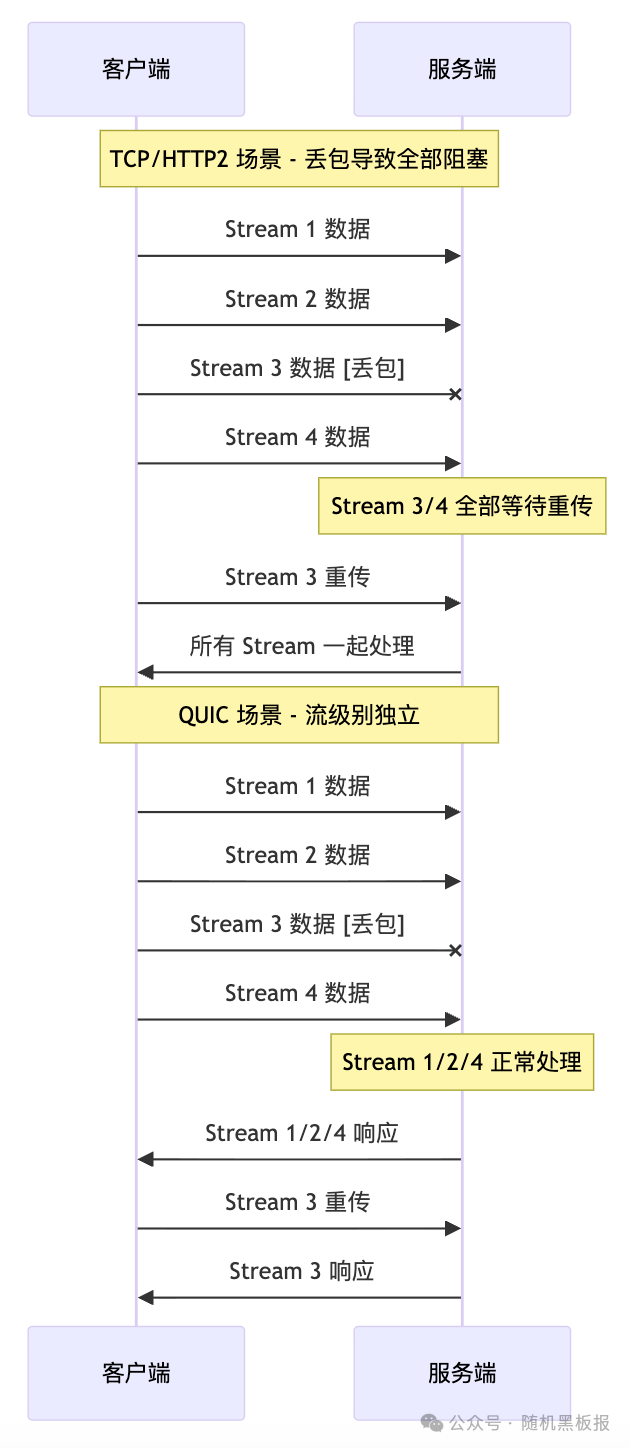

队头阻塞:从理论问题到生产事故

HTTP/2 解决了 HTTP 层的队头阻塞,但 TCP/IP 层的队头阻塞依然存在。当一个 TCP 包丢失时,后续所有数据都必须等待重传完成。

在低丢包率的网络环境下,这个问题可以忽略;但在移动互联网场景下,丢包是常态而非异常。

核心观点:QUIC 的多路复用在 UDP 之上实现,每个 Stream 独立传输,丢包只影响单个 Stream。

在百万 QPS 时,你可能通过优化重试策略和超时配置来容忍这个问题;但在千万 QPS 时,任何 1% 的请求异常都意味着每秒 10 万次的用户体验劣化,这已经超出了“容忍”的范畴,必须从协议层面根治。

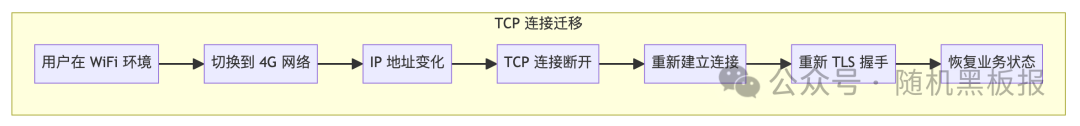

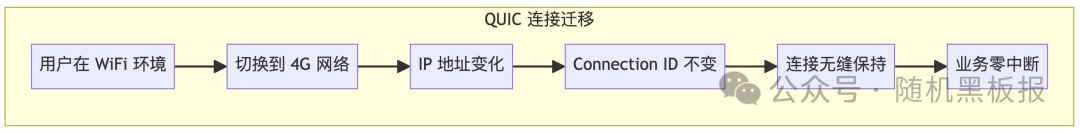

连接迁移:移动时代的隐藏成本

这是一个容易被忽视但在大规模场景下极为关键的特性。TCP 连接由四元组(源 IP、源端口、目标 IP、目标端口)唯一标识,当用户从 WiFi 切换到 4G,或者在基站之间漫游时,IP 地址变化会导致 TCP 连接失效。

核心观点:QUIC 使用 Connection ID 而非四元组标识连接,网络切换时连接可以无缝迁移。

在千万 QPS 的场景下,假设移动端用户占比 70%,每天每用户平均发生 3 次网络切换,那么每天会产生数千万次的连接迁移事件。如果每次迁移都需要重新建立连接,不仅用户体验受损,服务端也要承受额外的连接建立压力。QUIC 的连接迁移能力,让这些切换对用户和服务器都变成了“透明”事件。

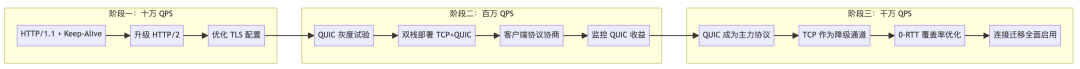

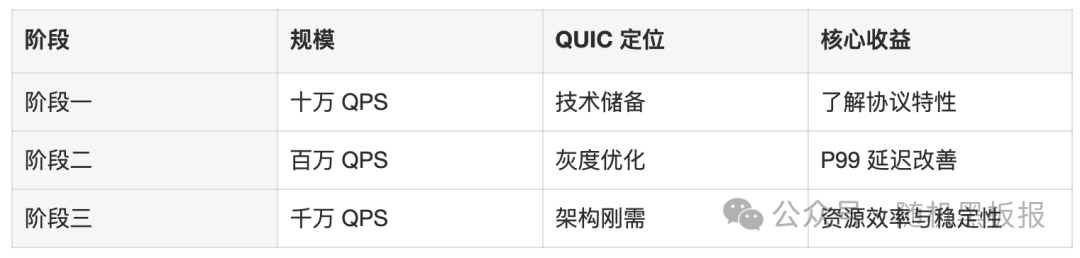

技术演进路线图

从实际的架构演进来看,QUIC 的引入通常遵循以下路径:

每个阶段的关键考量不同:

这张表清晰地揭示了QUIC从“技术储备”到“架构刚需”的蜕变轨迹。想了解更多关于数据库/中间件/技术栈在不同规模下的选型与优化策略,欢迎在技术社区交流探讨。

千万 QPS 下的 QUIC 架构要点

当 QUIC 成为主力协议时,架构层面需要关注以下几个核心问题:

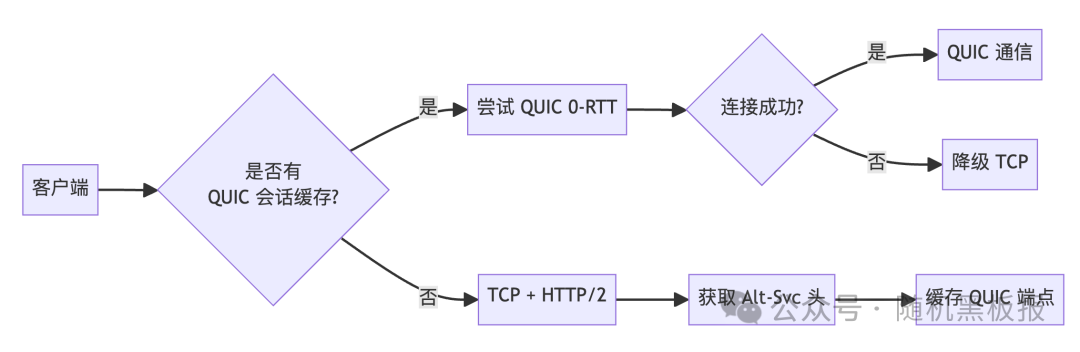

- 接入层的协议协商

客户端需要具备协议探测和降级能力。首次访问时通过 HTTP Alternative Services (Alt-Svc) 发现 QUIC 支持,后续优先使用 QUIC,在 QUIC 不可用时平滑降级到 TCP。

-

服务端的连接状态管理

0-RTT 依赖于会话票据(Session Ticket)的分发和验证。在分布式接入层中,需要确保会话票据在多个边缘节点间共享,否则用户被调度到不同节点时将无法复用连接。

-

UDP 负载均衡的挑战

传统的四层负载均衡器依赖五元组进行会话保持,但 QUIC 的连接迁移会改变源 IP 和源端口。负载均衡器需要支持基于 Connection ID 的会话保持,这对网络基础设施提出了新的要求。

总结

QUIC 协议从实验走向生产,不是一个单纯的技术升级决策,而是规模驱动的架构演进。

在十万 QPS 阶段,HTTP/2 + TCP 是成熟稳定的选择;在百万 QPS 阶段,QUIC 带来可量化的延迟收益;而在千万 QPS 阶段,QUIC 的 0-RTT 连接恢复、流级别的队头阻塞消除、以及连接迁移能力,共同构成了应对大规模、高并发、移动化场景的技术基座。

千万 QPS 不是百万 QPS 的简单 10 倍放大,而是协议选择从“锦上添花”变为“架构刚需”的质变点。希望本文的剖析,能帮助你更清晰地规划自己的技术演进路线。