上一节我们成功安装并解决了Istio常见的UPGRADE_FAILED 426错误。本节我们来深入探讨一下Istio最核心的功能之一:灵活的流量分发与路由控制。我们将从基础的按比例分发开始,逐步深入到更复杂的匹配规则,并在其中分享一个关键的踩坑与修复过程。

按比例分发流量

场景与目标

假设我们有一个名为 backend 的Deployment及其对应的 backend-service。现在,我们希望部署一个新版本 backend-v1 进行测试。关键点在于:backend-v1 和 backend 使用了相同的 Kubernetes Service Selector (app: backend)。这意味着如果不加控制,一旦 backend-v1 的Pod启动,Kubernetes的负载均衡器会立即将大约50%的流量分给它。

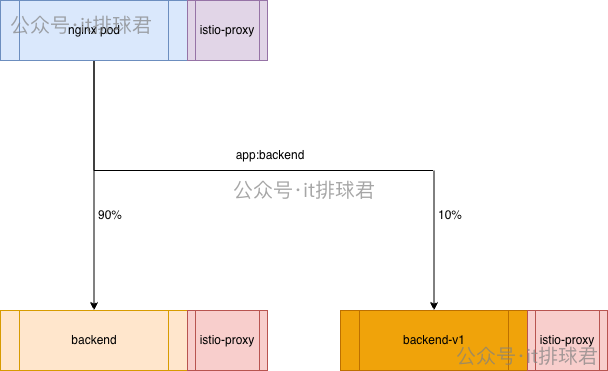

我们的目标是通过Istio的流量管理能力,在不修改任何Kubernetes Service的前提下,实现 9:1 的流量分发,即90%的请求流向旧的 backend,仅10%流向新的 backend-v1。

图1:Istio实现90/10流量分发的架构示意图,请求经过Nginx Pod的Sidecar后,被精准路由到不同版本的后端Pod。

配置步骤

-

标记Deployment版本

首先,我们需要为两个Deployment打上版本标签,这是Istio区分不同后端子集的依据。我们为原backend打上version: v0,为新backend-v1打上version: v1。

kubectl patch deployment backend -p '{"spec":{"template":{"metadata":{"labels":{"version":"v0"}}}}}'

kubectl patch deployment backend-v1 -p '{"spec":{"template":{"metadata":{"labels":{"version":"v1"}}}}}'

-

创建DestinationRule

接着,创建一个 DestinationRule 资源。它的作用是定义“目的地子集(subsets)”,告诉Istio,当我们提到v0或v1时,具体指的是哪些带有特定标签的Pod。

apiVersion: networking.istio.io/v1

kind: DestinationRule

metadata:

name: backend-dr

namespace: default

spec:

host: backend-service

subsets:

- labels:

version: v0

name: v0

- labels:

version: v1

name: v1

-

创建VirtualService

最后,创建 VirtualService 资源。这是定义流量路由规则的核心,我们在这里指定流向不同子集的权重。

apiVersion: networking.istio.io/v1

kind: VirtualService

metadata:

name: backend-vs

namespace: default

spec:

hosts:

- backend-service

http:

- route:

- destination:

host: backend-service

subset: v0

weight: 90

- destination:

host: backend-service

subset: v1

weight: 10

调试与一个典型的“坑”

配置完成后,我们发起测试请求并查看代理日志:

# 连续发起10次请求

for i in {1..10}; do curl -s 10.22.12.178:30785/test > /dev/null ; done

# 查看backend相关Pod的istio-proxy日志

kubectl logs -f -l app=backend -c istio-proxy

期望看到9条 v0 Pod的IP和1条 v1 Pod的IP。但实际日志可能是这样的:

[2026-01-28T08:24:55.670Z] "GET /test HTTP/1.1" 200 - upstream=10.244.0.55:10000 duration=0ms route=default

[2026-01-28T08:24:55.687Z] "GET /test HTTP/1.1" 200 - upstream=10.244.0.55:10000 duration=0ms route=default

...

[2026-01-28T08:24:55.706Z] "GET /test HTTP/1.1" 200 - upstream=10.244.0.53:10000 duration=0ms route=default

对比Pod IP:

kubectl get pod -owide

发现 10.244.0.53 对应 v0,10.244.0.55 对应 v1。日志显示流量大约是5:5分布,Istio的权重规则没有生效。

问题分析与修复

为什么? 核心原因在于 Host Header。Istio的 VirtualService 通过 hosts 字段来匹配请求。我们的 VirtualService 中定义的 host 是 backend-service(Kubernetes Service的DNS名称)。

当请求从客户端(或测试命令)直接发出,经过入口网关或作为入口的Nginx Pod时,如果请求中没有携带正确的Host头(或者Nginx转发时没有正确设置),istio-proxy 就无法将请求匹配到我们定义的 backend-vs 规则上,从而回退到普通的Kubernetes负载均衡。

解决方案:确保请求在到达目标服务的Sidecar时,其Host头与我们 VirtualService 中定义的 hosts 一致。

方法一:修改Nginx配置(直接但可能影响业务)

server {

listen 80;

listen [::]:80;

server_name localhost;

location /test {

proxy_http_version 1.1;

# proxy_set_header Host $host; # 原配置,传递客户端Host

proxy_set_header Host backend-service.default.svc.cluster.local; # 新配置,固定为Service名

proxy_pass http://backend-service:10000;

}

}

修改并重启Nginx后,流量按 9:1 分发的效果即刻生效。但这种方法粗暴地将所有请求的Host都固定了,如果后端业务需要根据原始Host进行不同处理,就会受到影响。

方法二:扩展VirtualService的hosts(推荐)

更优雅的方式是在 VirtualService 的 hosts 列表中,加入客户端访问时使用的域名。

apiVersion: networking.istio.io/v1

kind: VirtualService

metadata:

name: backend-vs

namespace: default

spec:

hosts:

- backend-service

- api.wilsontest.com # 新增外部可访问域名

http:

- route:

- destination:

host: backend-service

subset: v0

weight: 90

- destination:

host: backend-service

subset: v1

weight: 10

然后,客户端在发起请求时,需要带上对应的Host头:

for i in {1..10}; do curl -s -H 'host: api.wilsontest.com' 10.22.12.178:30785/test > /dev/null ; done

这样,请求在进入网格时就能被正确匹配到路由规则。关键启示:在微服务治理中,明确和规范请求的Host头至关重要,尤其是在使用服务网格进行高级流量管理时。对于“祖传代码”,需要仔细梳理所有可能的访问入口和Host,避免遗漏导致路由失效。

除了按比例,我们还可以根据请求头(Header)来精确控制流量走向。例如,只有携带特定Header的请求才被路由到新版本。

apiVersion: networking.istio.io/v1

kind: VirtualService

metadata:

name: backend-vs

namespace: default

spec:

hosts:

- backend-service

- api.wilsontest.com

http:

- match: # 匹配规则

- headers:

hellotest:

exact: "true"

route: # 匹配成功则路由到v1

- destination:

host: backend-service

subset: v1

- route: # 其他所有请求,默认路由到v0

- destination:

host: backend-service

subset: v0

使用以下命令测试,流量将全部流向v1版本:

curl -s -H 'host: api.wilsontest.com' -H 'hellotest: true' 10.22.12.178:30785/test

基于URI前缀的流量分发

我们也可以根据请求路径(URI)来分流。例如,将所有以 /test/v1 开头的请求导向新版本。

apiVersion: networking.istio.io/v1

kind: VirtualService

metadata:

name: backend-vs

namespace: default

spec:

hosts:

- backend-service

- api.wilsontest.com

http:

- match:

- uri:

prefix: /test/v1

route:

- destination:

host: backend-service

subset: v1

- route:

- destination:

host: backend-service

subset: v0

请求重写(URI Rewrite)

Istio还支持在路由过程中对请求进行修改,比如重写URI。这在API版本迁移或路径规范化时非常有用。

apiVersion: networking.istio.io/v1

kind: VirtualService

metadata:

name: backend-vs

namespace: default

spec:

hosts:

- backend-service

- api.wilsontest.com

http:

- match:

- uri:

prefix: /test/v1

route:

- destination:

host: backend-service

subset: v1

- match:

- uri:

prefix: /test/v2

rewrite: # 重写URI,将/test/v2改为/test

uri: /test

route:

- destination:

host: backend-service

subset: v0

- route:

- destination:

host: backend-service

subset: v0

这个配置实现了:

- 请求

/test/v1 -> 路由到 v1 版本。

- 请求

/test/v2 -> 被重写为 /test,然后路由到 v0 版本。

- 其他所有请求 -> 默认路由到

v0 版本。

概念辨析:蓝绿、金丝雀、灰度与A/B测试

掌握了上述流量控制能力后,我们就可以轻松实现多种发布策略。下面用一个表格来厘清这些常被混用的概念:

|

蓝绿发布 (Blue-Green) |

金丝雀发布 (Canary) |

灰度发布 (Gray Release) |

A/B测试 (A/B Testing) |

| 主要目标 |

零停机部署、瞬时回滚 |

用极小比例的真实流量快速验证新版本稳定性,发现技术风险 |

平稳、可控地逐步将全体用户迁移到新版本,观察综合反馈 |

通过对比不同版本,验证哪个在业务指标(如转化率)上更优 |

| 流量路由 |

100%切换(从绿环境全量切到蓝环境,或反之) |

极小比例引流(如1%-5%的流量到新版本) |

按比例分阶段扩大(例如10% → 30% → 50% → 100%) |

按规则(如用户ID哈希)或随机分配固定比例(如50%/50%) |

| 关注重点 |

系统整体可用性、切换与回滚速度 |

系统稳定性指标(错误率、延迟、资源消耗) |

发布过程的平稳性、性能表现及用户的广泛反馈 |

业务指标(点击率、购买率、用户留存率等) |

| 所需资源 |

需要维护两套完整的生产环境,成本较高 |

一套环境,新版本只需少量实例 |

一套环境,新旧版本实例根据流量比例共存 |

一套或多套环境,同时并行运行多个不同版本 |

| 用户感知 |

全体用户在同一时刻切换到新版本 |

被选中的一小部分用户会体验到新版本 |

所有用户会按照既定节奏逐步切换到新版本 |

用户被分为不同组,分别体验不同的版本 |

| 持续时间 |

极短(切换操作在几分钟内完成) |

短(几小时到一两天,验证通过后即全量或扩大) |

中长(可能持续数天到数周,逐步放量) |

长(可能持续数周到数月,直到收集到足够的统计显著性数据) |

| 典型场景 |

数据库重大变更、操作系统或中间件升级、关键业务大版本更新 |

后端服务逻辑更新、算法变更、第三方依赖库升级 |

前端用户界面(UI)改版、新增主要功能模块 |

网页UI设计、广告文案、推荐算法策略、产品定价方案优化 |

简单来说,蓝绿关乎“可靠切换”,金丝雀聚焦“风险探测”,灰度强调“平稳过渡”,而A/B测试则用于“效果验证”。Istio提供的精细化流量控制能力,正是实现这些高级发布策略的基石。

希望这篇从实战到踩坑的解析能帮助你更好地理解Istio的流量管理。如果在实践中遇到更多问题,欢迎来云栈社区一起交流探讨。