🛠️ 快速上手:搭建私有化 AI 助手

你是否希望拥有一个既能理解复杂指令,又能安全运行在你本地电脑上的智能助手?将 Kimi k2.5 这类云端大模型的推理能力与 OpenClaw(原名 Clawdbot)的强大智能体框架相结合,或许是目前最可行的方案之一。它不仅让 AI 助手变得更加可控,也从根本上解决了数据隐私和长期使用成本的问题。接下来,我们一步步看看如何实现。

🛠️ 安装 OpenClaw

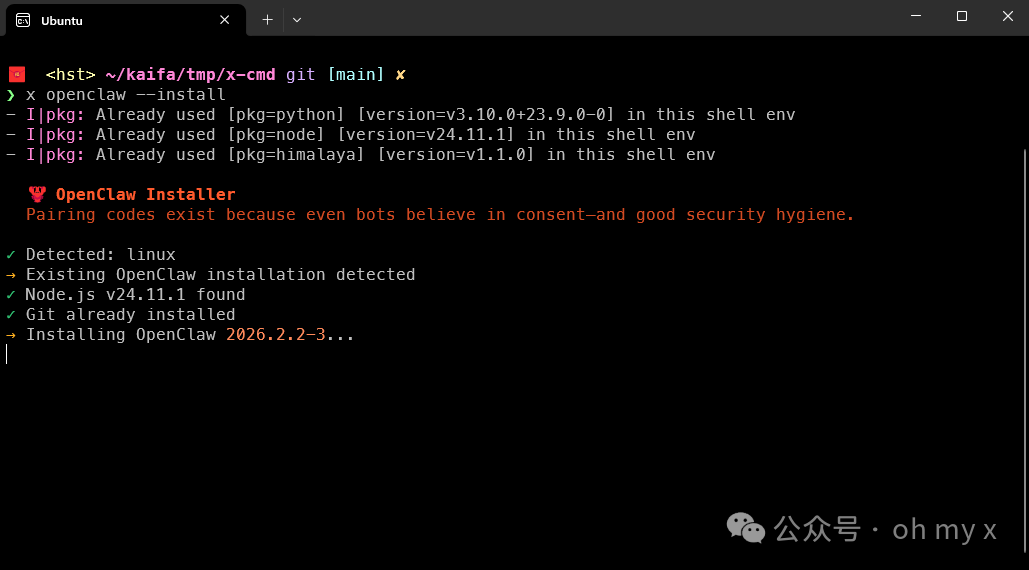

使用 x-cmd 可以一行命令补齐安装依赖和 Skill 工具,把复杂的安装过程简化成了一步:

x openclaw --install

⚠️ 安全提醒:尽管 OpenClaw 功能强大,但它目前对国内生态的适配并非完美,并且会涉及到对电脑的底层控制权限。因此,强烈建议不要将其安装在存有重要资料的个人主力电脑上,可以在虚拟机或备用机中进行尝鲜和测试。

使用 Ollama 驱动 OpenClaw

如果你还没有安装 ollama,可以使用 x ollama install 一键安装。

1. 启动 kimi-k2.5 服务

首先,我们需要在本地运行 Kimi k2.5 模型。通过以下命令启动服务:

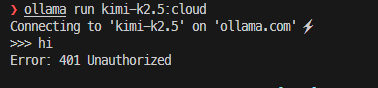

x ollama run kimi-k2.5:cloud

如果遇到上图所示的“401 Unauthorized”错误,这通常是因为需要先登录你的 Ollama 账户。只需前往 Ollama 官网注册并登录账号即可,这个过程是免费的。

2. 一键配置并启动

模型服务就绪后,接下来使用一行命令自动完成 OpenClaw 的配置并启动其网关服务:

x ollama launch openclaw

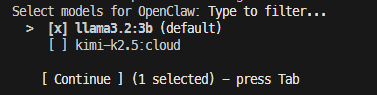

在打开的终端交互界面中,我们选择 kimi-k2.5,然后按 Tab 键进入下一步。这里有两种情况:

- 已初始化用户:OpenClaw 将直接调用你选择的本地模型来启动网关,配置到此完成。

- 初次使用用户:系统会识别到缺失配置,并自动进入“向导模式 (Onboarding Wizard)”引导你完成初始化。请跟随下面的步骤进行配置。

配置 OpenClaw

如果你是第一次运行,请跟随以下步骤完成核心设置:

1. 选择配置模式

阅读并同意条款后,我们选择 “Quickstart” 模式:

- Quickstart(快速启动):自动引导完成核心配置,后续可通过

configure 命令修改。

- Manual(手动配置):适合高级用户自定义各项细节。

2. 挑选你的 AI 模型

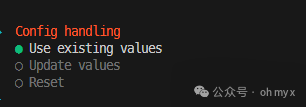

这一步,选择 “Use existing values” 即可沿用刚才 launch 命令指定的 Ollama 模型(即 kimi-k2.5)。

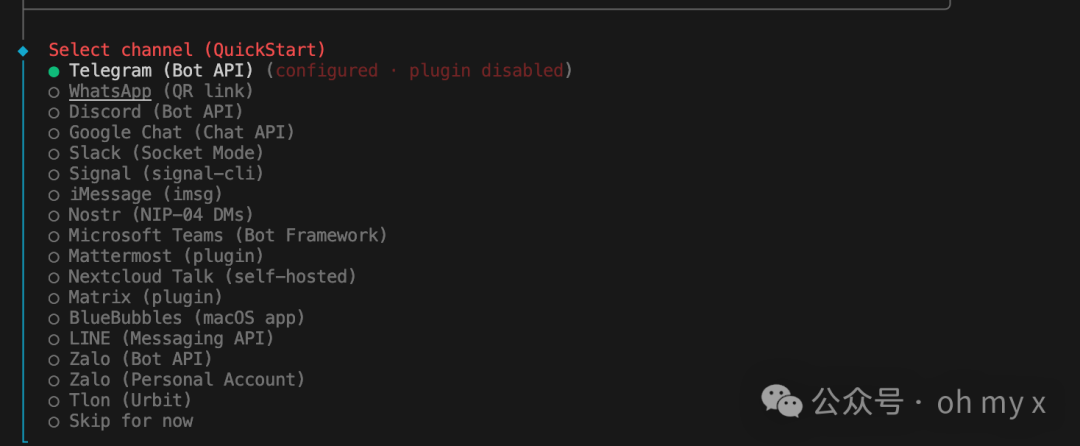

3. 跳过社交软件配置(可选)

向导会询问是否配置 Telegram、WhatsApp 等社交软件通道。为了快速跑通核心流程,这一步我们可以先跳过,优先打通网页端的交互。

4. 配置 Skills 与 Hooks

在向导过程中,系统会询问是否配置预设的“技能”。

- 技能安装:可以直接确认安装。向导通常会询问你使用哪种包管理器,如果你已安装 Node.js,选择 npm 即可。

- 挑选功能:你可以根据描述挑选喜欢的技能,或者直接跳过(后续在对话中也能随时安装)。

向导最后会询问是否开启以下三个重要插件,建议全部开启以获得完整体验:

boot-md(启动引导):在每次机器人启动时自动加载一段 Markdown 文本。你可以把自定义规则、偏好设置或项目背景写在这里。command-logger(命令日志):记录你在终端执行的关键操作。这对于后续排查问题和复盘非常有用。session-memory(会话记忆):保存聊天状态,让机器人在下次启动后依然能“记得”之前的上下文。

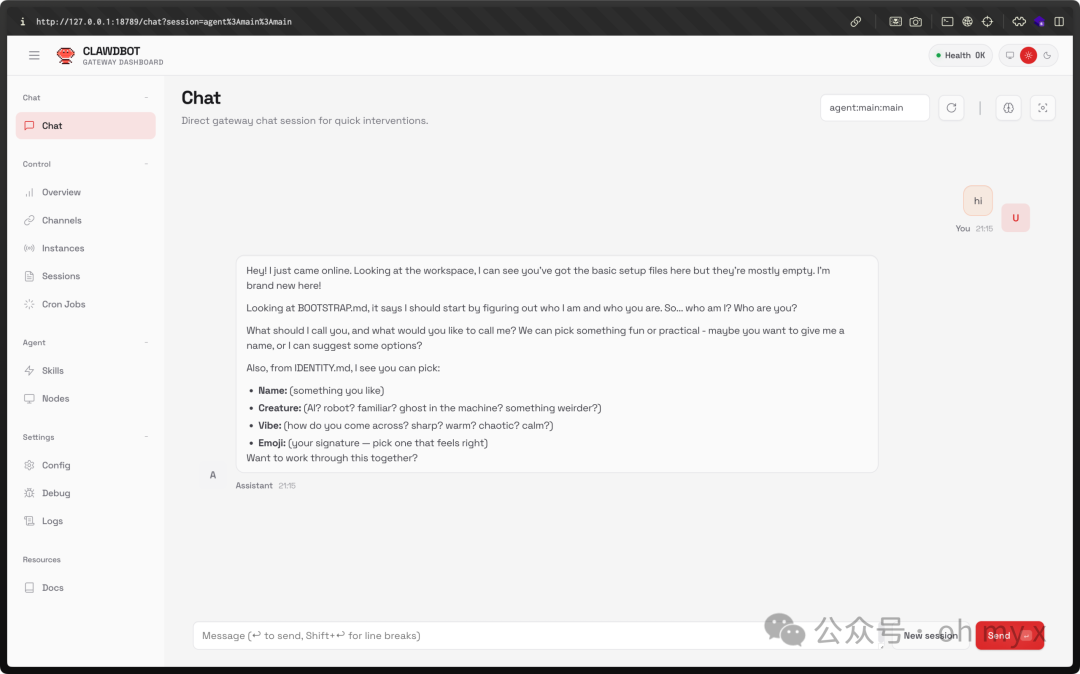

配置完成后,选择 Web UI,然后使用浏览器访问 http://127.0.0.1:18789 就可以测试部署是否成功了。

看到这个界面,恭喜你!一个由本地 Kimi k2.5 模型驱动的 AI 智能体已经成功运行。你可以开始与它对话,让它协助你处理文本、回答问题,甚至通过安装更多 Skills 来扩展它的能力。

方案总结与安全考量

我们必须清醒地认识到,本地模型 ≠ 万能。在“绝对智商”和最新知识覆盖上,它们可能还赶不上云端旗舰模型。但在安全性、可控性、低成本这三个维度上,本地模型方案具有无可比拟的优势。

当 AI 智能体开始接管你的电脑并处理信息时,隐私和长期使用成本,其重要性往往超过了模型在排行榜上的几分排名。Ollama + OpenClaw + Kimi 并不是最炫酷或功能最多的方案,但它很可能是目前最能让人“放心长期用”的平衡之选。

⚠️ 重要安全提示与“紧急制动”

OpenClaw 与智能体相关功能赋予 AI 较高的自主权,因此存在一定的潜在风险。为防止智能体行为失控或持续占用资源,X-CMD 提供了一个名为 x gram 的“最后手段”工具。

该工具可作为“紧急制动”使用,能够执行以下操作:

- 强制熔断:立即终止所有相关的智能体进程;

- 数据保全:归档智能体的记忆数据;

- 彻底清理:清除原始运行目录,根除其自动恢复运行的风险。

了解并善用这类安全工具,是在探索前沿开源实战时保护自身数字资产的重要一环。