在分布式系统中,Kafka作为核心的消息队列组件,其消息的可靠性传递至关重要。消息的重复消费是一个常见挑战,本文将深入解析四种主流解决方案,帮助你在实际架构中做出合适的选择。

1. 幂等生产者(Idempotent Producer)

启用Kafka的幂等生产者功能是防止生产端产生重复消息的第一道防线。该机制通过为每个生产者分配唯一的PID(Producer ID)并为发送的每批消息增加序列号,在Broker端进行去重判断。

核心配置:

enable.idempotence=true

工作原理与价值:

- 源头防重:确保即使在网络波动导致生产者重试发送时,同一消息也只会被Broker持久化一次。

- 性能无损:开启幂等性对生产者的性能影响极小,是实现“至少一次”语义的轻量级方案。

- 局限性:此方案主要保障了消息在进入Kafka主题时不重复,但无法解决消费者侧因重启、重平衡等原因导致的重复处理问题。

2. 事务性写入(Transactional API)

对于需要更强一致性的场景,可以使用Kafka的事务API。它能够保证跨分区、甚至跨主题的写入操作具有原子性(即“全有或全无”)。

核心配置:

生产者端需设置唯一的事务ID。

transactional.id=your-transaction-id

工作流程与注意事项:

- 生产者初始化事务。

- 在事务内发送消息。

- 提交或回滚事务。

- 消费者可以配置

isolation.level=read_committed,确保只读取已成功提交的事务消息,避免读到生产者中途失败产生的“幽灵数据”或半成品状态。

适用场景与权衡:

- 适用场景:适用于金融计费、订单状态同步等对一致性要求极高的业务,尤其在涉及Java应用与多系统状态同步时。

- 性能开销:事务机制会引入额外的网络往返和协调开销,比普通写入或幂等写入性能更低。

- 复杂性:需要妥善管理

transactional.id,并处理可能的事务超时与恢复逻辑。

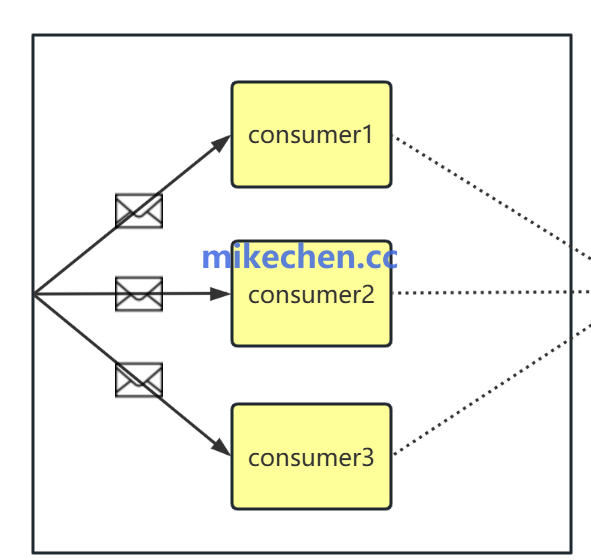

3. 消费端去重(Consumer-Side Deduplication)

这是最为通用和灵活的方案,在消费侧业务逻辑中实现去重,能够抵御来自生产端重试或消费端自身故障导致的任何重复。

常见实现方式:

- 外部存储去重:在消费消息前,先以其唯一标识(如消息ID、业务主键)在外部存储(如数据库、Redis)中查询。若已存在则跳过,否则处理并记录。这种方式可靠,但依赖外部存储的性能和可用性。

- 本地状态去重:使用如Kafka Streams提供的State Store,在流处理应用内部维护已处理记录的状态。适用于流处理场景,去重效率高,但状态存储容量有限。

- 时间窗口缓存:结合业务逻辑,仅对短时间内的消息进行去重检查(例如利用内存缓存记录最近1分钟已处理的消息ID),以牺牲少量精度换取存储和性能优势。

设计要点:

- 唯一键选择:选择真正具有业务全局唯一性的标识作为去重键。

- 存储一致性:确保去重记录写入与业务操作的事务性,避免两者不一致。

- 清理策略:根据业务设置合理的记录过期时间,防止存储无限膨胀。

4. 端到端精确一次处理(E2E Exactly-Once Processing)

这是最严格的保证级别,旨在实现从消息生产、Kafka内部存储到消费者处理并写入外部系统的整个链路都不重复。

实现理念:

将Kafka的事务机制与外部系统(如数据库)的事务或幂等写入能力相结合,形成一个分布式事务或幂等操作链。例如,使用“消费-处理-输出”模式,并将消费位移的提交与对外部系统的写入放在同一个事务中。

可用工具:

- Kafka Streams:其

processing.guarantee配置可设置为exactly_once_v2,在流处理应用内部自动管理状态和事务,简化了精确一次的处理。

- Kafka Connect:部分支持精确一次的Sink连接器,在将数据写入目标系统时会进行类似的事务协调。

挑战与选型建议:

- 实现复杂:需要深刻理解分布式事务,并对涉及的每个组件(Kafka、业务应用、外部存储)进行正确配置。

- 性能代价:事务协调带来显著的延迟和吞吐量开销。

- 外部系统依赖:要求下游系统支持幂等写入或参与事务,并非所有系统都满足。

总结与选型指南:

- 追求简单高效:优先启用幂等生产者,它能以极小成本解决绝大部分生产侧重复问题。

- 需要强一致性:涉及多分区原子写入或与外部状态强关联时,使用事务性写入。

- 追求最终可靠性:在消费者业务逻辑中实现去重是终极防线,适用性最广,可根据业务复杂度选择外部存储或本地状态方案。

- 全链路零重复:在对数据准确性有极端要求、且技术栈支持的情况下,考虑端到端精确一次,但务必做好充分的性能测试和复杂性评估。

|