想象一下:你脑中突然迸发出一个绝妙的AI想法,急于验证却苦于没有趁手的工具快速实现。或是老板突然丢给你一个项目,要求短时间内从零搭建一个神经网络模型。

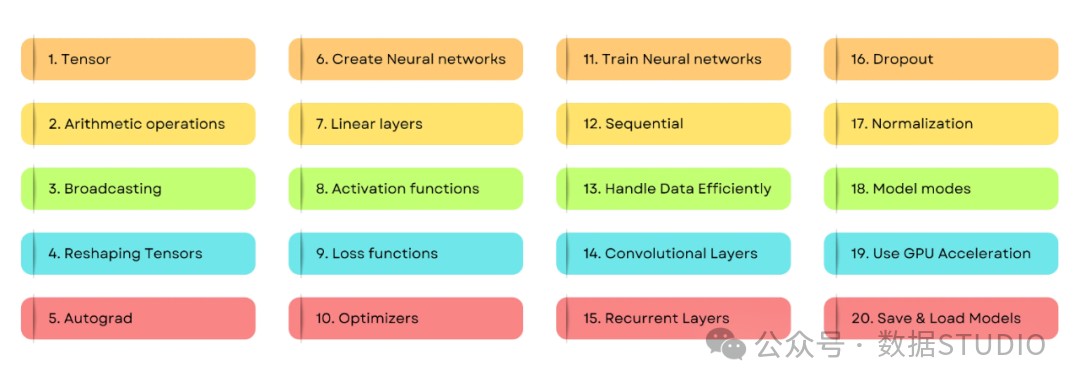

这些场景对许多AI开发者来说并不陌生,而PyTorch正是为解决这些问题而生——它提供了从研究原型到生产部署的无缝路径。今天,我们将深入解析PyTorch的20个核心概念,从基础Tensor操作到完整训练流程,助你快速掌握这一强大工具。

01 PyTorch基础:从Tensor开始

PyTorch的核心数据结构是Tensor(张量),可以理解为GPU优化的NumPy数组。创建Tensor有多种方式:

import torch

# 从列表创建

x = torch.tensor([1, 2, 3])

# 创建特定形状的Tensor

zeros_tensor = torch.zeros(3, 2) # 3x2的全零张量

ones_tensor = torch.ones(3, 2) # 3x2的全一张量

random_tensor = torch.rand(2, 2) # 2x2的随机张量(均匀分布)

normal_tensor = torch.randn(2, 2) # 2x2的随机张量(标准正态分布)

Tensor与NumPy的互转

PyTorch Tensor与NumPy数组可以轻松转换,这使得与现有科学计算生态的无缝集成成为可能:

import numpy as np

# NumPy数组转Tensor

x_numpy = np.array([0.1, 0.2, 0.3])

x_torch = torch.from_numpy(x_numpy)

# Tensor转NumPy数组

y_torch = torch.tensor([3, 4, 5.])

y_numpy = y_torch.numpy()

02 Tensor操作艺术

PyTorch提供了丰富的Tensor操作方法,理解这些方法是高效编程的关键。

重塑操作:view vs reshape

view和reshape功能相似,但view要求原始张量在内存中是连续的,而reshape没有此限制。

x = torch.randn(2, 3, 4)

print(x.is_contiguous()) # True

# 使用view重塑

y = x.view(6, 4) # 正常工作

# 转置后变为非连续

x_t = x.transpose(1, 2)

print(x_t.is_contiguous()) # False

y = x_t.view(6, 4) # 可能出错

y = x_t.reshape(6, 4) # 安全做法

维度操作技巧

维度操作对于数据处理至关重要:

# 增加维度

x = torch.randn(3, 4)

x_unsq = x.unsqueeze(0) # 形状变为(1, 3, 4)

# 减少维度

x_sq = x_unsq.squeeze(0) # 形状变回(3, 4)

# 转置和重排

y = x.transpose(0, 1) # 交换维度0和1

z = x.permute(1, 0, 2) # 自定义维度顺序

03 自动微分:PyTorch的"灵魂"

PyTorch的核心优势之一是自动微分(autograd)。通过计算图跟踪操作,它能自动计算梯度,这是训练神经网络的基础。

基础示例

# 创建需要梯度的张量

x = torch.tensor(2.0, requires_grad=True)

# 定义函数 y = x² + 2x + 2

y = x**2 + 2*x + 2

# 计算梯度

y.backward()

print(f"在x=2处的导数: {x.grad}") # 输出: 6.0

多变量函数

更复杂的多变量函数同样适用:

def g(w):

return 2*w[0]*w[1] + w[1]*torch.cos(w[0])

w = torch.tensor([3.14, 1], requires_grad=True)

z = g(w)

z.backward()

print(f"梯度: {w.grad}") # 近似 [2.0, 6.28]

⚠️ 梯度积累陷阱

梯度积累是初学者常踩的坑:PyTorch默认会累积梯度,每次反向传播前需手动清零:

optimizer.zero_grad() # 清除旧梯度

loss.backward() # 计算新梯度

optimizer.step() # 更新参数

04 构建神经网络:两种主流方式

PyTorch提供了两种构建神经网络的主要方式:nn.Module子类化和nn.Sequential容器。

方式一:继承nn.Module(灵活定制)

import torch.nn as nn

class NeuralNet(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super().__init__()

self.hidden = nn.Linear(input_size, hidden_size)

self.predict = nn.Linear(hidden_size, output_size)

def forward(self, x):

x = torch.relu(self.hidden(x))

return self.predict(x)

✅ 适用场景:需要复杂前向传播逻辑的网络,如RNN或自定义架构。

方式二:使用nn.Sequential(快速简洁)

model = nn.Sequential(

nn.Linear(10, 50),

nn.ReLU(),

nn.Linear(50, 20),

nn.ReLU(),

nn.Linear(20, 1)

)

✅ 适用场景:简单的前馈网络。

关键区别

在nn.Sequential中,激活函数被明确列为层;而在nn.Module子类中,激活函数通常在forward方法中调用。

05 神经网络核心组件

激活函数:引入非线性的关键

激活函数使神经网络能够学习复杂模式。需要明确的是,纯激活函数堆叠无法构成有效神经网络,因为激活函数本身没有可学习的参数。

| 激活函数 |

公式 |

特点 |

适用场景 |

| ReLU |

[\max(0, x)] |

计算简单,缓解梯度消失 |

大多数隐藏层 |

| Sigmoid |

[\frac{1}{1+e^{-x}}] |

输出范围(0,1) |

二分类输出层 |

| Tanh |

[\frac{e^x-e^{-x}}{e^x+e^{-x}}] |

输出范围(-1,1) |

RNN隐藏层 |

| Leaky ReLU |

[\max(\alpha x, x)] |

解决"神经元死亡"问题 |

替代ReLU |

损失函数:衡量预测误差

损失函数的选择取决于任务类型:

# 回归任务

mse_loss = nn.MSELoss() # 均方误差

mae_loss = nn.L1Loss() # 平均绝对误差

# 分类任务

ce_loss = nn.CrossEntropyLoss() # 多分类交叉熵

bce_loss = nn.BCELoss() # 二分类交叉熵

优化器:引导训练方向

PyTorch提供了多种优化算法:

import torch.optim as optim

# 经典SGD(带动量)

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

# 自适应学习率优化器

optimizer = optim.Adam(model.parameters(), lr=0.001) # 最常用

optimizer = optim.AdamW(model.parameters(), lr=0.001) # 改进版Adam

optimizer = optim.RMSprop(model.parameters(), lr=0.001)

06 训练循环:理论与实践结合

完整的训练流程结合了前述所有组件:

# 1. 准备模型、损失函数和优化器

model = NeuralNet(input_size=10, hidden_size=20, output_size=1)

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 2. 训练循环

for epoch in range(100):

# 前向传播

outputs = model(train_data)

loss = criterion(outputs, targets)

# 反向传播

optimizer.zero_grad() # 清除旧梯度

loss.backward() # 计算梯度

optimizer.step() # 更新参数

# 每隔10个epoch打印进度

if epoch % 10 == 0:

print(f'Epoch {epoch}, Loss: {loss.item():.4f}')

07 数据处理:Dataset与DataLoader

PyTorch通过Dataset和DataLoader提供高效的数据处理管道。

自定义Dataset

from torch.utils.data import Dataset, DataLoader

class CustomDataset(Dataset):

def __init__(self, data, labels):

self.data = data

self.labels = labels

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

return self.data[idx], self.labels[idx]

使用DataLoader

dataset = CustomDataset(data, labels)

dataloader = DataLoader(

dataset,

batch_size=32,

shuffle=True,

num_workers=4 # 多进程数据加载

)

# 训练循环中使用

for batch_data, batch_labels in dataloader:

# 训练代码...

pass

08 特殊网络层与应用

卷积层:处理图像数据

# 2D卷积(图像处理)

conv2d = nn.Conv2d(

in_channels=3, # 输入通道(RGB图像为3)

out_channels=64, # 输出通道/滤波器数量

kernel_size=3, # 卷积核大小

stride=1, # 步长

padding=1 # 填充

)

# 1D卷积(时间序列/文本)

conv1d = nn.Conv1d(in_channels=2, out_channels=32, kernel_size=5)

循环神经网络层:处理序列数据

# LSTM(长短期记忆网络)

lstm = nn.LSTM(

input_size=10, # 输入特征维度

hidden_size=20, # 隐藏状态维度

num_layers=2, # LSTM层数

batch_first=True, # 输入形状为(batch, seq, feature)

dropout=0.2 # 层间dropout

)

# GRU(门控循环单元)

gru = nn.GRU(input_size=10, hidden_size=20, num_layers=2, batch_first=True)

09 正则化技术:防止过拟合

Dropout:随机丢弃神经元

dropout = nn.Dropout(p=0.2) # 丢弃20%的神经元

x = torch.randn(32, 100)

x_dropped = dropout(x) # 训练时随机置零部分元素

批量归一化:加速训练并提高稳定性

# 批归一化(BatchNorm)

batch_norm = nn.BatchNorm1d(256) # 用于全连接层

# 层归一化(LayerNorm)

layer_norm = nn.LayerNorm(256) # 用于RNN/Transformer

关键区别:批归一化在批处理维度上归一化,而层归一化在特征维度上归一化。

10 模型模式切换:训练vs推理

PyTorch模型有两种模式,影响特定层的行为:

model = MyNeuralNet()

# 训练模式

model.train() # 启用dropout,批归一化使用批统计量

# 评估/推理模式

model.eval() # 禁用dropout,批归一化使用运行统计量

with torch.no_grad(): # 禁用梯度计算,节省内存

predictions = model(test_data)

11 GPU加速:释放硬件潜力

PyTorch支持GPU加速,能极大提升训练速度:

# 检查GPU可用性

print(f"CUDA可用: {torch.cuda.is_available()}")

print(f"GPU数量: {torch.cuda.device_count()}")

print(f"当前GPU: {torch.cuda.get_device_name(0)}")

# 设置设备

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

# 将模型和数据移至GPU

model = model.to(device)

data = data.to(device)

labels = labels.to(device)

12 模型保存与加载

PyTorch提供了两种主要的模型保存方式:

方式一:保存完整模型(简单但不够灵活)

# 保存

torch.save(model, 'full_model.pth')

# 加载

model = torch.load('full_model.pth')

model.eval() # 切换到评估模式

方式二:保存状态字典(推荐方式)

# 保存

torch.save(model.state_dict(), 'model_weights.pth')

# 加载

model = MyNeuralNet() # 先创建模型实例

model.load_state_dict(torch.load('model_weights.pth'))

model.eval()

保存检查点(包含更多训练信息)

checkpoint = {

'epoch': epoch,

'model_state_dict': model.state_dict(),

'optimizer_state_dict': optimizer.state_dict(),

'loss': loss,

}

torch.save(checkpoint, 'checkpoint.pth')

13 实用技巧与最佳实践

混合精度训练:减少显存占用,加速训练

from torch.cuda.amp import autocast, GradScaler

scaler = GradScaler()

for data, target in dataloader:

optimizer.zero_grad()

with autocast(): # 自动混合精度

output = model(data)

loss = criterion(output, target)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

性能分析:找出代码瓶颈

from torch.profiler import profile, record_function, ProfilerActivity

with profile(activities=[ProfilerActivity.CPU, ProfilerActivity.CUDA]) as prof:

with record_function("model_inference"):

output = model(data)

print(prof.key_averages().table(sort_by="cuda_time_total", row_limit=10))

总结

掌握这些PyTorch核心概念后,你可以从容应对从简单回归问题到复杂图像识别、自然语言处理的各种AI任务。无论你是想快速验证一个新想法,还是需要构建生产级AI系统,PyTorch都能提供从研究到部署的全流程支持。

深度学习的世界充满无限可能,而PyTorch正是打开这扇大门的钥匙。现在就开始动手实践,将这些理论知识转化为解决实际问题的能力吧!