在基于ARM64架构进行开发或系统运维时,深入理解其内存管理机制至关重要。无论是开发高性能应用时出现的卡顿问题,还是服务器负载过高时的性能瓶颈,其根源往往都与内存访问、页表管理密切相关。掌握底层原理,是进行高效优化和稳定运维的基础。

一、Linux 内存管理基础概念

理解Linux arm64内存工作原理,需要从几个核心概念入手,这是剖析复杂机制的基石。

1.1 虚拟内存与物理内存

物理内存是计算机硬件实际拥有的内存空间,由内存条提供(如8GB、16GB)。它直接与CPU交互,速度极快,是数据真实存储和运算的场所。

虚拟内存则是操作系统创建的一种逻辑内存空间。它主要解决两个核心问题:

- 扩展内存空间:当物理内存不足时,操作系统可将暂时不用的数据移至磁盘(交换区),腾出物理内存供急需的程序使用。

- 提供进程隔离:在多进程环境下,虚拟内存为每个进程提供一个独立、连续的地址空间。进程通过虚拟地址访问内存,由内存管理单元(MMU)负责将其翻译为物理地址。这确保了进程间互不干扰,极大提升了系统安全性与稳定性。

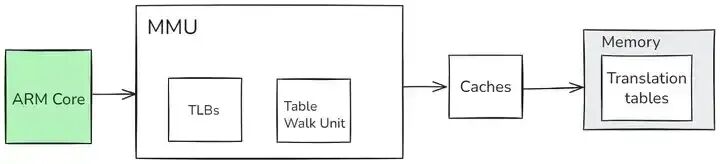

1.2 内存管理单元(MMU)

内存管理单元(MMU)是CPU中负责地址转换与内存保护的硬件组件。它扮演着“翻译官”和“警卫”的双重角色。

其核心工作流程如下:

- 地址转换:当CPU发出一个虚拟地址,MMU会查阅页表,找到对应的物理地址,再交由内存进行数据存取。

- 加速转换:为了提高转换速度,MMU内置了一个名为TLB(转址旁路缓存) 的高速缓存,用于存放最近使用过的页表项。若TLB命中,则可跳过访问内存中的页表,极大提升效率。

- 内存保护:MMU可以为每一块内存区域设置访问权限(如只读、读写、可执行)。当进程试图进行非法访问(如向只读区域写入数据),MMU会触发异常,由操作系统接管处理,从而防止系统崩溃或数据损坏。

二、ARM64 系统架构特点

ARM64架构为现代内存管理带来了强大的硬件基础。

2.1 64位寻址能力

相比32位架构的4GB寻址限制,ARM64采用64位地址总线,理论寻址空间高达2^64字节。虽然实际应用受限于硬件与操作系统,但这带来了质的飞跃,使其能够轻松应对需要处理海量内存的应用场景,如大数据分析、大型数据库以及复杂的企业级应用,避免了因内存不足导致的频繁磁盘交换,显著提升性能。

2.2 丰富的寄存器组与指令集优化

ARM64拥有31个64位通用寄存器,更充裕的寄存器资源减少了数据在内存和寄存器间的搬运次数,提升了数据处理效率,尤其利于计算密集型任务。

在指令集方面,NEON高级SIMD指令集是其重要特性。它支持单指令多数据操作,能在一个指令周期内并行处理多个数据单元。这在多媒体处理(如视频编解码、图像渲染)、音频信号处理以及科学计算中能带来显著的性能加速。

三、页表:虚拟地址与物理地址的桥梁

页表是操作系统用于记录虚拟页与物理页框映射关系的关键数据结构。内存被划分为固定大小的块(通常为4KB),虚拟内存中的块称为虚拟页,物理内存中的块称为物理页框。页表中的每个页表项(PTE) 则保存了一个虚拟页到物理页框的映射,以及该页的访问权限、状态等控制信息。

3.1 ARM64 的页表结构

ARM64主要支持两种页表层级结构,以适应不同的地址空间需求:

-

四级页表(48位VA):这是最常用的结构。它将虚拟地址(VA)划分为四个9位的索引和一个12位的页内偏移。

- PGD(页全局目录):第一级,通过VA[47:39]索引。

- PUD(页上层目录):第二级,通过VA[38:30]索引。

- PMD(页中间目录):第三级,通过VA[29:21]索引。

- PTE(页表):第四级,通过VA[20:12]索引,最终指向物理页框号(PFN)。

- 最终物理地址 =

(PFN << 12) | VA[11:0]。

-

三级页表(39位VA):适用于较小的地址空间。它省略了PUD层,将虚拟地址划分为三个9位的索引和一个12位的偏移,直接从PGD到PMD再到PTE。

3.2 页表的操作与维护

内核负责页表的全生命周期管理:

- 创建:在进程创建时,内核为其分配并初始化页表结构。

- 处理缺页:当进程访问一个尚未建立映射或页面被换出的虚拟地址时,会触发缺页异常。内核会分配物理页框(或从磁盘换入),并更新页表建立映射。

- 切换:进程切换时,内核会将新进程的页表基地址加载到MMU的寄存器中,实现地址空间的切换。

- 回收:当进程释放内存时,内核将对应页表项标记为无效,并回收物理页框。

四、虚拟地址的底层逻辑

4.1 虚拟地址空间布局

在Linux on ARM64中,虚拟地址空间被划分为两部分:

- 用户空间:供应用程序使用。每个进程都有自己独立的用户空间,包含代码段、数据段、堆、栈等。

- 内核空间:供操作系统内核使用。所有进程共享同一份内核空间,其中包含内核代码、数据以及用于系统管理的各种数据结构(包括页表本身)。

这种硬性隔离保证了用户程序的错误不会直接影响内核稳定性,用户程序需通过系统调用接口来请求内核服务。

4.2 虚拟地址到物理地址的转换过程

转换过程是MMU依据页表逐级查找的过程(以四级页表为例):

- CPU发出虚拟地址(VA)。

- MMU从专用寄存器获取当前进程的PGD基地址。

- 用VA[47:39]作为索引,在PGD中找到对应表项,获取PUD的物理地址。

- 用VA[38:30]索引PUD,找到对应表项,获取PMD的物理地址。

- 用VA[29:21]索引PMD,找到对应表项,获取PTE页表的物理地址。

- 用VA[20:12]索引PTE页表,找到最终的页表项,从中取出物理页框号(PFN)。

- 将PFN与VA的低12位(页内偏移)组合,得到最终的物理地址。

此过程中任何一级页表项无效或权限不足,MMU都会触发异常。

4.3 缺页异常处理

缺页异常是内存管理的核心机制之一,主要发生在:

- 首次访问:虚拟页面尚未分配物理页框。

- 页面换出:物理页框被回收,内容暂存于磁盘交换区。

处理流程:

- 硬件触发缺页异常,CPU转交控制权给内核的异常处理程序。

- 内核分析原因,分配新的物理页框(或从磁盘换入数据)。

- 内核更新页表,建立虚拟地址到新物理页框的映射。

- 内核恢复被中断的进程,使其重新执行导致缺页的指令,此时访问便能成功。

五、实际应用与性能优化

5.1 大页内存优化

标准内存页为4KB,当应用需要管理大量内存时(如数据库),会产生海量页表项,导致TLB命中率下降,增加地址转换开销。

大页(如2MB、1GB)通过增大单个页的尺寸,在管理相同容量内存时,显著减少页表项数量。这使得更多的地址映射能被TLB缓存,极大提升TLB命中率,减少MMU访存延迟,对于数据库、科学计算等内存密集型应用性能提升显著。在Linux中可通过配置 vm.nr_hugepages 等参数启用。

5.2 页表预分页与权限优化

在对实时性要求高的场景(如工业控制、嵌入式系统),可以通过预分页技术提前将进程可能访问的页面加载到内存,避免在关键任务执行时触发耗时的缺页中断。

同时,精细化设置页表项的访问权限(如将只读的数据区设置为不可写、不可执行),不仅能增强安全性,还能减少MMU的权限检查开销。例如,可以确保传感器数据区仅为只读,既保护了数据,也提升了访问效率。