当消息队列(MQ)出现百万级别的消息积压时,单纯地增加消费者实例往往效果有限。本文将系统性地讲解从紧急止血到长效优化的完整解决方案。

问题根源:消费者并行度受限于分区数

一个常见的误区是认为只要增加消费者数量就能线性提升消费能力。实际上,在类似Kafka这样的消息队列中,消费组的并行度由主题(Topic)的分区(Partition)数决定。一个分区在同一时刻只能被消费组内的一个消费者实例消费。

例如:

- 你的主题有 10 个分区。

- 你部署了 20 个消费者实例。

- 最终只有 10 个消费者在工作,另外 10 个处于空闲状态,造成资源浪费。

第一板斧:应急处理方案

当积压已经发生,首要目标是快速恢复系统正常。

方法一:在线扩容分区

这是最直接的应急手段。

方法二:创建新Topic分流

这是一个更稳妥的隔离方案。

- 操作步骤:

- 创建一个分区数更多的新Topic(例如

YourTopic_v2)。

- 将生产者的流量切换至新Topic。

- 为新Topic部署独立的消费组进行处理。

- 原理:将新增流量与历史积压流量物理隔离,确保新业务不受影响。

- 优点:对现有消费逻辑无侵入,风险低。

第二板斧:消费端长效优化

应急方案治标,优化消费者自身处理能力才能治本。

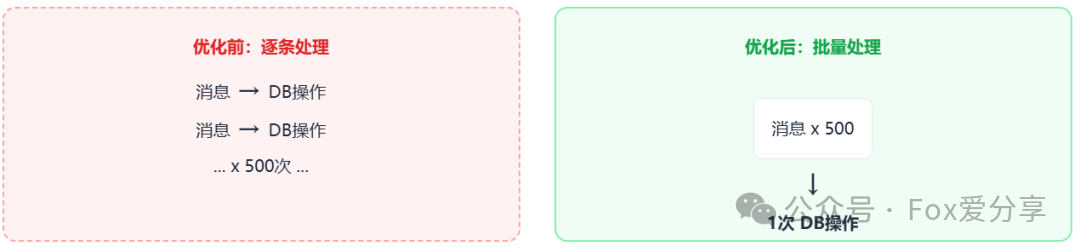

1. 实现批量处理

将多次网络I/O和数据库操作合并为一次,大幅降低开销。

- 优化前:单条拉取、单条处理、单条入库。

- 优化后:单次拉取一批消息(如500条),在内存中聚合处理,最后批量写入数据库。

- 效果:能极大减少网络与数据库的I/O压力。

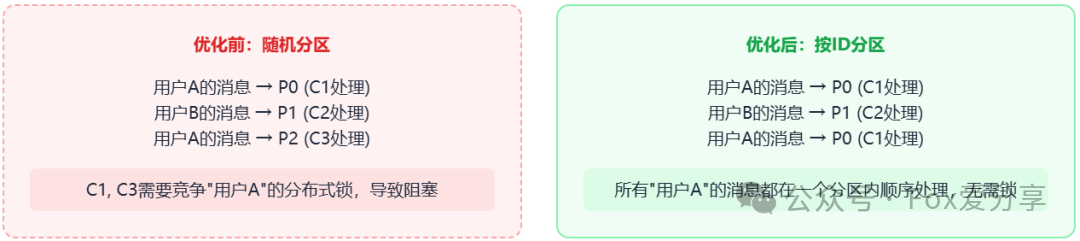

2. 优化锁竞争

通过合理的消息路由,避免不必要的分布式锁竞争。

- 优化前:消息随机分发到不同分区,多个消费者可能同时处理同一用户的请求,需要争抢分布式锁。

- 优化后:生产端以用户ID等业务键(Key)发送消息,保证同一用户的消息始终进入同一分区。同一个消费者实例串行处理该用户的所有消息,天然无需加锁。

- 效果:消除了锁开销,提升了单分区内的并发处理效率。

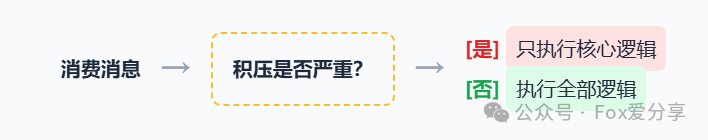

3. 服务降级与流控

为消费者增加动态降级能力,在高压下保核心业务。

- 思路:在消费者逻辑中内置降级开关。

- 监控:实时监控消费延迟(Lag)。

- 策略:

- 当

Lag > 10000 时,开启降级,仅执行核心业务逻辑(如扣减库存)。

- 当

Lag 恢复正常时,执行完整逻辑(核心逻辑 + 发通知、写日志等非关键操作)。

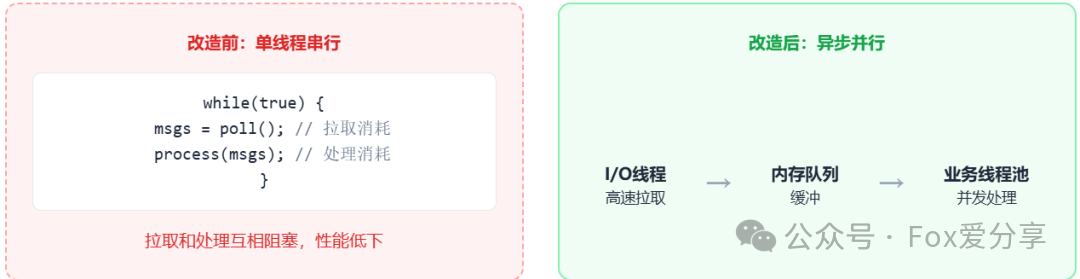

第三板斧:架构升级 - 异步消费模型

这是彻底释放消费端性能潜力的高级模式,核心思想是将消息的拉取(I/O)与业务处理(CPU计算)解耦。

- 传统模式:在一个线程循环中,拉取消息和处理消息串行执行,互相阻塞。

- 异步模型:

- I/O线程(1个):专门负责从MQ高速拉取消息,并放入内存阻塞队列。

- 内存队列(BlockingQueue):作为缓冲区,解耦I/O层与业务层。

- 业务线程池(N个):从内存队列中取出消息,并发执行业务逻辑,充分利用多核CPU。

此模型使得消费速度不再受限于单个消息的处理耗时,而是取决于业务线程池的总处理能力。

通过上述“应急处理 - 长效优化 - 架构升级”的三层递进方案,可以系统地应对和预防MQ消息积压问题,构建高可用的消息消费系统。 |