在人工智能领域,尤其是大型语言模型(LLM)的应用中,如何让模型高效地适应多变的环境与任务,是提升其实际效能的关键挑战。近期提出的ACE框架为这一难题提供了系统性的解决思路,通过动态的上下文工程,显著提升了智能体的学习与适应能力。

研究背景:上下文适应的重要性与挑战

随着LLM在智能代理与专业领域推理等场景中的深入应用,上下文适应(Context Adaptation)的价值日益凸显。这种方法的优势在于,它仅通过调整输入给模型的提示信息(Prompt)来提升性能,而无需修改模型本身的权重参数。

当前研究已证实,高质量的上下文能够有效引导模型执行下游任务、传递经验知识并减少“幻觉”现象。然而,传统方法常面临两大难题:一是设计过程繁琐,不够简洁;二是存在“上下文崩溃”风险,即随着信息不断追加,模型可能遗忘早期关键细节,导致性能下降。ACE(Agentic Context Engineering)框架旨在通过一种动态生成、反思与策展的循环过程,将上下文构建为一个持续进化的知识工具库。

核心方法:ACE框架的三元协作机制

ACE框架的核心是维护一份动态备忘录,并引入三个职能明确的模块化角色协同工作:

- 生成器:负责执行具体任务,生成推理轨迹。

- 反思器:分析生成器的成功与失败案例,从中提炼出经验教训。

- 策展人:将反思器总结的教训,系统性地整合并更新到结构化上下文中。

通过这种结构化的增量更新机制,ACE有效避免了信息过载导致的上下文崩溃,在保留详尽知识的同时,确保了上下文库的可扩展性与实用性。

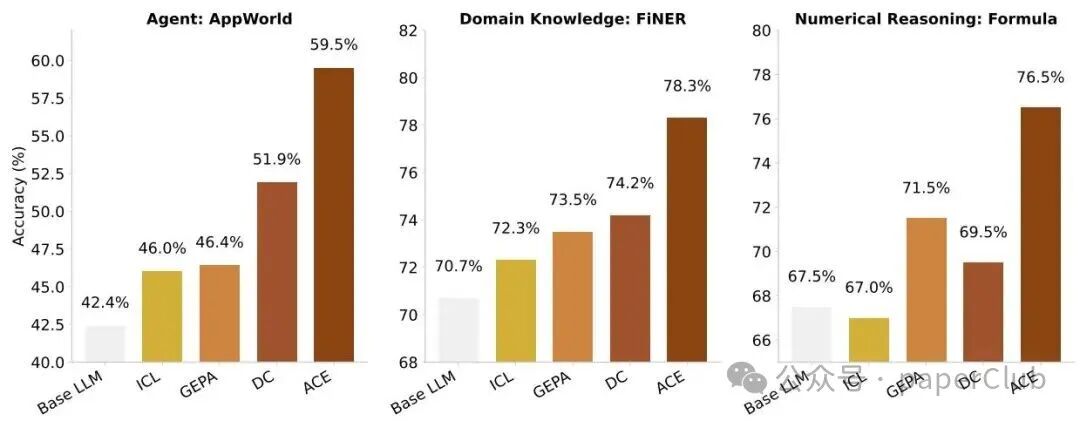

图1:ACE框架在多个代理和领域特定推理任务中,持续优于现有基线方法。

实验结果:在复杂任务中展现显著优势

评估显示,ACE框架在处理复杂任务时表现卓越,尤其在代理操作和领域特定基准测试上。例如,在金融分析基准测试中,凭借其全面的上下文生成与领域知识整合能力,ACE实现了平均8.6%的性能提升。

通过动态的反思与上下文更新,ACE不仅优化了代理的决策质量,还显著降低了模型适应新任务所需的时间与计算成本。

| 方法 |

GT Labels |

平均表现 |

| ReAct + ACE |

√ |

59.4% (+17.0%) |

| ReAct + ACE |

X |

57.2% (+14.8%) |

| ReAct + DC |

X |

51.9% (+9.5%) |

表1:AppWorld代理基准测试结果。ACE在不同条件下均展现出卓越的上下文适应与任务准确性。

结论与未来展望

ACE框架展示了LLM在自我改进与提升效率方面的巨大潜力,为大规模模型的适应性问题提供了创新思路。其通过利用任务执行中的自然反馈进行学习,减少了对大量人工标注数据的依赖,使得自我迭代更加高效。未来,ACE有望在自主智能体、专业化推理以及持续学习等前沿应用场景中扮演关键角色,进一步推动AI技术的发展。该框架已作为开源项目发布,供社区研究与使用。

文献信息

|