行业报告指出,数据中心服务器在运行时,约有30%的CPU算力被消耗在网络协议处理、虚拟化管理、存储I/O栈以及数据加密/压缩等基础性“杂活”上。这意味着,当客户在云上购买虚拟机或容器服务以部署业务应用时,实际能用于核心业务的计算资源只是服务器总资源的一部分。

在传统架构下,这种资源消耗尤为显著。工程师估算,仅处理2×25Gb网络的基础任务就可能占用超过8个vCPU。随着带宽提升,消耗呈指数级增长,例如在处理2×200Gb网络时,CPU消耗可能超过16个vCPU,这对计算密度和成本构成了严峻挑战。

DPU(Data Processing Unit,数据处理单元)的诞生正是为了扭转这一局面。它是一种专为卸载和加速数据中心基础设施任务而设计的专用处理器。简单来说,与运行应用逻辑的CPU和专注并行计算的GPU不同,DPU本身不运行客户业务,而是通过接管网络、存储、安全等“脏活累活”,为CPU腾出大量可产生收益的计算资源。在效率至上的数据中心行业,这颗被黄仁勋称为“第三颗主力芯片”的处理器,代表着显著的性能优势与切实的成本节约。

01 核心价值:效率超高的“杂活专员”

DPU成为数据中心架构革新的关键,源于其解决了传统架构中的几个根本性痛点:

资源与安全隔离是DPU提供的最直接价值。在传统共享CPU资源的架构中,客户应用与基础设施任务相互干扰,容易引发“吵闹邻居”效应,导致性能波动与下降。DPU通过硬件隔离彻底改变了这一状况。当网络协议处理、存储虚拟化、加密解密等任务从CPU卸载到DPU后,单台服务器通常可释放高达30%的CPU算力,这些资源可直接转化为可供售卖的计算实例。

在安全层面,传统的纯软件方案(如Hypervisor)仍存在潜在的侧信道攻击风险。DPU提供了硬件级的安全隔离,云平台的管理代码运行于DPU,客户代码运行于主机CPU,这种物理分离极大降低了攻击面,对于金融、政务等对数据安全有极高要求的行业尤为重要。

架构简化与效率提升是DPU带来的系统性收益。在复杂的传统虚拟化架构中,一个网络数据包需要经过物理网卡、主机驱动、虚拟交换机等多层软件栈,涉及频繁的上下文切换与内存拷贝,带来了额外的延迟与CPU开销。DPU支持硬件虚拟化(如vDPA),允许虚拟机绕过复杂软件层,直接与DPU通信。这不仅大幅提升了网络与存储性能,还显著降低了虚拟化架构的软件复杂性。有工程师指出:“vDPA将数据路径卸载到DPU后,其性能已无限接近物理网卡直通。”

02 技术路径:SoC与FPGA的路线之争

目前,DPU的实现主要有两大技术路径:高度集成的SoC方案和灵活可编程的FPGA方案。

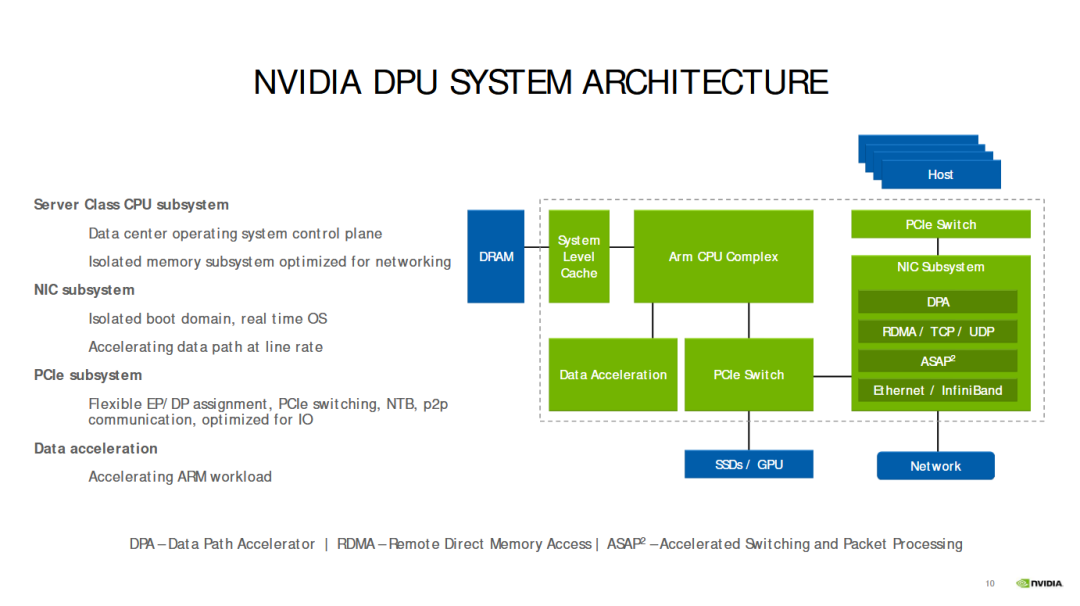

SoC方案是当前市场主流。它将多个处理核心、高速网络接口及各类专用加速引擎集成于单一芯片,形成一个完整的片上系统。典型的SoC DPU包含一个CPU子系统(如多个ARM核心)、PCIe控制器、内存控制器及完整的网络子系统,能够独立运行操作系统,实现对网络、存储、安全功能的全面卸载。

其网络子系统深度集成了RDMA(远程直接内存访问)、拥塞控制等关键功能。这种高集成度设计使得SoC方案在性能与能效方面表现卓越,尤其适合大规模、标准化的数据中心部署。英伟达的BlueField系列和Marvell的OCTEON系列是此路线的代表。

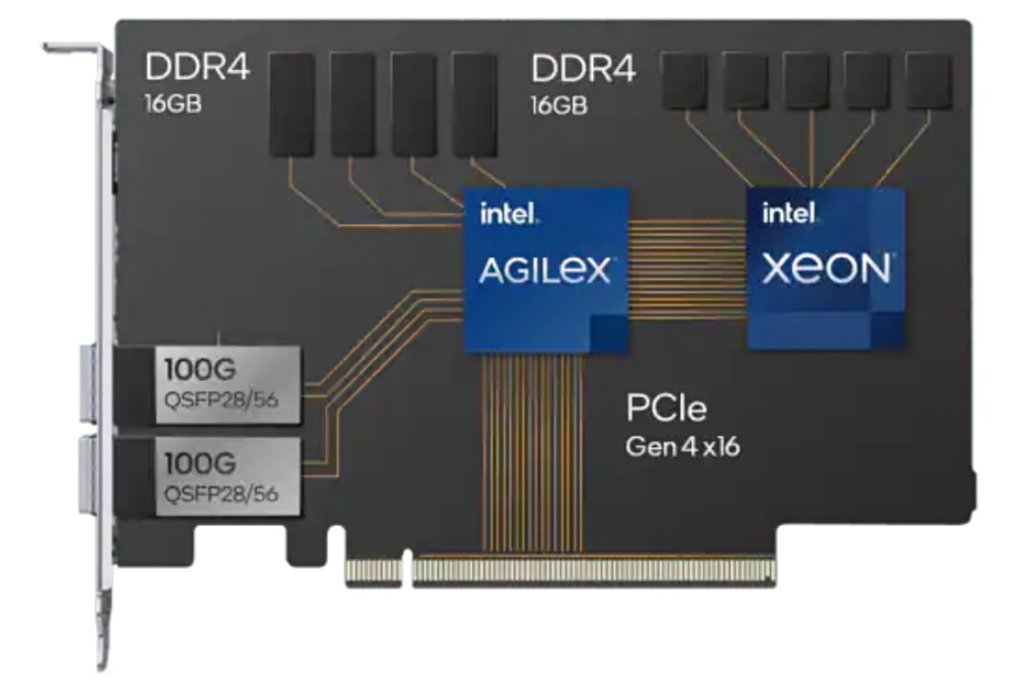

FPGA方案的核心优势在于其灵活性。该方案通常由FPGA芯片与辅助CPU通过PCIe协同工作:FPGA被编程为专用硬件,高效处理海量、规则明确的“数据平面”任务;CPU则负责运行操作系统,处理复杂的“控制平面”决策。

FPGA可通过重编程快速适应新的协议与标准,这对于技术快速迭代的数据中心环境极具价值。随着FPGA能力增强,现代方案已能将网络与存储加速功能完全实现在FPGA内,无需外挂网卡芯片。因此,追求差异化功能的云厂商常选择基于FPGA自研DPU,将自身业务特性固化到硬件中,构筑技术壁垒。阿里云、腾讯云等公有云巨头便采用了这一策略。

无论采用哪种路径,现代DPU都具备几个关键技术特征:高速网络接口(100G/200G及以上)、强大的可编程报文处理能力(如支持P4语言)、能独立运行操作系统的能力,以及集成的加密、压缩等硬件加速引擎。

03 全球巨头布局与国内厂商的追赶

DPU市场已成为全球芯片巨头与创业公司竞逐的新赛道。

英伟达凭借收购Mellanox获得的网络技术,推出了BlueField系列DPU,并将其与自家的ConnectX智能网卡技术深度融合。该系列从一代到三代持续演进,核心从ARM A72升级至A78,网络带宽不断提升。

英特尔则推出了功能定位类似的IPU(基础设施处理器)产品线。其策略是提供灵活的平台,技术路径涵盖基于Xeon D、ARM Neoverse的方案以及集成FPGA的混合方案,以满足客户的多样化需求。

此外,AMD、Marvell等公司也在积极布局。Marvell的OCTEON系列虽核心数众多(8-36个),但其设计更侧重于电信及5G应用场景。

面对这一潜力巨大的市场,国内云厂商与芯片创业公司也已快速跟进。阿里云发布了CIPU(云基础设施处理器),腾讯云推出了“玄灵”DPU产品。同时,中科驭数、星云智联、云豹智能、芯启源等一批创业公司也已获得资本加持,加速产品研发与市场落地。

云厂商选择自研DPU,主要驱动力在于实现差异化与获得快速响应能力。公有云业务各有特色,需要通过定制硬件来强化独特优势。同时,DPU的复杂性要求7x24小时的快速技术支持,依赖商业方案可能面临响应迟缓的问题。这促使阿里、腾讯等头部云服务商投入资源进行自主研发。

04 未来趋势:从卸载芯片到智能数据平台

随着技术演进,DPU正从功能单一的卸载设备向更智能的数据平台发展,呈现以下几大趋势:

集成度持续提高。未来的DPU将集成更强大的通用计算核心、更高速的网络接口(如400G/800G),甚至专用的AI加速引擎。英伟达已在尝试将GPU能力融入BlueField DPU,探索在数据路径上直接进行AI计算。

可编程性不断增强。P4等高级网络编程语言的普及,让工程师能够更便捷地定义数据包处理逻辑。增强的可编程性使DPU能够适应未来出现的全新网络协议与多变的工作负载,从而延长硬件生命周期。

应用场景不断拓展。除了传统数据中心,DPU正在进入智能驾驶、边缘计算、5G核心网等新兴领域。在智能汽车平台,DPU可实时处理海量传感器数据;在边缘侧,DPU能提供极低延迟的数据处理能力。

尽管前景广阔,DPU的普及仍面临生态碎片化的挑战。DPU的软硬件生态远比通用计算芯片复杂,需要与虚拟化层、操作系统、云管理平台进行深度集成。目前不同厂商的DPU在架构、编程模型上差异较大,导致应用移植和开发成本高企。

只有推动DPU的接口、编程模型和管理框架走向标准化,才能真正降低开发门槛,促进行业广泛采纳。此外,高性能DPU(单价约1500美元)的采购成本,对于需要万颗乃至十万颗级别部署的超大规模数据中心而言,也是一笔必须精打细算的投入。

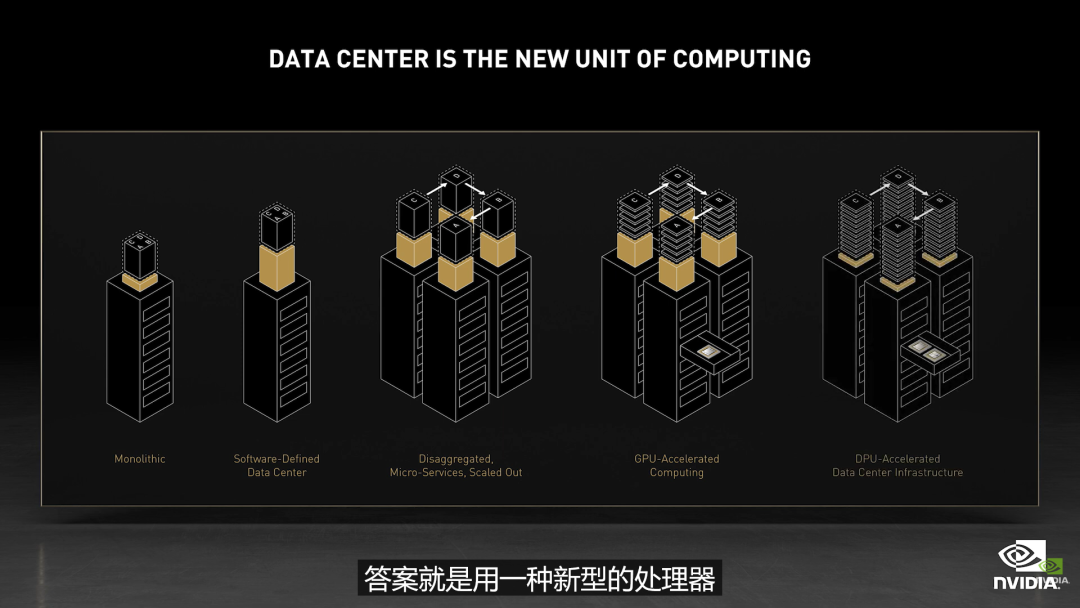

正如黄仁勋所言,“数据中心正成为新的计算单元”。为应对爆炸式增长的计算需求,数据中心的架构范式正在从“以CPU为中心”转向“以数据为中心”。

在新范式中,DPU能够将计算推向数据所在之处,最大限度减少不必要的数据搬运,从而显著降低延迟与整体能耗。从AWS的Nitro卡、微软Azure的Catapult项目,到英伟达BlueField、阿里云CIPU,全球云计算与芯片巨头均已在此领域重兵布局。随着数据中心规模持续扩张、算力需求不断增长,从云端到边缘,从5G到智驾,这颗“第三颗主力芯片”正在全方位地重塑计算的边界。