想象一下,在一个电商大促期间,海量的用户请求瞬间涌入,如果没有任何流量控制措施,整个微服务体系可能会因为某个服务的过载而迅速崩溃。服务限流正是应对这种场景的关键技术,它如同系统的“保险丝”或“智能收费站”,确保核心业务在可控的负载下稳定运行。作为流行的RPC框架,Dubbo提供了强大而灵活的限流能力,是构建高可用微服务架构的必备技能。

服务限流的核心价值与Dubbo特点

服务限流(Rate Limiting)的本质是通过控制单位时间内的请求访问速率来保护后端服务。在微服务架构中,服务间依赖复杂,限流能够有效防止因单一服务故障引发的“雪崩效应”。

Dubbo限流的主要优势包括:

- 多维度控制:支持服务级别、方法级别乃至参数级别的精细限流。

- 策略灵活:内置多种经典限流算法,并支持自定义扩展。

- 实时性高:部分配置支持动态调整,无需重启应用。

- 集成性好:与Dubbo的过滤器链无缝集成,对业务代码侵入性低。

Dubbo限流原理解析

要有效使用限流,首先需要理解其背后的核心概念与运行机制。

核心限流算法对比

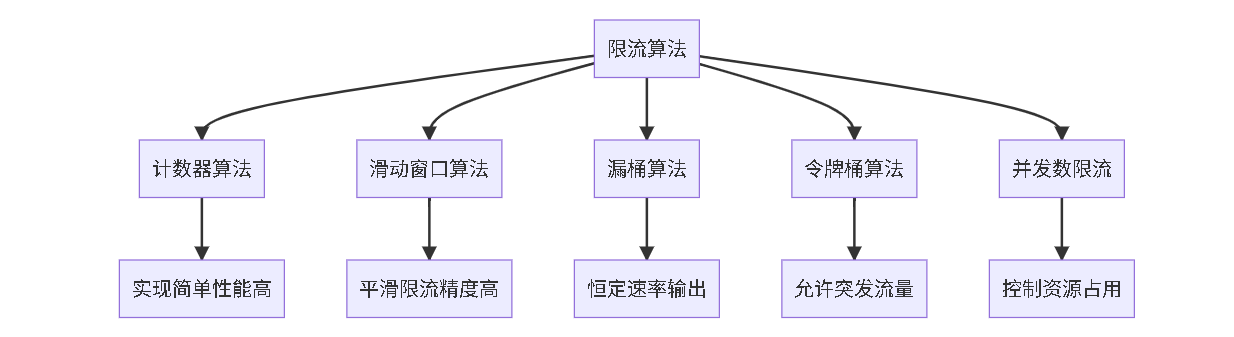

Dubbo支持多种限流算法,选择合适的算法对效果至关重要。下图对比了几种常见算法的特点与适用场景:

- 计数器/滑动窗口算法:实现简单,性能高,常用于简单场景或分布式限流。

- 漏桶算法:能够以恒定速率处理请求,平滑流量,但对突发流量不友好。

- 令牌桶算法:允许一定程度的突发流量,是兼顾平滑性与灵活性的常用选择。

- 并发数限流:严格控制系统资源(如线程)的占用,防止过载。

限流在Dubbo中的执行流程

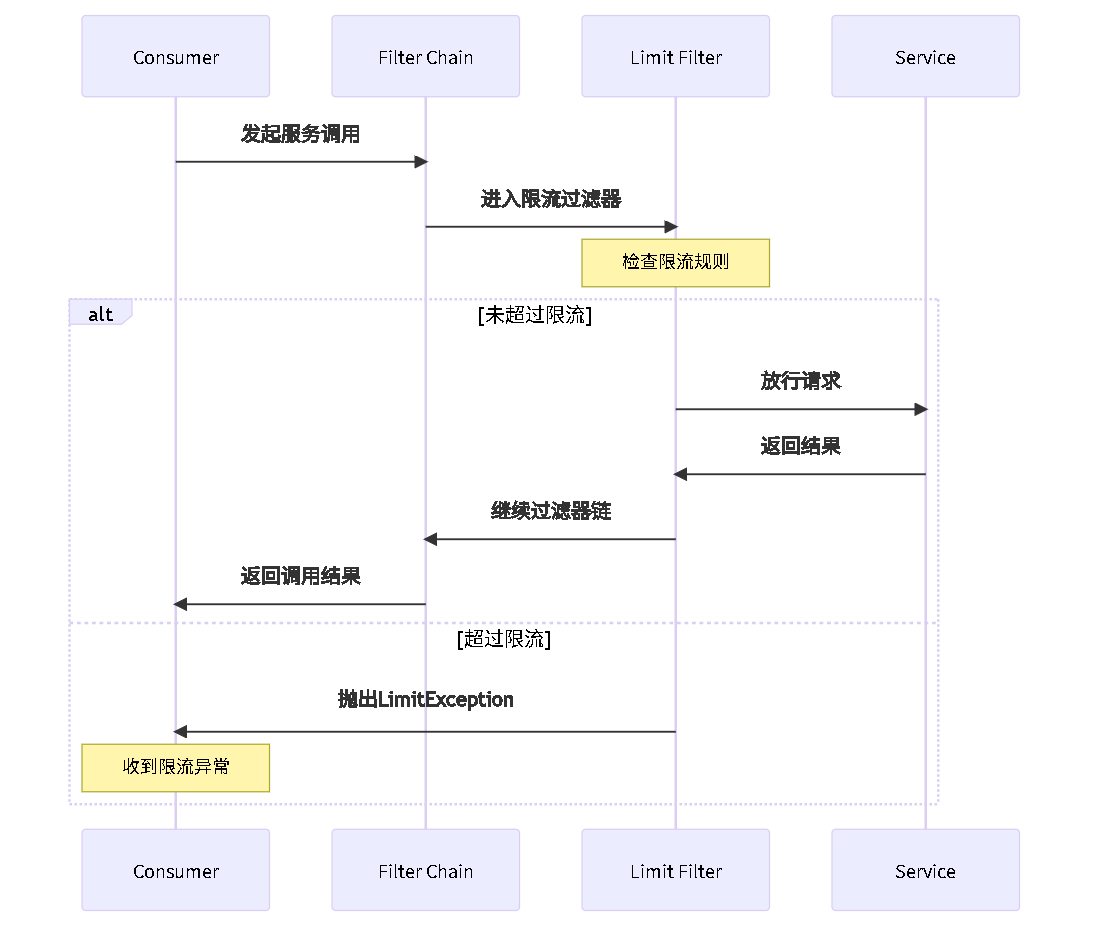

Dubbo的限流主要通过过滤器(Filter)机制实现。其核心执行流程如下图所示,清晰展示了从请求发起到被放行或限制的完整路径:

流程可以简化为以下步骤:

- 消费者(Consumer)发起RPC调用。

- 请求进入过滤器链,触发限流过滤器(Limit Filter)。

- 过滤器根据配置的规则(如TPS、并发数)进行检查。

- 若未超限,则放行请求,继续后续调用;若超限,则抛出限流异常。

其内部核心逻辑体现在过滤器实现中:

public class TpsLimitFilter implements Filter {

@Override

public Result invoke(Invoker<?> invoker, Invocation invocation) {

// 1. 获取本次调用的限流策略

TpsLimitStrategy strategy = getTpsLimitStrategy(invoker, invocation);

// 2. 尝试获取许可(执行限流检查)

if (!strategy.tryAcquire()) {

// 3. 若超过阈值,抛出限流异常

throw new RpcException("Service exceed limit: " + strategy.getLimit());

}

// 4. 检查通过,继续执行后续调用链

return invoker.invoke(invocation);

}

}

Dubbo限流实战配置详解

Dubbo提供了注解、XML、YAML/Properties等多种配置方式,适应不同项目需求。

基于注解的配置(推荐)

注解配置最为直观,与业务代码结合紧密。

1. 服务提供者端限流

在服务实现类或方法上直接声明限流规则。

@Service

public class UserServiceImpl implements UserService {

// 方法级别TPS限流:每秒最多50次调用

@TpsLimit(50)

@Override

public User getUserById(Long id) {

return userDao.getById(id);

}

// 详细配置:使用令牌桶算法,每秒100次

@TpsLimit(limit = 100, interval = 1000, rateLimitStrategy = "tokenBucket")

@Override

public List<User> searchUsers(String keyword) {

return userDao.search(keyword);

}

// 并发数限流:该方法最大并发执行数为10

@ConcurrentLimit(10)

@Override

public void updateUser(User user) {

userDao.update(user);

}

}

2. 服务消费者端限流

在引用服务时,对调用端进行限流保护。

@Component

public class OrderService {

// 在@Reference中配置,对此服务的调用进行限流

@Reference(version = "1.0.0", parameters = {"tps", "200", "tps.interval", "1000"})

private UserService userService;

}

基于XML的配置

适用于传统Spring项目或希望集中管理配置的场景。

<!-- 服务提供者配置示例 -->

<dubbo:service interface="com.example.UserService" ref="userService"

version="1.0.0" tps="100" executes="50">

<!-- 方法级别细化配置 -->

<dubbo:method name="createOrder" tps="50" executes="20"/>

</dubbo:service>

<!-- 服务消费者配置示例 -->

<dubbo:reference id="userService" interface="com.example.UserService"

version="1.0.0" tps="200" actives="100"/>

基于YAML/Properties的配置

这是Spring Boot和云原生架构下的主流配置方式。

# application.yml

dubbo:

application:

name: user-service

provider:

tps: 1000 # 全局默认TPS限制

consumer:

tps: 500 # 消费端全局TPS限制

services:

userService:

interface: com.example.UserService

tps: 200 # 服务级限制

executes: 100 # 并发数限制

methods:

- name: getUserById

tps: 100 # 方法级限制

executes: 50

高级策略:分布式限流与自定义扩展

当服务以多实例部署时,单机限流不足以控制全局流量,需要引入分布式限流。

基于Redis实现分布式限流

利用Redis的原子操作和过期特性,可以高效实现集群级别的统一限流。

@Component

public class RedisTpsLimitStrategy implements TpsLimitStrategy {

@Autowired

private RedisTemplate<String, String> redisTemplate;

private static final String LIMIT_KEY_PREFIX = "dubbo:tps:";

@Override

public boolean tryAcquire(String serviceName, String methodName, int limit, int interval) {

String key = LIMIT_KEY_PREFIX + serviceName + ":" + methodName;

long current = System.currentTimeMillis();

// 使用Lua脚本保证原子性

String luaScript = """

local key = KEYS[1]

local limit = tonumber(ARGV[1])

local interval = tonumber(ARGV[2])

local current = tonumber(ARGV[3])

-- 清理时间窗口外的旧数据

redis.call('zremrangebyscore', key, 0, current - interval * 1000)

local count = redis.call('zcard', key)

if count < limit then

redis.call('zadd', key, current, current)

redis.call('expire', key, interval)

return 1

else

return 0

end

""";

// 执行脚本...

Long result = redisTemplate.execute(script, keys, args);

return result != null && result == 1;

}

}

这种方案依赖Redis等外部存储,确保了集群内限流计数的一致性。

动态限流与配置中心集成

结合Nacos、Apollo等配置中心,可以实现限流规则的热更新。

@Component

public class DynamicTpsLimitManager {

@Autowired

private ConfigService configService; // 配置中心客户端

private Map<String, TpsLimitConfig> limitConfigs = new ConcurrentHashMap<>();

@PostConstruct

public void init() {

// 监听配置中心的规则变更

configService.addListener("dubbo-tps-rules", this::refreshConfig);

}

private void refreshConfig(String newConfig) {

// 解析新配置并更新内存中的规则

limitConfigs = parseAndLoad(newConfig);

}

}

限流监控、排查与最佳实践

配置限流后,必须建立监控以观察效果并排查问题。

关键监控指标

监控应关注以下核心数据:

- 通过请求数/被限流请求数:直接反映限流策略的松紧程度。

- 请求通过率:健康服务应保持在较高水平。

- 系统资源使用率:结合CPU、内存、线程池状态判断限流必要性。

可以与Prometheus等监控系统集成:

dubbo:

metrics:

enable: true

protocol: prometheus

management:

endpoints:

web:

exposure:

include: prometheus

常见问题排查指南

| 问题现象 |

可能原因 |

解决方案 |

| 频繁触发限流 |

阈值设置过低,或真实流量超预期。 |

基于压测结果调整阈值;分析业务流量模式。 |

| 限流规则不生效 |

配置方式错误、过滤器未加载。 |

检查配置语法;通过日志确认过滤器链。 |

| 分布式限流不一致 |

Redis集群节点间数据延迟。 |

使用RedLock等强一致性方案,或接受短暂不一致。 |

| 引入限流后性能下降 |

限流检查逻辑开销过大(如频繁访问Redis)。 |

采用本地限流为主,分布式限流兜底;优化检查算法。 |

最佳实践场景案例

电商系统场景化配置示例:

dubbo:

services:

userService:

methods:

- name: getUserById # 高频查询,限流可放宽

tps: 1000

- name: updateUser # 低频更新,限流收紧

tps: 100

orderService:

methods:

- name: createOrder # 核心交易,重点保护,中等限流

tps: 500

executes: 100

inventoryService:

methods:

- name: reduceStock # 防超卖关键操作,严格限流

tps: 300

executes: 50

容量规划参考公式:

限流阈值不应随意设置,可参考以下思路进行估算:

public class CapacityCalculator {

/**

* @param maxCapacity 系统压测最大容量 (TPS)

* @param safetyFactor 安全系数 (建议0.6-0.8)

* @param peakFactor 预估流量峰值系数 (建议1.5-3.0)

*/

public static int calculateTpsLimit(int maxCapacity, double safetyFactor, double peakFactor) {

// 公式:限流值 = 最大容量 × 安全系数 × 峰值系数

return (int) (maxCapacity * safetyFactor * peakFactor);

}

}

// 示例:系统最大处理1000 TPS,想要保留30%安全余量,并承受2倍峰值

// 建议限流值 = 1000 * 0.7 * 2.0 = 1400 TPS

总结

Dubbo服务限流是保障微服务架构高可用的关键环节。有效运用限流,需要:

- 理解原理:掌握不同限流算法的特点及Dubbo的过滤器机制。

- 熟练配置:根据项目情况,灵活运用注解、XML或YAML进行多维度配置。

- 进阶运用:在分布式场景下,结合Redis实现集群限流,并联动配置中心实现动态规则。

- 重视监控:建立关键指标监控,为限流策略的调优提供数据支撑。

- 合理规划:基于系统压测数据和业务目标,科学设置限流阈值,而非盲目猜测。

限流的最终目的并非限制业务发展,而是在流量风暴中为系统树立一道牢固的堤坝,确保核心业务航线的畅通无阻。通过本文介绍的原理解析、实战配置与进阶策略,你可以系统地构建起适合自身系统的Dubbo限流方案。