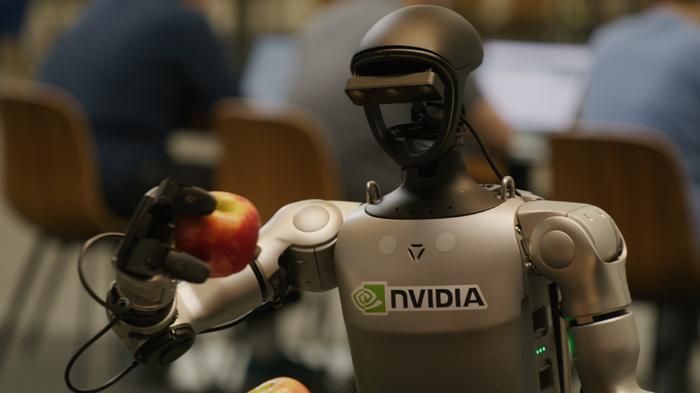

在本系列教程中,我们将带领开发者从Isaac Sim 仿真环境起步,逐步过渡到Jetson 硬件平台,完成真机部署与虚实验证,打通机器人开发、测试与落地的完整链路。

在具身智能快速发展的当下,如何安全、高效地训练和验证能够理解并改造物理世界的机器人,是行业面临的核心难题。传统的开发模式正面临一系列严峻挑战,严重制约着从算法创新到现实应用的进程,主要体现在以下四个方面:

- 高昂的试错成本与安全风险:实体机器人的硬件损耗、碰撞损坏以及在不稳定环境下的测试风险,使得每次实体调试都代价高昂。

- 数据匮乏与长尾场景难题:在现实世界中收集海量、特别是罕见的“边缘案例”数据(如突发干扰、极端光照天气)极为困难,导致算法存在性能盲区。

- 算法、硬件与环境的强耦合困局:软件算法的微小改动可能引发硬件调整需求,反之亦然,形成“牵一发而动全身”的迭代僵局,开发效率低下。

- “仿真到现实”的可靠性鸿沟:在简化仿真中表现优异的算法,常因模型失配而无法在复杂的物理世界中保持同等性能。

这些问题相互交织,成为制约具身机器人技术规模化落地的关键阻碍,而高保真仿真模拟正是解决上述难题的核心路径。

传统方案的瓶颈:Gazebo + ROS 2

Gazebo 与 ROS 2 的组合是目前市场上普及度较高的开源方案,两者均有近二十年的历史,在机电控制的灵活性与效能方面表现不错,长期作为机器人研发的标准仿真工具链,对创客与学生项目在成本上较为友好。其开源生态、社区支持以及与 ROS 工具的高度集成使其广受欢迎。然而,在面对现代机器人系统日益复杂的需求时,该组合也暴露出若干关键短板:

- 物理与渲染保真度有限:虽然支持基本的刚体动力学和传感器仿真(如激光雷达、摄像头),但其物理引擎(如 ODE、Bullet)在高精度接触建模、软体交互或多体耦合场景中表现一般;同时,其图形渲染能力较为基础,难以生成逼真的视觉数据用于训练深度学习模型。

- 大规模/多机器人仿真效率低:在处理大量机器人实体或复杂环境时易出现性能瓶颈,尤其在 CPU 密集型仿真中帧率下降明显,难以支持大规模并行仿真实验。

- 传感器建模精度不足:传感器插件(如相机、IMU、LiDAR)多为简化模型,缺乏对噪声、畸变、运动模糊等真实世界因素的精细建模,限制了感知算法在仿真到现实(Sim2Real)迁移中的泛化能力。

- 开发与调试体验割裂:Gazebo 与 ROS 2 虽可集成,但调试流程常需跨多个终端和工具(如 rviz、rqt、gazebo GUI),且可视化与仿真的同步性较差;此外,Gazebo 的 Python API 支持较弱,限制了快速原型开发。

- 缺乏对 AI 工作流的原生支持:Gazebo 本质上是传统物理仿真器,未针对机器学习训练流程进行优化,例如不支持自动微分、策略梯度回传或与主流 强化学习框架 的无缝对接。虽然可通过插件进行一定程度的集成,但实现过程并不简单。

以下是从技术复杂度、工程成本、维护负担三个维度对常见方案的评估参考:

综合来看,Gazebo + ROS 2 方案比较适合实验室级原型验证、小型机器人研发(如教学、科研原型)等任务。但对于需要高精度环境感知以及集成大量AI模型的具身智能机器人开发,则显得力有未逮。

剖析 NVIDIA Isaac AI 机器人开发平台

NVIDIA Isaac 开发平台自 2017 年发布以来,历经多年迭代,已从基础开发套件演进为覆盖机器人全生命周期的综合生态。其核心组件贯穿“仿真-学习-AI-部署”全流程,以下是各关键组件的功能解析:

- 底层支撑技术:为核心组件提供运行基础,开发者重点在于掌握其应用场景。

- Omniverse Kit:用于构建原生 Omniverse 应用和微服务的工具包,通过轻量级插件(C接口)和 Python 解释器,确保兼容性与开发灵活性。

- PhysX高保真物理引擎:模拟机器人与环境的真实交互(如刚体碰撞、软体形变),确保仿真结果贴近现实,提升 Sim-to-Real 迁移成功率。

- OmniGraph:可视化工作流编排工具,通过拖拽节点连接“场景触发-数据处理-动作执行”流程(如“传感器检测到障碍物→触发导航避障”),减少编码工作量。

- OpenUSD:跨平台 3D 场景描述标准,支持 Isaac Sim 与其他工具(如 Blender/Maya)的资产复用,极大简化了复杂场景的搭建流程,是实现高效云原生开发工作流中资产管理和协作的基础。

- 仿真平台 Isaac Sim:基于 NVIDIA Omniverse 构建的高保真机器人仿真引擎,支持虚拟开发、合成数据生成与虚实联动测试。

- 3D 场景搭建与机器人模型导入(支持 URDF 格式)。

- 高精度传感器仿真(相机/激光雷达/IMU)。

- 合成数据生成(SDG)。

- 软件在环(SIL)与硬件在环(HIL)测试。

- 集成 ROS2 Bridge 扩展,实现与 RViz2 等工具的数据通信与可视化。

- 提供超 1000 个 SimReady 3D 资产,支持快速拖拽搭建测试场景。

- 学习框架 Isaac Lab:轻量级机器人学习工具,依托 Isaac Sim 实现大规模并行仿真训练,专注强化学习(RL)与模仿学习。

- 封装强化学习算法,提供标准化训练接口。

- 支持批量仿真训练,极大提升数据采样效率。

- 允许自定义奖励函数,以引导智能体学习目标行为。

- 提供仿真到现实(Sim-to-Real)迁移工具集。

- 支持通过修改配置文件和利用 GR00T Mimic 等工具扩增数据,进行自定义训练。

- 融合 AI 技术:集成生成式 AI 与任务型 AI,赋能机器人感知、交互与决策。

- COSMOS生成式模型:作为世界基础模型(WFM),支持高保真合成数据生成与场景理解,加速感知模型训练。

- GR00T任务模型:作为视觉语言动作(VLA)模型,专注于根据语言指令完成抓取、导航等端到端任务。

- 模型可通过 NVIDIA NGC 平台获取。

- 可在 Isaac Sim 中启用 COSMOS 扩展生成带标注的合成数据。

- 可通过 TensorRT 优化 GR00T 模型,并集成到 Isaac ROS 节点进行部署。

- 部署接口 Isaac ROS:基于 ROS 2 构建的 GPU 加速机器人框架,是连接仿真与真实硬件的关键枢纽。

- 提供 CUDA 加速的感知算法(如 SLAM、目标检测)。

- 采用 NITROS 实现零拷贝数据传输,降低延迟。

- 提供模块化 GEM 软件包,即插即用。

- 针对 Jetson 等边缘设备进行部署优化,是整个系统能否成功运维部署到真实机器人的最后关键一环。

总体而言,Gazebo + ROS2 的功能大致相当于 Isaac 平台中仿真环节的一部分。面对未来空间智能的复杂需求,一个更集成、更高保真且原生支持 AI 工作流的平台显得尤为必要。

认识 NVIDIA Isaac AI 开发平台工作流

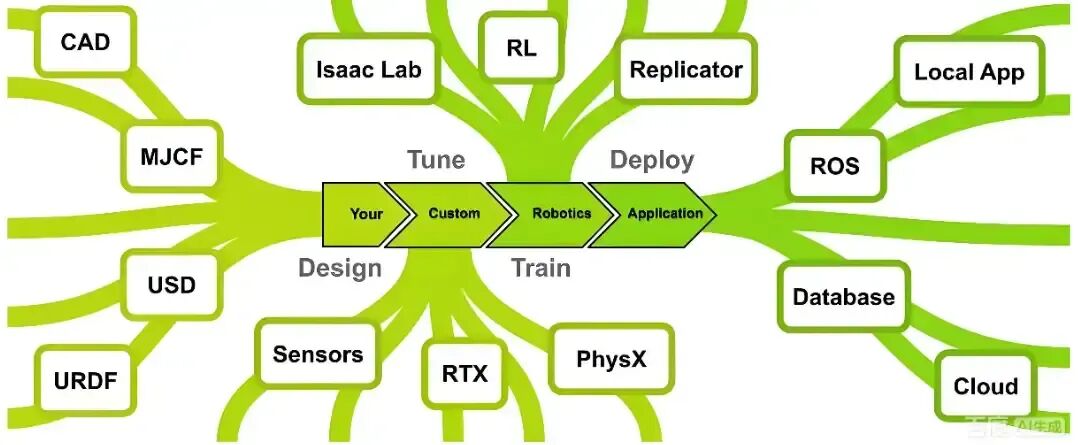

下图展示了基于 Isaac Sim 的典型机器人开发工作流:

流程从左至右分为四个阶段:

- 设计阶段:导入和调整以常用格式(如 URDF、MJCF)设计的机器人模型。这得益于通用场景描述(USD)的使用,USD 是 Isaac Sim 的核心数据交换格式,确保了与各类设计工具的良好兼容性。

- 优化阶段:此阶段是 Isaac Sim 的核心。利用基于 GPU 的高保真 PhysX 物理引擎和 RTX 渲染器,对装配了各类传感器(摄像头、激光雷达等)的机器人数字孪生进行仿真。开发者可以使用 Replicator 生成合成数据、通过 OmniGraph 编排仿真逻辑、调整物理参数以匹配现实,并最终为训练控制智能体做好准备。

- 训练阶段:Isaac Lab 在此扮演“导演”角色,它提供标准化的机器人任务模板,封装环境构建逻辑,并管理训练生命周期。它结合了扮演“策略学习者”的强化学习算法与作为“数据工厂”的仿真环境(Isaac Sim),支持强化学习、模仿学习等多种范式。

- 部署阶段:平台提供将训练好的智能体部署到真实机器人所需的全套组件。通过 Omniverse 的应用程序 API、与 ROS 2 的桥接以及高性能的 NVIDIA Isaac ROS 软件包,可以实现仿真环境与真实硬件之间的通信与集成,完成最终的应用构建。

理解这一工作流,有助于厘清 Isaac 平台内各软件组件间的分工与协作关系,为后续实际开发奠定清晰的基础。

下一步:SIL 与 HIL 测试

深入了解了 NVIDIA Isaac 平台的架构后,我们面临一个关键议题:如何确保在虚拟环境中训练的智能体能够可靠地迁移到现实世界?这就引出了两个至关重要的验证概念:软件在环(Software-in-the-Loop, SIL)和硬件在环(Hardware-in-the-Loop, HIL)。

SIL 测试允许我们在开发早期,在纯仿真环境中验证机器人的控制逻辑和算法;而 HIL 测试则更进一步,将真实的硬件(如控制器、传感器)接入仿真环路,实现对整个系统在接近真实条件下的严格校验。这两种方法是提升机器人系统可靠性、安全性和开发效率不可或缺的环节。

在后续的内容中,我们将详细探讨 SIL 和 HIL 在 Isaac Sim 中的具体实施方法与最佳实践。 |