你有没有过这样的体验?对着语音助手说话,它每个字都听清了,但你依然觉得“它不懂我”。

问题往往不在于听不清,而在于听不懂情绪。

而这,正是语音交互技术领域一个关键的质变点。最近,一款名为 Fun-Audio-Chat-8B 的语音大模型引发了行业关注。相比参数规模或榜单排名,更值得注意的是一个细节:它开始真正“在意”你说话时的情绪和状态。这并非营销噱头,而是语音AI向“拟人化”理解迈出的重要一步。

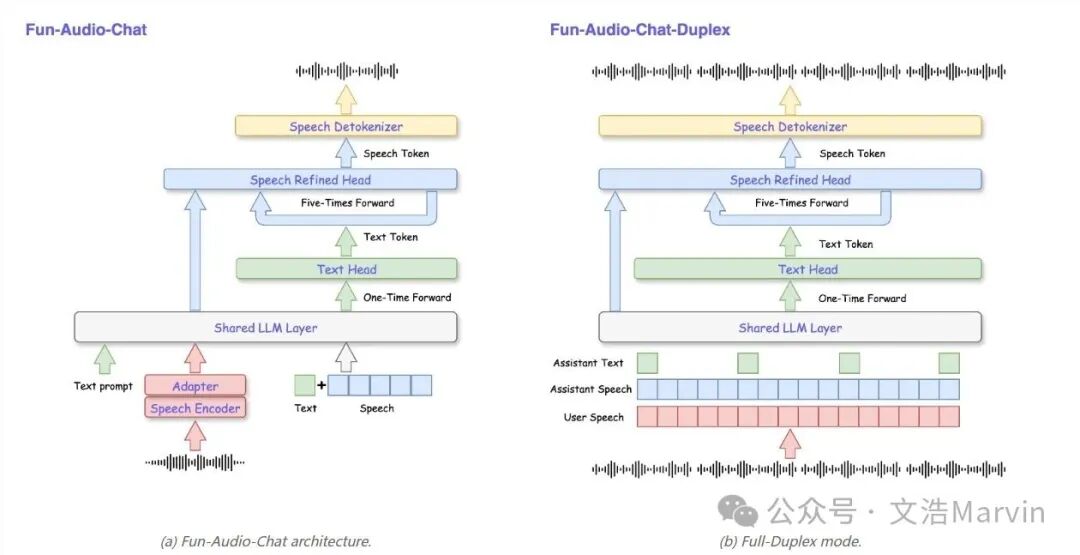

图:Fun-Audio-Chat-8B的架构示意图,支持单工与全双工交互模式,集成了语音编码、文本生成等模块。

语音交互的长期痛点:只听内容,不懂感受

过去很长一段时间,语音AI的进化方向高度趋同:识别更准、回答更快、信息更全。但人类沟通从来不只是信息交换。

当你语速放慢、声音变低,可能意味着疲惫;当你语气急促、停顿减少,可能透露着焦虑;当你一句话说到一半戛然而止,或许是在犹豫。传统的语音系统会将这些丰富的副语言信息全部“抹平”,只留下干巴巴的文本。结果就是:回答的内容或许没错,但回应却冰冷且缺乏共情。

情感感知,让语音AI跨过“像工具”的门槛

真正的变革在于,以 Fun-Audio-Chat-8B 为代表的新一代模型,开始将声音本身视为重要的信息源,而不仅仅是文字的附属载体。

通过分析语气、音高、节奏和停顿等声学特征,模型能够初步判断用户的实时情绪状态,并据此动态调整回应的语气、长度和内容深度。同一句文本指令,在用户疲惫或兴奋的不同状态下,得到的反馈不再是千篇一律的模板答案。

这意味着什么?这意味着语音AI正在从被动的“答题机器”,转变为能够主动适应对话者状态的交流对象。这种体验上的差异,往往不是功能级别的增减,而是整体“交流感”的跃升——你会隐约觉得,对面的声音似乎在认真倾听。

为什么“共情”比“聪明”有时更重要

许多人低估了情感理解在人机交互中的重要性。在简单信息查询、指令执行等场景中,情绪似乎无关紧要。然而,一旦进入更高频、更长期的深度使用场景,如情感陪伴、智能客服、车载系统或智能家居,情绪感知就成了决定用户体验成败的关键。

一个具备初步共情能力的语音系统,能够做到以下几点:

- 在你疲惫时,减少不必要的打断和冗余信息。

- 在你烦躁时,自动简化反馈流程,提供最直接的解决方案。

- 在你开心或健谈时,顺势延展对话,提供更丰富的互动。

这追求的并非单纯的“更聪明”,而是更体贴。而体贴,恰恰是人类最容易建立信任和依赖的情感纽带。

从“能用”到“愿用”,情感交互是关键一步

当前,语音AI的发展重点正在从“我能不能做到某项功能”,转向“用户愿不愿意长期使用”。当AI能够解读情绪,它便不再只是一个冰冷的功能入口,而是开始具备某种陪伴属性。这也解释了为何越来越多的语音模型不再片面强调“回答正确率”,而是更加注重“交流的自然度”与“对话的节奏感”。

技术参数在飞速进步,但最终被用户记住并喜爱的,永远是那份细腻的体验。当你说完一句话,从回应中能感受到被理解,那一刻,真正的语音交互才得以成立。

或许在不久的将来,我们评价一个语音助手的标准将发生改变。我们不会再仅仅询问“它好不好用”,而是会提出一个更接近人类社交本质的问题:“它,懂不懂我?”

而这,正是语音AI下一阶段竞争的核心战场,也是推动AIGC技术真正融入日常生活的关键。对于关注此类技术进展的开发者,可以持续在云栈社区交流探讨。 |