本帖最后由 alphaFind 于 2026-1-16 23:17 编辑

做量化策略或者复现 Paper 的时候,最搞心态的环节是什么?

绝对不是推导逻辑,而是对着 PDF 里那一行行密密麻麻的 Alpha 因子公式,手动把它们敲成 LaTeX 或者 Python 代码。

括号漏了一个、希腊字母 $\xi$ 和 $\zeta$ 看花眼、矩阵怎么都对不齐……这些毫无技术含量的重复劳动,硬生生把原本用来思考策略的时间给吞了。

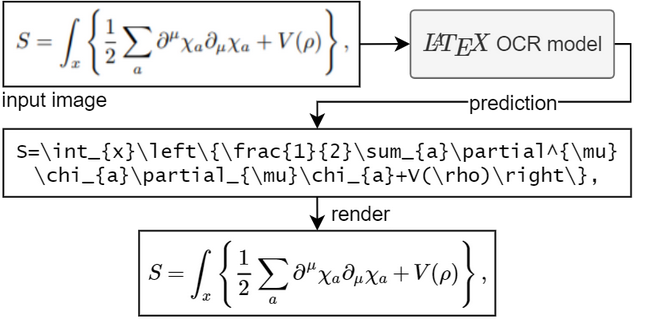

最近在 GitHub 上翻到一个叫 LaTeX-OCR (pix2tex) 的项目,试用了一下,真心觉得是“解放双手”级别的神器。简单说,它能把数学公式截图,直接“翻译”成代码。

01 它凭什么比普通 OCR 准?

很多通用的 OCR 工具识别文字还行,一碰到复杂的数学符号就歇菜。

LaTeX-OCR 的聪明之处在于,它没把这当成简单的字符识别,而是当成了“翻译”任务来做。它用的是 Encoder-Decoder 架构,这在 云栈社区 的很多 人工智能 讨论帖里都是标配:

- 眼睛(Encoder):用 ResNet 提取纹理,再加 Vision Transformer (ViT) 去看全局。这很重要,因为公式里的括号是成对的,离得再远,模型也得知道它们是一家的。

- 嘴巴(Decoder):基于 Transformer,把看懂的图像特征,一个词一个词地“写”成 LaTeX 代码。

这种设计让它不仅是“认字”,更是在理解公式的逻辑结构。

02 怎么用最顺手?

作者 Lukas Blecher 提供了好几种玩法,但我只推荐两种最实用的:

第一种:桌面端“偷懒”神器

它自带一个 GUI 工具,装好后就像截图软件一样。你在屏幕上框选一个公式,后台瞬间识别,然后自动把 LaTeX 代码塞进你的剪贴板。写文档或者做笔记的时候,简直不要太爽。

第二种:API 服务化

这才是重头戏。它内置了 FastAPI,可以自己部署成一个微服务。

这就意味着,你可以写个脚本,批量把一堆 PDF 里的公式截图发给它,它返回代码。对于喜欢折腾工具链的朋友,在 云栈社区 的 开源实战 板块里,经常能看到大家用这类工具搭建自动化的工作流。

03 量化人的“挖矿铲子”

对于 alphaFind 的读者,我们关注的永远是效率。这个项目完全可以嵌入到我们的自动化研报分析链路里:

- 研报结构化:配合文档解析工具,把旧版 PDF 里的数学模型抠出来。

- 因子库自动构建:截图转成 LaTeX 后,再用

latex2sympy 转成 Python 表达式,直接扔进回测引擎跑数据。

- 笔记数字化:只要你手写的字迹别太潦草,它甚至能识别手写公式。

04 避坑指南

项目支持 Docker 部署,环境配置不难。不过提醒一句,虽然它能用 CPU 跑,但如果你要批量处理几千张图,还是老老实实上 GPU 吧,CUDA 加速后的响应速度才是生产力级别的。

Github 仓库: lukas-blecher/LaTeX-OCR

官方文档: pix2tex.readthedocs.io

Python 教程: https://yunpan.plus/f/26

关注 alphaFind,从因子到策略,陪你走完最后一毫秒。

标签: #LaTeX #OCR #Github #量化工具 #ViT #Python #公式 #数学 |