核心要点

- 评估标准的维度重构:算力评估已从“单片芯片成本”切换至【单位Token产出效率】;系统总吞吐能力是衡量大规模资本投入回报的核心指标。

- 投资回报的财务实效:【资本性支出效率】不取决于设备采购单价,而取决于系统整体利用率;系统级整合通过消除“通信与数据瓶颈”,其带来的产出增益足以抵消高性能网络等核心组件的采购成本。

- 加速计算的竞争准入门槛:【系统级协同设计】已成为行业技术标准,单体组件的性能增益在“全栈生态整合”面前已不具备【技术溢价】。

- Token需求的爆发逻辑:单位成本下降引发了“杰文斯悖论”,较低的Token单价直接驱动了【实时智能代理】的规模化应用,并反向扩张了总算力需求。

- 算力资源的分配优先级:在供应受限周期内,获取硬件的“时间顺序”是关键竞争要素,【技术栈耦合深度】直接决定了前沿AI厂商能否获得最新一代算力的首发配额。

在CES 2026上,NVIDIA首席执行官黄仁勋再次重塑了人工智能工厂的成本收益架构。尽管近期行业内有不少声音认为NVIDIA的护城河正在变薄,但本文的评估结论恰恰相反:NVIDIA进一步巩固了自己作为下一代计算软硬件标准的统治地位。就像Intel和Microsoft在摩尔定律时代构筑的Wintel霸权一样,NVIDIA正成为可预见的未来中全球技术创新的核心引擎。

核心观测点在于:传统计算时代,性能翻倍的周期是两年;而现在,NVIDIA正驱动每年5倍的性能跃迁与10倍的吞吐量增益,并借由杰文斯悖论驱动Token需求实现15倍的爆发式增长。对于生态参与者与客户来说,适应这一新范式已经成为生存的必选项。跟不上这个演进速率的企业,将陷入西西弗斯式的困境:在无止境的追赶中消耗殆尽。

本文基于深度研究,审视NVIDIA如何通过极致协同设计改变“AI工厂”基础设施的投入产出逻辑,并分析这对Intel、AMD及超大规模云服务商带来的战略冲击。

历史的镜像:谁在Intel的制霸时代幸存了下来

回顾20世纪80到90年代,无数RISC架构供应商曾试图在芯片层面挑战Intel。Sun Microsystems等公司的名字现在大多成了计算史的脚注。历史给出的答案非常残酷:在由学习曲线与体量优势驱动的平台市场里,领先地位的本质不仅仅是产品力,更是极致执行所带来的确定性。

Intel曾把摩尔定律转化为一种组织准则,通过每两年翻倍的性价比优势,让竞争对手在追赶路径上疲于奔命。在那一阶段,最终穿越瓶颈的幸存者——AMD、Apple、TSMC及NVIDIA——无一不具备跨市场的规模优势:

- AMD:受益于早期IBM的双供应商策略,通过与x86标准的强制绑定获得了生存空间。

- Apple:通过垂直整合掌握了系统架构的主导权,成功从硬件层面定义了差异化体验。

- TSMC:通过代工模式积聚了超越任何单一垂直厂商的制造规模。

- NVIDIA:得益于早期在游戏与专业视觉市场的深厚积淀,积累了足以支撑自己在HPC领域试错的体量红利。

NVIDIA目前的护城河,正是建立在远超竞争对手的加速计算体量之上。一旦规模效应确立,除非发生地缘政治级别的剧烈扰动,否则后发者几乎无法在同一条学习曲线上完成超越。

极致协同设计:从芯片到系统级架构的重构

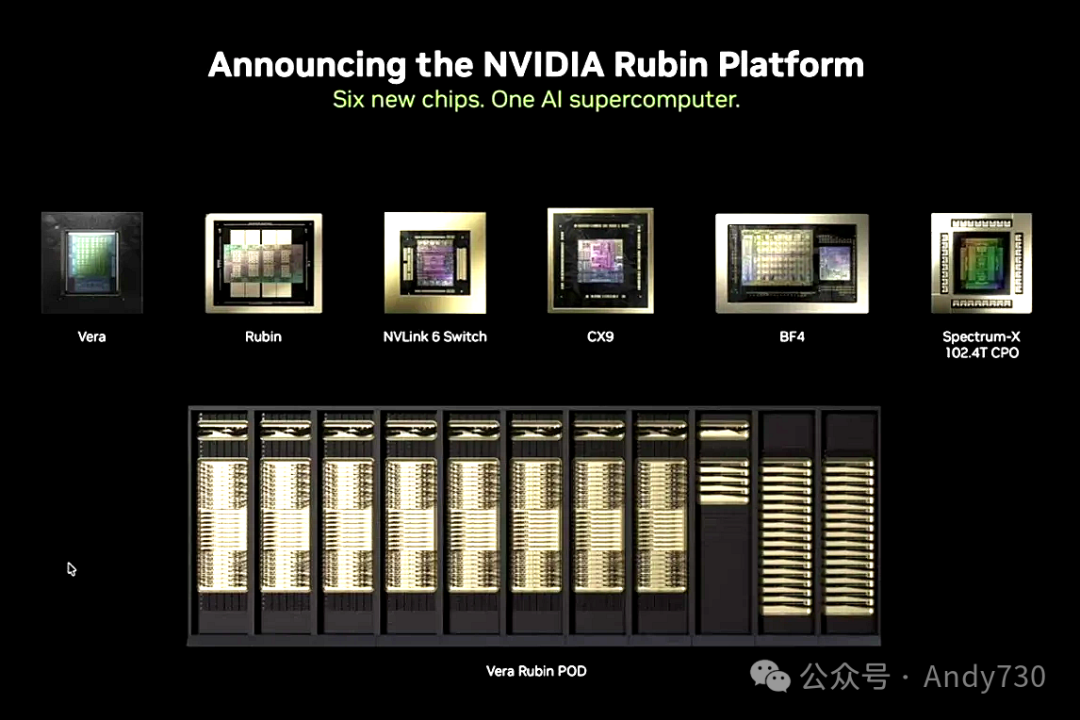

NVIDIA在CES发布了Vera Rubin平台,标志着计算范式从单一芯片向系统级架构的彻底转型。黄仁勋强调的极致协同设计,实质是将CPU(Vera)、GPU(Rubin)以及基于InfiniBand的NVLink、Spectrum-X以太网和BlueField DPU等元素进行端对端的深度整合。

过去几年,市场曾预测以太网的普及会削弱NVIDIA在高性能网络市场的主导地位。然而,NVIDIA通过Spectrum-X展示了自己从不防御、只管加速的竞争策略。目前,NVIDIA已经成为全球收入规模最大的网络公司。

这种协同设计的乘法效应极具破坏力:单一组件可能实现5倍性能提升,但通过优化机架内外的通讯带宽、显存一致性及软件栈,系统级的总吞吐量提升接近一个数量级。NVIDIA交付的不再是芯片,而是高度集成、旨在最大化Token输出效率的“AI工厂”。对于竞争对手来说,他们追赶的目标已不再是单一的制程指标,而是一个由计算、网络、内存与软件深度整合、相互驱动的强大飞轮。

Token成本模型:重新定义资本效率

在“AI工厂”的坐标系里,芯片本身已不再是核心指标,Token的输出效率才是。

Vera Rubin平台的部署逻辑显示:在大规模生产环境下,这个平台仅需Blackwell四分之一的GPU规模就能实现同等的训练吞吐量。这意味着客户的资本性支出将转化为更高的研发迭代频次。

在推理侧,随着工作负载从静态批处理转向交互式、由代理驱动的复杂应用场景,延迟敏感度与Token消耗量同步激增。Vera Rubin平台针对实时交互进行了架构级优化,每月产出的Token数量比Blackwell提升了10倍。

当Token生成效率提升一个数量级,单位成本将大幅骤降。正如杰文斯悖论所说,成本降低将直接解锁全新的应用场景,进而引发总需求的指数级增长。在功率受限的数据中心环境下,利用率每提升10%,带来的收益杠杆效应将直接体现为损益表上数十亿美元的利润增量。在这种逻辑下,NVIDIA的高性能网络设备在商业可行性上几乎是免费的,因为其带来的系统增益远超采购成本。

竞争态势:压力点与战略空白

1. Intel与AMD:结构性压力的分化

- Intel正通过加强互操作性寻找CPU在加速生态中的存在感。虽然Gaudi系列在特定性价比区间有受众,但在顶级算力市场,Intel已经转而寻求成为NVIDIA机架中具备高带宽连通性的组件。

- AMD在x86市场执行力出色,但在AI计算每12个月一迭代的速率下,在中心化数据中心领域缩短差距的难度极大。其战略重心应该加速转向边缘侧,利用在PC和汽车半导体领域的存量优势抵御NVIDIA的渗透。

2. 前沿机构:分配权即竞争力

本文认为顶级AI机构的竞争格局已经形成清晰的梯队。OpenAI凭借先发优势和巨大的用户基数处于核心地位,并与Microsoft深度绑定以确立结构性体量优势。xAI与Grok则凭借对算力的激进投入,在训练效率上紧随其后。

对于这些头部厂商来说,与NVIDIA栈紧密耦合的程度直接决定了其获得最新平台分配的优先级。未能进入NVIDIA第一梯队供应名单的厂商,将在模型演进速率上遭遇“降维打击”。

3. 超大规模云服务商:自研ASIC的边际递减

Google的TPU与AWS的Trainium曾被视为平衡NVIDIA溢价的利器。然而,在模型迭代速度决定生死的当下,自研加速器的开发周期与生态碎片化可能成为放缓创新的负累。战略优先级应该明确:模型迭代速度高于芯片自给自足率。

4. OEM合作伙伴:执行力的博弈

对于Dell、HPE、联想和Supermicro等厂商,目前的竞争焦点在于执行力而非差异化。在算力供给受限的长周期内,谁能更快完成系统级集成、解决高功耗环境下的散热挑战并交付可靠的机架,谁就能在市场中占据先机。

致客户:学习曲线优于数据整理

传统的建议是先清洗数据再部署AI。但基于目前“AI工厂”的成本收益逻辑,本文的策略建议是:立即进入学习曲线。

Token已经成为新的价值单位,通过快速迭代构建AI飞轮,利用AI本身来提升数据质量,而不是在等待数据完美的冗长过程中失去先发优势。历史证明,在平台转型期,商业价值总是向那些能实现规模、持续执行并能将效率提升转化为新需求的玩家聚集。

结语

“AI工厂”是下一代计算时代的商业引擎控制。核心竞争不再是单一技术点的突破,而是系统级学习曲线的复合。赢家将属于那些能够把AI转化为核心运营模型,而不是仅把它当作实验性特征的企业。关于系统级架构设计与技术趋势的更多深入探讨,欢迎在云栈社区进行交流。