在日常的后端开发工作中,处理大规模Excel数据导出是一个常见的需求。但传统的导出方案在面对数万甚至百万行数据时,往往伴随着内存溢出和性能断崖式下跌的痛点。本文将深入探讨如何利用流式处理架构,结合数据库查询优化与异步分片技术,实现真正高性能的Excel导出方案。

传统方案的问题

许多开发者在实现数据导出功能时,习惯使用Apache POI的HSSF或XSSF组件。这类方案在处理超过5万行数据时,性能便会急剧下降。

问题的根源在于其内存对象模型的设计缺陷:每个Cell对象在内存中大约占用1KB,百万级数据会直接导致JVM堆内存耗尽。

以下是一个典型的反面教材代码:

// 典型内存杀手写法

Workbook workbook = new XSSFWorkbook();

Sheet sheet = workbook.createSheet();

for (int i = 0; i < 1000000; i++) {

Row row = sheet.createRow(i); // 每行产生Row对象

row.createCell(0).setCellValue("数据"+i); // 每个Cell独立存储

}

这种写法会生成约100万个Row对象和对应的Cell对象(假设每行1列),内存占用轻松突破GB级别。更致命的是,频繁的Full GC会导致系统响应卡顿,甚至直接引发OOM崩溃。

流式处理架构设计

高性能导出的核心在于实现内存与磁盘的平衡。下面介绍两种经过生产环境验证的成熟方案。

方案一:SXSSFWorkbook

SXSSFWorkbook是Apache POI提供的增强类,它采用了滑动窗口机制。

具体使用示例如下:

// 内存中只保留1000行窗口

SXSSFWorkbook workbook = new SXSSFWorkbook(1000);

Sheet sheet = workbook.createSheet();

for (int i = 0; i < 1000000; i++) {

Row row = sheet.createRow(i);

// 写入后定时刷新到临时文件

if(i % 1000 == 0) {

((SXSSFSheet)sheet).flushRows(1000);

}

}

该方案通过将已处理的数据写入磁盘临时文件,内存中仅保留当前处理批次。实测表明,处理百万数据时内存占用可稳定控制在200MB以内。

方案二:EasyExcel

EasyExcel是阿里巴巴开源的高性能Excel处理框架,其底层采用事件驱动模型和对象复用池技术。

以下是其极简的流式API示例:

// 极简流式API示例

String fileName = "data.xlsx";

EasyExcel.write(fileName, DataModel.class)

.registerWriteHandler(new LongestMatchColumnWidthStyleStrategy())

.sheet("Sheet1")

.doWrite(data -> {

// 分页查询数据

int page = 0;

while (true) {

List<DataModel> list = queryByPage(page, 5000);

if (CollectionUtils.isEmpty(list)) break;

data.write(list);

page++;

}

});

该方案的优势在于自动分批加载数据,并通过反射缓存消除重复的对象创建。实测显示,百万数据导出内存占用可被控制在50MB以下。

数据库查询的黄金法则

即使导出工具本身已经优化,若数据查询环节存在瓶颈,整体性能依然会大打折扣。以下是三个关键的优化点。

3.1 解决深度分页问题

传统的LIMIT offset, size分页查询在偏移量(offset)巨大时,性能会急剧下降:

SELECT * FROM table LIMIT 900000, 1000 -- 越往后越慢!

正确的做法是使用基于游标或自增ID的递进查询:

// 基于自增ID的递进查询

Long lastId = 0L;

int pageSize = 5000;

do {

List<Data> list = jdbcTemplate.query(

"SELECT * FROM table WHERE id > ? ORDER BY id LIMIT ?",

new BeanPropertyRowMapper<>(Data.class),

lastId, pageSize);

if(list.isEmpty()) break;

lastId = list.get(list.size()-1).getId();

// 处理数据...

} while (true);

此方案利用了MySQL等数据库索引的有序性,将时间复杂度从O(N²)降低到O(N),是解决大数据量分页查询的利器。

3.2 减少字段数量

查询时应严格避免SELECT *,只获取必需的字段。

-- 错误写法:全字段查询

SELECT * FROM big_table

-- 正确姿势:仅取必要字段

SELECT id, name, create_time FROM big_table

实测表明,当单行数据从20个字段缩减到5个时,查询耗时可能降低40%,网络传输量减少超过70%。

3.3 连接池参数调优

对于专用的导出服务,建议配置独立的数据库连接池,避免影响主业务。以下是一个SpringBoot的HikariCP配置示例:

# SpringBoot配置示例

spring:

datasource:

hikari:

maximum-pool-size: 20 # 根据CPU核数调整

connection-timeout: 30000

idle-timeout: 600000

max-lifetime: 1800000

一个经验公式是:连接数 ≈ CPU核心数 * 2 + 磁盘数量。

生产级进阶技巧

4.1 异步分片导出

对于超大数据集,可以引入分治策略,将导出任务拆分为多个子任务并行执行。

@Async("exportExecutor")

public CompletableFuture<String> asyncExport(ExportParam param) {

// 1. 计算分片数量

int total = dataService.count(param);

int shardSize = total / 100000;

// 2. 并行处理分片

List<CompletableFuture<Void>> futures = new ArrayList<>();

for (int i = 0; i < shardSize; i++) {

int finalI = i;

futures.add(CompletableFuture.runAsync(() -> {

exportShard(param, finalI * 100000, 100000);

}, forkJoinPool.commonPool()));

}

// 3. 合并文件

CompletableFuture.allOf(futures.toArray(new CompletableFuture[0]))

.thenApply(v -> mergeFiles(shardSize));

return CompletableFuture.completedFuture(taskId);

}

这种异步处理与多线程分片相结合的方式,可以充分利用多核CPU能力,大幅缩短总处理时间。

4.2 配置JVM参数

针对大数据处理场景,合理的JVM参数调优至关重要。

// JVM启动参数示例

-Xmx4g -Xms4g

-XX:+UseG1GC

-XX:MaxGCPauseMillis=200

-XX:ParallelGCThreads=4

-XX:ConcGCThreads=2

-XX:InitiatingHeapOccupancyPercent=35

关键点包括:设置足够堆内存、选用低延迟的G1垃圾回收器,并调整相关阈值。同时,在代码层面应避免创建超过50KB的大对象,并尽量复用DTO实例。

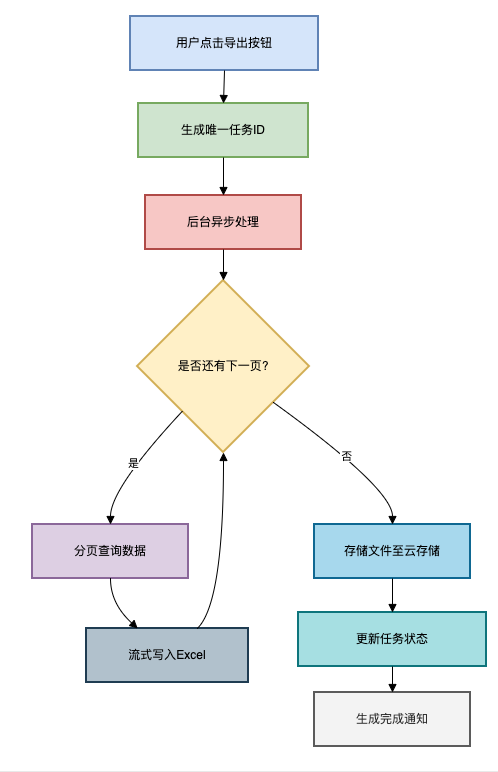

4.3 整体架构方案

一个健壮的生产级导出系统,其整体流程应设计为异步任务模式:

流程简述:

- 用户点击导出,服务端生成唯一任务ID并入库,状态为“处理中”。

- 后台异步线程分页查询数据,并使用流式引擎(如SXSSF或EasyExcel)写入Excel。

- 文件生成后,上传至云存储(如OSS、S3)。

- 更新任务状态为“完成”,并通过WebSocket或站内信通知用户下载。

总结

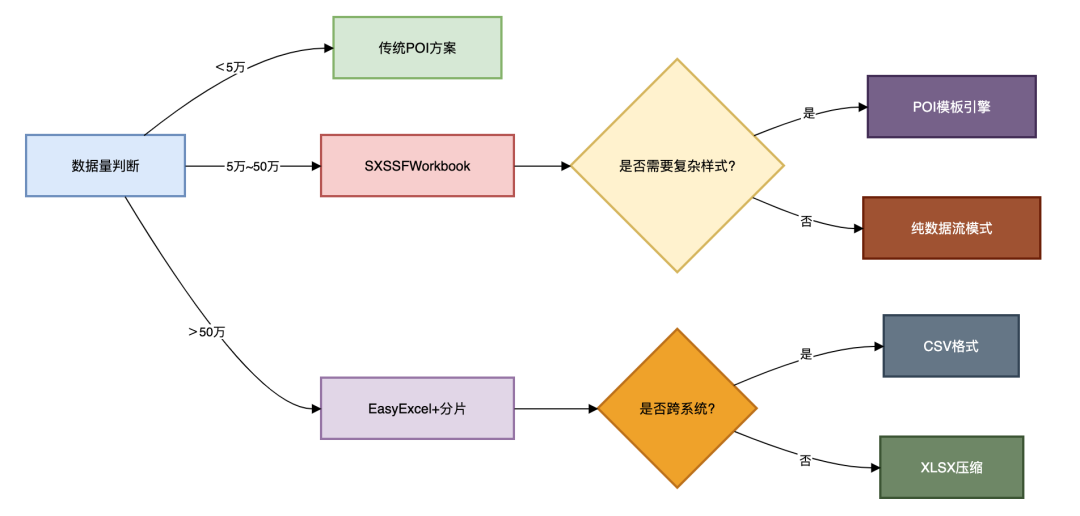

经过多个千万级数据项目的实践,我们可以将Excel高性能导出的核心公式总结为:

高性能 = 流式处理引擎 + 分页查询优化 + 异步资源管控

具体技术选型可参考以下决策树:

最后,分享三个实战忠告:

- 切忌过早优化:在需求和数据量级明确前,不要盲目选择最复杂的方案。

- 监控先行:务必对导出任务的耗时、内存峰值、成功率等关键指标进行埋点监控。

- 准备兜底策略:始终提供CSV格式导出作为保底方案,因为其生成和解析效率通常远高于XLSX。

希望本文提供的方案和思路,能帮助你在实际开发中从容应对大数据导出的挑战,在云栈社区与更多开发者交流实战经验,共同成长。