当企业的应用规模从几个服务扩展到成百上千个微服务时,容器编排工具的角色就发生了根本性转变。它不再是锦上添花的“便利工具”,而是直接关乎系统稳定性、运维效率和平台安全性的核心基础设施。在这样的大背景下,Kubernetes 脱颖而出,成为支撑企业现代化应用的核心平台。

Kubernetes 的职责远不止调度容器。它是一个完整的分布式系统平台,围绕高可用、容错、声明式配置、弹性伸缩和安全边界构建了一整套运行时与控制体系。正因如此,它才能从一个开发者本地的实验环境,无缝扩展到支撑全球业务的大型企业生产系统。

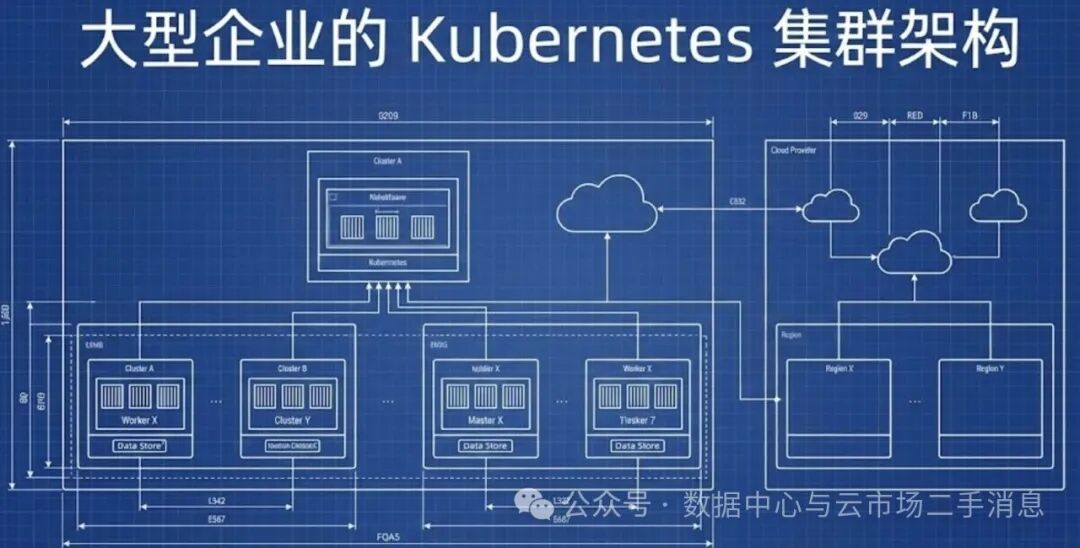

本文将带你从 Kubernetes 的核心概念出发,一步步构建出适用于大型企业生产环境的集群架构视角。我们会兼顾深度与可读性,确保初学者能理解基本逻辑,同时又不失企业级架构所必需的严谨与细节。

什么是 Kubernetes 集群

简单来说,一个 Kubernetes 集群就是一组协同工作的机器(物理机或虚拟机),它们共同协作来运行容器化的应用程序。

从架构视角看,集群被清晰地划分为两个逻辑平面:控制平面和数据平面。

+----------------------+

| Control Plane |

| (集群大脑) |

+----------------------+

|

|

+----------------------+

| Data Plane |

| (工作节点) |

+----------------------+

- 控制平面:它是整个集群的“大脑”,负责做出所有全局性的决策(例如调度、扩缩容)并管理集群状态。它本身不运行业务负载,其核心工作是告诉系统“应该发生什么”。

- 数据平面:由众多工作节点组成,是真正承载并运行应用 Pod 的地方,执行控制平面下达的指令。

Kubernetes 的核心架构组件

控制平面

控制平面是 Kubernetes 的决策中枢,所有对集群的操作和状态变更最终都会汇集于此。

kube-apiserver

kube-apiserver 是整个集群的唯一入口。无论是你手动的 kubectl 命令、持续集成系统,还是各类自动化控制器,所有与集群的交互都必须通过它。

它的核心职责包括:对请求进行认证与授权、校验请求的合法性,并将集群的“期望状态”持久化存储。在企业级部署中,API Server 通常以无状态方式部署多个副本,并置于负载均衡器之后,以实现高可用和横向扩展能力。

用户 / CI / kubectl

|

v

+-------------------+

| kube-apiserver |

+-------------------+

etcd

etcd 是 Kubernetes 的“记忆中枢”,一个强一致性的分布式键值存储数据库。集群的所有配置数据、Pod定义、服务发现信息以及Secret等敏感数据,最终都保存在这里。

企业实践中的关键点在于:etcd 通常运行在专用节点上,节点数量采用奇数(常见为3或5个)以实现高可用和仲裁,并且必须实施严格的定期备份策略。一次 etcd 数据的不可恢复性损坏,几乎等同于整个集群状态的丢失。

+------------------+

| etcd |

| (集群状态) |

+------------------+

kube-scheduler

调度器负责为每一个新创建且处于 Pending 状态的 Pod 挑选一个“最合适”的工作节点。

这个选择过程远不止是检查节点的CPU和内存是否足够。它还会综合考虑一系列复杂因素,例如节点污点与Pod容忍度、Pod之间的亲和与反亲和规则、以及满足区域分布等拓扑约束。

Pod(Pending)

|

v

Scheduler → 最佳节点选择

kube-controller-manager

控制器管理器并不是一个单一功能的组件,它内部运行着众多独立的控制循环。每个控制器都持续不断地对比系统的“期望状态”(记录在etcd中)和“实际状态”,并驱动系统向期望状态收敛。

这正是 Kubernetes 强大自愈能力的核心来源。

工作节点架构

工作节点是承载业务应用的实际载体。

kubelet

kubelet 是驻留在每个工作节点上的代理进程。它持续监听 API Server,获取分配到本节点的 Pod 定义,并确保容器运行时(如 containerd)按照这些定义启动和管理容器。同时,它也将本节点及Pod的运行状态实时上报给控制平面。

容器运行时

容器运行时负责执行底层的容器操作,包括从镜像仓库拉取镜像、创建容器实例以及管理其生命周期。在 Kubernetes 中,kubelet 通过标准的 CRI 接口与 containerd 或 CRI-O 等运行时进行交互,实现了与具体运行时的解耦。

kube-proxy

kube-proxy 负责实现 Service 抽象层的网络流量转发。它维护着节点上的网络规则,当有流量访问 Service 的虚拟IP时,kube-proxy 会将其透明地转发到后端一个健康的 Pod 上,从而屏蔽了 Pod IP 可能频繁变化的具体细节。

Service(VIP)

|

kube-proxy

|

Pod IP

企业级集群架构设计

在大型企业生产环境中,很少会采用“单一巨型集群承载一切”的模式。基于隔离性、容灾能力和团队自治的考虑,多集群部署已成为常态。

一个典型的高可用企业生产架构,其控制平面会跨多个可用区部署,并通过统一的负载均衡器对外提供访问入口。

+--------------------------------------------------+

| Load Balancer |

+--------------------------------------------------+

| | |

+-------------+ +-------------+ +-------------+

| Control | | Control | | Control |

| Plane AZ-1 | | Plane AZ-2 | | Plane AZ-3 |

+-------------+ +-------------+ +-------------+

etcd(跨 AZ 仲裁)

这种设计确保了即使某个完整的可用区发生故障,集群的控制平面依然能够保持可用,从而保障了整个平台的稳定性。

命名空间与隔离

在企业中,命名空间是进行逻辑隔离的首选工具,常用于区分不同团队、不同环境(开发/测试/生产)以及进行成本核算。

apiVersion: v1

kind: Namespace

metadata:

name: finance-prod

命名空间为资源提供了清晰的逻辑边界,它同时也是实施基于角色的访问控制(RBAC)和资源配额限制的基础。

工作负载抽象

Deployment 是最常用的一种工作负载抽象,用于管理无状态应用。它提供了便捷的滚动更新、回滚和副本数量管理能力。

apiVersion: apps/v1

kind: Deployment

metadata:

name: web-app

spec:

replicas: 3

selector:

matchLabels:

app: web

template:

metadata:

labels:

app: web

spec:

containers:

- name: web

image: nginx:1.25

ports:

- containerPort: 80

通过 replicas 字段,Deployment 确保了应用实例的高可用性;selector 定义了如何关联由它管理的 Pod;而 template 部分则详细描绘了 Pod 的创建蓝图。

Service 与稳定网络

由于 Pod 是临时性的、可随时被销毁和重建的,直接依赖其 IP 地址进行通信是完全不可行的。Service 这一抽象正是为了解决服务发现和稳定访问入口的问题而生。

apiVersion: v1

kind: Service

metadata:

name: web-service

spec:

type: ClusterIP

selector:

app: web

ports:

- port: 80

targetPort: 80

Service 为后端的一组 Pod 提供了一个稳定的虚拟 IP 和 DNS 名称,将 Pod 的动态变化完全封装起来,使得客户端无需关心后端的具体实例。

企业级网络与安全

在大型企业环境中,网络的要求不仅仅是“连通即可”。它必须具备精细的隔离能力、灵活的策略控制以及全面的可观测性。这也正是 Calico、Cilium 等高级容器网络接口(CNI)插件在企业中备受青睐的原因。

在安全层面,基于角色的访问控制是实施零信任安全模型的基石。

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

namespace: finance-prod

name: readonly

rules:

- apiGroups: [""]

resources: ["pods"]

verbs: ["get", "list"]

通过遵循最小权限原则,可以有效地将安全事件或误操作的影响范围限制在最小。

资源管理与成本控制

在企业环境中,对计算资源的精细化管理直接关系到应用的稳定性和云资源的成本支出。

resources:

requests:

cpu: "250m"

memory: "256Mi"

limits:

cpu: "500m"

memory: "512Mi"

合理地为容器设置 requests(请求)和 limits(限制)至关重要。这不仅能防止某个异常应用耗尽节点资源从而影响“邻居”,也为后续的集群容量规划、资源调度优化以及精确的成本分摊提供了可靠的数据基础。

可观测性与 GitOps

一个成熟的企业级 Kubernetes 平台,必然会配备完整的可观测性体系。这通常包括指标监控(如 Prometheus)、日志收集(如 EFK/ELK Stack)、分布式链路追踪以及统一的仪表盘可视化。

同时,采用 GitOps 实践来管理集群配置也日益成为主流。其核心思想是将 Git 仓库作为声明式基础设施和应用的唯一事实来源,通过 ArgoCD 或 Flux 等工具自动同步到集群。这种方式天然带来了变更审计、一键回滚和多环境配置一致性等好处,极大地提升了运维效率与安全。

Git 仓库

|

v

ArgoCD / Flux

|

v

Kubernetes 集群

总结

Kubernetes 的设计使其具备从单机扩展到全球级企业平台的能力,但这一切的前提是架构设计本身是经过深思熟虑且有明确原则的。

在大型企业的实践中,我们需要铭记:

- 清晰的架构原则比具体工具的选择更重要。

- 安全性不是可选项,而是必须内置的默认属性。

- 可观测性不是后期补充的功能,而是应用上线的准入门槛。

- 多集群部署不再是特殊案例,而是满足隔离、规模和韧性需求的普遍模式。

透彻理解 Kubernetes 的核心集群架构,是我们掌握其所有高级特性和应对复杂场景的坚实起点。 希望本文能帮助你在构建或优化自己的企业级容器平台时,有一个清晰的技术蓝图。如果你对云原生技术有更多兴趣,欢迎到云栈社区与其他开发者交流探讨。