视频生成模型已经显著推动了具身智能的发展,能够合成感知、推理与行动等多样化的机器人数据。然而,生成能准确反映真实机器人交互的高质量视频仍然颇具挑战。此外,针对机器人视频生成的评测仍处于早期阶段,缺乏一个标准化的评测基准。

现有的评测大多依赖侧重于视觉质量的感知指标。而那些基于物理的评测基准,又往往缺少任务特定的数据集与评测标准。这就导致评测常常忽略了任务完成度、动作‑目标对齐性、物理可行性等关键维度,使评分过于宽松。一个常见的问题是,即使视频中存在非自然的运动或未完成的任务,也能获得高分。评估体系的核心挑战在于,如何严格判断生成的视频是否真实还原了机器人行为。

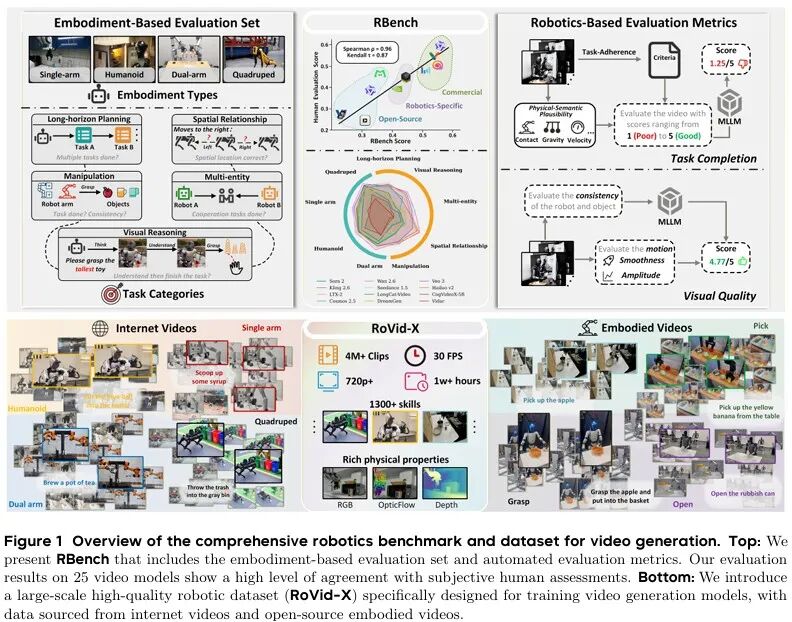

为此,北京大学联合字节跳动的研究团队提出了一个面向机器人的视频生成评测基准 RBench。该基准涵盖了五大任务领域与四种机器人形态,并通过结构一致性、物理合理性、动作完整性等可复现的子指标,系统地评测了任务完成的正确性与视觉保真度。

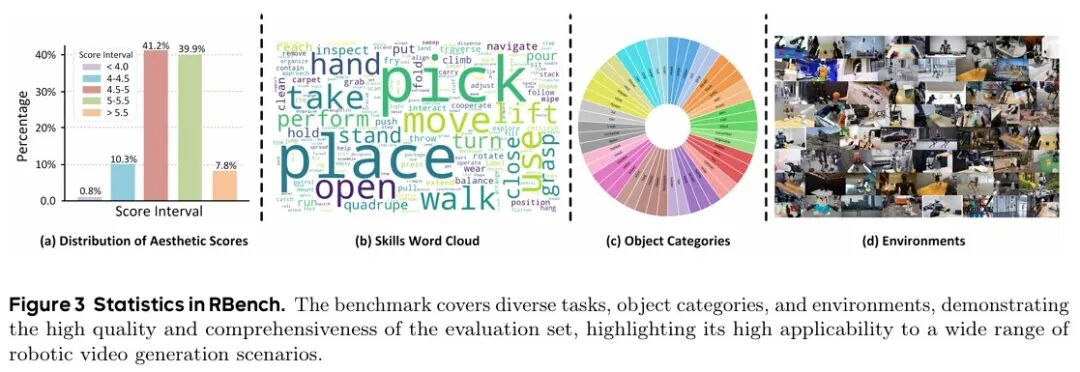

RBench虽然能全面评测机器人视频生成模型,但其背后仍面临高质量训练数据严重短缺的核心问题。基于此,该团队进一步提出了一套四阶段数据构建流程,并由此创建了 目前规模最大的、面向机器人的开源视频生成数据集——RoVid-X。该数据集包含400万条标注视频片段,涵盖数千种任务,并附有丰富的物理属性标注。其代码与数据集均已开源。

RBench评测基准

RBench是一个面向机器人物理场景的评测基准,旨在全面评估视频生成模型在机器人任务中的表现。通过对25个代表性模型的评测显示,当前模型在生成物理真实的机器人行为方面仍存在明显不足。

1. 基准构建

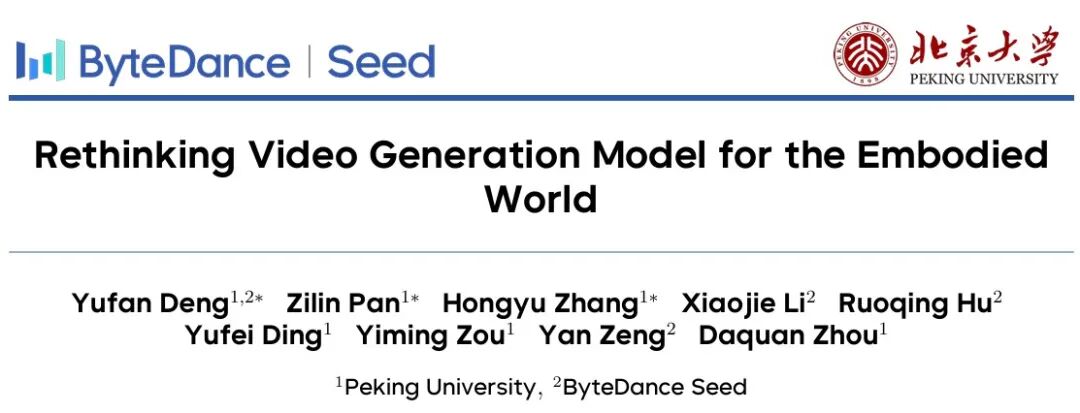

为了全面评估视频生成模型在机器人场景下的能力,研究人员从两个维度设计了多样化的基准:任务类别和智能体形态,共包含650个评测样本,覆盖五大任务领域和四类机器人形态。

- 任务导向类别包括五个代表性任务:常规操作、长程规划、多智能体协作、空间关系和视觉推理,总共包含250个图文对,每个任务50个样本。

- 形态导向类别涵盖四种主流机器人形态:双臂机器人、人形机器人、单机械臂和四足机器人,总共包含400个图文对,每个形态100个样本。

2. 自动评估指标

现有的视频生成评估方案,缺乏针对机器人场景定制的任务特定标准。为此,该团队将Qwen3-VL和GPT-5作为MLLM评估模型,提出了一套自动评估指标。

该方法从视觉质量和任务完成度两方面评估生成的机器人视频。在任务完成度方面,包括了物理-语义合理性和任务遵循一致性两个精细化子指标;在视觉质量方面,包括了运动幅度、机器人-主体稳定性和运动平滑度三个精细化子指标。

RoVid-X 数据集

1. 数据集构建

数据处理工作流程包含四个不同的阶段,每个阶段都旨在确保所收集数据的质量、多样性与相关性。具体阶段如下:

1.机器人视频收集。从大规模互联网视频平台及20多个开源具身视频数据集中收集原始的机器人视频。这些数据集涵盖了多种机器人类型和任务场景,确保了数据的广度与多样性。使用GPT-5模型对每个视频的内容进行自动筛选,剔除与研究目标不符的低质量或无关视频片段。

2. 视频质量过滤。在此阶段,对收集的视频执行严格的过滤程序,以去除低质量及与研究目标不符的视频片段。

3. 任务分割与描述生成。在此阶段,利用一个视频理解模型和一个特别设计的提示词模板,自动分析视频中的机器人动作。

4. 物理属性标注。为确保机器人动作在物理空间中的一致性和真实感,对视频进行物理属性增强。

2. 数据集分析

RoVid-X是首个专为训练视频生成模型而设计的开源大规模机器人视频数据集,包含400万个机器人视频片段。该数据集旨在应对视频生成模型在生成机器人视频时面临的物理挑战,为训练和评估提供高质量数据。

RoVid-X数据集涵盖了多样化的机器人动作、任务和机器人类型,确保了其在不同机器人领域的适用性。通过整合来自各类机器人和场景的视频,全面覆盖了机器人训练所需的物理属性和任务要求。

实验

1. 基于RBench的模型评测

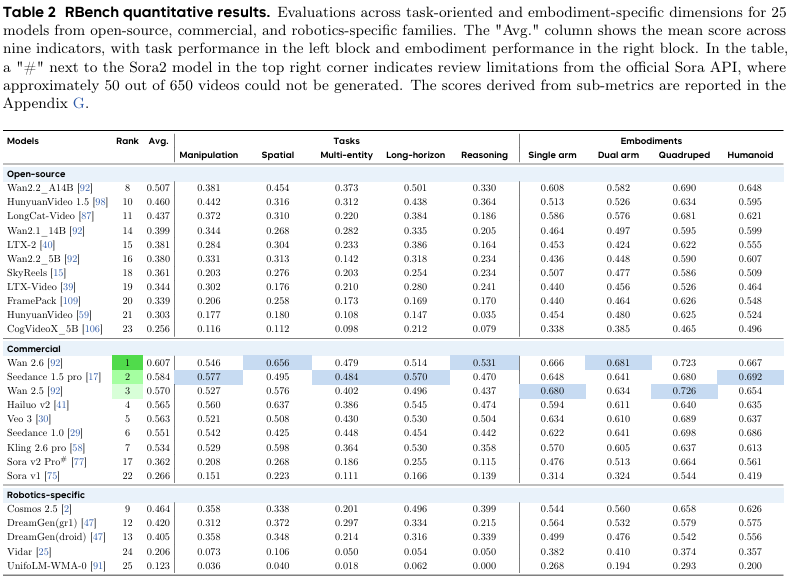

本次实验对闭源模型、开源模型以及专为机器人任务设计的模型这三类模型进行了评测,共计25种前沿视频生成模型。评测范围覆盖多种具身形态与任务类型,以全面反映模型的综合能力。

评测结果如上表所示,展示了跨模型架构、任务类型和具身形态的量化评估结果。实验结果表明:

- 顶尖商业闭源模型(如Wan 2.6、Seedance 1.5 Pro)已初步展现出世界模型的特性。这标志着模型需要理解并仿真出具有复杂交互的真实物理场景,而不仅仅是生成视觉精美的视频。

- 模型的推理能力随着版本迭代而不断增强。以Wan系列为例,从2.1版本(排名第14,得分0.399)到2.6版本(排名第1,得分0.607)实现了跨越式提升。

- 商业闭源模型的仿真能力存在差异。例如Sora系列模型在本次测评中表现欠佳(Sora v2 Pro排名第17,均分0.362),这说明这类模型的通用视频生成能力不能直接迁移到具身任务中,突显了真实、针对性训练数据的重要性。

- 闭源模型的性能整体领先,包揽了测评前7名,相对于开源模型形成了明显的优势。

2. RoVid-X 数据集效度验证

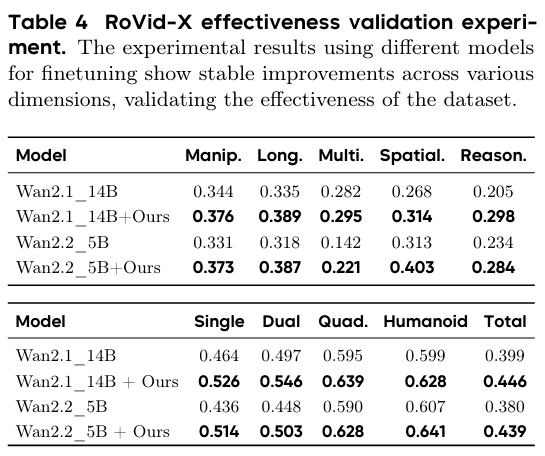

为验证RoVid-X数据集的有效性,研究选用Wan2.1 14B与Wan2.2 5B作为基础模型,使用纯MSE损失函数进行微调。受算力限制,从原始数据集中随机抽取20万样本进行训练。

实验结果如下表所示,在RoVid-X数据集上训练后,模型在五大任务领域与四种具身形态上的性能均获得了显著提升,证明了该数据集质量与数据构建流程的有效性。

总结

本论文提出了一个全面的机器人视频生成评测基准 RBench,旨在填补机器人视频生成模型评测的空白。它通过650个评测样本,全面评估了视频基础模型在五类机器人任务和四种机器人类型上的表现。同时,团队构建了目前规模最大的开源机器人视频生成数据集 RoVid-X,包含400万条标注视频片段,为具身视频模型的训练和评估提供了必要的支持。

想要与技术同行交流此类前沿AI与机器人技术?欢迎来云栈社区的讨论板块分享你的见解。