今天在油管看了个关于MCP的教程,总算是入门了。写这篇东西,主要是记录一下自己的理解,看看是不是真搞懂了点东西。

首先,什么是MCP?它的英文全称是 Model Context Protocol,翻译过来叫模型上下文协议。这东西是由推出最近火得一塌糊涂的 Claude Code 的公司——Anthropic,在2024年发布的。说到这公司,有个趣闻是它的老板之前在中国打工,东家是百度。不知道是不是因为这段经历让他感受“深刻”,导致现在他们家的产品对我们国内用户相当不友好。

那么,他们推出MCP的背景是什么?我们为什么需要它?又为什么它一出来就这么受欢迎?

这还得从AI应用的发展历程说起。自打 OpenAI 推出 ChatGPT 之后,我们都能用上AI工具了,国内外大模型也层出不穷。最开始,我们只是在网页对话框里和AI聊天,它能回答我们各种问题。但一个明显的问题随之而来:它不能帮我们做事。比如,它不能替我们用浏览器查资料,也不能查询实时天气。换句话说,早期的模型缺乏使用外部工具的能力。

MCP的出现,就等于给大模型装上了“手”和“脚”,让它拥有了调用各种外部工具的能力。这就好比你的电脑装了一个超强的操作系统,但没有办公软件,你还是没办法用它写文档、做表格。

其实这个过程是阶梯式的,反映了我们如何一步步思考并学习用好大模型。想想看,最开始我们只会跟AI在窗口里聊天、提问、等答案。很快我们就意识到,要想得到想要的答案,得学会提问。AI的普及,让我们真正理解到:提出一个好问题,有时比回答一个问题更难,也更重要。会提问的人是有深度思考的,而回答问题可能只需要知识检索。

那时候流行一个词叫 prompt,也就是提示词。意思是我们要给AI准确的指令,才能用好它。不同人的使用水平天差地别。当高手们开始思考如何让AI解决实际工作中的具体问题时,MCP的诞生就成了必然。事实上,就算没有MCP,也会有另一个功能类似的工具出现,因为人们对高效利用人工智能的追求是不断向前的。

所以,你现在可以这样理解:MCP是帮助我们利用AI解决实际问题的一个桥梁。我们已经不再满足于仅仅在对话框里得到答案,然后自己手动去完成任务。我们现在希望的是:AI既能给出方案,更能直接帮我们把事办了。

举个例子:以前我们问AI“明天广东天气怎么样?”,它会告诉你去哪个网站查天气,然后你得自己打开浏览器去搜索。现在有了MCP,我们再问同样的问题,AI就能通过对接外部数据源的MCP,直接获取数据,然后告诉你结果。

但是,当大模型要和MCP结合使用时,我们就不能继续用原来的网页聊天窗口了。我们需要一个新的入口来“启动”这个增强版的大模型,就好比普通用户在A窗口办事,而VIP用户请移步到功能更全的B窗口。

这个新的入口,就叫做 MCP Host。不同公司会推出自己的MCP Host,目前比较常见的有 Claude Desktop、Cursor、Cline 和 Cherry Studio。我这里以 Cline 为例,它是由 VS Code 团队推出的。

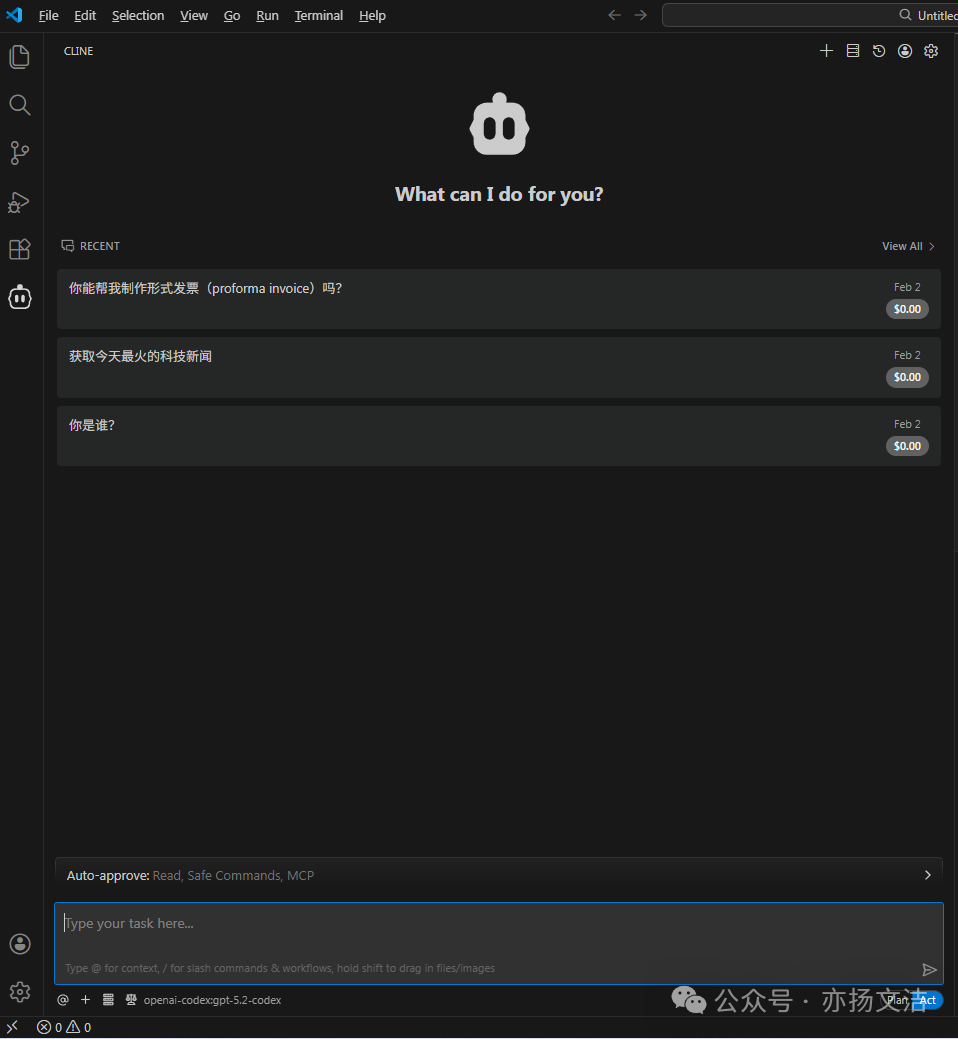

所以,第一步是在 VS Code 里安装 Cline 插件。安装好后,我们还需要把大模型“对接”进来。以前我们用哪家的大模型,就得去哪家的网页端。现在有了 Cline 这个统一入口,想用哪个模型,直接通过 API 对接就行。

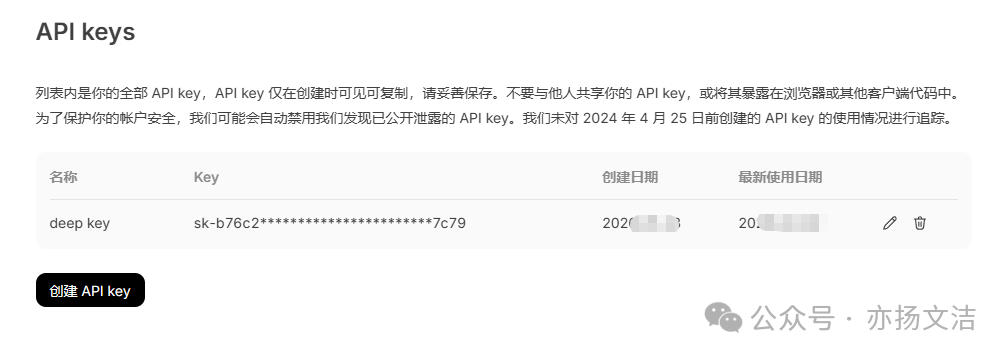

如果我们想用 DeepSeek 的模型,就需要去他们的官网平台申请创建一个 API Key。这串字符就是密钥,相当于通行证。申请成功只代表路通了,但你还没“充值”,用不了。你需要给 DeepSeek 充点值,10块、20块都行,用多少扣多少。用谁家的模型,就给谁家付钱,这很合理。

对接好之后就可以使用了。具体的对接步骤这里不展开,否则篇幅太长了。至此,我们就能正常使用 Cline 了。请注意,我们只是换了一个使用大模型的“前端入口”(Cline),背后调用的模型(比如 DeepSeek 或 ChatGPT)本质上和以前在各自官网使用是一样的。

之所以要换这个入口,就是为了能调用 MCP,让大模型能办更多具体的事,而不是只当个“问答机”。当然,你仍然可以通过 Cline 问大模型简单的问题,比如让它制定一个减肥计划。

但我们用 Cline 的核心目的,是通过 MCP 让大模型解决更具体的任务,所以问简单问题就有点“杀鸡用牛刀”了。

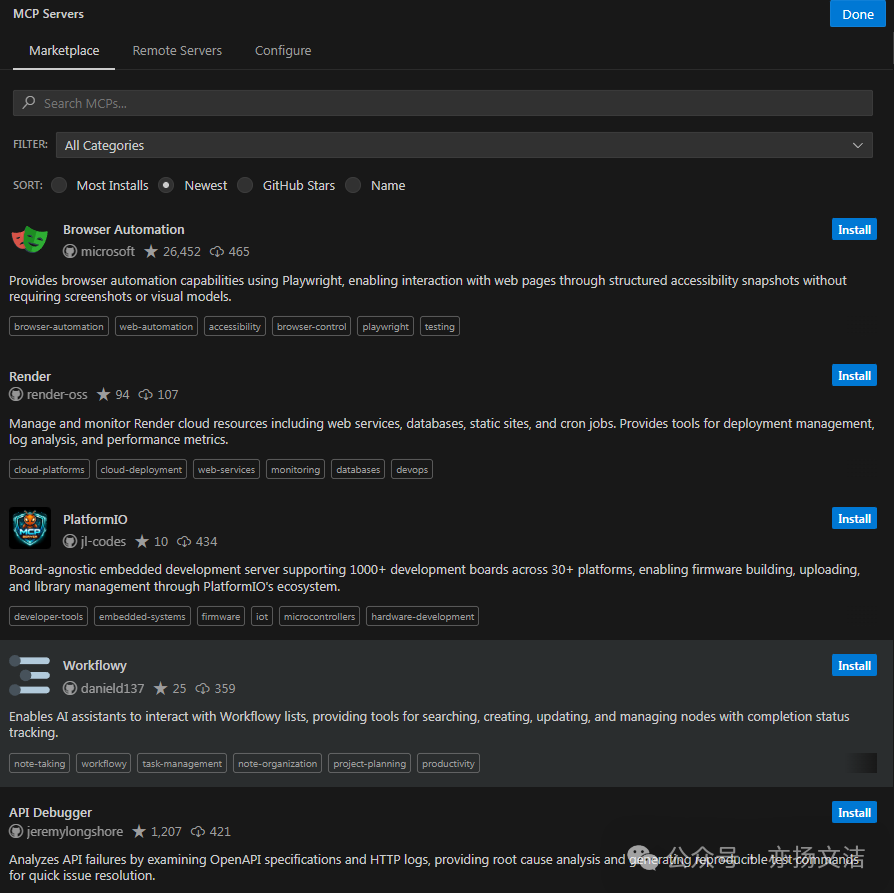

那么,关键来了:怎么用 MCP 来解决问题?简单说,你想解决什么问题,就安装对应的那个 MCP Server。比如你想获取实时天气,就需要安装一个专门获取天气数据的 MCP Server。这里说的“安装”,本质上就是配置一个函数或一段代码。

现在有很多平台提供了各式各样的 MCP Servers,基本是免费的,就像给你的手机安装不同的 App。Cline 自己也内置了一个“应用市场”,推荐了很多 MCP Servers,找到合适的点击安装就行。

当你安装了“获取实时天气”的 MCP Server 后,你再问大模型天气问题,它就知道你有一个专门的“工具”(Server)能解答这个问题。大模型会去调用这个工具,拿到数据后再整理好答案告诉你。这在以前,大模型自己是无法做到的。

同理,如果你安装了“获取实时热点新闻”的 MCP Server,你就可以直接让大模型告诉你当前有什么热点新闻。这就是 MCP 的基本概念和用法。它本质上拓展了大模型的能力边界,让AI从“顾问”变成了能动手的“执行者”。想要深入了解协议细节和开发资源,可以参考其官方文档。整个生态,无论是模型、Host还是Server,都在推动着智能与数据应用的深度融合。希望这篇记录对同在摸索的你有所帮助,也欢迎到云栈社区一起交流更多AI应用的实战心得。