LangGraph 的一个核心设计理念是:多智能体工作流本质上是图结构,而非简单的线性链。早期基于 LLM 的应用普遍采用“提示 → LLM → 响应”的线性模式,但这种架构难以应对真实智能体系统的复杂性。比如,生产环境中的多智能体协作往往需要分支(基于数据选择不同执行路径)、循环(支持重试与迭代优化)、汇合(多个智能体向共享状态写入数据),以及条件路由(根据执行结果动态决定后续流程)。

LangGraph 如何表示工作流

在 LangGraph 中,每个工作流都是一个 StateGraph——本质上是一个有向图。其中,节点代表智能体,或者说处理状态的函数;边定义了智能体之间的转换逻辑;而状态则是在整个图中流动的共享数据结构。

from langgraph.graph import StateGraph, END

from typing import TypedDict

# Define your state schema

class IncidentState(TypedDict):

incident_id: str

current_metrics: dict

proposed_solution: dict

issue_resolved: bool

retry_count: int

# Create the graph

workflow = StateGraph(IncidentState)

# Add agent nodes

workflow.add_node("diagnose", diagnose_agent)

workflow.add_node("plan_fix", planning_agent)

workflow.add_node("execute_fix", worker_agent)

workflow.add_node("verify", verification_agent)

# Define transitions

workflow.add_edge("diagnose", "plan_fix")

workflow.add_edge("plan_fix", "execute_fix")

workflow.add_edge("execute_fix", "verify")

# Conditional: retry or exit

workflow.add_conditional_edges(

"verify",

lambda state: "resolved" if state["issue_resolved"] else "retry",

{

"resolved": END,

"retry": "diagnose" # Loop back

}

)

workflow.set_entry_point("diagnose")

这样做的好处非常明显:图本身就可以当作直观的开发文档,让人一眼看懂流程;增加或减少节点时无需改动复杂的协调逻辑;状态有明确的类型约束;循环也有内置的终止条件,避免了死循环。

节点、边、状态三者职责清晰。节点封装具体的逻辑操作,只管执行任务;边定义节点间如何交互、谁先谁后;状态则承载共享上下文,使节点可以保持无状态。这种职责分离让系统更易理解、调试和扩展,节点还能在不同的工作流中复用。

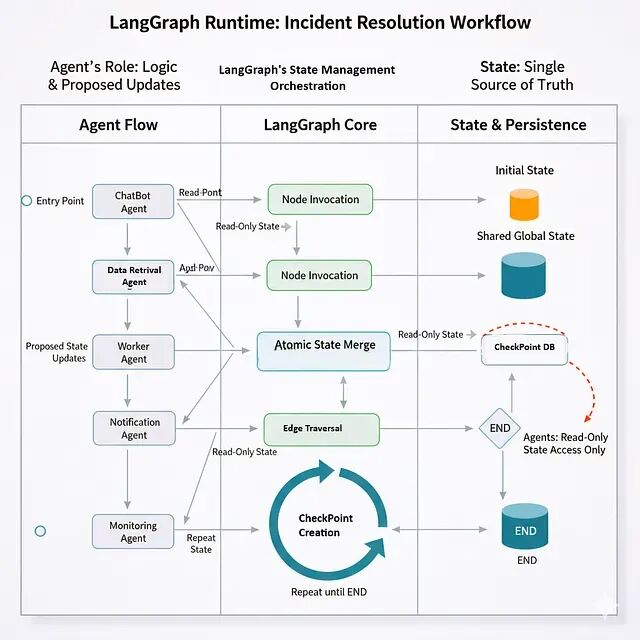

运行时到底发生了什么

图定义是声明式的,但真正让智能体编排变得强大且可靠的是其运行时行为。

工作流启动后,LangGraph 使用状态机来管理执行。首先从入口节点的初始状态开始,然后调用对应的智能体函数并传入当前状态(只读副本)。智能体返回的是对状态的增量更新,而非整个状态的替换。LangGraph 拿到这些更新后,会原子性地将其合并到当前状态,接着根据图定义决定下一个要执行的节点,同时创建一个“检查点”,把当前状态和执行位置持久化下来。这个过程循环往复,直到走到 END 节点或达到最大迭代次数。

有一点非常关键:智能体永远无法直接修改共享状态。它们拿到的是状态的只读快照,计算完成后返回希望进行的更新,实际的状态修改由 LangGraph 的运行时统一、原子地完成,这从根本上保证了状态的一致性和操作的原子性。

边遍历机制

边定义了图中允许的转换路径,但具体在何时进行转换则由运行时动态决定。

静态边非常简单直接:

workflow.add_edge("diagnose", "plan_fix")

diagnose 节点执行完毕并创建检查点之后,LangGraph 会立刻用更新后的状态去调用 plan_fix 节点。

条件边则提供了极大的灵活性:

workflow.add_conditional_edges(

"verify",

route_function,

{"retry": "diagnose", "resolved": END}

)

verify 节点完成后,LangGraph 会调用 route_function(state) 函数,根据当前状态来判断下一步走哪条边。如果函数返回 “retry”,工作流就循环回 diagnose;如果返回 “resolved”,则直接结束。

此外,任何节点在执行前,其所有前置节点都必须已完成并创建了检查点。这就有效避免了在 Pub/Sub 等异步系统中常见的“前面节点还没跑完,后面节点就提前开始”的竞态问题。

状态管理的特殊之处

LangGraph 的状态管理与传统分布式系统有显著不同。

它不是存放在 Redis 或数据库中让智能体直接读写的一块共享内存。LangGraph 在内部统一维护状态,仅向智能体提供受控的访问。对智能体而言,状态是不可变的——它们拿到的是某个时刻的快照,不能直接修改,只能通过返回“更新字典”来申明想要的变更。

当多个智能体通过并行边同时运行时,LangGraph 会收集所有智能体返回的更新,然后使用预定义的 reducer 函数,原子性地将这些更新合并应用到状态上。这巧妙地解决了“读-修改-写”场景下的竞态条件问题。

每个检查点还会创建一个独立的状态版本。如果你想查看执行历史中任意时刻的状态是怎样的?直接查询对应的检查点即可。这实现了所谓的“时间旅行调试”。

检查点持久化

检查点不仅仅是日志,它们是可靠的工作流恢复点。

每个检查点都记录了完整的状态快照、当前在图中的位置(刚执行完哪个节点),以及相关的元数据(如时间戳、创建检查点的节点、执行路径等)。

检查点的创建时机主要有三个:每个节点成功完成后、条件边被评估前,以及工作流被主动暂停时(例如等待人工审批)。

这种机制带来了巨大优势:如果某个节点执行到一半崩溃了,可以从最后一个检查点轻松重试,无需从头开始;长时间运行的工作流可以暂停后再恢复,进度毫厘不差;调试时,你可以从任意一个检查点开始重新运行(replay)工作流。

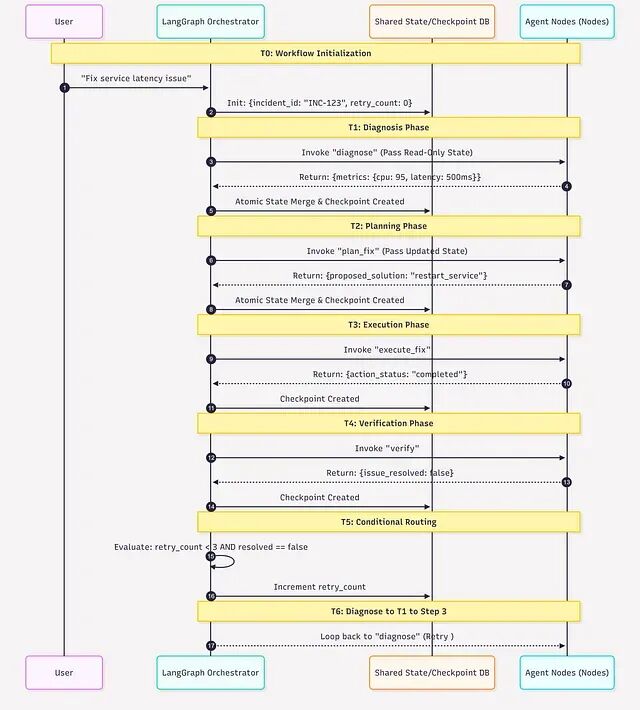

一个完整的运行时示例

假设用户发起了请求:“修复服务延迟问题”。

T0: Workflow starts

- Initial state: {incident_id: “INC-123“, retry_count: 0}

- Entry point: “diagnose“

T1: “diagnose” node executes

- Receives: {incident_id: “INC-123“, retry_count: 0}

- Agent calls Data Agent, fetches metrics

- Returns: {current_metrics: {cpu: 95, latency: 500ms}}

- LangGraph merges: state now has metrics

- Checkpoint created

T2: Static edge triggers: “diagnose” → “plan_fix“

- “plan_fix” node executes

- Receives merged state (incident_id + retry_count + current_metrics)

- Agent calls Knowledge Agent for runbook

- Returns: {proposed_solution: “restart_service“}

- LangGraph merges

- Checkpoint created

T3: Static edge triggers: “plan_fix” → “execute_fix“

- “execute_fix” node executes

- Calls Worker Agent

- Returns: {action_status: “completed“}

- Checkpoint created

T4: Static edge triggers: “execute_fix” → “verify“

- “verify” node executes

- Calls Data Agent again

- Returns: {current_metrics: {cpu: 90, latency: 480ms}, issue_resolved: false}

- Checkpoint created

T5: Conditional edge evaluation

- LangGraph calls route function with current state

- route_function checks: state[“issue_resolved”] == false and retry_count < 3

- Returns: “retry“

- LangGraph increments retry_count

- Routes back to “diagnose” (cycle)

T6: “diagnose” executes again (retry #1)

- Process repeats with updated state...

可以看到,状态在节点间不断累积——监控指标、修复方案、操作结果都包含在内。每个节点都能看到之前所有节点产出的完整上下文信息。重试逻辑是由图结构强制定义的,而不是硬编码在每个智能体的业务逻辑里。任何故障发生后,检查点机制都能确保程序从断点精确恢复。

使用 LangGraph,智能体开发者只需关心如何根据输入返回正确的状态更新。复杂的协调逻辑、状态合并、条件路由和持久化,全部由运行时统一接管。

关键架构模式

传统的多智能体系统倾向于累积对话历史:

# Common pattern - append-only log

messages = [

{“role“: “user“, “content“: “Service X is slow“},

{“role“: “data“, “content“: “CPU at 95%“},

{“role“: “knowledge“, “content“: “Try restarting“},

{“role“: “action“, “content“: “Restarted service“},

...

]

这个历史记录会无限增长,智能体每次都需要在这段冗长的历史中翻找有用的数据,效率低下且上下文管理复杂。

LangGraph 采用了不同的思路:状态就是当前世界的精简快照:

class State(TypedDict):

# Current values, not history

incident_id: str

current_cpu: float

recommended_action: str

action_status: str

retry_count: int

智能体读取当前值、更新当前值。完整的历史通过独立的检查点机制维护,主要用于调试和审计,而工作流运行时使用的状态始终保持精简。这带来了多个好处:访问状态是 O(1) 复杂度,无需解析冗长历史;数据所有权清晰,一眼就能看出哪个状态字段由哪个节点负责更新;推理也变得更简单,因为“当前状态”就是事实的唯一来源。

Reducer 解决并行协调难题

当多个智能体需要向同一个状态字段写入数据时怎么办?LangGraph 提供了 reducer——专门用于合并并发更新的函数。

在传统的多智能体协作模型中,智能体需要自己实现复杂的协调逻辑:抢锁、读-修改-写、重试、冲突检测。这套逻辑各团队实现不一,一旦出现部分故障,整个协调过程就容易出错。Reducer 将冲突解决机制上移到编排层,智能体层面完全无需关心协调问题。

例如,下面这个例子中,三个监控智能体并行检查不同的服务副本:

from typing import Annotated

from operator import add

class State(TypedDict):

# Reducer: combine all health check results

health_checks: Annotated[list, add]

三个 Data Agent 各自返回健康检查结果,reducer(这里就是列表的 add 操作,即 extend)会自动把三份结果合并成一个列表。没有任何一个智能体需要知道其他智能体的存在,它们不用抢锁,也无需协调彼此的更新。

如果没有 reducer,开发者就需要手动实现加锁机制来防止数据被覆盖、编写逻辑来合并多个结果,还要担心更新丢失。有了 reducer,所有这些并发协调的难题都在编排层被自动、统一地处理了。

检查点用于调试和恢复

每次节点执行后创建的检查点,其状态快照和执行位置信息会被持久化到后端存储(如 Postgres、Redis 或文件系统)。

当生产环境出现意料之外的结果时,你可以检查各个检查点的内容,精确查看每个智能体当时观察到了什么数据、基于此做出了什么决策。这相当于为整个多智能体系统的工作流安装了一个“黑匣子”,所有的决策链条都清晰可查。

如果运行工作流的服务器中途崩溃,工作流可以从最后一个检查点无损恢复,无需重头开始。对于那些需要调用昂贵 API 或收集大量数据的长时间任务而言,这一特性至关重要。

更重要的是,工作流可以被主动暂停数小时甚至数天。状态通过检查点得以保持,未来可以从暂停的地方精确恢复,所有上下文信息都完整保留。

修改工作流的灵活性

LangGraph 的另一个突出优势是工作流易于修改和演进。

假设初始的工作流是 Diagnose → Fix → Verify。现在产品经理提出新需求:“在制定修复方案之前,先查一下 Jira 系统里有没有相关的已知问题记录”。

代码改动非常小,且高度局部化:

# Add the new agent

workflow.add_node(“check_jira“, jira_agent)

# Rewire the flow

workflow.add_edge(“diagnose“, “check_jira“) # New path

workflow.add_conditional_edges(

“check_jira“,

lambda state: “known_issue“ if state[“jira_ticket“] else “unknown“,

{

“known_issue“: “apply_known_fix“, # New path

“unknown“: “plan_fix“ # Original path

}

)

单个智能体的实现逻辑完全不用动,底层的状态协调、检查点处理、错误恢复等机制也统统不用动。整个业务逻辑的变更清晰地体现在图结构的变化上。

如果换成基于 Pub/Sub 的事件驱动架构来实现同样的需求变更呢?你需要修改事件的路由逻辑、完成状态跟踪逻辑(因为现在参与的是4个智能体而非3个)、可能还要调整状态合并的协调逻辑,所有集成点都需要重新测试。

再看重试逻辑的修改。原来是最多重试3次:

# Before

workflow.add_conditional_edges(

“verify“,

lambda state: “retry“ if state[“retry_count“] < 3 else “end“,

{“retry“: “diagnose“, “end“: END}

)

现在来了新需求:“只有临时性错误(如网络抖动)才重试,永久性错误(如配置错误)则不重试,直接升级处理”。你只需要修改条件判断函数本身即可:

# After - just change the condition function

def should_retry(state):

if state[“issue_resolved“]:

return “success“

if state[“error_type“] == “config“:

return “escalate“ # Don't retry config errors

if state[“retry_count“] >= 3:

return “max_retries“

return “retry“

workflow.add_conditional_edges(

“verify“,

should_retry,

{

“success“: END,

“retry“: “diagnose“,

“escalate“: “human_review“,

“max_retries“: “alert_team“

}

)

业务逻辑在工作流的结构中一目了然,修改起来也极其顺手,不会影响到无关的部分。

LangGraph 支持的典型模式

迭代优化:当生成的方案质量不达标时,可以很方便地加入循环进行迭代优化。

workflow.add_node(“generate_solution“, llm_agent)

workflow.add_node(“validate_solution“, validation_agent)

workflow.add_node(“refine_solution“, refinement_agent)

workflow.add_conditional_edges(

“validate_solution“,

lambda state: “valid“ if state[“solution_quality“] > 0.8 else “refine“,

{

“valid“: “execute_fix“,

“refine“: “refine_solution“

}

)

workflow.add_edge(“refine_solution“, “generate_solution“) # Loop back

方案会在“生成-验证-精炼”这个循环中不断迭代,直到其质量分数超过设定的阈值(例如0.8)。

并行信息收集:当需要同时从多个数据源拉取信息时,可以利用并行边。

from langgraph.graph import START

# Parallel nodes

workflow.add_node(“fetch_metrics“, data_agent)

workflow.add_node(“fetch_logs“, elasticsearch_agent)

workflow.add_node(“fetch_config“, knowledge_agent)

# All start in parallel

workflow.add_edge(START, “fetch_metrics“)

workflow.add_edge(START, “fetch_logs“)

workflow.add_edge(START, “fetch_config“)

# All must complete before analysis

workflow.add_node(“analyze“, analysis_agent)

workflow.add_edge(“fetch_metrics“, “analyze“)

workflow.add_edge(“fetch_logs“, “analyze“)

workflow.add_edge(“fetch_config“, “analyze“)

LangGraph 保证 analyze 分析节点会在三个数据源节点都执行完毕后才开始运行,自动处理了并行任务的同步问题。

人工审批门控:对于高风险操作,可以轻松嵌入人工确认环节。

workflow.add_node(“propose_fix“, planning_agent)

workflow.add_node(“await_approval“, approval_gate)

workflow.add_node(“execute_fix“, action_agent)

workflow.add_edge(“propose_fix“, “await_approval“)

# Workflow pauses at await_approval

# State is persisted

# When human approves, workflow resumes

workflow.add_conditional_edges(

“await_approval“,

lambda state: “approved“ if state[“human_approved“] else “rejected“,

{

“approved“: “execute_fix“,

“rejected“: “propose_alternative“

}

)

这个等待人工确认的过程可以持续几小时甚至几天,期间不占用任何计算资源,状态通过检查点完好保存。

什么场景适合 LangGraph

- 适合场景:智能体数量较多(例如5个以上)、流程中包含条件逻辑或循环、业务逻辑需要频繁调整、事后需要对执行过程进行调试和分析、流程中包含人工审批或质量门控、以及长时间运行的任务需要可靠的崩溃恢复机制。在这些场景下,LangGraph 提供的结构化编排、状态管理和持久化能力价值巨大。

- 可能不适合的场景:非常简单的线性流程(A → B → C,没有分支)、智能体之间完全独立无需任何协调、对延迟极端敏感(要求编排开销必须控制在10毫秒以内)、或者团队本身已具备深厚的分布式系统功底,希望完全自主实现状态机和协调逻辑。

总结

编排框架在复杂系统中的价值早已被反复验证:Kubernetes 之于容器编排、Airflow 之于数据管道、Temporal 之于通用工作流。LangGraph 将同样的理念带入多智能体 AI 领域,提供了 LLM 感知的、生产就绪的编排能力。

其核心价值在于:图结构让复杂的工作流变得直观、易于修改和扩展;检查点机制为系统带来了可审计性、可调试性和强大的故障恢复能力;reducer 和原子状态更新等抽象,巧妙地解决了并行智能体协作中的协调难题。这使得开发者可以将精力专注于智能体本身的业务逻辑创新,而非底层协调管道的实现细节。

对于正在从实验原型迈向生产系统的多智能体系统开发团队而言,LangGraph 提供了一条经过验证的、可行的工程化路径。如果你想了解更多关于AI与智能体开发的前沿实践,欢迎访问云栈社区与其他开发者交流探讨。