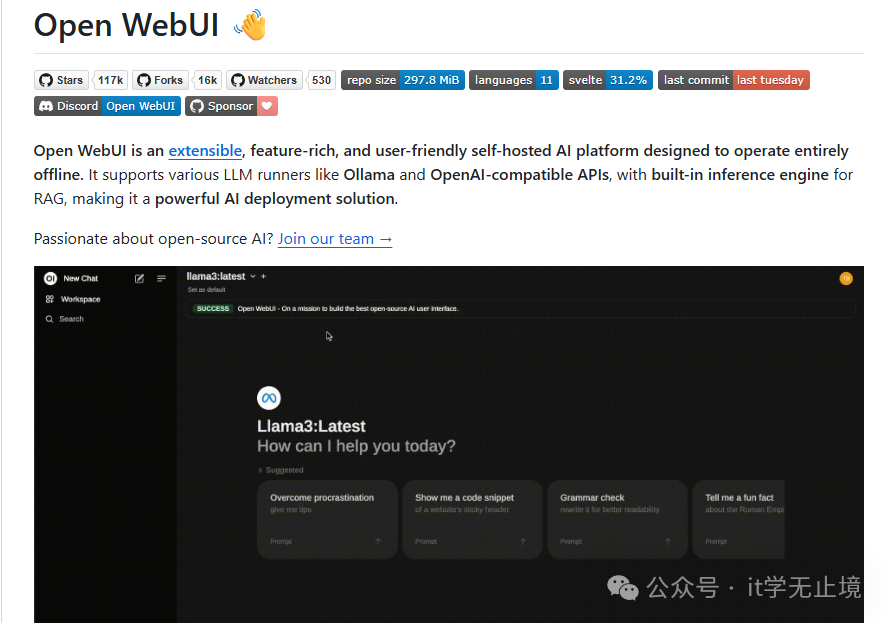

在探索AI应用时,我们常常需要一款能够集中管理多种大语言模型的工具。它最好能支持本地化部署以保障数据隐私,同时拥有友好的界面和全面的功能。OpenWebUI(原名Ollama WebUI)正是这样一个出色的开源项目,它提供了一个功能丰富的Web界面,让你能够便捷地与本地或远程的各类AI模型进行交互。

核心特性解析

1. 统一的多模型管理

OpenWebUI的核心优势在于其强大的模型兼容性。它能够作为一个统一的接口,连接并管理多种主流的大语言模型运行时和API:

- Ollama:无缝集成,用于在本地运行Llama 2、Mistral、Qwen等开源模型。

- OpenAI API:轻松接入GPT-3.5、GPT-4等模型。

- 其他API服务:支持Azure OpenAI、Anthropic Claude、Google Gemini,以及任何兼容OpenAI API格式的自部署模型后端。

这意味着开发者无需在不同平台的界面间频繁切换,在一个云原生/IaaS友好的环境里即可管理和测试所有模型。

2. 内置RAG知识库引擎

项目集成了检索增强生成(RAG)引擎,使你能够构建专属的知识库:

- 支持上传PDF、Word、文本、图片等多种格式文件。

- 将文档内容处理后,可供模型在回答时进行参考,显著提升回答的准确性和相关性。

- 支持知识库的增量更新与管理,非常适合构建企业内部知识助手或基于特定数据集的问答系统。

3. 注重隐私与安全

OpenWebUI设计之初就强调数据主权:

- 支持完全离线部署,所有对话数据和处理过程均可保留在本地服务器。

- 提供用户管理、权限控制等基础功能,适合对数据安全有要求的小团队或个人使用场景。

快速部署:使用Docker运行

对于大多数用户而言,通过Docker部署是最为快捷和方便的方式,可以有效避免环境依赖问题。

只需执行以下一条命令即可启动服务:

docker run -d \

-p 3000:8080 \

--name open-webui \

--restart always \

-v open-webui:/app/backend/data \

ghcr.io/open-webui/open-webui:main

命令执行后,在浏览器中访问 http://你的服务器IP:3000 即可进入OpenWebUI的初始化设置页面。

基础配置与使用流程

- 连接模型:首次进入后,需要在设置中配置模型后端。例如,若本地已安装Ollama,通常只需填入

http://host.docker.internal:11434 作为Ollama基础URL并保存,系统便会自动获取本地已拉取的模型列表。

- 创建与使用知识库:在“知识库”页面创建新的知识库,上传相关文档文件。在聊天时,可以选择启用特定的知识库,模型将基于其中的内容进行回答。

- 开始对话:在主聊天界面选择已连接的模型,即可开始进行多轮对话。界面支持对话历史管理、消息编辑等常用功能。

项目优势与适用场景

与其他类似工具相比,OpenWebUI的优势在于其 “一体化” 和 “开源可控”。

- 一体化:集成了聊天、多模型支持、知识库、Web搜索(插件)等核心人工智能应用功能。

- 开源可控:代码完全开源,允许进行深度定制和二次开发,且部署方式灵活。

适用场景包括:

- 个人开发者/爱好者:用于本地测试、对比不同开源模型效果,或作为学习LLM应用的平台。

- 中小型团队:需要快速搭建一个内部使用的AI问答助手,并希望将敏感数据留存在内网环境。

- 研究人员:需要一个统一的、可复现的界面来与不同模型进行交互实验。

总结

OpenWebUI作为一个活跃的开源项目,降低了个人和中小企业使用、管理大语言模型的门槛。它通过提供直观的Web界面、支持丰富的模型后端以及内置的RAG功能,成为了连接用户与本地/云端AI能力的一个高效桥梁。对于希望构建私有化、定制化AI应用的开发者而言,它是一个非常值得尝试的起点。

项目开源地址:https://github.com/open-webui/open-webui |