智能光学计算成像是将人工智能 (特别是深度学习) 与光学成像技术深度融合的前沿交叉领域。它通过整合光学神经网络、超表面、全息及量子光学等技术,旨在突破传统成像的物理极限,实现更高效、更智能的图像获取与处理。

关键技术与前沿应用

该领域近年来的关键进展主要体现在以下几个方面:

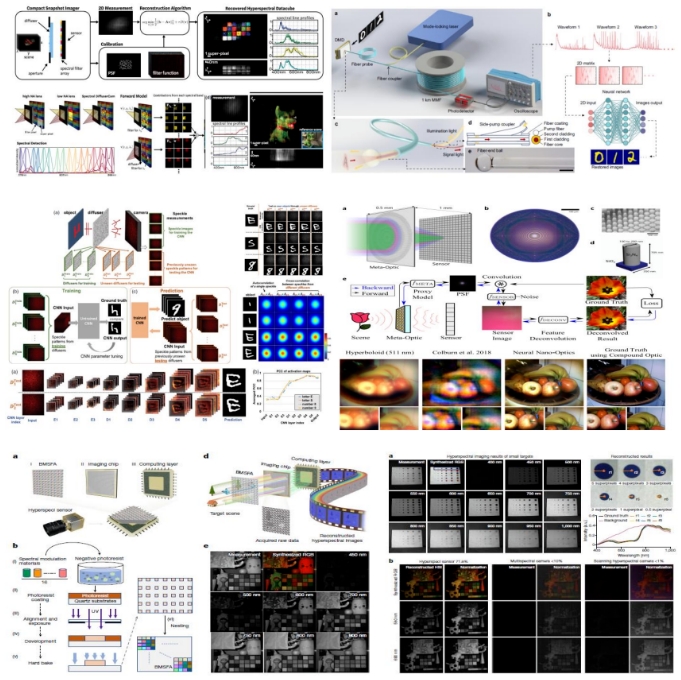

- 光纤与散斑成像:利用条件生成对抗网络等深度学习方法,实现了对多模光纤输出散斑或透过散射介质后散斑的快速解码与高质量图像重建。

- 光谱与高光谱成像:结合多通道滤光片、衍射光栅、超表面等硬件,并利用深度学习模型求解逆问题,实现了从低维测量数据中高效重建高光谱信息。

- 全息成像:应用深度神经网络优化全息图的重建过程,显著提升了三维重建的速度与成像质量。

- 超分辨率成像:通过深度学习模型,从低分辨率图像中恢复高频细节,有效提升光学系统的空间分辨率。

- 计算成像优化:利用可微分的计算模型,对成像全链路进行端到端的联合优化,从而用更简单、紧凑的光学硬件获得高质量图像。

核心课程内容体系

本课程体系旨在系统性地介绍智能光学计算成像的理论、算法与实践,主要涵盖以下模块:

一、 计算成像导论与理论基础

- 核心概念与现状:阐述计算成像的基本思想及其与传统成像的区别。

- 成像物理模型:深入讲解图像传感器、噪声模型及光波前分析等基础理论。

- 逆问题求解:介绍图像重构的数学基础,包括如何利用正则化方法求解一般性的计算成像逆问题。

- 实践案例:泊松图像融合 (Poisson Blending)。

二、 机器学习与Python 软件基础

- 机器学习基础:概述监督/无监督学习及线性回归、多层感知机等经典算法。

- Python 与关键库:涵盖 NumPy/CuPy 矩阵运算、Matplotlib 数据可视化。

- 深度学习框架:重点介绍 PyTorch 与 TensorFlow 的基本使用。

- 实践案例:使用 Numpy/CuPy 与 Matplotlib 绘制分形图像。

三、 深度学习模型与图像重构

- 经典网络架构:详解全连接网络 (FCN)、卷积神经网络 (CNN)、U-Net、ResNet 的原理与 PyTorch 实现。

- 先进重构方法:介绍神经表示 (Neural Representations)、神经渲染 (Neural Rendering) 及学习式重构 (Learned Reconstruction)。

- 优化算法:讲解如何使用 ADMM 算法求解图像重构问题。

四、 典型计算成像技术解析与实践

- 压缩感知成像:讲解压缩感知理论,及其在单像素成像、结构光照明中的应用。

- 实践案例:一维信号与二维图像的压缩感知重构;基于多模光纤的超快单像素成像。

- 高光谱成像:介绍高光谱成像原理及基于神经网络的光谱重建技术。

- 实践案例:基于神经网络的高空间分辨率宽带高光谱图像重建。

- 微纳光学计算成像:探讨超构表面 (Metasurface) 如何用于相位调控与成像增强。

- 无透镜成像:分析基于点扩散函数 (PSF) 调控的无透镜成像技术,如散射成像。

五、 端到端光学-算法协同设计

这是智能光学计算成像的核心范式,通过可微分的物理模型(如衍射模型、光线追迹模型),将光学硬件设计与后端图像处理算法在一个框架内进行联合优化,从而实现全局性能最优。

下面的技术示意图展示了这种端到端联合设计在解决复杂成像问题(如通过散射介质成像)中的强大能力。

- 综合案例一:端到端的散射介质散斑计算成像。

- 综合案例二:采用纯相位调制元件,实现从单张灰度图像到高光谱图像的端到端重建(融合超光谱、解模糊、点扩散函数设计与深度学习)。

适用人群

本内容适合光电工程、计算机科学(尤其是计算机视觉与人工智能方向)、物理、生物医学工程等领域的科研人员、工程师及高年级学生,旨在帮助其掌握智能光学计算成像的核心技术,并应用于大数据处理、精密检测、医疗诊断及新型成像设备开发等场景。 |