在大数据处理中,查询性能是决定分析效率的关键。本文将深入探讨从基础配置到高级调优的多维度方法,帮助你系统性地提升查询速度。

一、基础配置与模式优化

1. Fetch抓取

Fetch抓取是指Hive在某些查询场景下,可以绕过MapReduce计算,直接从存储中读取数据并输出。例如,执行 SELECT * FROM employees; 这类简单查询时,Hive会直接读取对应存储目录下的文件。

在 hive-default.xml.template 文件中,参数 hive.fetch.task.conversion 默认值为 more(老版本默认是 minimal)。将其设置为 more 后,全局查找、字段查找、LIMIT 查找等操作都将不走MapReduce,从而显著提升简单查询的响应速度。

2. 本地模式

当Hive查询处理的数据量较小时,启动分布式模式的额外开销(如网络传输、多节点协调)可能得不偿失。此时,可以启用本地模式,让作业在单台机器上执行,以加快速度。

启用本地模式涉及三个核心参数,它们共同决定了何时触发本地执行:

hive.exec.mode.local.auto=true:开启自动判断是否启动本地模式的开关。hive.exec.mode.local.auto.inputbytes.max:设置本地MR任务的最大输入数据量,默认128M。hive.exec.mode.local.auto.inputfiles.max:设置本地MR任务的最大输入文件个数,默认4个。

只有当输入数据量和文件数均小于上述阈值时,才会自动启用本地模式。

-- 开启本地mr

set hive.exec.mode.local.auto=true;

-- 设置local mr的最大输入数据量为50M

set hive.exec.mode.local.auto.inputbytes.max=50000000;

-- 设置local mr的最大输入文件个数为10个

set hive.exec.mode.local.auto.inputfiles.max=10;

二、从SQL与程序角度优化

1. 熟练运用SQL语法

高效的SQL语句是性能优化的基石。考虑这样一个场景:有一张用户交易表,需要取出每个用户最近一天的主营类目,以及前10天的总交易额和总笔数。

初始方案:

通过两个子查询分别计算最近类目和累计数据,最后进行关联。

-- 步骤1:获取最近一天的主营类目

INSERT OVERWRITE TABLE t1

SELECT user_id, substr(MAX(CONCAT(ds, cat)), 9) AS main_cat

FROM users

WHERE ds='20120329'

GROUP BY user_id;

-- 步骤2:汇总前10天的总交易数据

INSERT OVERWRITE TABLE t2

SELECT user_id, sum(qty) AS qty, SUM(amt) AS amt

FROM users

WHERE ds BETWEEN '20120301' AND '20120329'

GROUP BY user_id;

-- 步骤3:关联最终结果

SELECT t1.user_id, t1.main_cat, t2.qty, t2.amt

FROM t1 JOIN t2 ON t1.user_id=t2.user_id;

此方案需要两次全表扫描和两次中间表写入,效率较低。

优化方案:

使用窗口函数和聚合函数,一次扫描完成计算。

SELECT user_id,

substr(MAX(CONCAT(ds, cat)), 9) AS main_cat,

SUM(qty),

SUM(amt)

FROM users

WHERE ds BETWEEN '20120301' AND '20120329'

GROUP BY user_id;

优化后,作业从原有的25分钟缩短到10分钟以内,主要得益于减少了中间表的读写开销。这种利用聚合函数合并逻辑的SQL优化思路具有普适性。

2. 解决无效ID导致的数据倾斜

当主键(如user_id)存在大量NULL值时,这些空值在JOIN时会被当作相同的Key分配到同一个Reduce Task,引发严重的数据倾斜。

方案一:过滤NULL值,分开处理

SELECT * FROM log a

JOIN bmw_users b ON a.user_id IS NOT NULL AND a.user_id=b.user_id

UNION ALL

SELECT * FROM log a WHERE a.user_id IS NULL;

此方案需要读取log表两次。

方案二:使用CASE WHEN将NULL值随机打散

SELECT * FROM log a

LEFT OUTER JOIN bmw_users b

ON CASE WHEN a.user_id IS NULL THEN CONCAT('dp_hive', RAND())

ELSE a.user_id END = b.user_id;

方案二通过将空值转换为随机字符串,把倾斜的数据均匀分发到不同Reduce上,同时只读取一次log表,作业数从2个减少为1个,IO和计算效率更高。

3. 解决不同数据类型关联产生的倾斜

如果关联两边的字段数据类型不一致(例如STRING与BIGINT),Hive在进行Hash分发时可能无法正确识别,导致某一类型的数据全部进入同一个Reduce。

解决方案:将关联字段统一转换为字符串类型。

SELECT * FROM s8_log a

LEFT OUTER JOIN r_auction_auctions b

ON a.auction_id = CAST(b.auction_id AS STRING);

通过此优化,一个原本需要1.5小时的作业可缩短至20分钟内完成。

4. 利用Hive对UNION ALL的优化

Hive会将多个UNION ALL的子查询优化成一个作业(Job)执行。

SELECT * FROM effect a

JOIN (

SELECT auction_id AS auction_id FROM auctions

UNION ALL

SELECT auction_string_id AS auction_id FROM auctions

) b

ON a.auction_id=b.auction_id;

此写法比分别用数字ID和字符串ID去关联商品表性能更优,因为商品表(auctions)和效果表(effect)都只被读取一次,最终只需一个MapReduce作业。

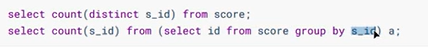

5. 使用GROUP BY替代COUNT(DISTINCT)

在数据量极大的场景下,COUNT(DISTINCT)操作会由一个Reduce Task处理全部去重数据,极易成为性能瓶颈。通常可以改用GROUP BY后再COUNT的方式。

-- 原语句(可能产生数据倾斜)

SELECT COUNT(DISTINCT user_id) FROM log;

-- 优化语句

SELECT COUNT(1) FROM (SELECT user_id FROM log GROUP BY user_id) t;

虽然优化语句会多出一个子查询作业,但在海量数据下,能有效避免单个Reduce负载过重,总体耗时更短。

三、MapReduce任务深度调优

1. Map阶段优化

(1) 控制MapTask数量

过多的MapTask(尤其是每个处理的数据量远小于HDFS块大小128M/256M时)会带来额外的任务调度开销。这通常是由于源头存在大量小文件。

相关调优参数:

hive.merge.mapfiles=true:在Map-only任务结束时合并小文件。hive.merge.size.per.task=256000000:合并后文件的目标大小(默认256M)。mapreduce.input.fileinputformat.split.maxsize:控制切片的最大值,调大此值可减少Map数。mapreduce.input.fileinputformat.split.minsize.per.node:控制单个节点上切片的最小值,用于在节点层面合并小文件。

(2) 调整MapTask内存

避免因内存不足导致的频繁GC(垃圾回收)。

set mapreduce.map.memory.mb=4096; -- 设置Map Task容器内存为4G

set mapreduce.map.cpu.vcores=2; -- 设置Map Task申请的CPU核数

可以通过JobHistory查看Task的计数器,确保 GC time elapsed / CPU time spent < 10%。

2. 攻克数据倾斜难题

数据倾斜的本质是MapReduce中部分Reduce Task处理的数据量远高于其他Task。 以下是针对GROUP BY和JOIN的专项优化。

(1) GROUP BY 数据倾斜优化

- Map端预聚合:相当于在Map端执行一次

Combiner,大幅减少Shuffle数据量。

set hive.map.aggr = true; -- 开启Map端聚合

set hive.groupby.skewindata = true; -- 开启负载均衡(会生成两个MR Job)

- 热点Key分离处理:手动将导致倾斜的热点Key取出,先打散进行局部聚合,再与正常数据合并。

-- 将热点key(如‘NULL’或‘-99’)单独处理

SELECT key, sum(cnt) FROM (

SELECT CASE WHEN key = '热点值' THEN concat('热点值', '_', cast(rand()*10 as int)) ELSE key END as new_key, cnt

FROM original_table

) t GROUP BY new_key;

-- 然后再对结果进行二次汇总(如需)

(2) JOIN 数据倾斜优化

- MapJoin:适用于大表 JOIN 极小表(维表)。可将小表全量加载到每个Map Task的内存中,在Map端完成Join,彻底消除Shuffle。

-- 通过Hint提示使用MapJoin

SELECT /*+ MAPJOIN(small_table) */ big_table.*, small_table.*

FROM big_table JOIN small_table ON big_table.key = small_table.key;

-- 调整小表内存限制(默认512M,最大2048M)

set hive.sql.mapjoin.memory.max=2048000000;

- Skew Join:适用于大表 JOIN 大表且存在热点Key。Hive会自动检测倾斜的Key,并将其拆分成多个子任务处理,非倾斜部分走普通Join。

-- 开启Skew Join优化

set hive.optimize.skewjoin = true;

set hive.skewjoin.key = 100000; -- 键出现次数超过10万则判定为倾斜

-- 执行Join语句

SELECT * FROM big_table_a a JOIN big_table_b b ON a.key = b.key;

其原理如下图所示,能有效避免热点Key拖慢整个作业:

3. Reduce阶段与Shuffle调优

(1) 调整ReduceTask并行度

在无数据倾斜的前提下,若每个Reduce处理的数据量过大,可适当增加Reduce数量。

set mapred.reduce.tasks = 100; -- 根据数据量设置,通常 map数量:reduce数量 ≈ 10:1

(2) 优化Shuffle过程

Shuffle阶段的网络I/O和磁盘Merge是性能关键。

- 并行副本数:调整Reduce从Map端并行下载数据的线程数。

set mapreduce.reduce.shuffle.parallelcopies = 10; -- 默认5,网络好可调大

- Reduce端缓存:调整Reduce Task用于缓存Map输出结果的内存比例。

set mapreduce.reduce.shuffle.input.buffer.percent = 0.7; -- 默认0.7,使用堆内存的70%

set mapreduce.reduce.shuffle.merge.percent = 0.66; -- 内存缓冲区使用率达到66%时启动合并溢写

- Merge因子:控制每次磁盘文件合并时操作的文件数量。

set mapreduce.task.io.sort.factor = 20; -- 默认10,磁盘IO能力强可适当调大

通过结合上述基础优化、SQL编写技巧与底层MapReduce参数调优,可以构建起多层次的大数据查询性能保障体系,从容应对海量数据下的快速分析挑战。