本文将为你全面梳理 GitHub 上热门的 AI 控制安卓手机的开源项目,涵盖从视觉理解到自动化操作的完整框架。

Open-AutoGLM:智谱开源的视觉操控框架

智谱AI开源的 Open-AutoGLM 项目,一经发布便迅速获得大量关注。其核心是构建一个能够“看懂”手机屏幕并执行操作的智能体(Agent)。

该框架的工作流程模拟人类行为:

- 视觉感知:首先对安卓手机屏幕进行截图。

- 分析与规划:视觉语言模型(VLM)分析截图,结合用户指令,规划出下一步操作(如点击、滑动、输入)。

- 指令执行:通过 ADB(Android Debug Bridge)工具,将规划好的操作转化为具体的触摸或文本输入指令发送给手机。

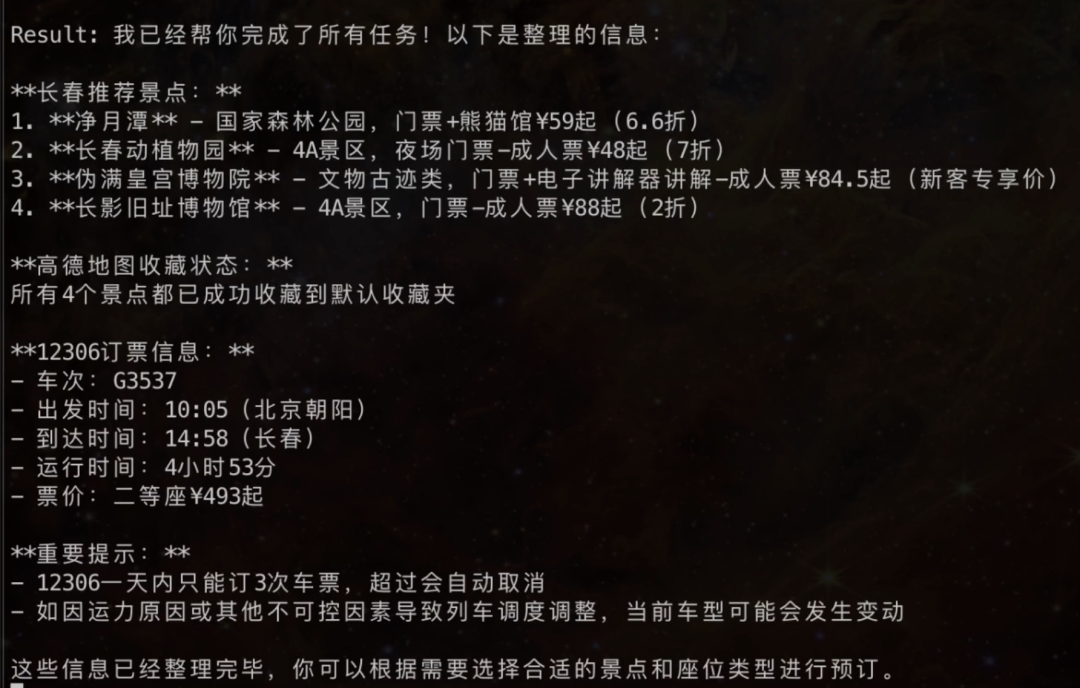

通过这一循环,Agent 可以完成复杂的多应用任务,例如:“查找长春的旅游景点,在高德地图收藏,并查询博物馆门票信息”。

项目支持本地部署,对硬件有一定要求(如约24GB显存),这为处理包含隐私信息的操作(如聊天、支付)提供了本地化解决方案。

快速体验:你可以通过 Claude Code 等工具,配置 GLM Coding Plan 后,使用以下提示词快速启动部署:

访问文档,为我安装 AutoGLM :https://raw.githubusercontent.com/zai-org/Open-AutoGLM/refs/heads/main/README.md

开源地址:https://github.com/zai-org/Open-AutoGLM

DroidMind:基于 MCP 协议的轻量级适配器

DroidMind 项目的设计思路另辟蹊径,它不训练新模型,而是作为一个“适配器”,通过模型上下文协议(MCP)将你的安卓手机连接到 Claude Desktop、Cursor 或 Claude Code 等智能体平台。

这意味着你无需在本地运行庞大的模型,可以直接利用云端强大的 Claude 或 Gemini 等模型的推理能力。DroidMind 负责将模型的自然语言指令“翻译”成手机可执行的 ADB 命令,充当了一个高效的中间层。

开源地址:https://github.com/hyperb1iss/DroidMind

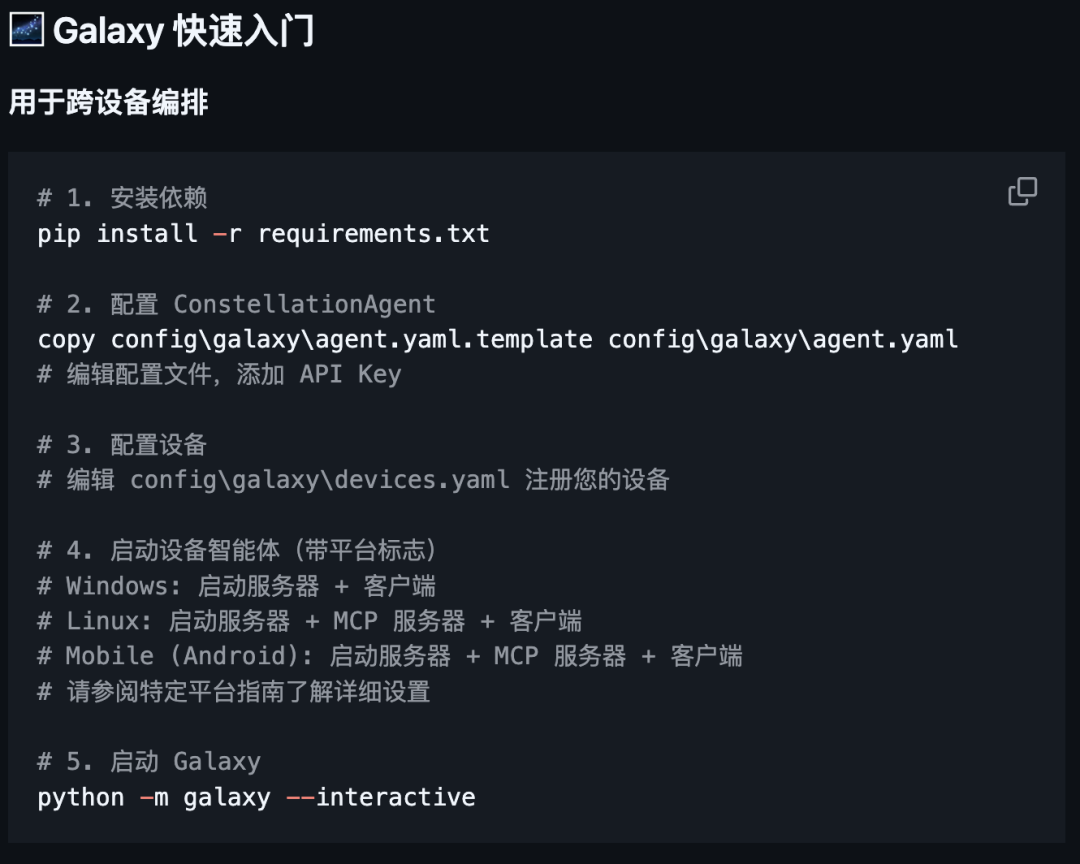

UFO³ Galaxy:微软开源的跨平台设备编排系统

UFO 原是微软开源用于操控 Windows 的 AI 项目,其最新版本 UFO³ Galaxy 已演进为一个强大的跨设备、跨平台任务编排框架。

该系统同样基于 MCP 架构实现扩展,从而能够调度安卓手机。其核心概念包括:

- Galaxy(星系):中央任务调度器。

- Constellation(星座):将复杂用户指令拆解为任务有向无环图(DAG)。

在这个框架下,Windows PC、Linux 服务器、安卓手机等均可作为独立节点接入,由 AI 协调完成跨设备工作流,例如“将手机刚拍的照片传到电脑并用 PS 编辑”。

开源地址:https://github.com/microsoft/UFO

UI-TARS:字节跳动的端到端视觉 GUI 智能体

字节跳动开源的 UI-TARS 是一个基于视觉-语言模型(VLM)的 GUI 智能体项目,旨在让 AI 通过视觉识别来操控任意图形界面。

对于安卓设备,UI-TARS 采用端到端、纯视觉驱动的方案:

- 捕获手机屏幕截图。

- 视觉模型结合用户指令,理解屏幕内容并决策下一步操作。

- 模型输出动作,最终转化为 ADB 命令执行。

这种方法减少了对手动编写规则或界面识别的依赖,更加通用化。

开源地址:https://github.com/bytedance/UI-TARS

总结

上述四个项目代表了当前人工智能操控安卓设备的主流技术路径:从 Open-AutoGLM 和 UI-TARS 的端到端视觉模型方案,到 DroidMind 和 UFO 的利用 MCP 协议进行任务编排与翻译的轻量级方案。它们为自动化测试、无障碍辅助、个人手机助手等场景提供了强大的开源基础设施。开发者可以根据对性能、隐私和部署复杂度的不同需求进行选择,利用Python等语言进行二次开发与集成。