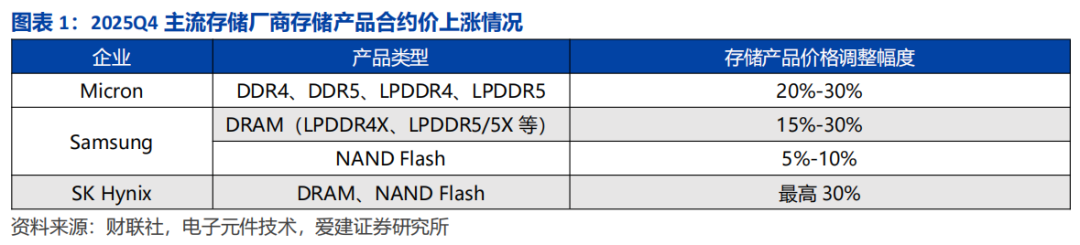

2025年第三季度,全球存储市场迎来新一轮价格调整。9月14日,美光(Micron)宣布将存储产品价格上调20%-30%,并暂停了DDR4、DDR5及移动DRAM(LPDDR4、LPDDR5)等产品的报价。紧接着在9月22日,据Newdaily报道,三星(Samsung)宣布将LPDDR4X、LPDDR5/5X等移动DRAM产品合约价上调15%-30%,同时将NAND Flash合约价上调5%-10%。10月23日,SK海力士(SK Hynix)官方宣布,2025年第四季度DRAM与NAND Flash合约价最高上调30%。

回顾2016年至2025年全球芯片市场的周期表现,价格波动主要受终端需求驱动。2016-2018年的涨价周期主要得益于智能手机的升级换代。而2020-2023年,线上经济与居家办公等场景则拉动了PC等终端出货量的提升。

近年来,人工智能(AI)产业的爆发式增长,使得服务器等高端计算设备对存储芯片的容量、带宽及延迟性能提出了前所未有的高要求。HBM3E、DDR5等先进存储技术加速迭代,成为匹配这一需求的核心方案。其中,HBM3E凭借其超高带宽,以及在散热与能效上的显著提升,有效突破了AI大模型训练的I/O瓶颈;DDR5则以其低延迟优势,精准适配AI推理等场景的高性能需求。

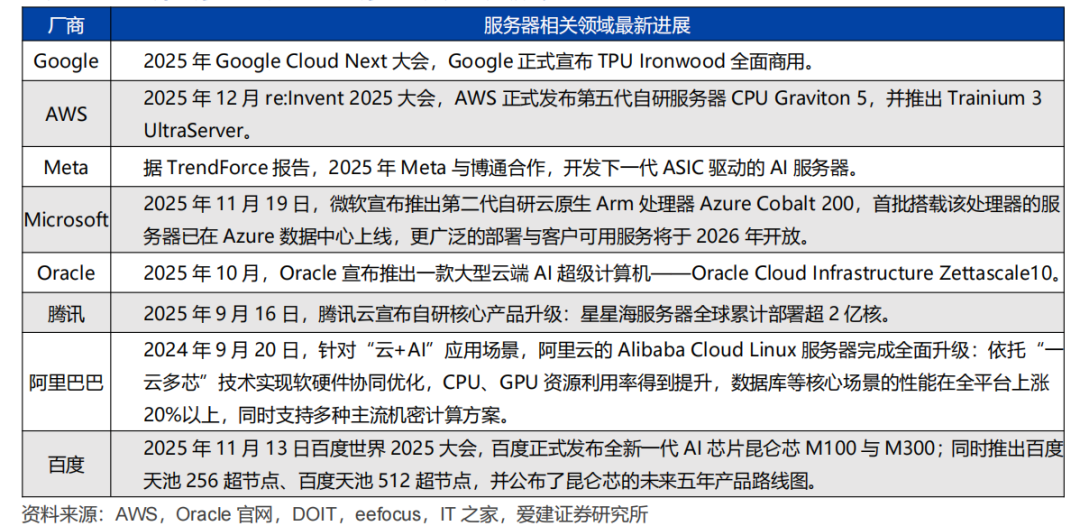

TrendForce数据显示,谷歌、AWS、Meta、微软、甲骨文、腾讯、阿里巴巴、百度这八大云服务厂商的资本开支从2021年的1451.0亿美元增长至2024年的2609.0亿美元,年复合增长率达21.6%。该机构进一步预测,到2026年,全球八大云服务厂商的资本开支有望达到6020亿美元,2024-2026年的年复合增长率或将高达51.9%。

根据弗若斯特沙利文的数据,全球服务器市场规模从2020年的1360万台增长至2024年的1600万台(其中AI服务器占比12.5%),2020-2024年复合增长率为4.2%。该机构预测,到2030年,全球服务器市场规模将增长至1950万台(AI服务器占比提升至33.3%),2025-2030年的复合增长率预计为3.7%。

内存:DRAM市场与技术格局

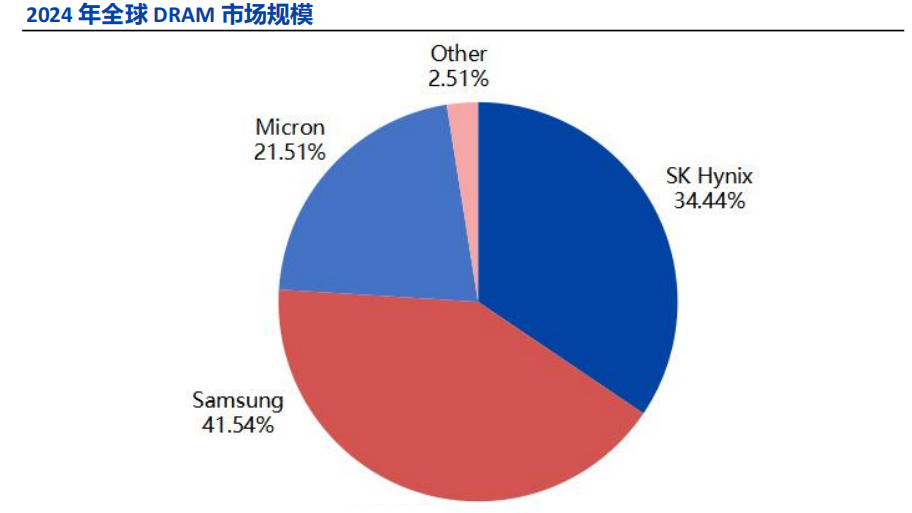

全球DRAM市场呈现高度集中的寡头垄断格局。根据DRAMeXchange和TrendForce的数据,2024年,SK海力士、三星和美光这三家公司合计占据了全球97.49%的市场份额。

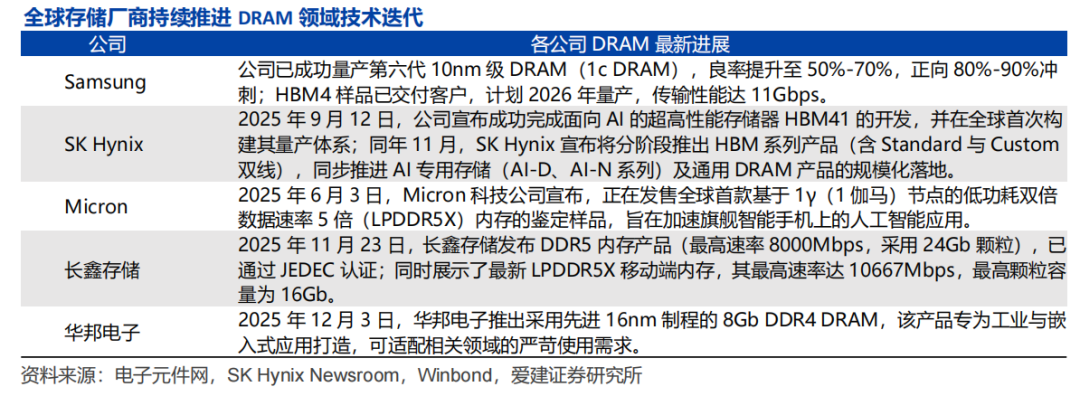

全球领先的存储厂商持续深耕DRAM领域,加速技术迭代。三星已量产第六代10nm级(1c)DRAM,并向客户交付了HBM4样品,计划于2026年量产;美光推出了全球首款基于1γ节点的LPDDR5X内存样品,旨在赋能旗舰手机的AI应用。在国内,长鑫存储发布了通过JEDEC认证的DDR5内存(最高速率8000Mbps)及LPDDR5X移动端内存(最高速率10667Mbps)。

DRAM技术路线的分化

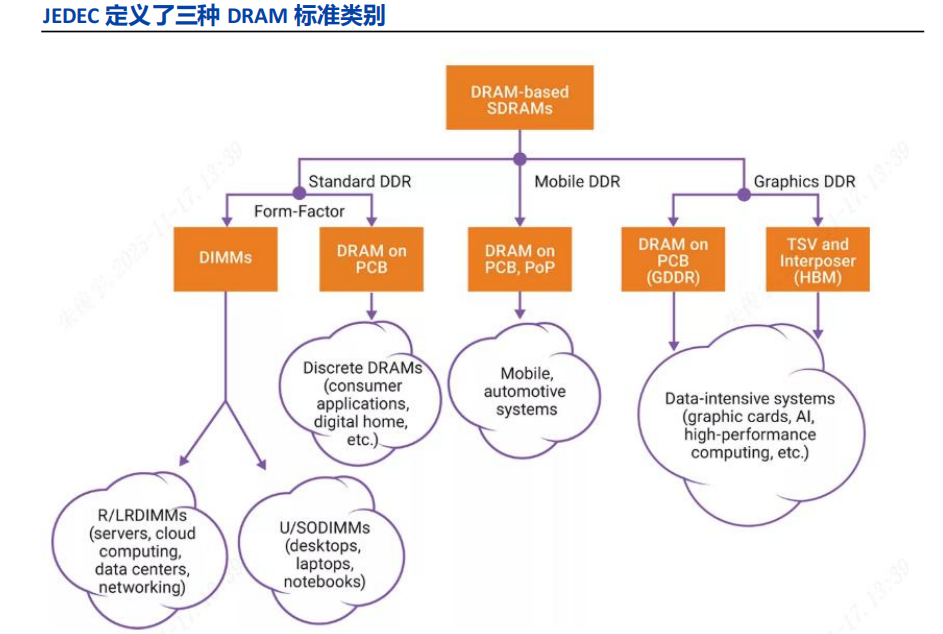

固态技术协会(JEDEC)已明确定义并开发出DDR、LPDDR及GDDR三类主要的DRAM标准。这三类标准各有侧重,旨在帮助设计人员精准满足不同目标应用在功耗、性能及规格上的核心需求。

标准DDR主要面向服务器、云计算、网络设备、笔记本电脑、台式机及消费类应用。它支持更宽的通道、更高的存储密度与多样化的形状尺寸,其性能提升的核心路径在于优化核心频率。

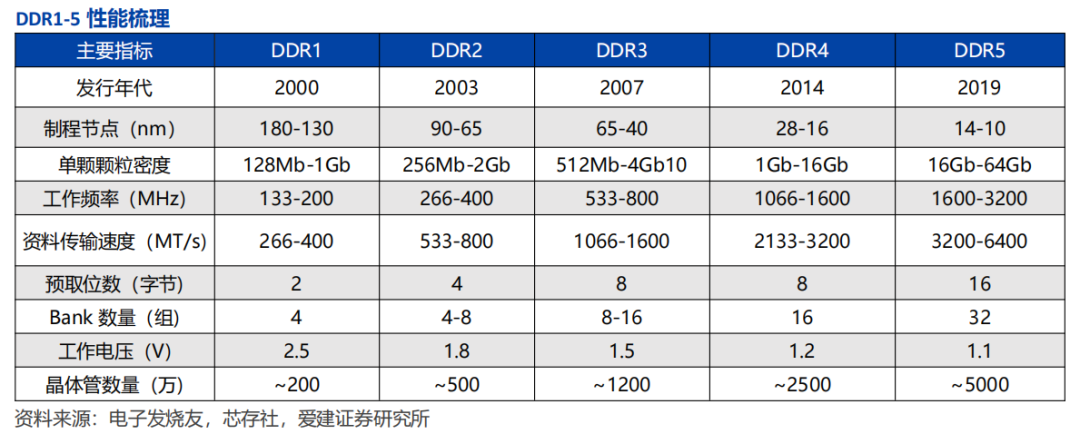

从DDR1到DDR5的技术演进中,产品呈现出“能耗降低、速度提升、容量增大”的清晰趋势。作为当前最新的内存标准,DDR5采用14-10nm的制程节点;数据传输速率从DDR4的2133-3200 MT/s,提升至3200-6400 MT/s;同时其工作电压下降至1.1V,在降低功耗的同时进一步提升了性能。

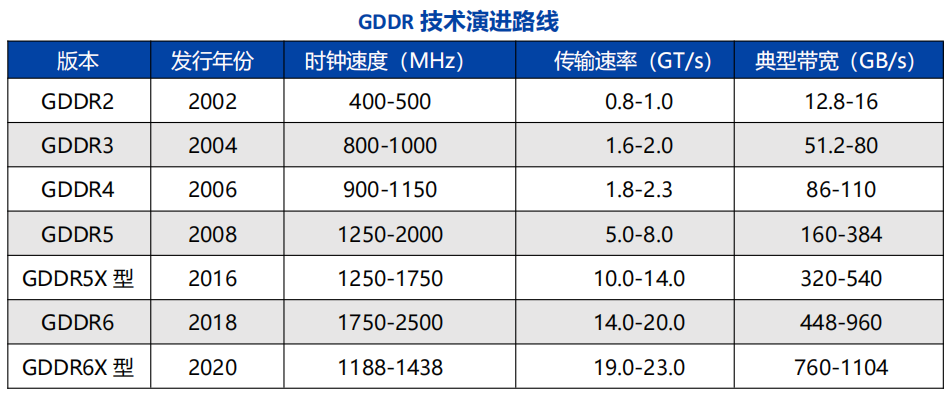

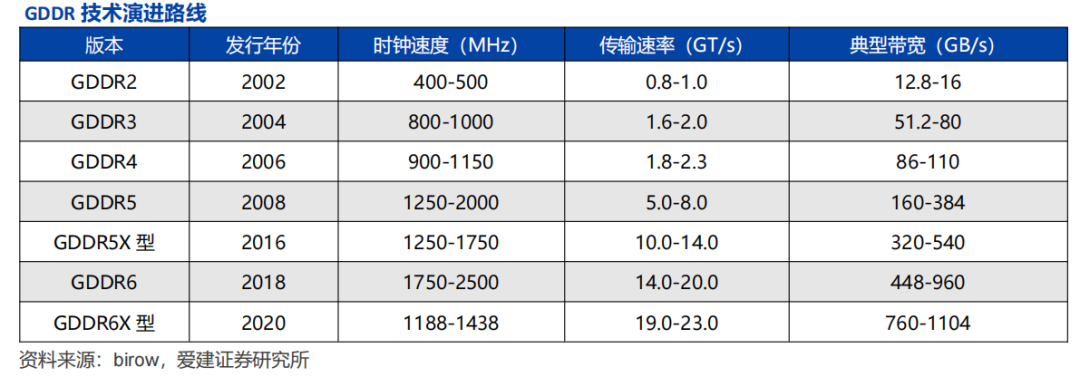

GDDR是一类适用于高端显卡的高性能DDR存储器,主要面向图形处理、数据中心加速、人工智能等对吞吐量要求极高的数据密集型应用。它以SDRAM为基础发展而来,历经二十余年演进已十分成熟。目前市面上的GDDR6、GDDR6X传输速率分别达到14.0-20.0 GT/s、19.0-23.0 GT/s,其中GDDR6X的传输带宽可达760-1104 GB/s。随着AI大模型、4K/8K超高清渲染等场景需求的持续升级,下一代GDDR7的性能提升将巩固其在高端显卡与AI加速硬件中的主流地位。

DRAM核心发展方向:HBM

人工智能的发展深刻改变了芯片行业。随着大模型计算量持续增长,传统内存带宽难以支撑AI高计算量场景的需求,制约了GPU性能的充分释放。其中,占芯片面积约60%的缓存以及存储结构与工艺,成为进一步挖掘GPU潜力的关键。而HBM(高带宽内存)通过其高带宽、低延迟的特性,能有效减少数据传输损耗,有望破解芯片性能提升的瓶颈,助力AI高效执行深度学习任务。

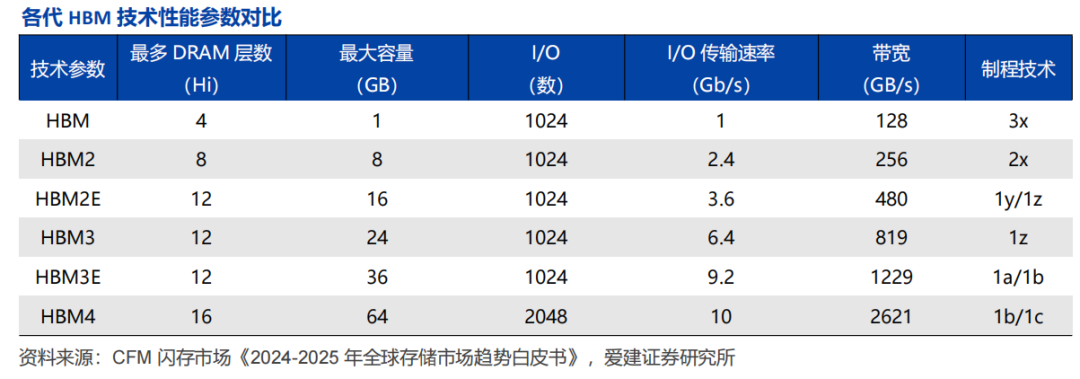

HBM是一种基于3D堆叠技术的高性能DRAM。它通过垂直堆叠多个DRAM芯片,并利用硅通孔(TSV)技术实现芯片之间的高速互连,从而大幅提升数据带宽。

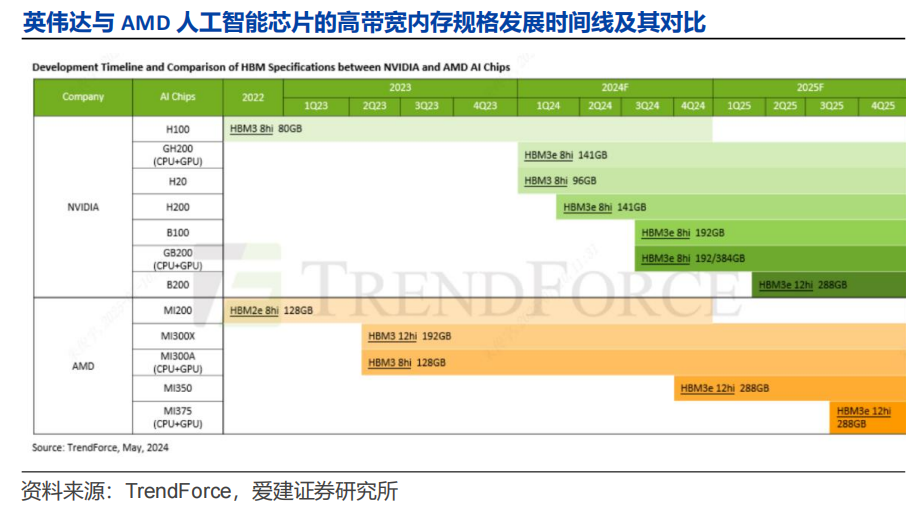

TrendForce数据显示,英伟达与AMD的AI芯片所采用的HBM技术路线呈现同步迭代、分层竞争的特征。在2022-2025年这个周期内,双方的HBM规格从HBM2e/HBM3(8层堆叠)升级至HBM3e(8层/12层堆叠),单芯片HBM容量从80-128GB提升至288GB以上。

自2015年第一代HBM发布以来,该技术已逐步迭代至第六代——HBM4。纵观这六代产品的性能演变,其在带宽、单芯片容量、堆叠层数等关键维度均实现了巨大突破:带宽从初代的128GB/s提升至HBM4的2.56TB/s;单芯片容量从1GB增加至64GB;堆叠层数则从4层(4Hi)升级至16层(16Hi)。

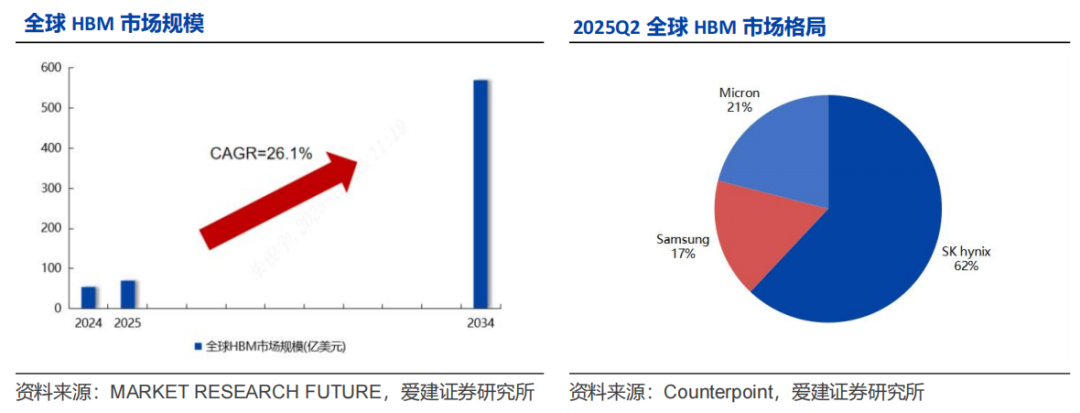

全球HBM市场前景持续向好。Market Research Future数据显示,2024年全球HBM市场规模为56.1亿美元,预计到2034年将增长至570.9亿美元,2024-2034年的年复合增长率高达26.1%。

由于技术门槛极高,目前全球仅SK海力士、三星、美光三家企业具备HBM稳定量产及供应能力。其中SK海力士技术优势显著,于2023年8月率先推出HBM3E产品,并正积极推进HBM4研发。据Counterpoint数据,2025年第二季度全球HBM市场份额中,SK海力士、美光、三星的占比分别为62%、21%、17%。

TrendForce数据显示,2023年至2025年,HBM在DRAM市场中的渗透正在加速:2023年,HBM产量和营收占DRAM总规模的比重分别为2%和8%;预计到2025年,这两个数字将分别达到10%和30%。