AI 并没有改变企业追求确定性的本质, 它只是第一次,把“不确定性”引入了企业核心系统。

过去一年,几乎所有大型企业、互联网公司、传统行业龙头,都在谈论引入 AI Agent。然而,一个残酷的现实摆在眼前:真正在生产系统中稳定运行的 AI Agent,比例极低。

更多的项目呈现出的状态是:

- Demo 效果惊艳

- PPT 理念超前

- 试点不断开展

- 规模化却一再失败

问题究竟出在哪里?通过对大量企业案例的调研、技术评估和系统复盘,我们发现:失败的根因,往往并非模型本身能力不足,而是“成熟度错位”。 企业面临的挑战不再是“AI 能不能做”,而是——在当前企业的系统与治理成熟度下,AI 被允许和能够做到什么程度。

一、为什么“成熟度模型”是企业 AI Agent 的第一性问题

在咨询实践中,一个反复出现的现象是:

企业一旦决定“上 AI Agent”, 就会不自觉地用“终局视角”倒推系统设计。

例如,很多企业直接期望 AI 能全自动处理复杂工单,或希望 Agent 能自主决策库存、调度、成本,甚至大幅减少审批环节和人力投入。这在商业逻辑上看似合理,但在系统工程层面却极其危险。

1. 企业系统的本质:对不确定性的管理

传统企业 IT 系统的核心目标非常明确:

消灭不确定性。

- 流程引擎(BPM)→ 固化执行路径

- ERP 系统 → 施加强业务约束

- 审批流 → 收敛潜在风险

而 AI Agent 的本质恰恰相反:

在不确定性中,生成“足够好”的决策与行动建议。

这两种系统范式之间,存在着天然的、根本性的张力。

2. 为什么仅关注“能力视角”注定失败

大多数企业在初期讨论 Agent 时,关注点往往局限于技术能力:能不能调用 API、能不能进行多轮推理、能不能自动执行任务。但真正决定一个 AI 项目能否在企业内落地生根的,从来不是这些“能不能”,而是:

成熟度模型的核心价值正在于此: 它帮助企业在不同发展阶段,清晰地界定其系统可以承受多大的“不确定性半径”,从而规划出风险可控的演进路径。

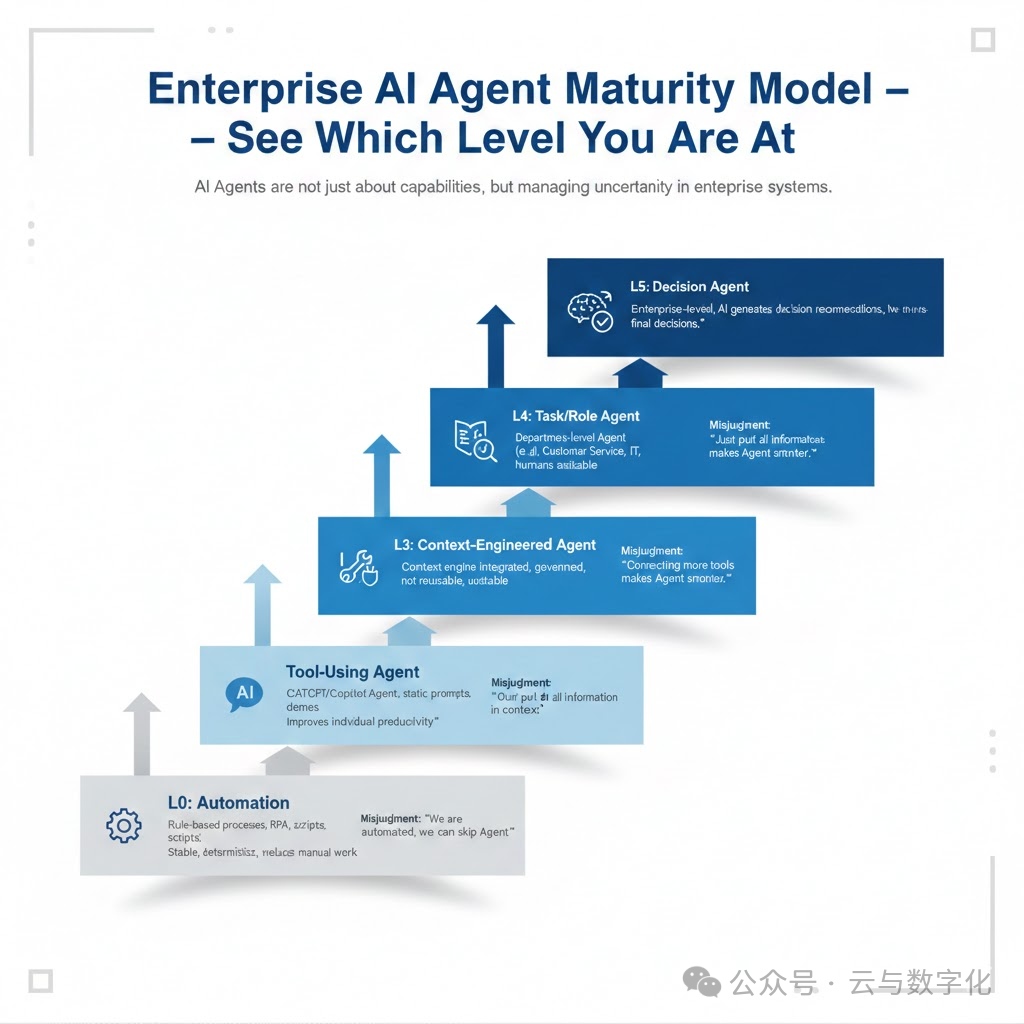

二、企业 AI Agent 成熟度模型:六个不可跳过的层级

下文介绍的模型并非理想化的理论路径,而是基于大量企业反复试错后,总结出的“最小风险演进路径”。每个层级都代表了不同的能力、治理水平和风险承受度。

第 0 层:Automation(自动化)

——确定性世界的巅峰形态

1. 典型系统形态

- 脚本自动化

- 流程引擎(BPM)

- RPA(机器人流程自动化)

- 规则驱动的运维、审批、调度系统

2. 这一层解决了什么问题

- 减少重复性人工操作

- 降低人为操作错误率

- 提升跨部门流程的一致性

这是过去20年企业IT建设的主战场。

3. 被严重低估的核心特征

Automation 并非“低级阶段”,而是确定性系统所能达到的极致形态。它的核心特征可以用一句话概括:

只要输入条件一致,输出结果就必须严格一致。

4. 最大的误判与风险

“我们已经很自动化了,可以直接跳过前期,上马复杂的 Agent。”

这是90% AI Agent 项目失败的起点。Automation 系统对不确定性是零容忍的;而 Agent 系统天生就是概率性系统。如果不在认知和架构上进行彻底的范式切换,后续建设必然崩溃。

第 1 层:Prompt-based AI(基于提示词的AI)

——“看见能力”的阶段,而非“拥有能力”

1. 典型表现

- ChatGPT / Copilot 类工具的使用

- 静态、手写的 Prompt(提示词)

- 用于文档生成、代码辅助、数据分析

2. 这一层的真实价值

- 让组织第一次直观感知到大模型的能力边界

- 显著提升个体员工的生产力

- 有效激发管理层的想象力和投资意愿

这是整个组织的认知启蒙阶段。

3. 被普遍误解的关键点

Prompt ≠ 系统能力

Prompt 的特性是:

- 不可复用:高度依赖具体场景和个人

- 不可治理:难以进行版本管理和统一优化

- 不可审计:决策过程难以追溯和复盘

- 强依赖个人经验:效果波动大

它本质上是“个人能力的放大器”,而非“可沉淀的系统能力”。

4. 这一层最大的风险

企业容易在这一层产生危险的错觉:

“只要我们把 Prompt 写得足够精妙,就能直接支撑起复杂的企业级 Agent 系统。”

必须强调的结论是:

静态、孤立的 Prompt,无法支撑任何需要稳定性、可治理性的企业级 Agent 系统。

——最容易“看起来成功,实际上失败”的阶段

1. 典型形态

- Agent 被赋予调用外部 API 的能力

- 能够查询数据、创建工单、调用其他业务系统

- Demo 演示效果极其惊艳,似乎无所不能

2. 这一层的关键跃迁

AI 从仅提供“建议”,走向了可以发起“执行”。这是一个质的飞跃。

3. 为什么这一层最危险?

在这一层,项目常常呈现以下特点:

- 工具(Tools)数量快速膨胀,缺乏管理

- 上下文(Context)越堆越多,变得臃肿不堪

- Agent 可能的错误执行路径呈指数级增长

但致命的问题是:

- 无法稳定复现和定位问题

- 无法解释 Agent 为何做出某个失败决策

- 没有任何人能为 Agent 的自主行为后果负责

4. 这一层的核心矛盾

Agent 已经“能干活”, 但系统还远未具备“治理能力”。

这正是大量AI项目 “卡死在第2层” 无法走向规模化的根本原因。

第 3 层:Context-Engineered Agent(上下文工程化智能体)

——真正的工程能力分水岭

这是判断企业是否真正具备驾驭 AI Agent 能力的分界点。

1. 核心变化:从 Prompt 到 Context Engine

关键升级不在于模型,而在于架构:

- Context(上下文)被结构化管理,而非简单堆砌

- Context 被有效治理,包括版本、权限、有效性

- Context 可审计、可回溯,整个决策链路清晰

Context 不再是“一次性输入”,而是可复用的核心系统资产。

2. 这一层系统获得的关键能力

- 稳定性:行为输出更加可预测

- 可预测性:对结果有更高置信度

- 问题可定位性:能够追踪和诊断问题根源

- 行为边界可定义:能明确限制Agent的行动范围

从这一层开始,Agent 才初步具备了:

- 长期稳定运行的基础

- 进入生产系统的资格

- 获得组织信任的可能性

3. 常见的致命误区

“把所有相关信息都塞进 Context,Agent 就会更聪明。”

Context Engineering(上下文工程)的目标绝不是“信息更多”,而是:

在正确的时刻,为正确的 Agent,提供刚刚好的正确上下文。

第 4 层:Task / Role Agent(任务/角色型智能体)

——从“通用能力”走向“组织分工”

1. 典型形态

- 专属的客服 AI Agent

- 专属的运维 AI Agent

- 财务或 ERP 领域的 AI Agent

2. 这一层的本质变化

- Agent 不再试图“什么都能干一点”

- 而是“只为某个特定组织角色或任务链条深度负责”

这实质上是企业组织结构在技术架构上的映射。

3. 最大的风险点

多 Agent ≠ 高智能

如果没有统一的:

- Context 治理体系

- Memory(记忆)共享与同步机制

- Tool 的权限与安全模型

那么多 Agent 的引入只会带来:

- Agent 间协作混乱,效率低下

- 问题出现时责任难以界定

- 系统整体复杂度失控,运维成本飙升

第 5 层:Decision Agent(决策建议型智能体)

——企业真正想要,但最难驾驭的一层

1. 这一层的正确定位

AI 负责生成决策建议与分析, 人类保留并行使最终决策权。

这是当前技术与管理条件下,企业级 Agent 所能触及的安全上限。

2. 为什么不能是“AI 全权决策”?

核心制约在于:

- 法律与合规风险:现有法律框架难以界定AI决策主体责任

- 责任归属问题:一旦造成重大损失,责任无法清晰划分

- 系统不可解释性:复杂模型的决策黑箱仍未完全打开

成熟的现代企业永远不会把 “最终决策权” 和与之对应的 “风险承担权” 完全交给 AI 系统。

3. 一个重要的能力判断标准

当 AI 给出了一个错误的决策建议时, 你的团队是否能系统性地解释“它为什么会错”?

如果答案是否定的,那么你的组织很可能还未真正准备好进入这一层。

三、成熟度自检:一句话判断你在哪一层

你可以用以下问题快速对组织当前状态进行诊断:

如果你的 AI Agent 在工作中出错了,你现在能够做到:

- 完全不知道为什么 → 很可能停留在 第 1 或 第 2 层

- 能在局部定位到问题环节(如某个工具调用失败或上下文缺失) → 达到了 第 3 层 水平

- 能进行系统性治理和优化(如调整角色分工、优化上下文策略) → 进入了 第 4 层及以上

四、给管理层的关键提醒

AI Agent 的引入不是一次简单的“技术升级”,它本质上是一场“治理能力升级”。 许多失败的项目,往往并非因为走得太慢,而是因为——走得太快,跨越了当前组织成熟度所能支撑的台阶。

五、结语:真正的领先,从来不是抢跑

在 AI Agent 席卷而来的时代:

- 真正的领先,不在于最早使用 AI 技术

- 而在于最清醒地认知自己正站在哪一个成熟度层级

- 并且深刻地知道 “现阶段最不该做什么”

企业之间未来的分水岭,将不再仅仅体现在模型参数的多少上,而会更深刻地体现在——对智能系统不确定性的理解深度与治理能力上。关于更多人工智能与企业数字化的深度讨论,欢迎访问云栈社区进行交流。