1. 引言: 为什么我们需要 epoll?

在深入技术细节之前,不妨先思考一个现实问题:一个服务器如何同时处理成千上万个客户端连接?

想象一下银行办理业务的场景:

- 原始方法(阻塞IO): 一个柜员处理一个客户,其他人必须排队等待。

- 改进方法(多进程/线程): 增加更多柜员,每人处理一个客户。

- 高效方法(IO多路复用): 一个“大堂经理”监控所有等待的客户,当某个客户准备好时,才分配柜员处理。

epoll 就是这个高效的“大堂经理”系统。在 Linux 网络编程中,处理大量并发连接的传统方法(如 select/poll)就像是让经理不断询问每个客户“你好了吗?”,而 epoll 则是客户准备好时主动通知经理。

1.1 历史背景: 从 select 到 epoll 的演进

通过一个表格可以清晰地对比三种主要的 I/O 多路复用技术:

| 特性 |

select |

poll |

epoll |

| 最大文件描述符数 |

有限制(FD_SETSIZE, 通常1024) |

理论上无限制 |

无限制 |

| 效率随连接数增长 |

O(n), 线性下降 |

O(n), 线性下降 |

O(1), 几乎恒定 |

| 内核-用户空间数据拷贝 |

每次调用都拷贝全部fd集合 |

每次调用都拷贝全部fd集合 |

使用mmap共享内存, 避免拷贝 |

| 触发方式 |

水平触发(LT) |

水平触发(LT) |

支持LT和边缘触发(ET) |

| 内核实现 |

轮询所有fd |

轮询所有fd |

回调机制, 只关注就绪fd |

| 时间复杂度 |

O(n) |

O(n) |

O(1)(就绪列表) |

select 的问题就像在一个有上千个房间的酒店里,每次想知道哪些房间需要服务,管理员必须逐个敲门询问。而 epoll 则是在每个房间安装了一个门铃,当客人需要服务时按铃,管理员只在控制台查看哪些铃响了。

2. epoll 的核心设计思想

2.1 事件驱动架构

epoll 的核心思想是事件驱动(Event-Driven)。它不是主动轮询每个连接的状态,而是让内核在连接状态变化时通知应用程序。

这就像订报纸的两种方式:

- 轮询方式: 每天早上跑到报社问“今天有我的报纸吗?”

- 事件驱动: 订阅报纸,报社每天送到你家邮箱,你只需检查邮箱。

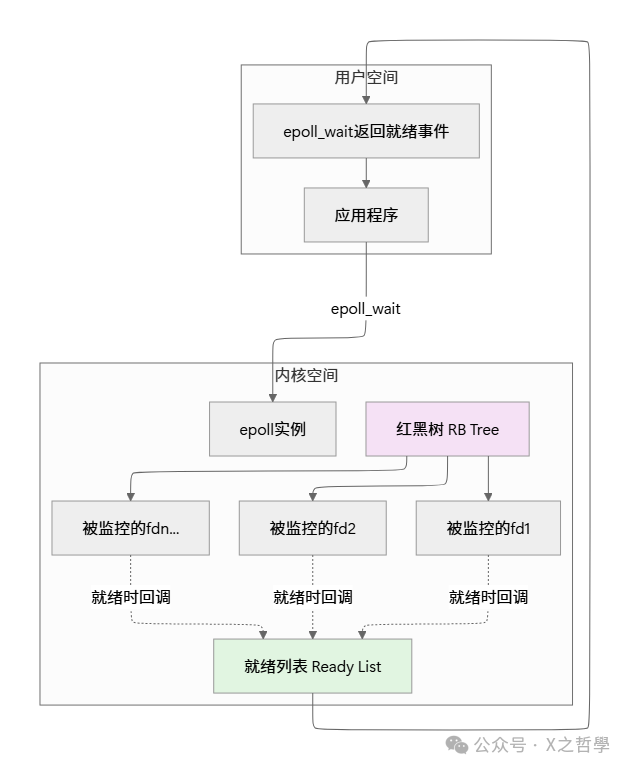

2.2 就绪列表(Ready List)机制

epoll 最巧妙的设计之一是维护一个就绪列表。当某个文件描述符(fd)就绪时,内核将其添加到这个列表中,应用程序只需从这个列表中获取就绪的fd,而不需要遍历所有监控的fd。

2.3 水平触发 vs 边缘触发

epoll 支持两种工作模式,这是理解其高级用法的关键:

水平触发(Level-Triggered, LT):

- 只要文件描述符处于就绪状态,每次调用

epoll_wait 都会报告。

- 类似于传感器:只要水位高于阈值,就一直发出警报。

- 默认模式,编程简单,不容易遗漏事件。

边缘触发(Edge-Triggered, ET):

- 只有当文件描述符状态发生变化时才会报告。

- 类似于按钮:只在按下(状态变化)时触发一次。

- 更高效,但需要正确处理,可能一次处理多个事件。

生活中的比喻:

- LT模式: 你的手机充电,只要电量低于20%,就一直显示低电量警告。

- ET模式: 你的门铃,只在有人按下的瞬间响一次。

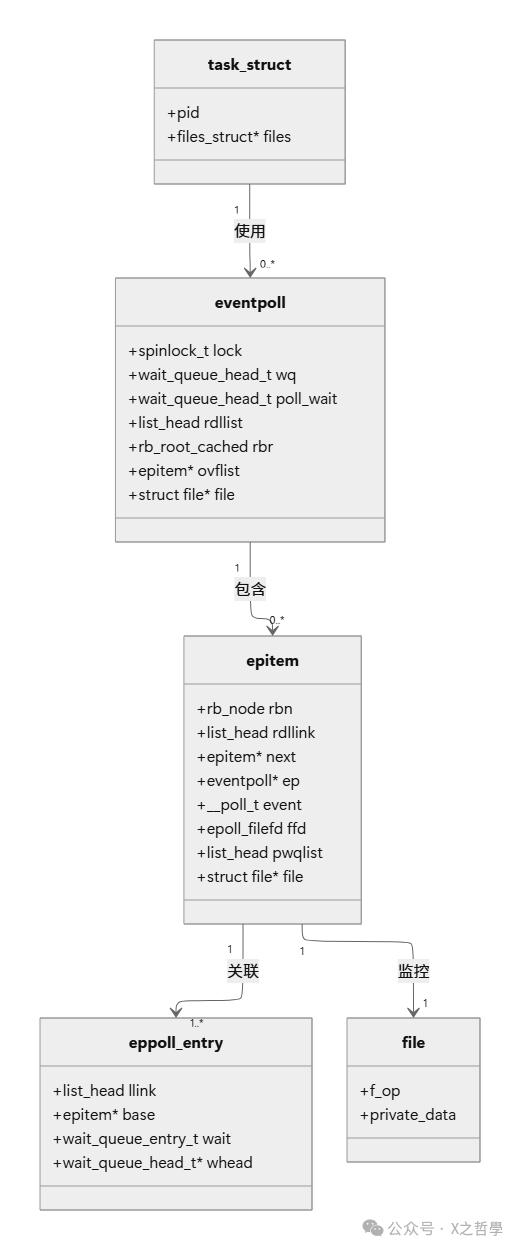

3. epoll 的核心数据结构

要真正理解 epoll,我们必须深入内核源码。以下是 epoll 的三个核心数据结构:

3.1 eventpoll 结构体

这是 epoll 实例的核心结构,每个 epoll_create 调用都会创建一个:

// Linux 内核源码: fs/eventpoll.c

struct eventpoll {

/* 保护该结构的锁 */

spinlock_t lock;

/* 等待队列, 用于epoll_wait的进程 */

wait_queue_head_t wq;

/* 用于file->poll的等待队列 */

wait_queue_head_t poll_wait;

/* 就绪列表: 存放就绪的fd */

struct list_head rdllist;

/* 红黑树的根节点, 存储所有被监控的fd */

struct rb_root_cached rbr;

/* 当向用户空间传递事件时, 用于链接就绪fd */

struct epitem *ovflist;

/* 创建eventpoll的user */

struct user_struct *user;

/* 对应的文件结构 */

struct file *file;

/* 用于优化循环检测 */

int visited;

struct list_head visited_list_link;

};

3.2 epitem 结构体

每个被监控的文件描述符对应一个 epitem:

struct epitem {

/* 红黑树节点 */

union {

struct rb_node rbn;

struct rcu_head rcu;

};

/* 用于链接到就绪列表 */

struct list_head rdllink;

/* 用于链接到ovflist */

struct epitem *next;

/* 该epitem所属的eventpoll */

struct eventpoll *ep;

/* 事件掩码, 保存用户感兴趣的事件 */

__poll_t event;

/* 文件描述符信息 */

struct epoll_filefd ffd;

/* 每个fd可链接到的多个事件 */

struct list_head pwqlist;

/* 对应的文件指针 */

struct file *file;

/* 用于向等待队列添加项目 */

struct callback {

void (*func)(struct eppoll_entry *);

struct eppoll_entry *base;

} cb;

};

3.3 eppoll_entry 结构体

这是 epoll 等待队列条目:

struct eppoll_entry {

/* 链接到epitem的pwqlist */

struct list_head llink;

/* 指向所属的epitem */

struct epitem *base;

/* 等待队列项 */

wait_queue_entry_t wait;

/* 等待队列头 */

wait_queue_head_t *whead;

};

3.4 数据结构关系图

4. epoll 的工作原理解析

4.1 三阶段生命周期

epoll 的工作可以分为三个阶段,让我们详细分析每个阶段:

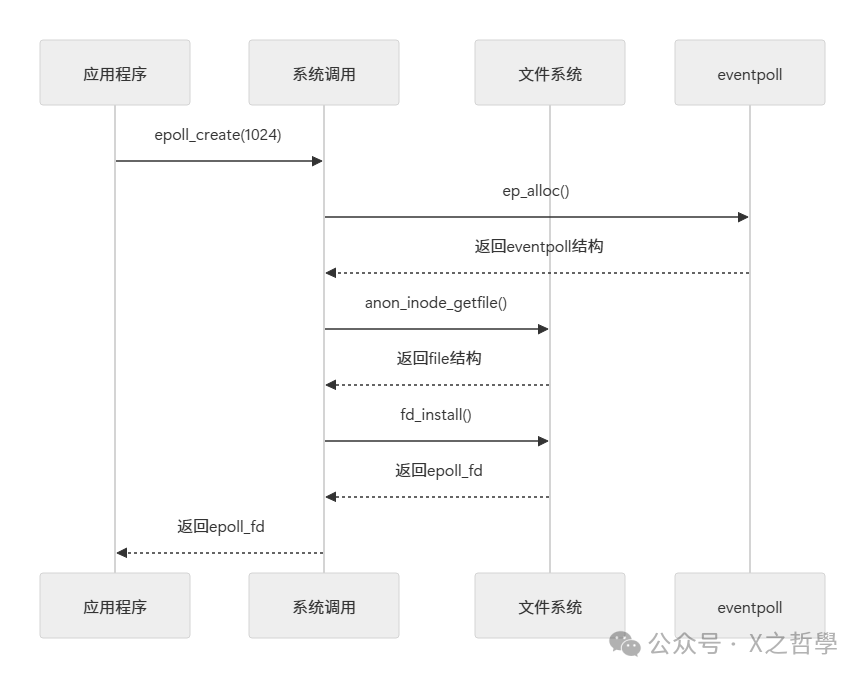

阶段1: 创建 epoll 实例(epoll_create)

int epoll_create(int size); // size参数在现代内核中已忽略, 但必须大于0

内核实现流程:

- 检查 size 参数是否大于 0

- 调用

ep_alloc() 分配并初始化 eventpoll 结构

- 分配一个匿名文件描述符, 将 eventpoll 绑定到该文件的 private_data

- 返回文件描述符

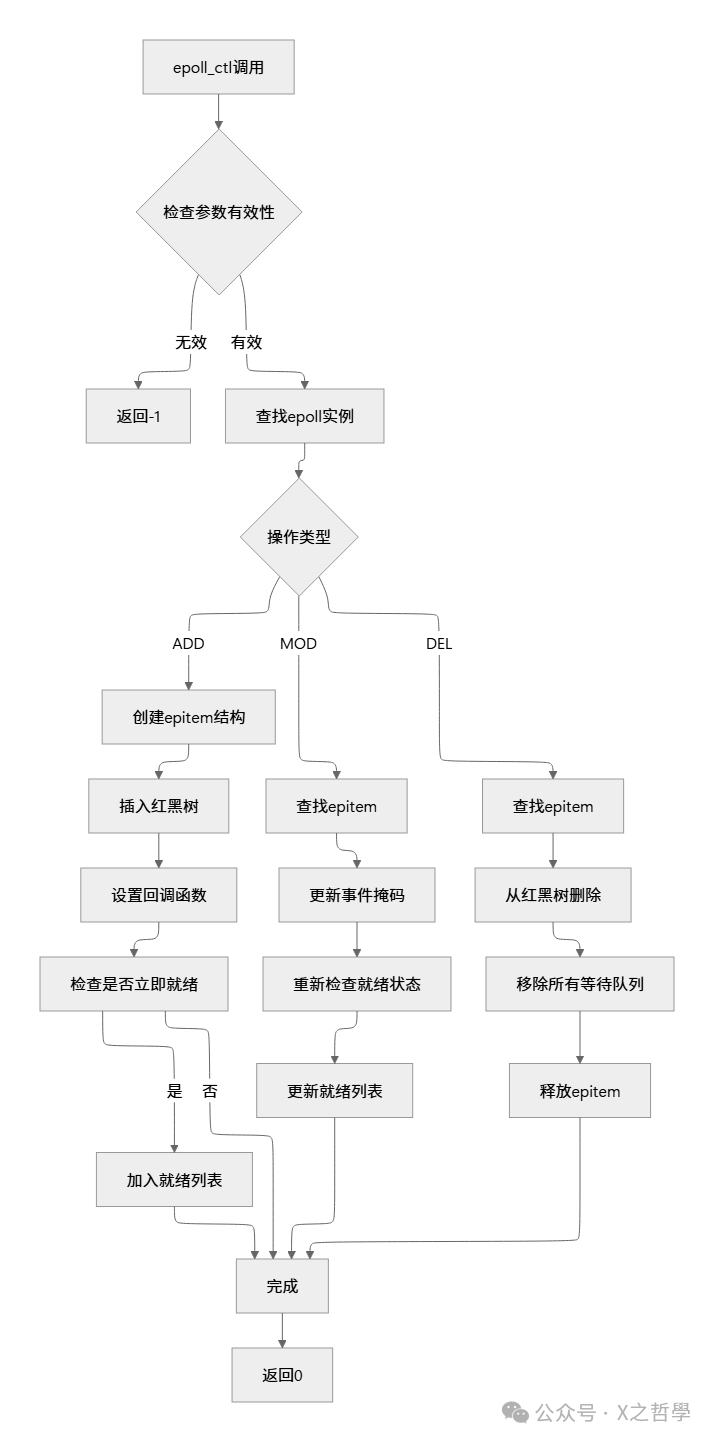

阶段2: 添加/修改监控项(epoll_ctl)

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

操作类型:

- EPOLL_CTL_ADD: 添加新的 fd 到监控列表

- EPOLL_CTL_MOD: 修改已监控 fd 的事件设置

- EPOLL_CTL_DEL: 从监控列表中删除 fd

以 EPOLL_CTL_ADD 为例的内核流程:

- 根据 epfd 找到对应的 eventpoll 结构

- 根据 fd 找到对应的 file 结构

- 创建 epitem 结构并初始化

- 将 epitem 插入红黑树

- 设置回调函数

ep_ptable_queue_proc

- 如果 fd 已经就绪, 立即将其加入就绪列表

阶段3: 等待事件(epoll_wait)

int epoll_wait(int epfd, struct epoll_event *events,

int maxevents, int timeout);

内核实现关键步骤:

- 检查参数有效性

- 调用

ep_poll():

- 如果就绪列表不为空, 直接拷贝事件到用户空间

- 如果为空且超时不为0, 将当前进程加入等待队列

- 调度出去, 等待被唤醒或超时

- 被唤醒后, 将就绪事件拷贝到用户空间

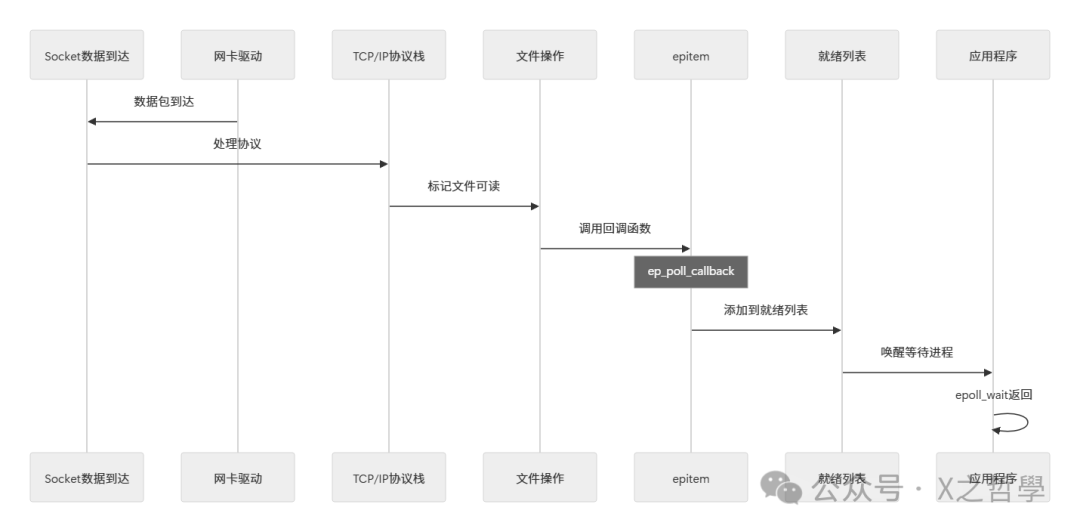

回调机制的触发流程:

4.2 回调机制: epoll 高效的核心

epoll 高效的关键在于它的回调机制。每个被监控的 fd 都会注册一个回调函数 ep_poll_callback()。当 fd 就绪时,内核网络栈会自动调用这个回调函数。

// 回调函数核心逻辑

static int ep_poll_callback(wait_queue_entry_t *wait, unsigned mode,

int sync, void *key)

{

struct epitem *epi = ep_item_from_wait(wait);

struct eventpoll *ep = epi->ep;

// 1. 将epi添加到就绪列表

list_add_tail(&epi->rdllink, &ep->rdllist);

// 2. 如果eventpoll正在等待, 唤醒它

if (waitqueue_active(&ep->wq))

wake_up_locked(&ep->wq);

// 3. 如果使用了边缘触发, 还需要检查其他条件

// ...

return 1;

}

为什么回调比轮询高效?

select/poll: 每次调用都需要遍历所有 fd, O(n) 时间复杂度。epoll: 只有就绪的 fd 才会触发回调, O(1) 添加到就绪列表。

5. 完整示例: epoll 服务器实现

让我们通过一个完整的 echo 服务器示例来理解 epoll 的实际使用:

5.1 基础服务器框架

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

#include <arpa/inet.h>

#include <sys/socket.h>

#include <sys/epoll.h>

#include <fcntl.h>

#include <errno.h>

#define MAX_EVENTS 1024

#define BUFFER_SIZE 4096

#define PORT 8080

// 设置非阻塞IO

static void set_nonblocking(int sockfd) {

int flags = fcntl(sockfd, F_GETFL, 0);

fcntl(sockfd, F_SETFL, flags | O_NONBLOCK);

}

int main() {

int listen_fd, epoll_fd;

struct sockaddr_in server_addr;

struct epoll_event ev, events[MAX_EVENTS];

// 1. 创建监听socket

listen_fd = socket(AF_INET, SOCK_STREAM | SOCK_NONBLOCK, 0);

if (listen_fd == -1) {

perror("socket");

exit(EXIT_FAILURE);

}

// 2. 设置地址重用

int reuse = 1;

setsockopt(listen_fd, SOL_SOCKET, SO_REUSEADDR, &reuse, sizeof(reuse));

// 3. 绑定地址

memset(&server_addr, 0, sizeof(server_addr));

server_addr.sin_family = AF_INET;

server_addr.sin_addr.s_addr = htonl(INADDR_ANY);

server_addr.sin_port = htons(PORT);

if (bind(listen_fd, (struct sockaddr*)&server_addr,

sizeof(server_addr)) == -1) {

perror("bind");

close(listen_fd);

exit(EXIT_FAILURE);

}

// 4. 开始监听

if (listen(listen_fd, SOMAXCONN) == -1) {

perror("listen");

close(listen_fd);

exit(EXIT_FAILURE);

}

printf("Server listening on port %d\n", PORT);

// 5. 创建epoll实例

epoll_fd = epoll_create1(0);

if (epoll_fd == -1) {

perror("epoll_create1");

close(listen_fd);

exit(EXIT_FAILURE);

}

// 6. 添加监听socket到epoll

ev.events = EPOLLIN | EPOLLET; // 边缘触发模式

ev.data.fd = listen_fd;

if (epoll_ctl(epoll_fd, EPOLL_CTL_ADD, listen_fd, &ev) == -1) {

perror("epoll_ctl: listen_fd");

close(listen_fd);

close(epoll_fd);

exit(EXIT_FAILURE);

}

// 7. 事件循环

while (1) {

int nfds = epoll_wait(epoll_fd, events, MAX_EVENTS, -1);

if (nfds == -1) {

perror("epoll_wait");

break;

}

for (int i = 0; i < nfds; i++) {

// 7.1 新连接到达

if (events[i].data.fd == listen_fd) {

handle_accept(listen_fd, epoll_fd);

}

// 7.2 客户端数据到达

else if (events[i].events & EPOLLIN) {

handle_client(events[i].data.fd, epoll_fd);

}

// 7.3 其他事件处理

else if (events[i].events & (EPOLLERR | EPOLLHUP)) {

handle_error(events[i].data.fd, epoll_fd);

}

}

}

// 清理

close(listen_fd);

close(epoll_fd);

return 0;

}

5.2 关键处理函数

// 处理新连接

void handle_accept(int listen_fd, int epoll_fd) {

struct sockaddr_in client_addr;

socklen_t addrlen = sizeof(client_addr);

struct epoll_event ev;

while (1) { // 边缘触发需要循环accept

int client_fd = accept4(listen_fd,

(struct sockaddr*)&client_addr,

&addrlen,

SOCK_NONBLOCK);

if (client_fd == -1) {

if (errno == EAGAIN || errno == EWOULDBLOCK) {

// 没有更多连接了

break;

} else {

perror("accept");

break;

}

}

printf("New connection from %s:%d\n",

inet_ntoa(client_addr.sin_addr),

ntohs(client_addr.sin_port));

// 添加到epoll监控

ev.events = EPOLLIN | EPOLLET | EPOLLRDHUP;

ev.data.fd = client_fd;

if (epoll_ctl(epoll_fd, EPOLL_CTL_ADD, client_fd, &ev) == -1) {

perror("epoll_ctl: client_fd");

close(client_fd);

}

}

}

// 处理客户端数据

void handle_client(int client_fd, int epoll_fd) {

char buffer[BUFFER_SIZE];

ssize_t n;

while (1) { // 边缘触发需要循环读取

n = read(client_fd, buffer, sizeof(buffer));

if (n > 0) {

// 回显数据

write(client_fd, buffer, n);

} else if (n == 0) {

// 连接关闭

printf("Client %d disconnected\n", client_fd);

close(client_fd);

epoll_ctl(epoll_fd, EPOLL_CTL_DEL, client_fd, NULL);

break;

} else if (n == -1) {

if (errno == EAGAIN || errno == EWOULDBLOCK) {

// 数据读取完毕

break;

} else {

// 真实错误

perror("read");

close(client_fd);

epoll_ctl(epoll_fd, EPOLL_CTL_DEL, client_fd, NULL);

break;

}

}

}

}

6. 性能优化与最佳实践

6.1 epoll 工作模式选择

| 场景 |

推荐模式 |

理由 |

| 常规应用 |

水平触发(LT) |

编程简单, 不容易出错 |

| 高性能服务器 |

边缘触发(ET) |

减少epoll_wait调用次数 |

| 需要精确控制 |

边缘触发(ET) |

避免水平触发重复通知 |

| 传统代码迁移 |

水平触发(LT) |

兼容select/poll行为 |

6.2 惊群问题(Thundering Herd)

问题描述: 多个进程/线程同时监听同一个端口, 当新连接到达时, 所有进程都被唤醒, 但只有一个能处理连接, 其他进程白白浪费CPU。

解决方案:

- SO_REUSEPORT(Linux 3.9+): 内核级别负载均衡

- EPOLLEXCLUSIVE(Linux 4.5+): 只唤醒一个等待的epoll实例

- 单进程accept, 然后分发连接给工作进程

// 使用EPOLLEXCLUSIVE避免惊群

ev.events = EPOLLIN | EPOLLEXCLUSIVE;

epoll_ctl(epoll_fd, EPOLL_CTL_ADD, listen_fd, &ev);

6.3 边缘触发模式的正确使用

必须注意的要点:

- 使用非阻塞IO

- 循环读取/写入直到EAGAIN

- 正确处理缓冲区

// 边缘触发读取的模板

void et_read(int fd) {

char buffer[1024];

ssize_t n;

while (1) {

n = read(fd, buffer, sizeof(buffer));

if (n > 0) {

// 处理数据

process_data(buffer, n);

} else if (n == 0) {

// 连接关闭

close_connection(fd);

break;

} else if (n == -1) {

if (errno == EAGAIN || errno == EWOULDBLOCK) {

// 数据已读完

break;

} else {

// 真实错误

handle_error(fd);

break;

}

}

}

}

7. 调试与监控工具

7.1 系统调用跟踪

# 使用strace跟踪epoll调用

strace -e epoll_create,epoll_ctl,epoll_wait ./epoll_server

# 统计epoll_wait调用次数和时间

strace -c -e epoll_wait ./epoll_server

# 实时查看epoll活动

strace -p $(pidof epoll_server) -e epoll_wait

7.2 性能分析工具

# 使用perf分析性能瓶颈

perf record -g ./epoll_server

perf report

# 查看epoll相关内核函数

perf probe --add 'ep_poll_callback'

perf record -e probe:ep_poll_callback ./epoll_server

7.3 /proc 文件系统监控

# 查看进程打开的文件描述符

ls -la /proc/$(pidof epoll_server)/fd/

# 查看epoll实例信息

cat /proc/$(pidof epoll_server)/fdinfo/<epoll_fd>

# 监控系统epoll使用情况

grep epoll /proc/slabinfo

7.4 自定义调试信息

在代码中添加统计信息:

// 在eventpoll结构中添加统计字段

struct eventpoll_stats {

unsigned long wait_calls; // epoll_wait调用次数

unsigned long events_returned; // 返回的事件总数

unsigned long callback_calls; // 回调调用次数

unsigned long max_ready; // 单次返回的最大事件数

};

// 定期打印统计信息

void print_epoll_stats(int epoll_fd) {

struct epoll_event events[10];

int n = epoll_wait(epoll_fd, events, 10, 0);

if (n > 0) {

// 有事件, 重新加入监控

for (int i = 0; i < n; i++) {

// 重新添加到epoll

}

}

}

8. epoll 的局限性及替代方案

8.1 epoll 的局限性

| 局限性 |

说明 |

影响 |

| 仅Linux支持 |

非跨平台解决方案 |

无法直接移植到其他Unix系统 |

| 文件描述符限制 |

受系统最大文件描述符数限制 |

需要调整ulimit |

| 内存使用 |

每个fd需要内核数据结构 |

大量连接时内存消耗明显 |

| 水平触发默认 |

默认模式可能导致性能问题 |

需要显式设置边缘触发 |

8.2 替代方案比较

| 技术 |

平台 |

特点 |

适用场景 |

| epoll |

Linux |

高性能, 就绪列表, 回调机制 |

Linux高性能服务器 |

| kqueue |

FreeBSD, macOS |

类似epoll, 更通用的事件类型 |

BSD系系统 |

| IOCP |

Windows |

异步IO, 完成端口模型 |

Windows高性能服务器 |

| io_uring |

Linux 5.1+ |

新一代异步IO, 零拷贝, 更高效 |

极致性能需求 |

8.3 未来趋势: io_uring

io_uring 是 Linux 5.1 引入的新异步IO接口, 相比 epoll 有显著优势:

// io_uring 简单示例

#include <liburing.h>

struct io_uring ring;

io_uring_queue_init(32, &ring, 0);

// 提交读请求

struct io_uring_sqe *sqe = io_uring_get_sqe(&ring);

io_uring_prep_read(sqe, fd, buf, size, offset);

io_uring_submit(&ring);

// 等待完成

struct io_uring_cqe *cqe;

io_uring_wait_cqe(&ring, &cqe);

io_uring 的优势:

- 真正的异步IO, 减少系统调用

- 支持更多操作类型

- 零拷贝能力

- 批处理提交和完成

9. 实战中的常见问题与解决方案

9.1 问题: epoll_wait 返回 EINTR

原因: 被信号中断

解决方案:

while (1) {

int nfds = epoll_wait(epoll_fd, events, MAX_EVENTS, timeout);

if (nfds == -1) {

if (errno == EINTR) {

// 被信号中断, 继续等待

continue;

}

perror("epoll_wait");

break;

}

// 处理事件...

}

9.2 问题: 连接泄漏

原因: 没有正确关闭文件描述符

检测方法:

# 监控进程的fd数量

watch -n 1 'ls /proc/$(pidof server)/fd | wc -l'

解决方案:

// 统一管理所有连接

struct connection {

int fd;

time_t last_active;

// 其他状态...

};

// 定期检查并关闭空闲连接

void cleanup_idle_connections(struct connection *conns, int max_conns,

int idle_timeout) {

time_t now = time(NULL);

for (int i = 0; i < max_conns; i++) {

if (conns[i].fd != -1 &&

now - conns[i].last_active > idle_timeout) {

printf("Closing idle connection %d\n", conns[i].fd);

close(conns[i].fd);

epoll_ctl(epoll_fd, EPOLL_CTL_DEL, conns[i].fd, NULL);

conns[i].fd = -1;

}

}

}

9.3 问题: 性能突然下降

可能原因及排查步骤:

- 检查系统负载:

top, htop

- 监控网络:

netstat -s, ss -s

- 检查epoll统计: 自定义统计或内核trace

- 分析内存使用:

vmstat 1, free -m

- 检查日志: 系统日志和应用日志

10. 总结

10.1 epoll 核心思想总结

经过深入分析, 我们可以将 epoll 的核心思想总结为以下几点:

- 事件驱动, 非轮询: 内核在fd就绪时主动通知, 而非应用程序轮询。

- 就绪列表机制: 维护就绪fd列表, 避免遍历所有监控的fd。

- 红黑树高效管理: 使用红黑树组织监控的fd, 保证O(log n)的查找效率。

- 共享内存减少拷贝: 使用mmap共享内存, 避免内核-用户空间数据拷贝。

- 灵活触发模式: 支持LT和ET两种模式, 适应不同场景。

10.2 最佳实践清单

根据多年实践经验, 以下是最佳实践建议:

| 实践领域 |

具体建议 |

理由 |

| 模式选择 |

默认使用LT, 性能关键使用ET |

LT更安全, ET更高效 |

| 非阻塞IO |

始终使用非阻塞socket |

避免阻塞影响其他连接 |

| 边缘触发处理 |

循环读写直到EAGAIN |

确保读取所有可用数据 |

| 内存管理 |

合理设置缓冲区大小 |

避免内存浪费或频繁分配 |

| 错误处理 |

检查所有系统调用返回值 |

及时发现和处理问题 |

| 资源清理 |

正确关闭所有文件描述符 |

避免文件描述符泄漏 |

| 监控统计 |

添加运行统计信息 |

便于性能分析和调试 |

| 连接管理 |

实现连接超时机制 |

防止资源被长时间占用 |

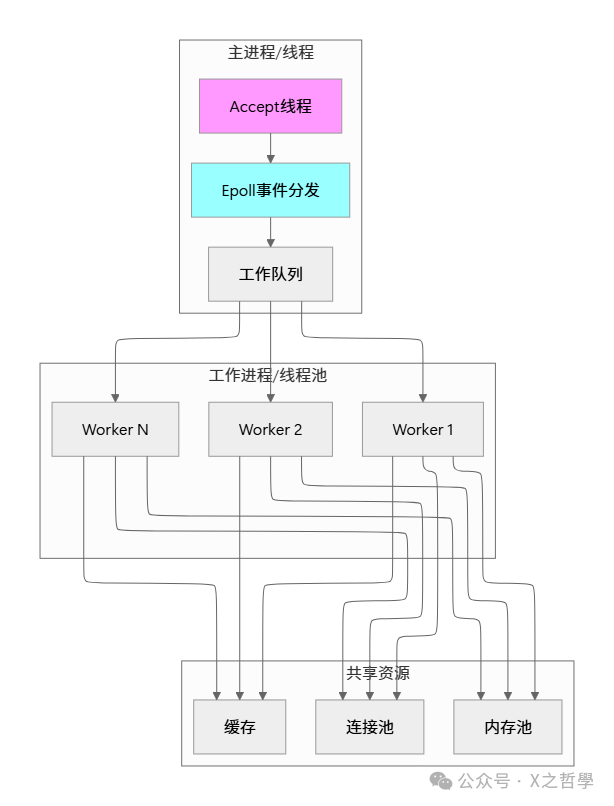

10.3 架构设计建议

对于高并发服务器架构, 建议采用以下模式:

本文深入探讨了Linux epoll机制,从应用场景到内核实现,旨在帮助开发者构建高性能网络服务。想了解更多关于系统架构设计和网络编程的深度内容,欢迎访问云栈社区与更多技术同仁交流探讨。