最近,团队启动了一个 从 0 到 1 的 AI 产品 项目。老板给出的 Deadline 很明确:两个月内必须能接入现有业务。当我被抽调进项目组时,时间仅剩 5 周。

技术栈已经敲定:Next.js + TypeScript + Tailwind + shadcn + AI Coding。

而我面临的问题是:我是一名后端工程师,几乎没有前端开发经验。坦白说,如果没有 AI 编程工具的加持,这个项目我一个人根本无法推进。

但正是借助 Claude + Cursor 的组合,我第一次深刻体会到什么是 “十几分钟干完我一天的工作” 的开发效率。

为什么 Next.js 成为了创业公司的首选框架?

你一定听过类似的观点(我是在社交媒体上看到的):

如果你的用户量已经大到需要考虑高并发和负载均衡,那你已经不需要自己操心这些了。

这句话,简直是为创业公司(Startup)量身定做的。在产品初期,我们追求的不是完美的、可扩展性极高的架构,而是:能够最快上线的、可用的真实产品。

因此,我们选择了 Next.js。你可以把它理解为:前端 + 后端 + API + SSR + 部署一体化 的全栈框架。

一个更形象的比喻是:它将 Spring Boot、Vue、Nginx、网关和 SSR 的能力,压缩到了一个仓库里。在 MVP(最小可行产品)阶段,速度远大于一切。

AI 编程是如何将“不可能”变为“刚刚好”的?

我没有前端基础,但我拥有强大的“外挂”:Cursor、Claude 4.5 以及之前用过的 Trae。

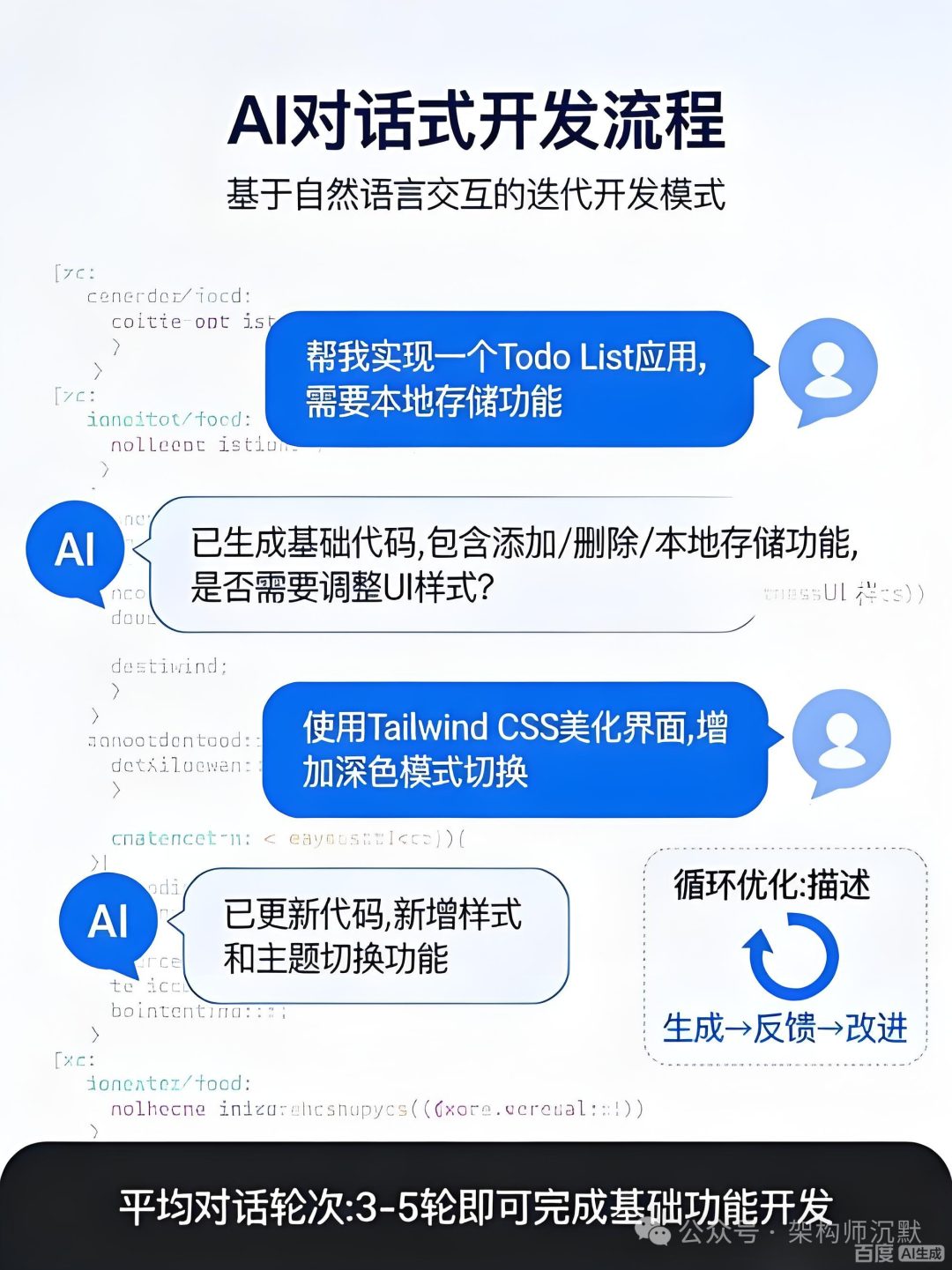

真实的开发体验是这样的:Claude 负责生成 UI 代码,我负责判断“这个产出是不是垃圾”。在这个过程中,你会发现一个既残酷又令人兴奋的事实:

AI 编写代码的速度,永远比你制造技术债务的速度还要快。

于是,你便进入了一种真实的“氛围式编码”(Vibe Coding)状态:

需求 → AI生成 → 能跑 → 先上线 → 再重构 → 再堆需求 → 再优化

这并非不专业,而是快速迭代的现实。在 前端框架/工程化 的实践中,拥抱工具以提升效率是明智的选择。

5 周极限开发时间线

再次强调,我们不是在写一个演示 Demo,而是要开发一个 能接入公司现有业务流的真实 AI 产品。

| 周次 |

核心任务 |

| Week 1 |

项目初始化、Next.js+TS 快速学习、设计表结构、搭建 MySQL、实现基础 CRUD |

| Week 2 |

产品需求文档(PRD)定稿,进行核心数据模型设计 |

| Week 3 |

完成核心功能模块开发,并进行架构讲解与评审 |

| Week 4 |

优化产品首页、统一登录流程、完成初步部署 |

| Week 5 |

实现鉴权逻辑、处理 Token 与 Cookies、进行核心业务流程联调 |

5 周之后,产品真的跑起来了。

这套技术栈为什么能撑住快速迭代?

前端技术栈

Next.js 14 + React 18 + TypeScript + Zustand + Tailwind + AntD + Radix

这个组合可以理解为:快速开发(AntD) + 无障碍与规范(Radix) + 极致定制自由(Tailwind) 的混合体。

把它们混用,短期内开发体验非常爽快,但长期来看会带来维护风险。然而对于 MVP 来说,这无疑是 性价比最高的技术选型。

后端技术栈

Next.js API Routes

+ Prisma

+ MySQL

+ Redis

+ Zod

+ Winston

使用这套栈,你会第一次感受到:前端代码能直接、安全地操作数据库是一种什么体验。这在传统的 Java/Spring 世界里近乎“异端”,但在需要快速验证的 Startup MVP 中,却是救命稻草。像 MySQL 和 Redis 这样的成熟组件,为快速搭建稳定后端提供了坚实基础。

踩坑记录:那些让人“头痛”的瞬间

在高速开发中,我们也遇到了不少坑,这里分享几个印象深刻的:

- Next.js Middleware 的限制:在

middleware.ts 中无法直接 import Prisma Client,因为 Edge Runtime 不支持某些 Node.js API,导致运行时错误。

- 静态渲染与动态 API 的冲突:在构建时,Next.js 会对静态生成页面中调用的动态 API 发出警告,需要仔细规划数据获取策略。

- Ant Design 版本兼容性:Ant Design v5 向 v6 的迁移,以及实验性版本

antd-x 的兼容性问题,带来了不少适配成本。

- 日志查看不便:在容器化部署后,查看应用日志只能通过容器标准输出,定位问题效率较低。

关于 AI 产品架构与语言选型的思考

我们现在看到的 AI 产品,其核心流程本质上是:

用户 → System Agent → 路由 → 专用 Agent → 调用 Tool → 访问 LLM → 返回结果

在这个过程中,MCP(Model Context Protocol)解决了 LLM 如何标准化调用外部工具 的问题;而 A2A(Agent-to-Agent)通信则解决了 多个 Agent 之间如何协作与隔离上下文 的难题。未来的应用可能不再是一个单一程序,而是一个 协同工作的 Agent 集群。对 人工智能 领域趋势的洞察,有助于我们设计更灵活的架构。

在 AI 产品开发中,Python 和 TypeScript 有着清晰的分工:

| 领域 |

Python 的角色 |

TypeScript 的角色 |

| 模型训练 |

绝对王者 |

几乎没有 |

| 模型服务 |

核心提供者 |

主要消费者 |

| 产品迭代 |

相对较慢 |

速度极快 |

| 部署复杂度 |

较重(环境、依赖) |

较轻(容器化简单) |

| 用户界面 |

生态较弱 |

王者级别(React生态) |

用一句话总结:Python 负责“锻造”AI 能力,TypeScript 负责“包装”并交付给用户。

总结:Vibe Coding 的真相与启示

我必须说一句实话:AI 编程工具让一个没有前端经验的后端工程师,能够在 5 周内做出一个可接入业务的真实 AI 产品。

但与此同时,它也带来了新的挑战:技术债务堆积的速度,可能比你添加新功能的速度还要快。

我们真正需要对抗的,或许不是 AI 本身,而是内心深处对 “我只熟悉我原有的技术栈” 的执念。

这 5 周,是我职业生涯中 技术视野成长最快的一段时间。因为我终于明白了:

编程语言只是工具,

交付速度是早期产品的信仰,

而拥抱 AI 辅助开发,是我们必须跳进去的时代浪潮。

这次经历让我深刻感受到全栈快速开发的魅力与挑战。如果你也对 Next.js 全栈开发或 AI 应用实践感兴趣,欢迎到 云栈社区 与其他开发者交流探讨。