TranslateGemma 是 Google 发布的一套开源翻译模型,定位为“专为翻译优化”的 Gemma 系列变体,非常适合在本地或自建服务中进行高质量的机器翻译。

其离线运行的核心优势在于,能够将敏感数据完全留在本地处理,这使其成为翻译内部文档、合同或产品路线图等保密材料的理想选择。

根据社区反馈,TranslateGemma 的翻译能力表现突出:

- 性能超越体型:基准测试表明,即使是仅40亿参数(4B)的小型版本,其翻译质量也能媲美甚至超越参数量大得多的基座模型(如12B/27B)。

- 广泛的语言支持:该模型针对55种语言进行了特别优化。用户报告称,对于日语、韩语等非英语语言,其翻译结果非常自然流畅,效果有时优于 Google 翻译和 Gemini Pro。

- 多模态能力:它继承了 Gemma 的多模态特性,可以直接识别并翻译图片中的文字,在 Vistra 等视觉翻译基准测试中表现优异。

想要在个人电脑上运行这个强大的翻译模型,主要有两种便捷的方式:通过 Ollama 命令行工具,或使用 LM Studio 图形化界面。对于大多数用户而言,LM Studio 的图形化操作更加直观友好。

首先,访问 lmstudio.ai 官网下载并安装 LM Studio 软件。

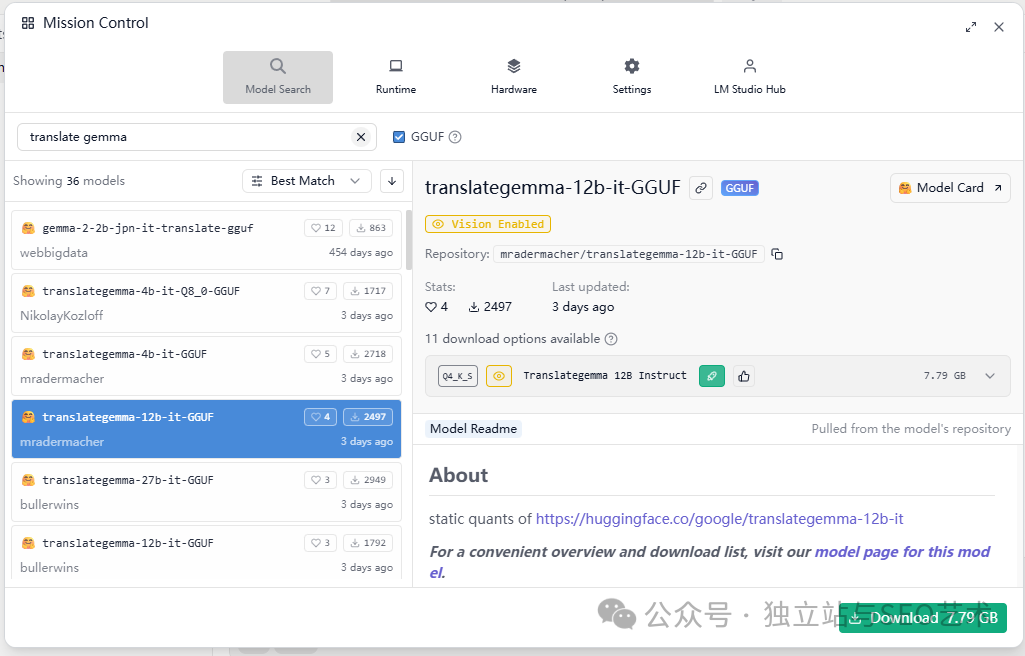

安装完成后打开软件,在 “Model Search” 页面中搜索 “translate gemma”。你会看到社区提供的多个量化版本(GGUF格式),请根据自己电脑的硬件性能(尤其是显存大小)选择合适的模型进行下载,例如参数较少的 4B 版本对硬件更友好。

模型下载完成后,切换到聊天界面,加载你下载的 TranslateGemma 模型,即可开始畅快地使用这款免费、精准且支持多语言的本地翻译工具了。

如果你在部署过程中遇到问题,或想了解更多开源模型的最佳实践,可以到 开源实战 板块查找相关指南。这种将前沿模型便捷地带到本地的实践,正是当前 智能 & 数据 & 云 领域的重要趋势之一。

That‘s it.

写出更好的about us 让谷歌和AI更懂你

欢迎就本地模型部署的更多技巧,在 技术文档 或 云栈社区 进行深入的技术讨论。 |