提起AI编程助手,你能想到什么?是GitHub Copilot、Cursor,还是Tabnine?这些工具我早就用过,它们确实能在写代码时帮上忙,比如补全代码、生成函数片段。但说句实话,用久了总感觉差点意思,就像一个只会听指令打字的实习生,能省些力气,但真正的思考和复杂任务还得自己来。

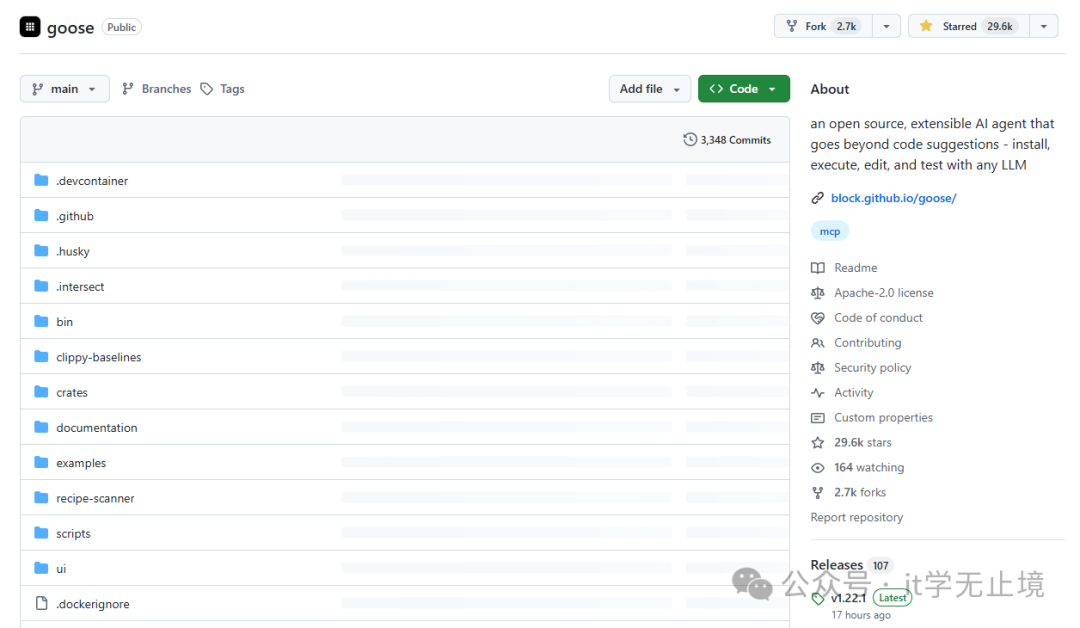

直到上周,我在GitHub闲逛时,偶然发现了一个名叫 Goose 的项目,简介瞬间抓住了我的眼球:“一个开源的、可扩展的Rust写的AI代理,它超越了代码建议——可以使用任何大语言模型(LLM)进行安装、执行、编辑和测试。”

这描述让我愣住了。这听起来不是一个简单的代码补全工具,而是一个能真正“动手”干活的智能代理!好奇心驱使下,我决定亲自试试这个用Rust写的“怪物”到底有多厉害。

实际体验:它不只是写代码,而是在“执行”任务

说实话,刚开始我没抱太大期望,毕竟市面上宣称“智能”的工具太多了。但安装好Goose后的一次简单尝试,就彻底改变了我的看法。

我随口对它说了句:“帮我安装并配置一个React项目,使用Vite构建,加上TypeScript和Tailwind CSS。”

然后,令人惊讶的事情发生了。它真的开始“干活”了!我全程旁观,手指没碰一下键盘:

- 它先自动检查环境,发现没有Node.js,于是自行下载安装。

- 接着运行

npm create vite@latest 命令,并自动完成一系列交互确认。

- 然后准确安装TypeScript和Tailwind CSS的相关依赖包。

- 最后,它还顺手配置好了

tsconfig.json 和 tailwind.config.js 文件。

整个过程不到三分钟,一个配置完善的现代化React项目就搭建完毕。那一刻我意识到,这哪里是AI助手?这分明是雇了一个全栈开发实习生!

深入原理:Rust与工具化架构的精妙设计

作为一个开发者,惊喜过后自然想扒开看看它的内部构造。打开仓库源码,第一眼就看到它是由Rust编写的。在人工智能工具普遍采用Python或TypeScript的当下,这个选择很独特,但也非常聪明。

仔细想想,一个AI代理需要频繁执行系统命令、处理文件IO、管理子进程,这些正是Rust的强项——极高的执行效率、出色的并发处理能力和严格的内存安全保障,能确保复杂任务下的稳定运行,不会因为一个小错误就导致整个进程崩溃。

它的核心架构是一个“工具路由器”(ToolRouter)。Goose将各种操作抽象成独立的“工具”(Tool),例如:

- 安装依赖的工具

- 执行Shell命令的工具

- 编辑文件内容的工具

- 运行测试用例的工具

- 查看日志输出的工具

而LLM(如GPT-4、Claude等)则扮演“大脑”的角色,负责理解你的自然语言指令,然后动态地规划、选择并组合这些工具,一步步完成最终目标。这种清晰的分层设计,既保证了灵活性,又让每一步操作都可控、可解释。

一周深度使用:那些让我直呼“爽快”的特性

将Goose集成到日常开发流程中使用一周后,我发现了它几个远超普通代码助手的优势:

1. 任务执行范围极广

传统的AI助手大多局限于在编辑器内生成代码片段。而Goose能干的事情多得多:

- 安装依赖、配置本地或远程开发环境。

- 执行构建、打包、部署等命令和脚本。

- 按照要求编辑、重构多个文件。

- 运行测试套件并分析结果。

- 查看和分析应用日志。

- 甚至能完成从代码到部署上线的完整流程。

2. 支持任何LLM,拒绝厂商绑定

这是Goose最让我欣赏的设计之一。它本身不提供模型,而是作为一个“执行层”,可以对接任何你喜欢的LLM。你只需要在配置文件中指定即可,例如使用OpenAI的GPT-4:

[llm]

provider = "openai"

model = "gpt-4"

api_key = "your-api-key-here"

或者使用本地的Ollama运行Llama 3:

[llm]

provider = "ollama"

model = "llama3"

这意味着你完全可以根据需求、预算和隐私要求自由选择大脑,不会被任何一家服务商绑架。

3. 强大的可扩展性

Goose“一切皆工具”的设计理念,让它的扩展变得异常简单。你可以轻松地为它添加自定义工具,封装任何你想要的操作,比如调用内部API、操作特定数据库、触发CI/CD流程等。以下是一个简单的工具定义示例:

#[derive(Debug, Serialize, Deserialize)]

pub struct MyCustomTool {

pub name: String,

}

impl Tool for MyCustomTool {

fn execute(&self, input: &str) -> Result<String, String> {

// 在这里实现你的自定义逻辑

// 例如:调用某个特定API,处理数据等

Ok("自定义工具执行成功!".to_string())

}

}

4. Rust带来的性能优势

我曾尝试让Goose处理一个相对复杂的任务:“搭建一个微服务原型,包含3个Node.js后端服务、1个React前端应用、1个Nginx网关,并用Docker容器化。”

得益于Rust的高效执行,Goose快速协调了安装、初始化、配置、编写Dockerfile等一系列操作,其执行速度远超用Python编写的类似代理,几乎没有明显的延迟感。

客观看待:目前存在的挑战与注意事项

当然,世上没有完美的工具。经过一周的使用,我也发现了一些需要适应和注意的地方:

1. 初始配置有一定门槛

你需要自行准备LLM的API密钥,理解其配置文件的格式,并对它的“工具”系统有一个基本概念。这对于完全新手来说,可能需要花点时间摸索。不过,一旦配置完成,后续使用就非常顺畅了。

2. 效果依赖于所选LLM的能力

Goose的“智能”程度很大程度上取决于背后LLM的强弱。使用GPT-4、Claude-3等顶级模型时,任务分解和工具调用非常精准;但如果使用能力较弱的小模型,则可能出现指令理解偏差或规划错误。这很合理,毕竟“大脑”决定了上限。

3. 适用场景需要区分

对于行内代码补全、函数片段生成这类极其简单快速的需求,GitHub Copilot这类工具可能响应更快。Goose的优势在于处理多步骤、跨文件、涉及系统操作的复杂任务。最佳实践可能是将它们结合使用:轻量补全用Copilot,复杂自动化用Goose。

思考:为什么Goose代表了AI编程的一个新方向?

作为一个有多年经验的开发者,我目睹了AI编程工具从简单的代码补全发展到今天的智能代理。Goose让我清晰地看到一个趋势:未来的AI在编程中的角色,不应仅仅是“助手”(Assistant),而应该是能够自主执行任务的“代理”(Agent)。

助手只能在你写作时提供建议,而代理能直接为你完成从构思到部署的整条工作流。你不需要再事无巨细地敲打每一条命令,而是可以描述你的目标,让AI代理去思考并执行具体的步骤。

Goose正是这个方向的优秀实践。它通过Rust保证了执行效能与稳定性,通过工具化架构实现了强大的可扩展性,通过开放的多LLM支持赋予了用户极大的灵活性。这三点让它从一个玩具变成了一个真正有潜力进入生产工作流的实用工具。

总结

使用Goose近一个月,它实实在在地改变了我的部分工作模式。我不再需要手动记忆和输入一长串环境配置命令,不再需要繁琐地重复搭建项目骨架,可以将更多精力集中在架构设计、性能优化和业务逻辑这些更具创造性的工作上。

这绝非偷懒,而是对开发效率的实质性解放。如果你也对提升开发自动化水平感兴趣,厌倦了只能补全代码的“助手”,那么强烈建议你试试这个名为Goose的开源AI代理。它会让你对“AI编程”有全新的认识。

项目完全开源,地址是:https://github.com/block/goose 。你可以在云栈社区这样的开源实战技术论坛找到更多类似的优质项目和深度讨论。不妨现在就动手尝试,看看这个Rust驱动的智能伙伴,能为你带来多少惊喜。