wechat-article-exporter 是一款强大的在线工具,专为有批量下载需求的微信公众号运营者或内容创作者设计。它不仅能帮你将公众号文章完整地保存下来,还支持导出评论、阅读量等互动数据,并提供了 HTML、Markdown、Word 等多种格式选项,确保排版样式完美还原。

其主要特性包括:

- 公众号搜索与添加:支持通过关键字搜索并添加目标公众号。

- 多格式导出:支持导出 HTML、JSON、Excel、Txt、Markdown、Word(内测中)格式。其中 HTML 格式会打包图片和样式文件,能够 100% 还原文章的原生排版。

- 数据缓存与过滤:缓存文章列表以减少接口请求,支持按作者、标题、发布时间、原创标识、所属合集等条件进行文章筛选。

- 合集下载:可以按专题合集批量下载文章。

- 互动数据抓取:支持导出评论、评论回复、阅读量、转发量等数据(需通过抓包获取 credentials 信息)。

- 多种部署方式:支持 Docker 部署、Cloudflare 部署。

- 开放 API:提供 API 接口供开发者集成使用。

官方提供的在线体验地址为:https://down.mptext.top/dashboard/account

安装与部署

推荐使用 Docker Compose 进行部署,配置简单,易于管理。创建一个 docker-compose.yml 文件,内容如下:

services:

wechat-article-exporter:

image: ghcr.io/wechat-article/wechat-article-exporter:latest

container_name: wechat-article-exporter

ports:

- 3000:3000

volumes:

- ./data:/app/.data

restart: always

保存后,在文件所在目录执行 docker-compose up -d 命令即可启动服务。

使用教程

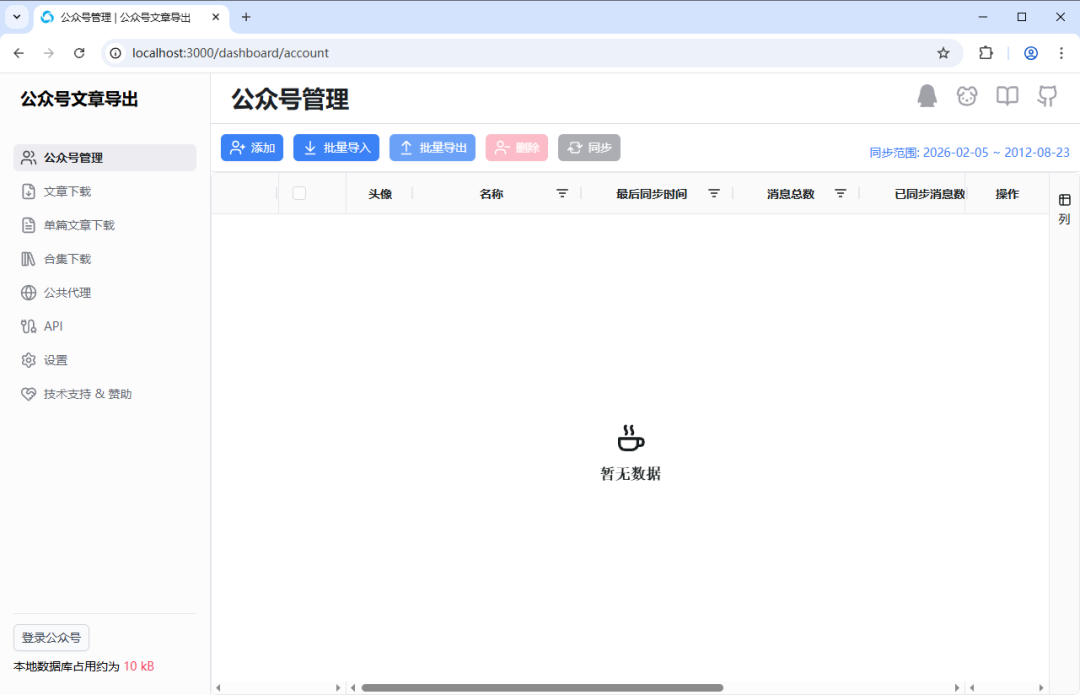

1. 访问管理界面

服务启动后,在浏览器中输入 http://你的NAS或服务器IP:3000 即可访问管理后台。

访问提示:如果部署在局域网内的 NAS 上,本地电脑直接访问可能会遇到问题。对于 Windows 用户,可以使用 netsh 工具配置端口转发,将本地端口映射到 NAS。具体命令如下(请将示例 IP 替换为你自己的 NAS IP):

# 查看所有转发规则

netsh interface portproxy show all

# 添加一个 3000 端口映射

netsh interface portproxy add v4tov4 listenaddress=127.0.0.1 listenport=3000 connectaddress=192.168.31.90 connectport=3000

# 删除 3000 映射

netsh interface portproxy delete v4tov4 listenaddress=127.0.0.1 listenport=3000

配置完成后,即可通过浏览器访问 http://localhost:3000 来打开管理界面。

2. 登录微信公众号

点击界面左下角的 “登录公众号” 按钮,会弹出一个二维码。

使用手机微信扫描此二维码并确认登录(需要一个已注册的公众号管理员账号)。登录成功后,界面左下角会显示当前账号的信息。

3. 添加与管理公众号

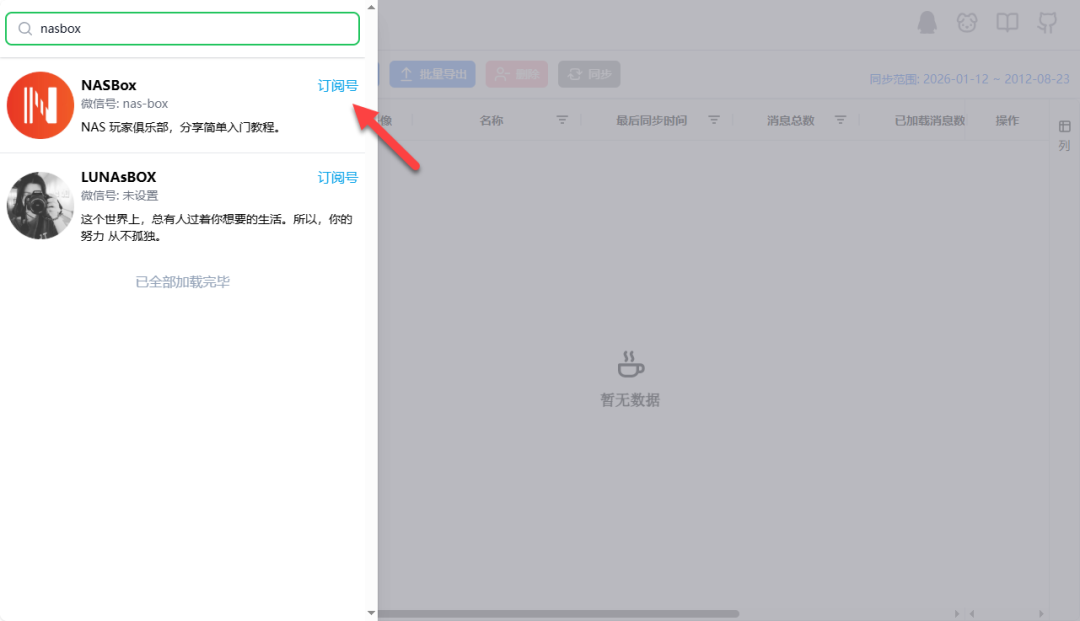

点击“公众号管理”页面右上角的 “添加” 按钮。

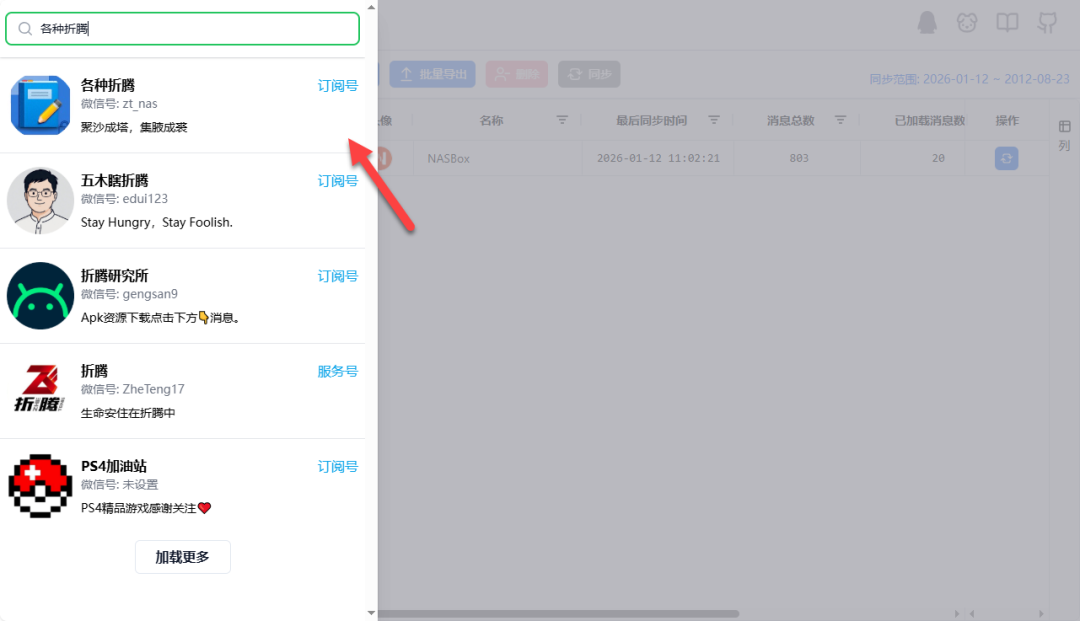

在弹出的搜索框中,输入你想下载文章的公众号名称或关键字进行搜索。

不仅限于自己的公众号,其他公开的公众号同样可以添加(例如,可以尝试搜索“各种折腾”,这是一位分享NAS相关内容的博主)。

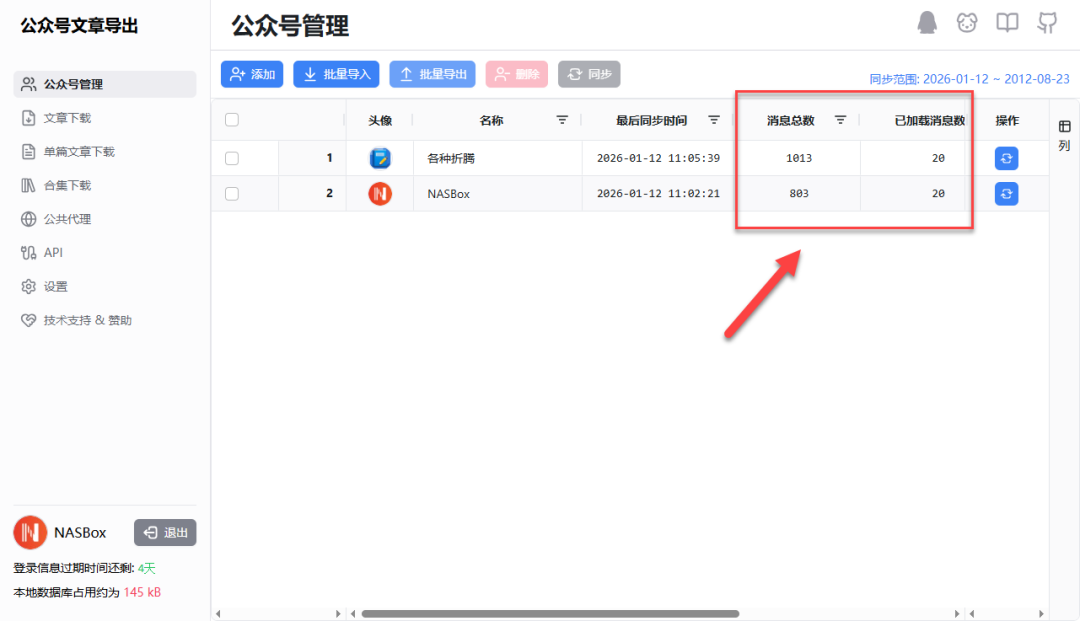

添加成功后,系统会自动同步该公众号最近的部分文章列表。

4. 下载与导出文章

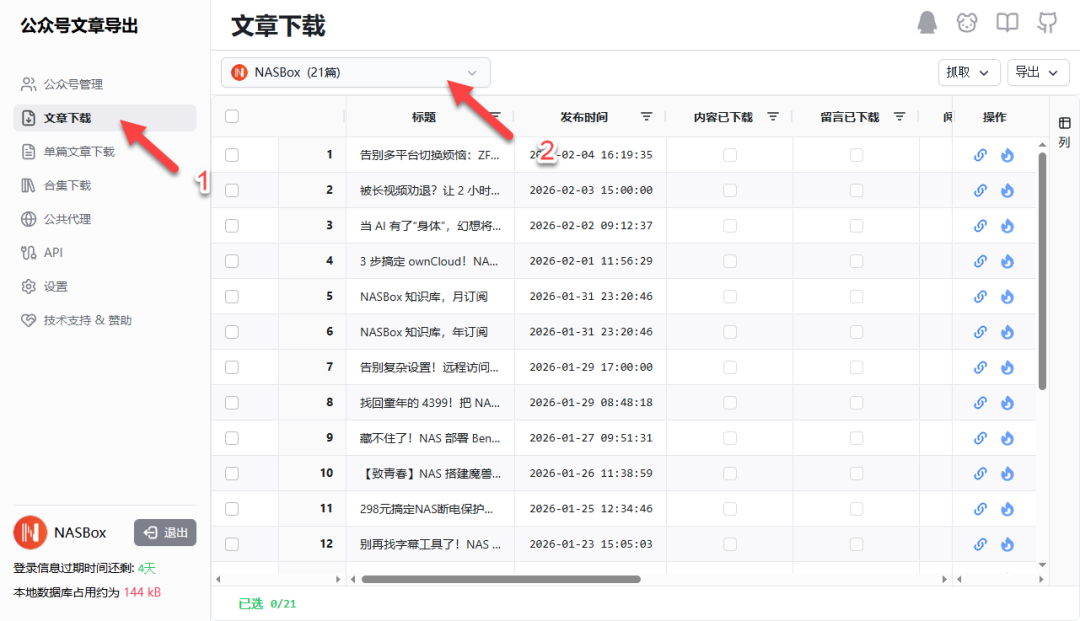

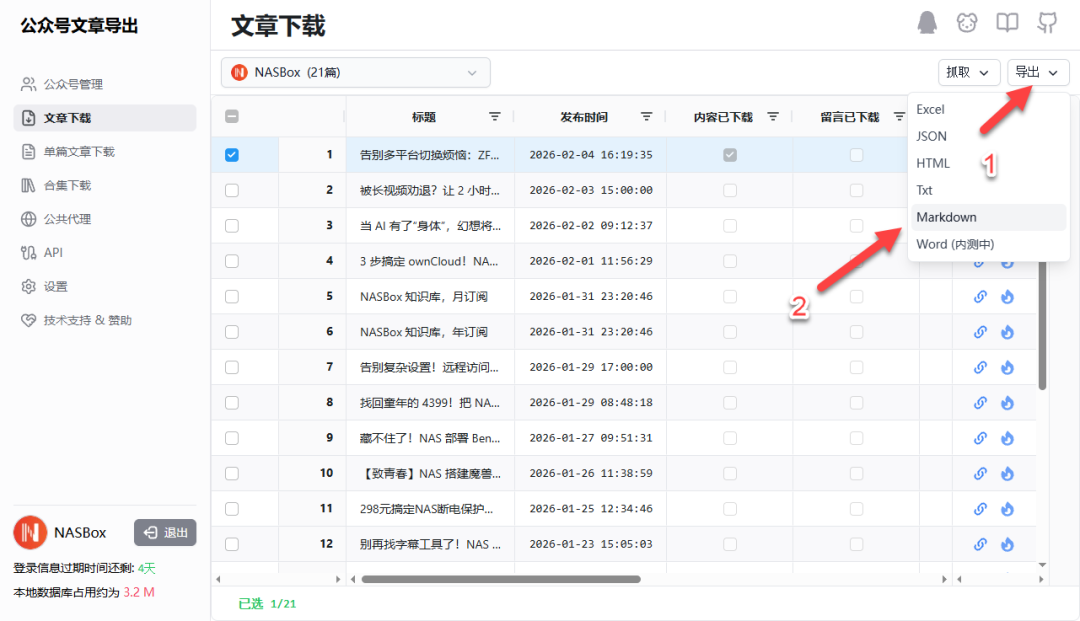

切换到左侧菜单的 “文章下载” 页面,在顶部下拉框中选择已添加的公众号,即可看到其文章列表。

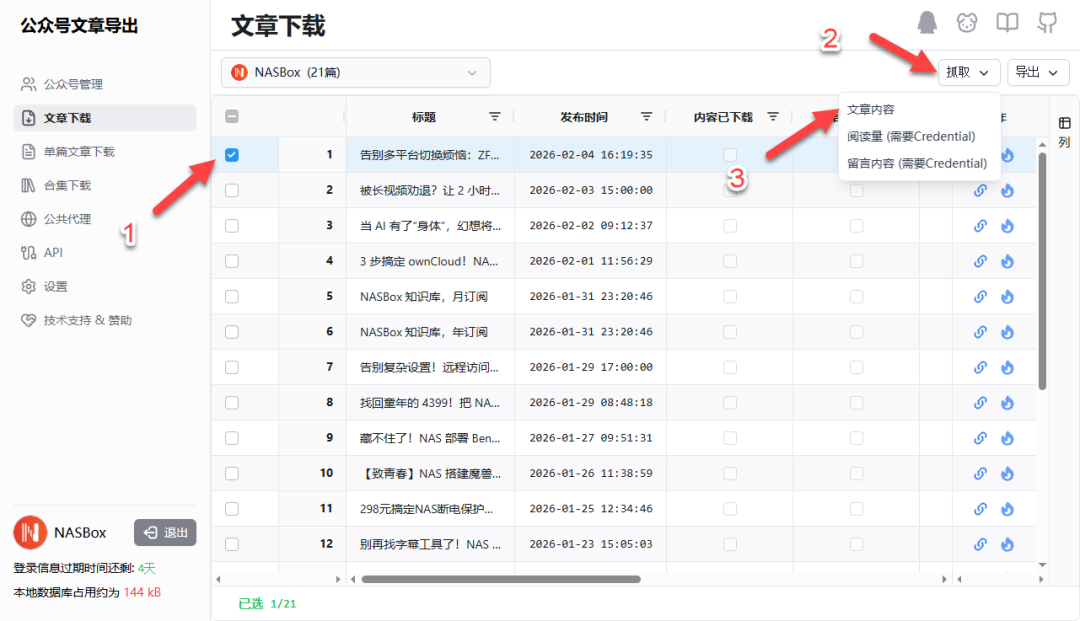

勾选你想要下载的文章,然后点击上方的 “获取” 按钮,选择 “文章内容” 开始抓取。

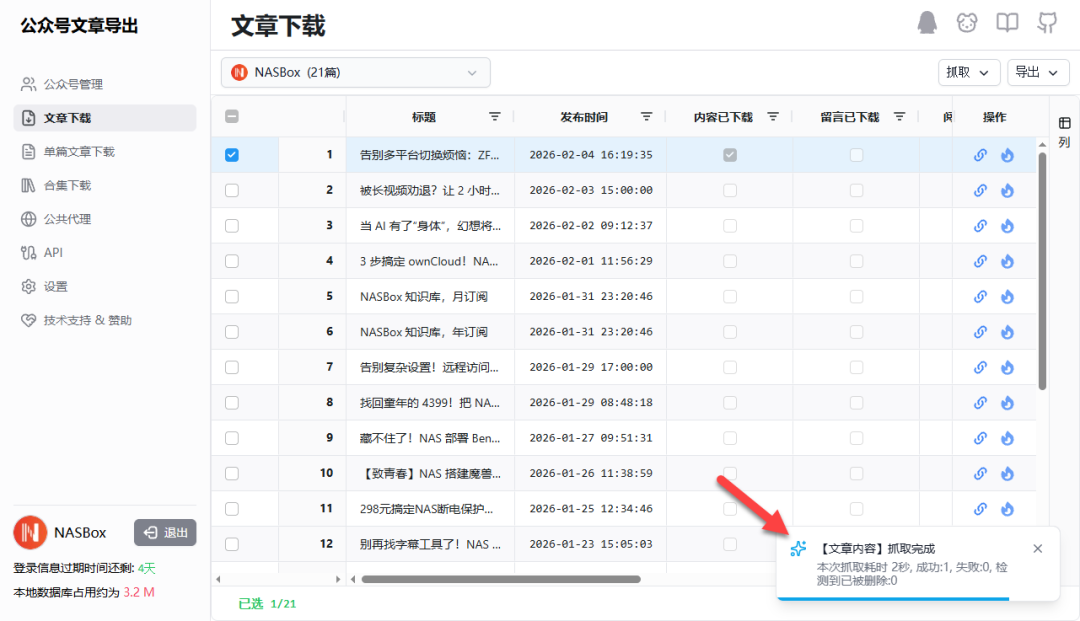

抓取完成后,页面下方会有成功提示。

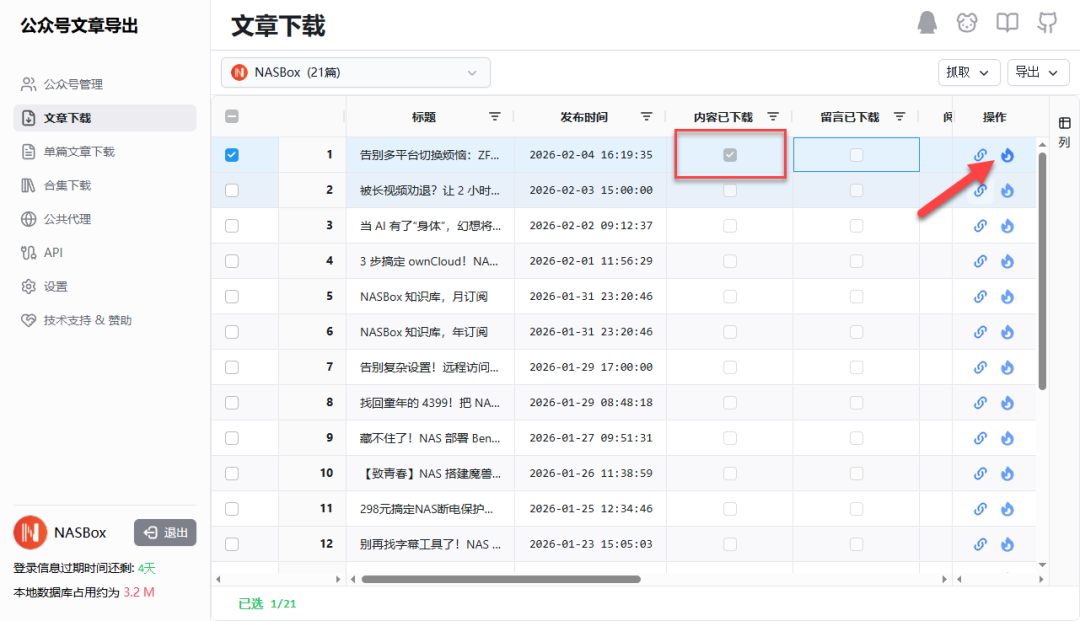

此时,可以点击操作列中的“浏览”图标,在线预览已下载的文章,确认排版是否正常。

文章内容完美还原,包括图片和格式。

确认无误后,再次勾选文章,点击 “导出” 按钮,选择你需要的格式,例如 Markdown。

导出的 Markdown 文件会包含文章正文、封面图链接等信息。

5. 其他功能

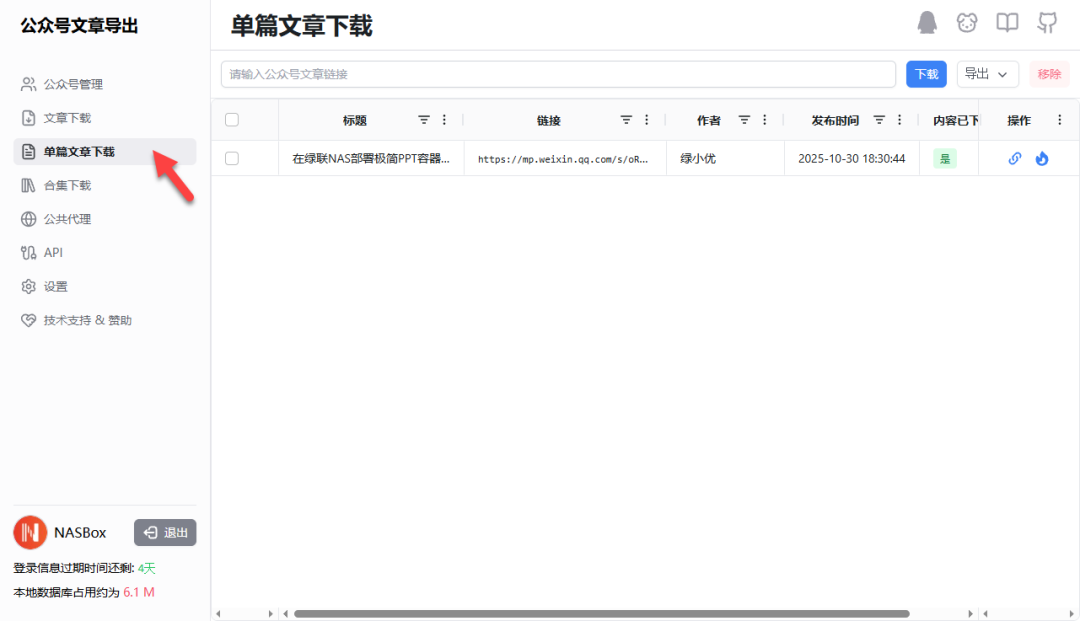

- 单篇文章下载:即使没有关注某个公众号,也可以通过“单篇文章下载”功能,直接输入文章链接进行下载。

- 合集下载:工具支持抓取公众号内的文章合集进行批量下载,非常适合整理系列教程或专题内容。

总结与评价

wechat-article-exporter 解决了许多公众号运营者和内容收藏者的一个痛点:如何高效、完整地备份自己的或感兴趣的文章。其 Docker 化部署降低了使用门槛,而支持评论、阅读量等元数据导出更是为数据分析提供了可能。

不过需要注意,其核心功能(如抓取文章详情和评论)依赖于有效的微信公众号登录凭证(Credentials)。对于需要进行复杂自定义或集成到其他工作流的开发者,其提供的 开放API 也是一个不错的扩展点。

总的来说,如果你恰好是公众号运营者,并且有批量备份、多格式导出或数据分析的需求,这款工具值得一试。如果你只是想偶尔保存一两篇文章,或许一些更轻量级的浏览器插件或离线工具会更方便。在 云栈社区 的开发者论坛中,你也能找到关于各类内容处理工具的更多讨论和实战分享。

综合推荐:⭐⭐⭐ (按需选用)

使用体验:⭐⭐⭐ (功能完整,依赖登录状态)

部署难易:⭐⭐⭐⭐ (Docker Compose一键部署,非常简单)