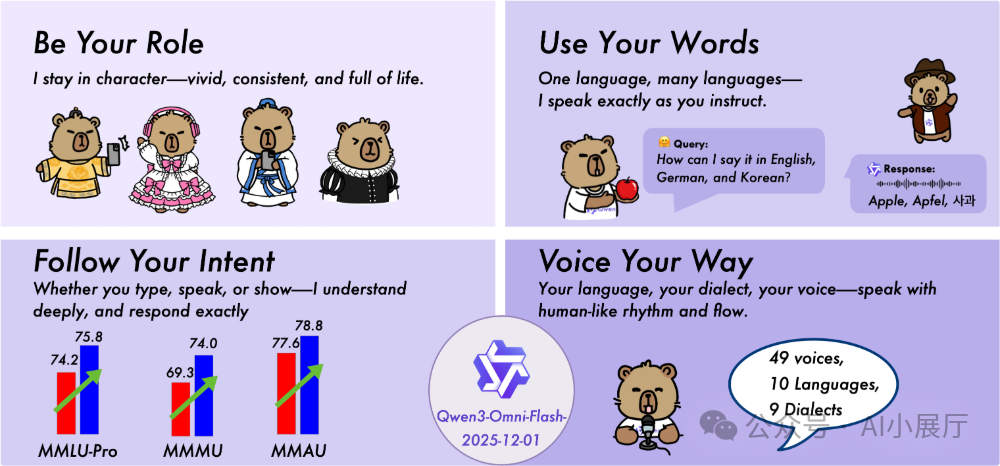

近日,阿里巴巴通义大模型团队推出了Qwen3-Omni-Flash-2025-12-01模型。作为Qwen3-Omni全模态模型的迭代升级版,新版本在多模态深度理解、实时交互流畅度、系统提示可控性以及多语言支持广度上均实现了显著增强,标志着通义在全模态人工智能技术路径上的又一次重要迈进。

核心特性:全能感知与实时交互

Qwen3-Omni-Flash是通义基于旗舰模型Qwen3-Omni深度优化的全模态大模型。它不仅继承了强大的文本处理能力,更在图像、音频、视频的理解与生成上实现一体化,并支持实时文本与自然语音的输出。

相较于前代,Flash版本着重提升了以下维度:

- 多模态理解深度:强化了对图文、音视频等混合信息的综合推理能力。

- 实时音视频交互:大幅优化了“边听边答、边说边生成”的流式响应性能。

- 系统提示控制:全面开放了系统提示(System Prompt)的自定义能力,允许开发者精细定义模型行为。

- 多语言听说能力:扩展了语音识别与合成的语言覆盖范围。

- 流式生成性能:提升了在连续对话和实时场景下的响应速度与稳定性。

该模型被官方定位为实现“声、形、意合一体化交互”的核心能力基座。

核心能力解析

1. 多模态输入与输出

模型能够同时接收并处理文本、图像、音频、视频等多种模态信息,并在统一的认知框架下进行理解、推理与内容生成。这实现了从“静态图像描述”到“动态视频解析”再到“自然语音对话”的无缝体验跨越。

2. 实时流式交互

Flash版本引入了更强大的流式生成机制,能够实现:

- 边听边理解:在用户说话过程中即开始解析语义。

- 边说边生成:实时产出文本或语音回应,延迟极低。

- 边看边回答:对视频流进行实时分析并给出反馈。

这一特性使其特别适用于智能客服、实时语音助手、直播互动等对时效性要求极高的后端架构应用场景。

3. 系统提示全面开放

模型支持开发者通过系统提示进行深度行为定制,例如:

- 设定语气风格:如专业严谨、轻松口语化、亲切温柔等。

- 定义扮演角色:如扮演教师、客服专员、个人助理等。

- 控制输出格式与篇幅:精确指定回复的长度和结构。

- 细致控制模型机能:对特定能力的调用进行约束或增强。

这项能力赋予了开发者更大的自由度,能够根据具体业务需求塑造独特的“模型人格”。

4. 广泛的多语言支持

根据官方数据,模型具备广泛的语言处理能力:

- 文本:支持119种语言的理解与生成。

- 语音识别:支持19种语言的语音转文字。

- 语音合成:支持10种语言的文字转语音。

这使其能够轻松应对全球化业务、跨语言平台服务等复杂需求。

技术亮点与性能表现

技术架构与增强

模型基于Qwen系列的多模态骨干架构,并采用了类混合专家(MoE)方案。Flash版本进一步强化了多模态表征学习、跨模态信息对齐与联合推理能力,确保在多任务、多模态场景下的性能更加均衡与鲁棒。

在语音生成方面,其效果远超传统TTS技术,具备语速随语义自动调节、停顿自然、情感表达贴近真人、多语言音色一致性强等特点。这得益于通义在Qwen-TTS等语音模型上的长期技术积累。

在视觉理解层面,模型在视觉问答(VQA)、图解数学、视频语义理解等任务上表现突出,在物体识别、图像细节描述、视频动作与上下文推理、多帧关联分析等方面的准确度显著提升。

评测数据

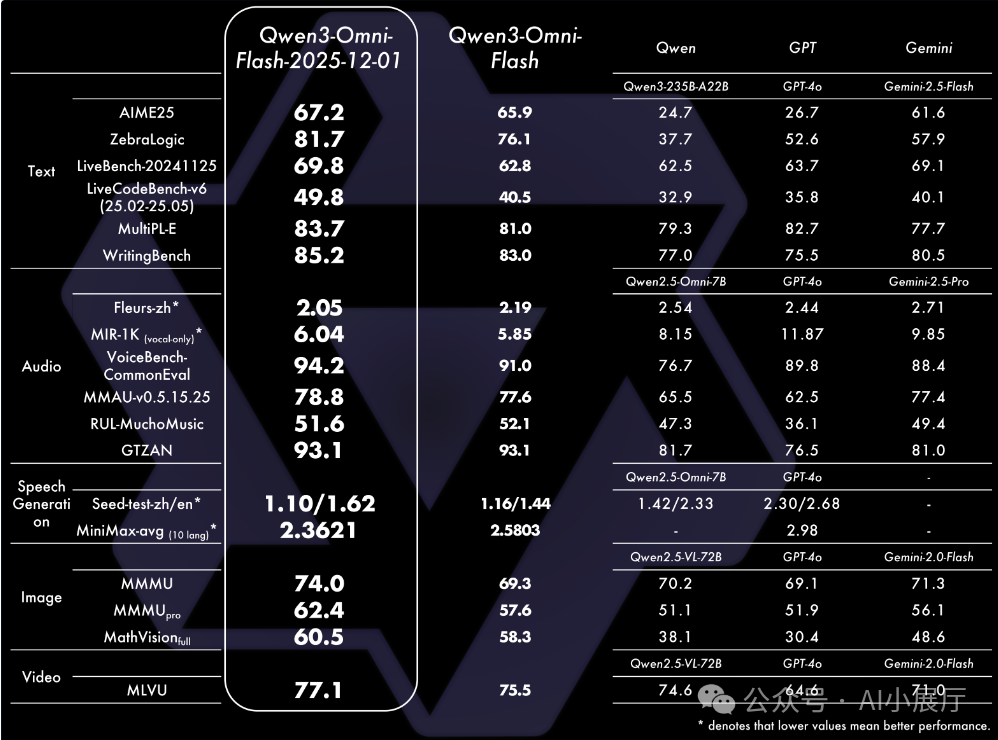

官方评测数据显示,Qwen3-Omni-Flash在多个权威基准测试中取得显著进步,例如:

- ZebraLogic(逻辑推理)得分提升 +5.6

- LiveCodeBench-v6(代码生成)得分提升 +9.3

- MMMU(多学科视觉理解)得分提升 +4.7

综合来看,模型在逻辑推理、代码生成、多模态理解、语音交互等多个核心维度实现了全面增强。

如何使用与集成

1. 在线体验:Qwen Chat

个人用户和开发者可以通过“通义千问”官方平台进行在线体验,快速测试模型的文本对话、语音交互、图像识别及视频解析等核心功能,用于创意验证或效果评估。

2. API调用:企业集成

企业和开发者可以通过阿里云百炼平台,调用 qwen3-omni-flash-realtime-2025-12-01 接口,将模型能力集成到自有产品中。计费方式采用通行的Token计费模式,输入与输出分开核算。

典型应用场景

- 智能客服:结合真实感语音与多语言支持,可处理图文咨询、语音提问、视频演示等多模态客户服务,提升体验与效率。

- 会议助手:实现实时语音转写、多语言同传翻译、会议纪要自动生成、视频内容关键点提取等功能,服务于跨国企业与在线协作平台。

- 内容创作:辅助进行文稿撰写、视频脚本创作、基于视频内容的剪辑建议生成、图文混排内容编辑等,赋能自媒体、影视制作及运营团队。

- 教育与语言学习:利用其多语言对话与语音评估能力,打造口语练习伙伴、提供发音纠正、开展场景化对话教学,构建“听说读写”一体化的智能学习环境。

|