在人工智能领域,大型语言模型(LLMs)凭借其强大的通用能力成为技术焦点。然而,行业分析机构Gartner与科技巨头NVIDIA均指出,小型语言模型(SLMs)的崛起正成为AI智能体(Agent)未来发展的核心趋势。Gartner预测,到2027年,企业使用小型、任务专用AI模型的频率将达到通用LLMs的三倍。

SLMs为何至关重要?它们又是如何在复杂的AI智能体架构中扮演核心角色的?本文将深入解析SLM的核心定义、关键构建技术,并重点阐述在智能体设计中最大化其效能的四种核心协作策略。

什么是小型语言模型(SLMs)?

小型语言模型(Small Language Models, SLMs)同样是基于Transformer 架构构建的神经网络,其核心特征在于参数量级相对较小,通常在数亿到数百亿之间,远低于动辄千亿、万亿参数的通用大模型。

其核心优势包括:

- 高效专注:虽然牺牲了部分通用性,但在特定任务上表现卓越,效率极高。

- 快速推理:更少的参数意味着更快的计算和响应速度。

- 资源友好:对内存和算力的要求大幅降低。

- 易于部署:非常适合在本地服务器或边缘计算环境中进行隐私优先的私有化部署。

SLMs 是如何被构建和优化的?

SLMs并非LLMs的简单缩小版,而是通过一系列精密的模型压缩与优化技术实现的:

-

量化(Quantization)

- 原理:降低模型参数的数据精度,例如将32位浮点数(FP32)转换为8位整数(INT8)或4位(INT4)。

- 效果:在几乎不损失精度的情况下,显著减少模型体积并提升推理速度。

-

剪枝(Pruning)

- 原理:识别并移除网络中冗余或不重要的参数、神经元或连接。

- 效果:如同修剪枝叶,在保持模型主干能力的同时,减少其复杂度和计算量。

-

知识蒸馏(Knowledge Distillation)

- 原理:让一个庞大的“教师模型”指导一个轻量级的“学生模型”学习。学生模型通过模仿教师模型的输出或中间层特征,来继承其强大的知识表示和推理能力。

- 效果:使紧凑的SLM能够获得接近甚至超越更大模型的性能,实现“小身材,大智慧”。

赋能 AI 智能体的四大核心协作策略

SLMs的真正价值在于与LLMs在智能体系统中协同工作。通过以下四种策略设计,可以充分发挥SLM的效率与LLM的泛化能力。

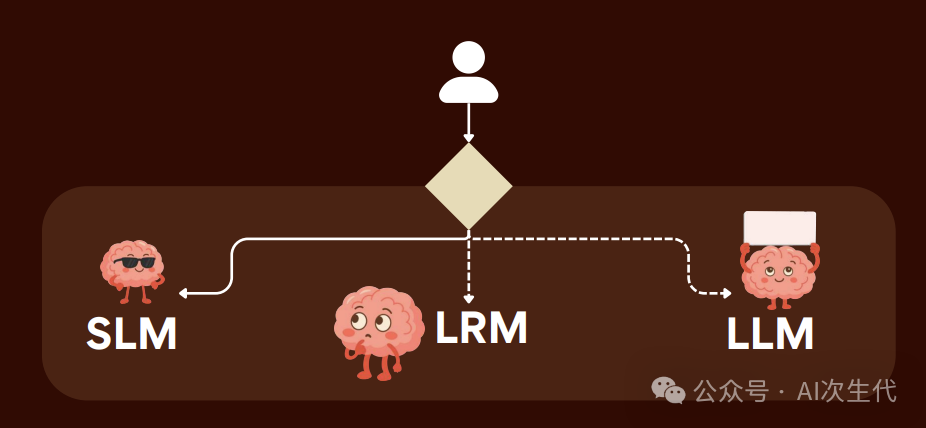

策略一:智能路由(Intelligent Routing)

- 运作方式:系统根据任务复杂度进行智能分发。将简单、高频、定义清晰的任务(如意图分类、关键词提取)路由给SLM处理;将需要深度理解、创造性或多步推理的复杂任务交给LLM。

- 核心价值:大幅降低对昂贵LLM的调用频率和成本,同时提升系统整体响应速度。

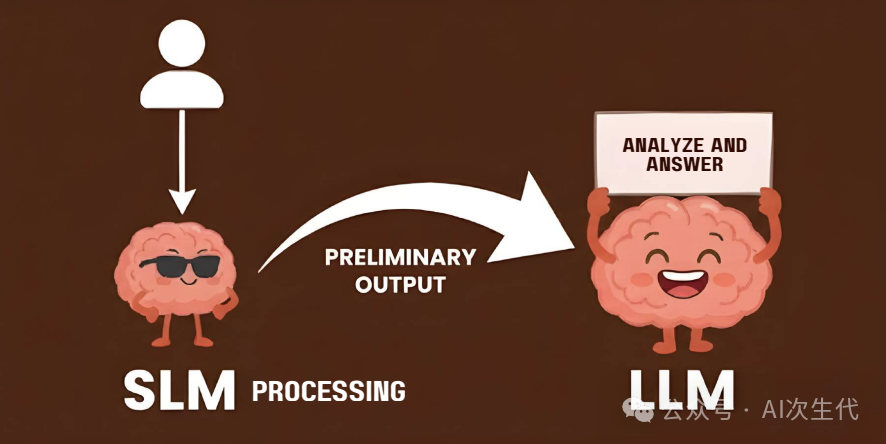

策略二:流水线协作(Pipeline Collaboration)

- 运作方式:SLMs在任务处理流水线中扮演专业“工序”角色。

- 前端预处理:SLM负责数据清洗、文档摘要、查询重构等(例如,Uber在其智能体RAG系统中使用SLM进行查询预处理)。

- 后端精炼:LLM生成初步内容后,由SLM负责格式化、风格调整或错误修正。

- 核心价值:利用SLM的专业性提升数据质量,为LLM减负,优化处理流程。

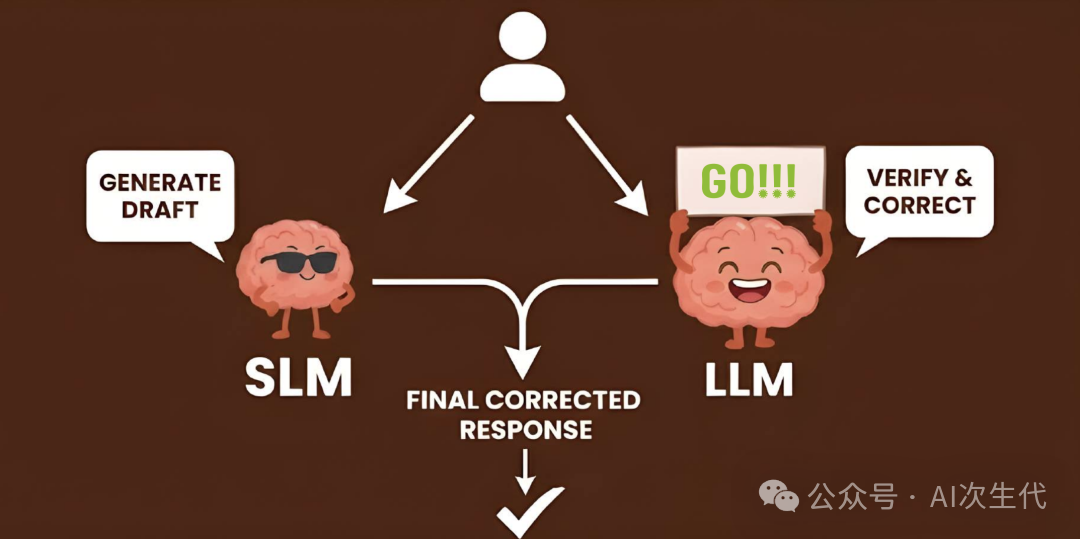

策略三:并行验证(Parallel Verification)

- 运作方式:在需要高可靠性或快速反应的场景中,SLM和LLM并行工作。

- SLM:快速生成一个初步答案或草稿。

- LLM:同步进行更深入的分析,或对SLM的输出进行校验与增强(例如,OpenAI在其安全护栏中使用SLM进行快速的内容安全检查)。

- 核心价值:结合了SLM的“速度”与LLM的“深度”,在保证质量的同时实现快速响应。

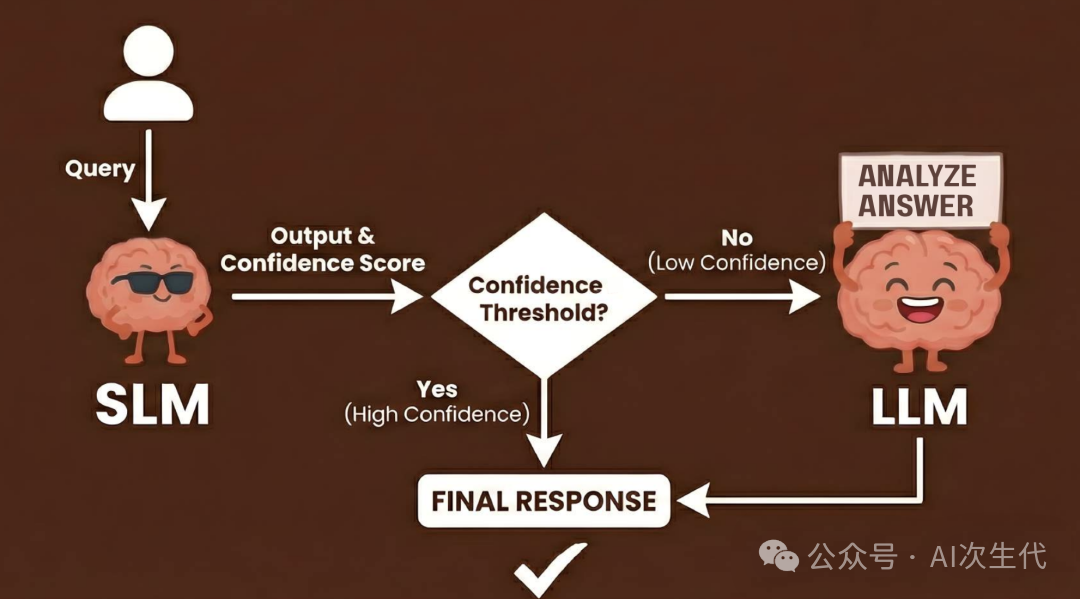

策略四:条件激活(Conditional Activation)

- 运作方式:SLM作为默认任务处理器。系统实时评估SLM输出的置信度,仅当置信度低于预设阈值时,才“唤醒”成本更高的LLM进行接管。

- 核心价值:实现最优的资源分配,确保绝大部分日常任务由高效的SLM处理,仅将疑难杂症交由LLM解决。

企业为何应积极布局SLMs?

领先企业采纳SLMs是基于其对实际业务痛点的精准解决:

| 维度 |

SLMs 带来的核心价值 |

典型应用场景(案例参考) |

| 隐私与安全 |

支持本地化或边缘计算部署,敏感数据无需出域。 |

医疗诊断辅助、法律文档分析、内部数据分类。 |

| 成本控制 |

单次推理成本极低,规模化应用经济性显著。 |

海量票据/表单处理(成本可降至LLM的1%)。 |

| 领域专业化 |

易于使用企业私有数据进行微调,打造专属助手。 |

内部代码助手、客服工单分类、供应链优化(如微软案例)。 |

行业应用实例:

- Uber:在其智能体RAG流水线中,利用SLM进行查询预处理和答案有效性验证。

- OpenAI:在安全防护机制中部署SLM,用于高效执行内容安全过滤和意图分类。

- Microsoft:利用SLM提升其云供应链履行流程的准确性与效率。

结语

小型语言模型(SLMs)并非大型语言模型(LLMs)的替代者,而是其最佳协作者。在未来AI智能体的生态中,SLM将扮演处理日常、专业及实时任务的“高效执行层”;而LLM则作为应对复杂、创新挑战的“战略决策脑”。熟练掌握智能路由、流水线协作、并行验证与条件激活这四大协作策略,将是企业在下一代AI应用竞争中构建差异化优势的关键。 |