在企业数据平台的演进历程中,传统数据仓库(如Oracle Exadata、Teradata、Greenplum及早期的Hive+Presto组合)曾是不可或缺的基石。然而,随着业务复杂度激增、数据量呈指数级膨胀,以及对实时分析的迫切需求,传统数仓架构显露出三大核心瓶颈:

- 成本高昂:计算与存储强耦合,扩容需购置整机,资源利用率低下;

- 性能受限:复杂查询响应迟缓,难以支撑亚秒级的交互式分析;

- 架构僵化:ETL流程冗长,无法灵活适应湖仓一体、流批融合等现代数据范式。

由此,一场旨在“去传统数仓化”的技术革新悄然展开。其中,StarRocks与数据湖(如Delta Lake/Iceberg/Hudi)的结合,正成为构建新一代高性能、低成本数据架构的关键组合。

一、为什么选择 StarRocks + 数据湖?

1. 架构对比:传统数仓 vs. 湖仓一体

| 维度 |

传统数仓(如 Greenplum) |

StarRocks + 数据湖 |

| 存储模型 |

行存/列存封闭格式 |

开放格式(Parquet/ORC)+ 元数据层(Iceberg/Delta) |

| 计算存储耦合 |

强耦合,扩容成本高 |

存算分离,可按需弹性伸缩 |

| 实时能力 |

以批处理为主,微批延迟高 |

支持分钟级至秒级实时入湖与查询 |

| 运维复杂度 |

高(依赖DBA深度调优) |

低(具备自动优化、向量化执行引擎) |

| 总拥有成本(TCO) |

高(硬件+许可+人力) |

可降低50%~70%(采用对象存储与开源技术栈) |

关键洞察

StarRocks并非旨在取代数据湖,而是作为高性能查询引擎,直接读取数据湖上的开放格式数据,实现“湖上建仓”(Lakehouse Query Engine)的能力。

二、落地四步走:构建 StarRocks + 数据湖架构

步骤 1:数据湖选型(Iceberg vs. Delta vs. Hudi)

- Apache Iceberg:元数据抽象能力最强,兼容性最佳,适合Spark、Flink、Trino、StarRocks等多引擎协同查询。

- Delta Lake:与Databricks生态绑定紧密,提供强ACID保证,但开源版本功能可能受限。

- Apache Hudi:写入优化出色(支持MOR/COW表类型),适用于数据高频更新场景。

推荐:若以StarRocks作为核心查询引擎,建议优先选择Apache Iceberg。自v3.0版本起,StarRocks官方对Iceberg Catalog的支持最为完善。

步骤 2:数据入湖(实现流批一体)

- 批处理数据:使用Spark或Flink将数据写入Iceberg表(Parquet格式)。

- 流式数据:通过Flink CDC捕获变更数据→写入Kafka→经由Flink Iceberg Sink入湖,实现分钟级延迟。

- 关键配置:建议设置

write.format.default=parquet 并调整 write.target-file-size-bytes=512MB,以避免产生过多小文件问题。

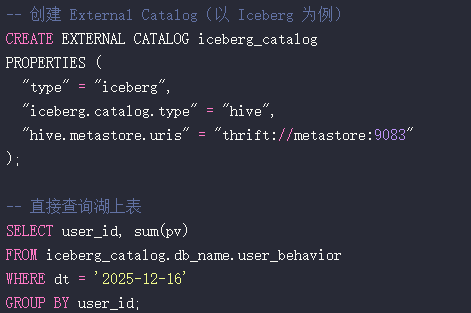

步骤 3:StarRocks对接数据湖

注意:StarRocks自v2.5版本起支持外部表(External Table),并在v3.0+版本推出了原生Iceberg Catalog,查询性能提升了3~5倍。

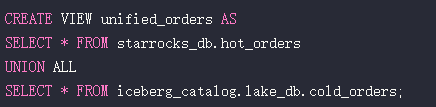

步骤 4:混合负载优化(应对HTAP场景)

- 热数据:将高频查询的表(例如近7天的订单表)通过同步方式导入StarRocks内部表,并采用主键模型与聚合索引进行优化。

- 冷数据:保留在数据湖中,通过StarRocks的外部Catalog进行查询。

- 统一查询入口:利用StarRocks的视图(View)功能,封装数据湖表与内部表,为业务提供透明的单一查询入口。

三、典型应用场景

场景 1:实时用户行为分析

- 原有痛点:基于Hive + Presto的链路数据延迟超过1小时,无法支持运营实时决策。

- 解决方案:

- Flink实时消费日志,每5分钟提交(commit)一次至Iceberg表。

- StarRocks直连Iceberg表进行查询,平均响应时间<2秒。

- 达成效果:运营策略迭代速度提升10倍,投资回报率(ROI)提升35%。

场景 2:金融风控毫秒级查询

- 原有痛点:PB级历史交易数据,传统数仓难以同时满足全量扫描与高并发点查。

- 解决方案:

- 近30天的高频访问数据存入StarRocks主键模型(支持upsert)。

- 全量历史数据保存在Iceberg数据湖中。

- 在应用层或通过StarRocks视图实现查询自动路由。

- 达成效果:点查询P99延迟<50毫秒,全表扫描性能提升8倍。

四、实践避坑指南

坑 1:小文件爆炸

- 现象:Flink高频写入Iceberg时产生大量小文件,导致StarRocks查询性能急剧下降。

- 解决方案:

- 调整Flink Checkpoint间隔(例如设置为5分钟)。

- 启用Iceberg表的自动压缩(rewrite data files)任务。

- 在StarRocks中为外部表设置

enable_file_metacache = true,缓存文件元数据。

坑 2:元数据同步延迟

- 现象:Iceberg表新增了分区,但StarRocks无法立即查询到。

- 解决方案:

- 使用StarRocks v3.1+版本,并配置Iceberg Catalog的

metadata_cache_ttl 参数(如iceberg.metadata.cache-ttl-seconds=300)实现自动刷新。

- 或执行手动命令:

REFRESH EXTERNAL TABLE table_name;

坑 3:谓词下推失效

- 现象:查询中的过滤条件未能下推到数据湖层,导致全表扫描。

- 解决方案:

- 确保Iceberg表设计了合理的分区字段(如

dt, hour)。

- 在StarRocks查询时,在WHERE条件中显式使用这些分区字段。

- 升级至StarRocks 3.x版本,其对谓词下推和投影下推的支持更为完善。

五、深度优化:充分释放性能潜力

1. 文件布局优化

- 对Iceberg表使用Z-Order或Cluster Key对数据(如按

user_id字段)进行重排聚集。

- 此举能显著减少I/O扫描量,使StarRocks的向量化执行引擎优势最大化。

2. 缓存加速策略

- 在StarRocks中开启PageCache(通过参数

storage_page_cache_limit设置,如20G)。

- 对高频访问的数据湖表文件进行缓存,可使二次查询速度提升10倍以上。

3. 计算下推

- 利用StarRocks的聚合下推能力,将COUNT、SUM、MIN、MAX等聚合操作下推至Parquet文件级别。

- 结合Parquet文件自带的统计信息(min/max),可以有效跳过不相关的Row Group。

4. 成本监控

- 使用 S3 Storage Lens 或阿里云OSS访问分析等工具,监控StarRocks查询对数据湖存储的读取流量。

- 需警惕“隐性成本”:高频的小文件读取可能导致存储API请求次数暴增,从而推高费用。

结语:架构的演进,而非简单的替代

StarRocks与数据湖的结合,其意义并非是要“干掉”传统数据仓库,而是通过开放、弹性、高性能的新一代架构范式,来解决旧体系在成本与效率上难以逾越的鸿沟。

某头部电商的实际测试数据显示:完成架构迁移后,其数据平台年成本从1200万元降至350万元,复杂查询的P95响应时间从45秒缩短至1.2秒。

如果你的团队仍在为数据仓库扩容的巨额成本而困扰,为漫长的ETL流程而头疼,或为无法实现实时分析而束手无策,那么,是时候深入了解并评估这套强大的“湖仓一体”组合方案了。 |