要理解当下AI绘图的强大能力,我们需要将其置于从“机械模仿”到“深刻理解”的技术演进脉络中审视。

第一阶段:GAN 时代

早期AI绘画由生成对抗网络(GAN)主导。其内部“生成器”与“判别器”通过博弈进化,能生成以假乱真的图片,但存在根本局限:它缺乏语义理解能力。当时的模型高度垂直化,例如训练于猫的图片只能生成猫。它无法理解概念的组合,如“猫骑自行车”,强行生成的图片往往将不同物体的纹理生硬拼接。

第二阶段:CLIP 的出现

真正的转折点是OpenAI发布的CLIP模型。它通过在海量图文对上训练,建立了文本与图像的关联映射。从此,AI能够理解自然语言描述与视觉内容之间的关系。当输入“一只骑自行车的猫”时,CLIP能将这段文字转化为机器可理解的语义向量,并指导生成过程不偏离描述,为精准的文生图控制奠定了基础。

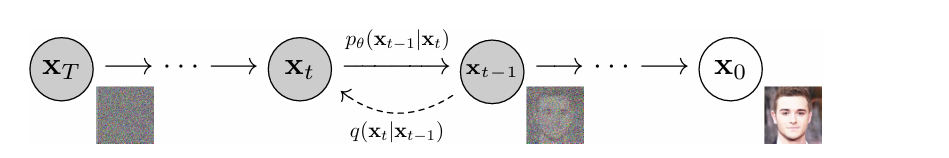

第三阶段:扩散模型时代

同期,扩散模型成为新的主流。其训练过程是“破坏”与“重建”:向清晰图片逐步添加噪声直至变成完全随机的“雪花图”(前向扩散),然后让模型学习逆向的去噪过程(反向扩散)。生成时,则从一张纯噪声图开始,通过数十至上百步迭代,逐步预测并减去噪声,最终还原出清晰图像。

扩散模型的迭代去噪过程

GAN 与扩散模型的核心差异

尽管GAN生成速度更快,但扩散模型凭借其“慢工出细活”的特性实现了全面超越:

- 生成多样性:GAN易陷入“模式坍塌”,只生成有限的几种样本;扩散模型必须学习处理所有噪声情况,因而能生成风格、内容极其多样的图片。

- 训练稳定性:GAN中生成器与判别器的动态博弈难以平衡,训练常失败;扩散模型的训练目标(预测噪声)是确定的数学问题,训练稳定,易于扩展。

- 生成质量:GAN一次性成图,错误无法修正;扩散模型的迭代生成如同雕刻,允许在多步中反复打磨细节,实现了画质的飞跃。可以说,GAN是才华横溢但情绪不定的画家,而扩散模型是基本功扎实、耐心极致的大师。

AI绘图的基本原理:基于Stable Diffusion的系统梳理

Stable Diffusion (SD) 并未推翻扩散模型,而是进行了一次关键架构创新,其核心机制可概括为:在潜空间(Latent Space)中,利用CLIP提取的语义指令,指挥U-Net网络一步步预测并剔除噪声,最后解码成图。

Stable Diffusion 原理图

1. 潜空间:效率的关键

传统扩散模型在像素空间操作,计算量巨大。SD引入了变分自编码器(VAE)。在生成前,VAE编码器将高维像素图像压缩成一个极小的潜空间向量(例如,512x512图像被压缩为64x64张量);生成完成后,VAE解码器再将其解压回高清图片。这一“降维”操作将计算量减少了约64倍,是SD能在消费级显卡上运行的核心。

2. CLIP:语义的翻译官

在SD流程中,CLIP的文本编码器将提示词转化为高维语义向量(Embedding)。这个向量包含了词语的深度关联信息,作为核心条件(Condition)被注入到图像生成的每一个迭代步骤中,确保生成内容始终符合文本描述。

3. 核心引擎:U-Net与采样

在潜空间中作画的“画师”是 U-Net。其核心工作是:在每一步迭代中,预测当前潜空间图像中的噪声。

交叉注意力机制是控制精准的关键。U-Net中的图像特征(Query)会不断与CLIP提供的文本语义(Key)进行匹配。一旦图像的某个区域特征与文本中的概念(如“猫”)匹配成功,就会将对应的视觉描述信息(Value)融合进当前图像中。这个过程确保了文字能精准指导画面生成。

采样器(Sampler)与调度器(Scheduler) 则像施工指挥。调度器规划每一步的降噪强度,采样器执行具体的数学解算,共同指挥U-Net进行多轮“预测噪声-减去噪声”的循环,最终得到清晰的潜空间图像,再由VAE解码输出。

流程小结

- 文生图:从潜空间随机噪声开始,结合CLIP指令,由采样器指挥U-Net迭代去噪,最后VAE解码。

- 图生图:用VAE编码器将原图压缩进潜空间,添加一定量噪声(强度可控),后续过程与文生图相同。

这一流程正是 ComfyUI 等可视化工作流的基础逻辑:

- 加载 Checkpoint(包含U-Net、CLIP、VAE的模型包)。

- CLIP 文本编码器处理提示词。

- 准备潜空间画布(空Latent Image或加噪后的Latent)。

- K采样器节点执行迭代去噪。

- VAE解码器输出最终图像。

关键概念进阶词典

- LoRA:轻量化的模型“补丁”,用于微调特定风格、角色或概念,即插即用。

- ControlNet:精准控制工具,通过输入轮廓、姿态、深度等条件,强制AI按照指定构图生成,是工业级应用的关键。它基于PyTorch等框架实现,为生成过程戴上了“手铐”。

- Text Embedding:将特定视觉概念训练成一个特殊“令牌”,在提示词中调用即可生成对应形象。

工具论:如何选择AI生图工具

选择工具的核心在于权衡“封装程度”与“控制权”。

1. 整合型工具:精装房

代表:Midjourney、集成在豆包中的即梦模型、Gemini中的Nano-Banana。

- 特点:厂商将模型、参数、优化逻辑完全封装,提供“黑盒”体验。输入简单提示即可获得高质量输出,下限高,无需本地硬件。

- 局限:用户失去对采样器、模型架构等底层参数的控制权,难以实现精准定制。

2. 开源生态:自建房

以 Stable Diffusion 为核心,所有组件可自由更换,前端界面主要分为两类:

SD WebUI:全能的单反相机

- 特点:集成式仪表盘,参数像相机按钮一样排列,适合单任务操作和直观调试。

- 适用场景:常规文生图、图生图、局部重绘(Inpaint)。拥有丰富的插件生态,易于上手。

ComfyUI:可视化的编程电路板

- 特点:通过节点和连线搭建可视化工作流,清晰展示数据流动。定制能力极强,可构建自动化处理管线。

- 核心优势:

- 工作流定制:能将“生成→检测→修复→放大”等步骤连成全自动流水线,适合批量化处理。

- 资源高效:底层优化好,显存利用率高,生成速度通常更快。

- 生态活跃:自定义节点(Custom Nodes)更新迅速,能快速适配最新模型(如FLUX、Qwen)。

- 进阶控制:在复杂风格迁移、AI视频生成(配合AnimateDiff等节点)方面具有独特优势。

- 适用人群:希望深入理解原理、需要搭建自动化流程或进行复杂实验的进阶用户和开发者。其节点式逻辑与Transformer架构的可视化理解有相通之处。

硬件与部署

- 本地部署:需要性能足够的显卡(建议显存12GB以上以运行最新模型)。

- 云端部署:通过RunningHub、AutoDL等平台租用云端GPU,按需使用。你获得的是一个完整的远程桌面环境,可以像在本地一样操作完整的WebUI或ComfyUI界面,并上传自定义模型和节点,是低成本体验高性能算力的灵活方式。

方法论:从提示词到模型训练的三重境界

第一重:提示词工程

适用于90%的日常需求,核心是将自然语言转化为AI理解的“标签”。

- 基础公式:

主体 + 场景 + 风格

- 进阶公式:

主体(及细节) + 场景(及描述) + 风格 + 镜头语言 + 氛围 + 细节修饰

- 突破边界:当语言无法精确描述空间关系或复杂组合时,便需进入下一境界。

第二重:模型与插件控制

利用开源生态的模块化能力解决特定问题。

- 选对Checkpoint:根据需求选择写实、二次元或通用大模型。

- 使用LoRA:为模型添加特定的风格滤镜或人物特征。

- 应用ControlNet:通过输入边缘检测、姿态、深度图等,对构图、姿态进行像素级精确控制。这是实现商业级复用的关键。

- 辅助工具:局部重绘(Inpaint)修复瑕疵,高清放大(Upscale)提升分辨率。

第三重:训练与微调

应对现有模型库无法满足的极端定制化需求。

- 训练Text Embedding:固定一个简单概念或物体(文件极小)。

- 训练LoRA:当前主流方式。准备20-50张目标图片,训练后获得专属风格或人物的微调模型。

- 全量微调Checkpoint:通常用于注入海量专业领域数据,算力和数据要求高,多为企业级应用。

结语

AI绘图技术正以前所未有的速度演进,从GAN到扩散模型,从黑盒工具到开源工作流,其核心是不断降低创意表达的门槛,同时提供更精细的控制能力。对于从业者而言,AI并非替代者,而是强大的“能力放大器”。在“生成”变得轻而易举的时代,审美判断、创意构思与问题定义的能力显得愈发珍贵。理解其原理,善用其工具,方能在这场视觉革命中真正掌握主动权。