2024年的圣何塞,英伟达GTC大会上,真正让硅谷沸腾的,不仅是Blackwell芯片的参数,更是会场外那个人形机器人、数字孪生工厂与气象模拟器交织的庞大展区。它证明了一个事实:巨头的护城河不只在于硅片,更在于让物理世界“活”起来的应用生态。

2025年12月20日,北京中关村,摩尔线程首届MUSA开发者大会的现场,我们或许能在这家“最像英伟达的中国挑战者”身上,看到相似的逻辑。真正的战略底色,不在主论坛的PPT参数里,而在那超过1000平方米、人头攒动的“MUSA嘉年华”展区。

与仅展示硬件或单一AI生图的传统芯片发布会不同,这里的展区呈现为高密度的“应用集市”。展出的不是芯片本身,而是芯片驱动物理世界运转时的鲜活状态。

在工业智造板块,雪浪云通过数字孪生大屏,展示了基于摩尔线程GPU的“盾构大脑”方案,实时呈现地下几十米深的三维地质构造与掘进姿态;在智慧医疗区,微眸医疗的眼科手术机器人,利用GPU实现毫秒级的眼球组织识别与实时渲染;在具身智能领域,景业智能的四足巡检机器狗,通过VR遥操作终端展现了低延迟的环境感知与回传能力。此外,中国移动和中国电信也展示了基于全功能GPU的云桌面与云游戏方案。

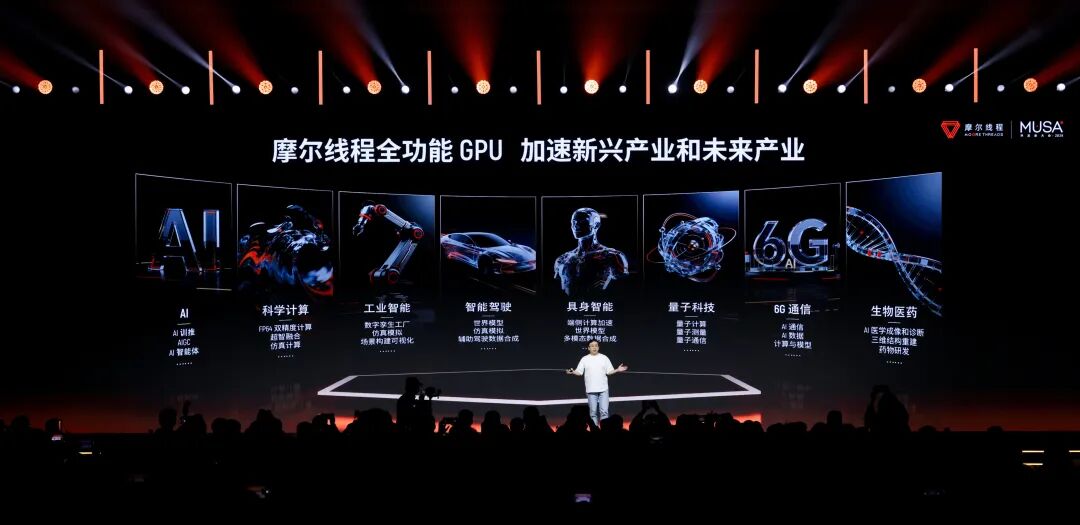

这些实时渲染的画面、流动的AI推理数据与端侧设备的即时响应,共同构成了一个复杂的混合算力场。这种布展逻辑,折射出国产GPU行业的一个重要转向:从早期的单点算力比拼,进入到以场景落地、工程化稳定性和生态密度为核心的“深水区”。 摩尔线程正试图证明,其“全功能GPU”的应用边界,已从数据中心拓展至工业、医疗、教育等物理世界的毛细血管。

01 物理世界,倒逼芯片架构

行业用户的关注焦点,往往不是单纯的算力数值,而是“芯片能否解决复杂系统的协同问题”。以工业数字孪生和具身智能为例,系统面临典型的“混合负载”挑战:既要处理传感器海量时序数据进行AI预测,又要实时构建高保真三维模型进行可视化,还需对控制参数做出低延迟反馈。物理世界的智能化,本质上是“AI计算+图形渲染+视频处理+物理仿真”的综合体。

目前,国内部分专注于AI计算的ASIC或GPGPU在单一任务上表现出色,但面对上述跨域需求时,常因缺乏图形或视频单元,需额外搭配显卡。这种“异构拼凑”不仅增加成本与功耗,更带来了数据传输瓶颈和驱动兼容性挑战。

摩尔线程坚持的“全功能GPU”路线,正是基于对此类应用场景的预判。 上市15天后,摩尔线程正式发布了新一代全功能GPU架构——“花港”。该架构算力密度提升50%,效能提升10倍,其核心设计兼顾了计算与图形的双重需求:

- 全精度计算支持:支持从FP4、FP6、FP8到FP64的全精度计算,既能满足科学计算所需的FP64高精度,也能适应大模型推理向FP4低精度的演进趋势。

- 图形引擎进化:内置第二代光线追踪硬件加速引擎和AI生成式渲染架构。

基于“花港”架构,摩尔线程公布了未来的芯片演进路线:

- “华山”芯片:专攻AI训推一体,内置新一代异步编程模型和全精度张量核心,旨在为万卡级智算集群提供支撑。

- “庐山”芯片:专攻极致图形渲染,计划将光追性能提升50倍,3A游戏性能提升15倍,并宣布将于2026年完整支持DirectX 12 Ultimate标准。

这一路线图清晰展示了差异化打法,也意味着国产显卡将在图形API标准上首次对齐国际一流水平。对于依赖Unreal Engine或Unity的开发者而言,这是一个关键信号:国产GPU正成为可以支撑复杂图形生态的通用底座。

02 大模型训练:检验算力的“好用”标准

如果说工业现场考验的是GPU的应用广度,那么大模型训练则是检验其算力高度的试金石。这也是此前国产GPU备受B端客户关注的领域。

在MDC 2025上,摩尔线程发布的“夸娥”万卡智算集群,重点展示了其在超大规模训练中的工程化能力。对客户而言,集群的有效性远重于峰值算力。数据显示,“夸娥”集群在Dense大模型上的训练算力利用率达60%,线性扩展效率达95%。

在软件层面,为解决大规模集群常见的故障中断痛点,摩尔线程推出了万卡训练容错系统,通过自动故障检测和快速检查点恢复,将有效训练时间占比提升至90%以上,直接回应了行业对训练稳定性的担忧。

在硬件层面,摩尔线程补齐了互联带宽短板。其新一代Scale-up系统实现了1314 GB/s的片间互联带宽(MTLink 4.0),并推出MTT C256超节点,能以一层网络实现256颗GPU的全互联。虽与顶级产品仍有差距,但在国产阵营中,已足以支撑万亿参数模型的规模化训练。

在实战层面,摩尔线程宣布通过软硬协同优化,完整复现了DeepSeek V3的FP8训练。其中特别强调了一项技术突破:其全功能GPU支持高精度累加计算,解决了DeepSeek V3在部分国际产品上FP8累加精度不足的难题。 正如硅基流动CEO袁进辉所言:“有算力和好用的算力之间,有一条看不见的鸿沟。”全功能架构的通用性设计,在保证速度的同时守住了精度底线。

此外,在推理侧,摩尔线程联合硅基流动,在现款旗舰卡MTT S5000上完成了DeepSeek R1 671B全量模型的适配。实测显示,单卡解码性能突破1000 Tokens/s,Prefill吞吐突破4000 tokens/s,表明国产GPU已具备承载高并发生产级推理业务的能力。

针对“好不好用”的行业顾虑,摩尔线程创始人张建中的回应或许最为贴切:“以前很多国内开发者,由于国产硬件平台的性能不够,导致开发的产品跟主流产品有一定的差距。我们今天把平台提升,就是为了努力疏解开发者的束缚。”

03 下沉终端与开源:撬动生态的支点

展区中,一款名为MTT AIBOOK的硬件产品引人注目。这款AI算力本搭载摩尔线程自研 “长江”智能SoC,拥有50 TOPS异构算力,预置基于Linux的MT AIOS系统及完整AI开发环境,甚至内置了智能体“小麦”。该产品已于12月20日在京东开启预售。

当前,多数国产芯片厂商聚焦于B端数据中心市场。此策略虽能获取大额订单,却难以触达广泛的个人开发者和学生群体。而英伟达CUDA生态的强大,很大程度上源于其消费级显卡在教育和个人领域的极高渗透率。

谈及生态建设,摩尔线程CTO张钰勃表示:“一个公司的力量是有限的。未来我们每一代的GPU,从架构开始到上面的每一层软件,我们全部都会坚持开源的路线。我们要把黑盒打开,让开发者看到底层。” 这种“开源”承诺与“终端普及”策略相结合,构成了独特的生态闭环:

- 降低门槛:AIBOOK旨在补齐国产GPU在“人才供应链”上的短板,让学生能在宿舍低成本跑通MUSA代码。

- 打通链路:提供开箱即用的验证终端,实现“端侧开发、云端部署”的无缝闭环。

- 开源共创:通过开源MUSA SDK、通信库及编译器前端,吸引高校和科研机构深度参与优化。正如清华大学翟季冬教授所言:“真正的软硬协同,是要让做硬件的人看见软件第一手的需求。”

通过将硬件下沉至C端,摩尔线程能更直接获取开发者反馈,反哺软件栈迭代。目前,其通过摩尔学院已直接触达20万开发者和全国200多所高校,这些“种子”将成为未来生态的中坚力量。

04 结语:生态密度的终极较量

透过MDC 2025,摩尔线程传递的核心信号并非参数刷新,而是其生态系统不断增长的“密度”。

从地下的盾构机到云端的DeepSeek训练,从高校的AIBOOK到前沿的量子计算框架MUSA-Q,其产品线覆盖了端到云、AI到图形、商业应用到基础科学的广泛场景。

这种全铺开的打法,初期面临巨大的研发挑战,需同时维护庞大的图形驱动与AI编译器,适配海量应用。但一旦生态成型,其构筑的市场壁垒与抗风险能力也将极高。 正如中国工程院院士郑纬民所指,发展“主权AI”的核心在于实现“算力自主、算法自强、生态自立”,其中“生态自立”是最难啃的骨头。

对国产GPU行业而言,2026年将是一个分水岭。之前的竞争更多停留在参数对标,而接下来,谁能将芯片在更多物理场景中真正驱动起来,谁能吸引更多开发者在此平台写下第一行代码,谁就将在激烈的淘汰赛中站稳脚跟。