内存正经历史上最强的涨价周期,HBM与DDR5供需失衡,AI推理的算力消耗持续飙升——全球已步入“高成本算力时代”。面对行业性的算力紧缺,优刻得通过大规模国产智算集群与新一代GPU虚拟化技术的结合,为企业提供了更可控、更高效的AI基础设施解决方案,旨在帮助企业在算力紧缩周期内,依然维持AI生产力的增长动能。

图片来源:Tiger Trade

12月4日,摩根士丹利中国团队在针对大中华区科技半导体的报告中指出,存储市场正在酝酿一场供需错配的风暴。其结论明确:内存超级周期并非尾声,而是刚刚开始。

内存价格为何持续飙升?

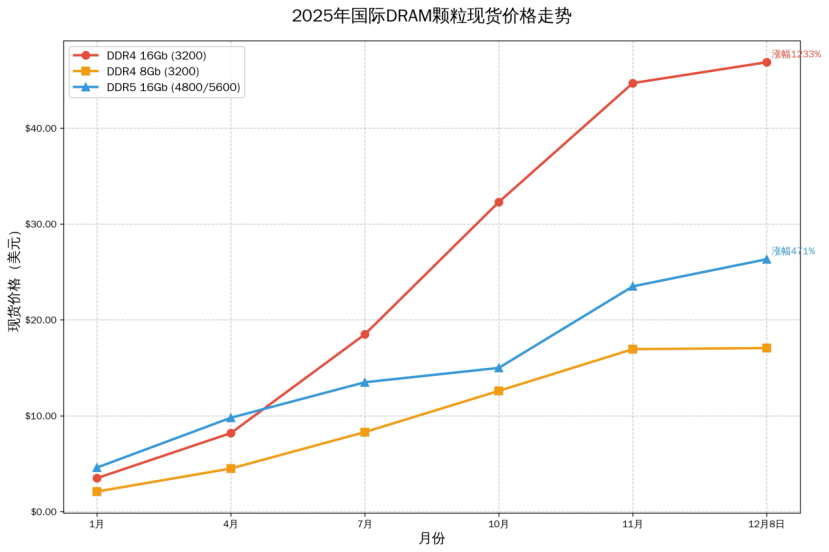

本轮内存价格暴涨的核心可归结为供需关系的结构性失衡,并在市场情绪作用下被放大:

- 需求端:AI大模型训练与推理的快速发展,导致AI服务器对DRAM和HBM的需求暴增。单台AI服务器的内存配置普遍达到2T-4T。与此同时,消费电子新品备货、云服务商大规模下单等多重需求汇聚,形成了强劲的合力。

- 供给端:三星、海力士、美光等存储颗粒制造商将产能转向利润更高的DDR5和HBM。许多DDR4产线被关停或升级,加之HBM良率较低挤占了大量晶圆产能,新增产能落地周期长,导致传统内存的供应缺口不断扩大。

- 市场端:经销商囤货溢价、模组厂批量采购消耗库存等行为,使得市场需求在涨价预期的恐慌中被进一步放大。

图片来源:全球半导体观察

AI大模型为何如此消耗内存?

在人工智能大模型发展的初期,市场需求主要由训练环节驱动。如今,推理工作负载正成为新的需求核心。训练与推理对存储系统的要求存在显著差异:训练阶段主要承担向GPU输送数据集和保存模型检查点两大任务;而推理阶段的存储链路则复杂得多,涉及模型加载、KV缓存动态管理、基于RAG的外部知识检索等多个关键流程。

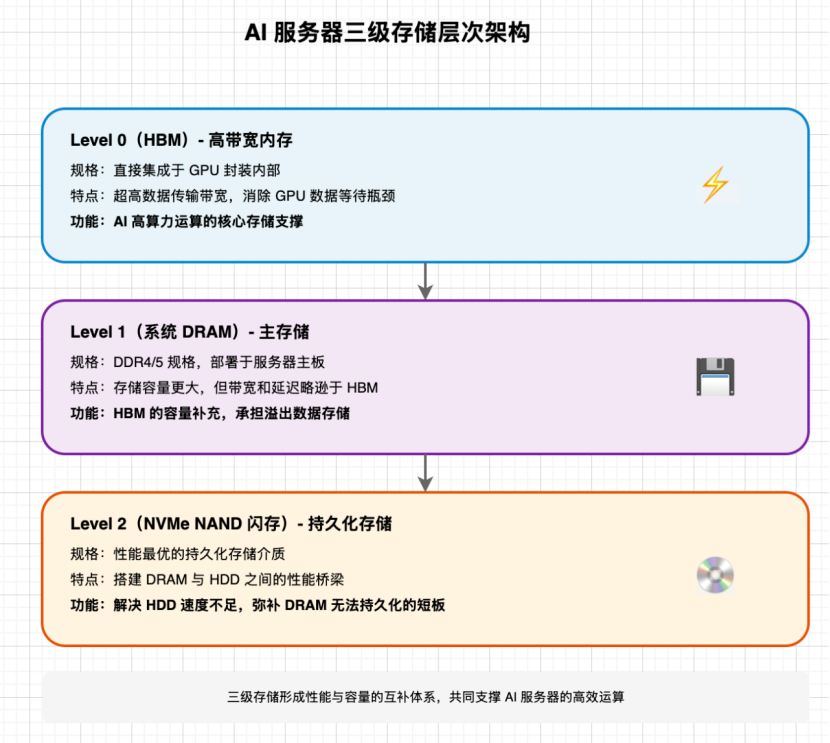

一、AI服务器的三级存储层次

AI服务器构建了清晰的三级内存/存储体系,各级之间性能与容量互补:

- Level 0 (HBM):高带宽内存,直接集成在GPU内部,提供极高的数据传输带宽,是消除GPU数据等待瓶颈的关键。

- Level 1 (系统DRAM):通常采用DDR4/5,部署于服务器主板,容量远大于HBM,主要作为HBM的容量补充。

- Level 2 (NVMe NAND闪存):作为高性能的持久化存储,连接DRAM与传统HDD,解决了速度与持久化存储的矛盾。

二、GPT类大模型的完整数据流转链路

一次典型的GPT模型查询,会触发数据在三级存储间的动态流转:

- 用户推理请求到达服务器。

- 若模型权重未加载,则从NVMe SSD读取并加载至HBM或DRAM。

- Prefill阶段:并行处理所有输入Token,并生成初始的KV缓存(模型的短期记忆)。

- 若开启RAG,系统从NVMe SSD上的向量数据库中检索相关外部知识。

- Token生成阶段:逐个生成输出,KV缓存持续增长;当超过HBM/DRAM容量时,部分缓存被卸载到NVMe SSD。

- 生成的响应及元数据,最终写入NVMe SSD进行持久化存储。

三、大模型对各层级存储的量化需求

模型权重、动态KV缓存及RAG等功能,共同驱动了PB至EB级别的海量存储需求。

-

HBM需求:静态权重与动态缓存

以MoE架构的GPT-5模型(约4.5万亿参数)为例,其推理对HBM的需求主要来自两部分:

- 模型权重:活跃专家权重需全部驻留HBM,需求约24PB。

- KV缓存:经GQA技术优化后,按58亿并发Token规模计算,需求约2.8PB。

二者合计,HBM总需求约26.8PB。

-

DRAM需求:支撑KV缓存

DRAM需求核心来自KV缓存。假设24小时内输入KV缓存重用率为50%,按每日处理38万亿Token估算,GPT-5推理所需的DRAM容量高达约9.1EB。

-

NAND需求:RAG场景是主力

NAND闪存需求的70%-80%来自RAG。考虑到数据向量化、索引构建带来的约4倍数据膨胀,以及数据中心通常需要的3倍冗余(复制、纠删码、系统开销等),若按月活用户11亿、单用户月均上传1GB RAG数据计算,年化原始数据量为66EB,实际需要的NAND存储容量将达约200EB。

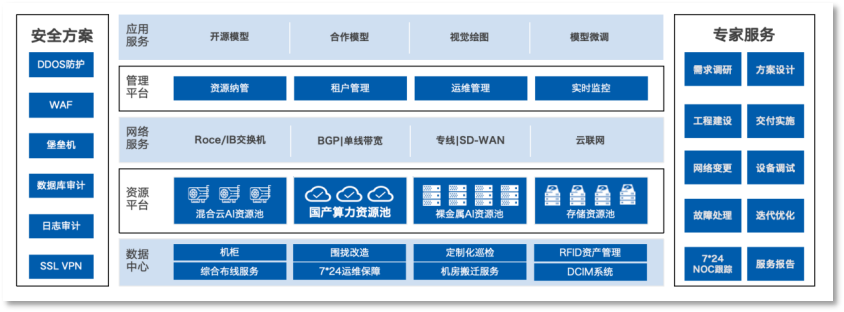

优刻得“国产集群+GPU切分”方案,全面提升算力效率

全球内存颗粒原厂暂停报价导致价格疯涨,AI算力服务器溢价严重。在此全球性AI算力短缺趋势下,优刻得积极适配国产算力生态,基于海光、龙芯、鲲鹏等国产通用CPU,以及昇腾、寒武纪、沐曦等国产GPGPU,构建了大规模云原生/IaaS智算集群。该集群提供低延迟、高吞吐的GDR(GPU Direct RDMA)运行环境,结合配套的高性能存储与UK8S容器服务,能够快速构建大数据分布式训练环境,满足千亿参数大模型的训练与推理需求。目前,优刻得上海青浦智算中心已落地国产千卡级智算集群。

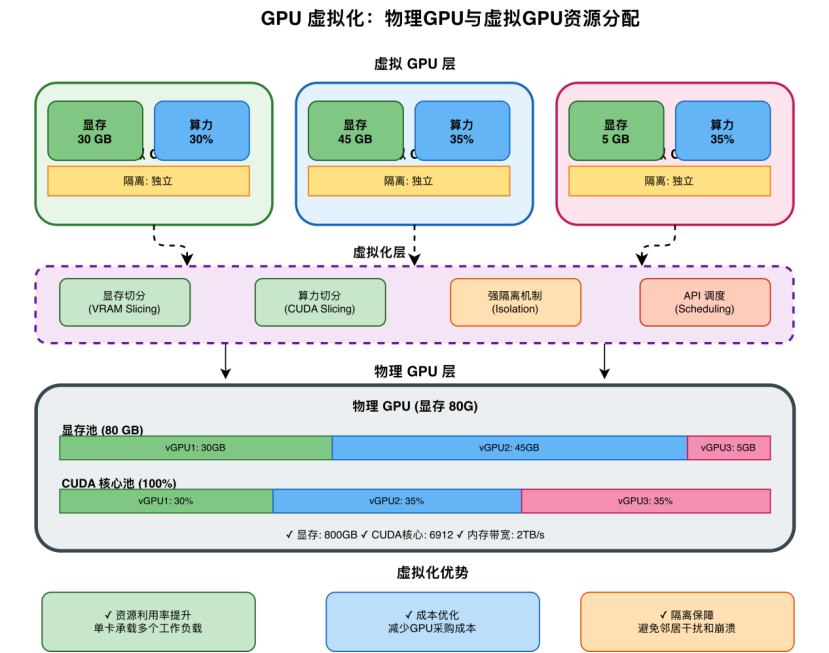

针对企业在AI任务中普遍存在的GPU资源浪费、利用率不足等痛点,优刻得正式发布了新一代GPU虚拟化技术。该技术提供显存与算力的双维度精细化切分能力,可将单张物理GPU拆分为多个独立的虚拟算力单元,最小切分粒度可精确至10%。这使得单卡能够同时承载多个AI工作负载,在模型推理服务、开发测试、科研教学等场景中,显著提升GPU资源利用率。

依托国产化算力底座与精细化的GPU虚拟化能力,优刻得正在构建一个更具弹性、更高利用率、更具成本效益的AI算力服务体系。通过持续的技术创新,推动算力资源得到充分释放,助力企业在AI需求爆发的时代,实现更高效、更可持续的智能计算生产力。 |