本文基于Google十年来的OCS研发与部署经验,从TPUv4的48台OCS原型验证,到TPUv7 Ironwood的14万卡级Jupiter网络大规模商用,深度复盘了OCS如何从边缘辅助设备演变为承载ICI(Inter-Chip Interconnect)协议的“内存语义织物(Memory Semantic Fabric)”。文章进一步跳出Google视角,横向剖析了2025年技术产业界爆发的MEMS、Piezo、Robotic、SiPh硅光四大技术流派,并结合Lumentum R300商用化进程以及CPO的演进路径,预判了未来CPO和OCS融合的百万卡全光计算织物演进。

1 Google OCS光路解耦演进

目前,世界上唯一实现OCS大规模商业化应用的恐怕只有Google。从早期的Apollo项目探索到Ironwood架构落地,从TPUv4的3D Torus拓扑到Jupiter DCN网络中Spine层的全面光化,OCS的角色发生了根本性转变。它从最初的流量工程工具,演变为计算架构的内生组件,实现了从微观计算单元到宏观数据中心架构的物理层解耦与重构。无论是48台OCS组建3D Torus连接4096颗TPUv4的Pod,还是1024台OCS支撑起147,456颗TPU v7 Pod的超大规模互联网络,OCS都已成为Google打破数据中心物理限制、实现算力线性扩展的关键。

1.1 ICI网络革命:从48台OCS构建TPUv4 Pod到3D Torus范式

在ICI专用网络层面,OCS的引入彻底改变了超算集群的拓扑构建方式。Google在NSDI 2023年发表的论文中首次披露,仅用48台自研的Palomar OCS,就构建了一个标准的3D Torus Pod拓扑,成功支撑起4096颗TPUv4芯片的互联。

其核心创新之一在于Palomar OCS基于3D MEMS镜面阵列技术。Google采用了136x136的端口配置,通过精密的MEMS微镜阵列,在不经过任何光电转换的情况下,直接在物理层实现了芯片间的高速光互联。值得注意的是,OCS的成本不到系统总成本的5%,功耗不到3%,却支撑起了比传统Infiniband网络更大规模的无阻塞互联。

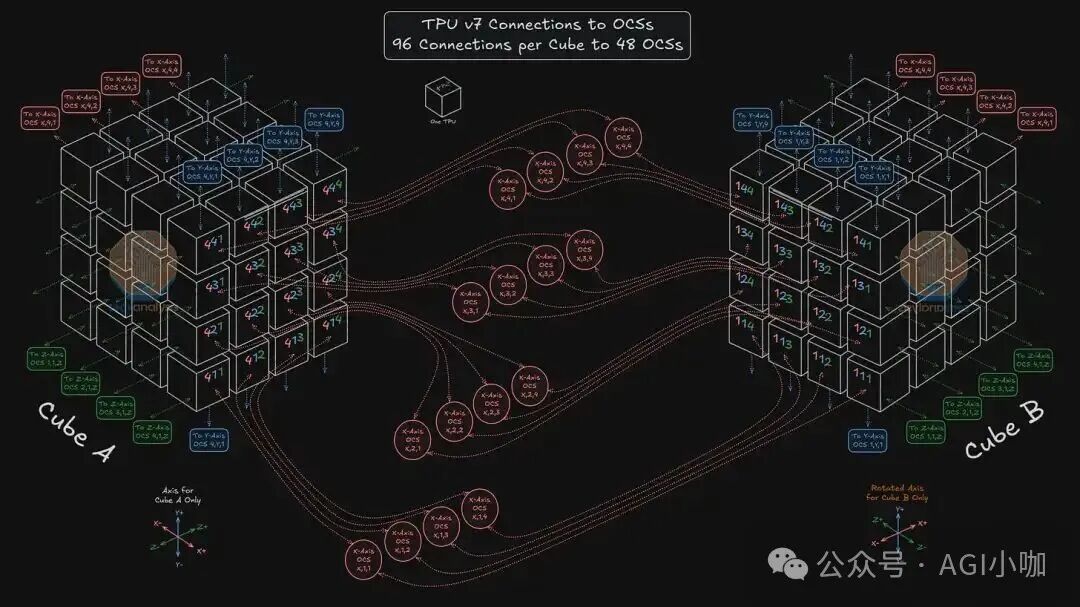

1.2 ICI演进:TPUv7 Ironwood与Twisted 3D Torus的软硬协同

随着大模型参数规模突破万亿级别,对互联架构提出了更高要求。Google在2025年Hot Chips峰会上展示了最新的TPUv7 Ironwood架构。为了支撑单Pod扩展至9,216个芯片,Google引入了更为复杂的Twisted 3D Torus拓扑,通过增加长距离跳线连接来提高对剖带宽和降低网络直径。

Ironwood搭载了新一代ICI,总带宽达到9.6 Tb/s。配合OCS,它实现了超大规模的内存统一寻址,构建了1.77 PB的全局HBM内存池,打破了单芯片显存容量的物理限制,为万亿参数模型的全量加载提供了硬件基础。这一物理层架构的成功,离不开上层云原生/IaaS技术栈的深度支撑,特别是Orion SDN控制器与XLA编译器的协同优化。

图1:TPUv7 Cube A与Cube B连接48台OCS

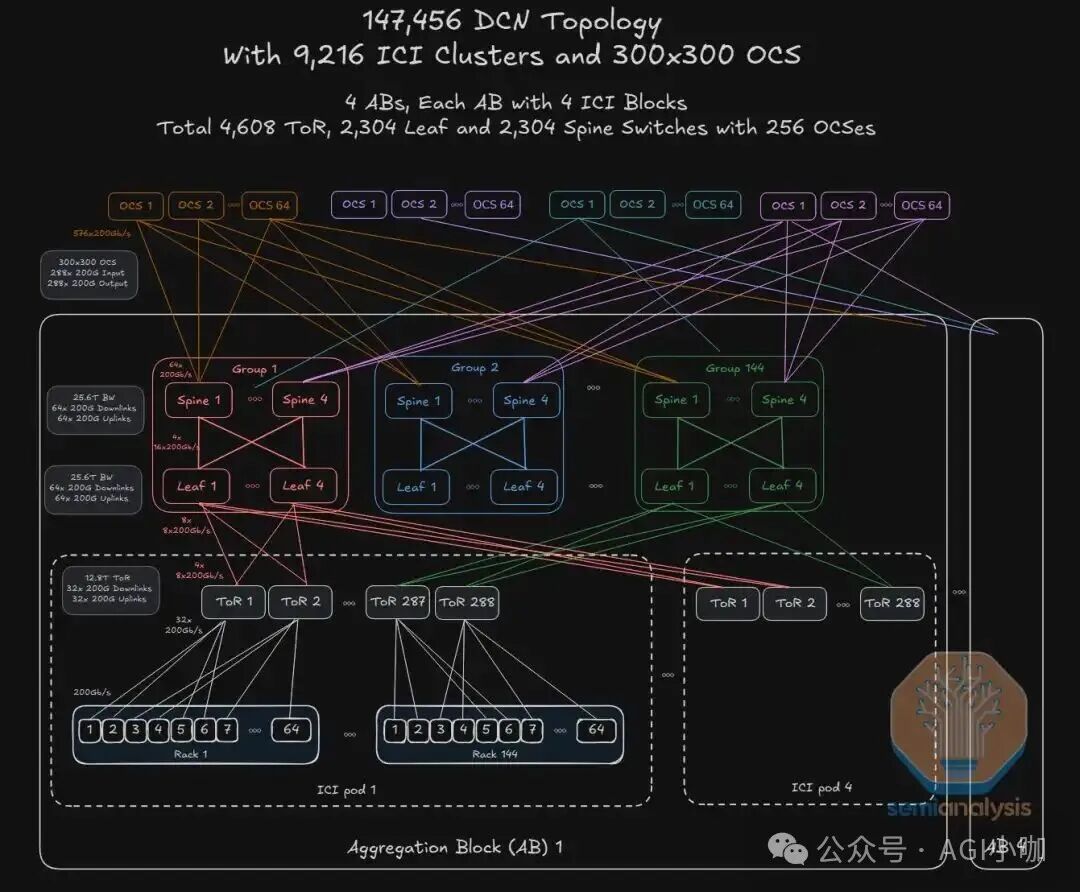

1.3 Jupiter DCN范式转移:OCS重构骨干网迈向14万卡集群

如果说ICI网络是OCS在专用超算领域的胜利,那么Jupiter DCN的演进则标志着OCS在通用数据中心骨干网层面的全面突围。自2022年起,Google开始在生产环境的Jupiter DCN网络中大规模部署OCS,并在SIGCOMM发表了里程碑式的论文。

在Jupiter Evolving架构中,OCS替代了传统的电聚合交换机。这一替换不仅节省了数以万计的光电转换模块,更重要的是在物理层卸载了流量工程。通过集中式SDN控制平面,网络可以根据实时业务负载动态调整光纤链路的物理连接,实现流级调度。据测算,基于OCS的Jupiter Evolving架构为Google节省了超过300亿美元的资本支出。Apollo OCS波长与端口速率无关的特性,使得Spine层交换机从400G升级到800G乃至1.6T时,无需更换核心OCS设备,这奠定了其市场优势。

在最新的Ironwood部署中,仅用约256台Apollo OCS就替代了庞大的Super-Spine电交换集群,成功支撑起147,456颗TPU v7的超大规模互联。为了驾驭复杂的全光网络,Google构建了从感知(CSIG遥测)、传输层硬件卸载(Falcon协议)到全局调度(Orion)的全栈协同体系。

图2:14万颗TPU+1024台OCS全景图

1.4 供应链双轨制:内修与外扩

为保障OCS和TPU芯片大规模交付的安全与成本可控,Google实施了严格的供应链双轨策略:

- 路线一(内部80%):核心产能基于Google自研的Apollo协议及定制化硬件。核心MEMS微镜阵列的IP由Google掌握,由瑞典Silex Microsystems进行晶圆代工,最终的系统集成与测试由Celestica完成。这一闭环确保了核心技术栈的私密性与成本控制。

- 路线二(外部20%):引入Lumentum(及其R300平台)和Coherent作为商用供应商。通过采购符合OCP规范的商用OCS设备来进一步降本增效,同时用市场需求倒逼OCS技术的行业标准化和产业链成熟。

2 OCS四大技术流派的工程实现与横向对比

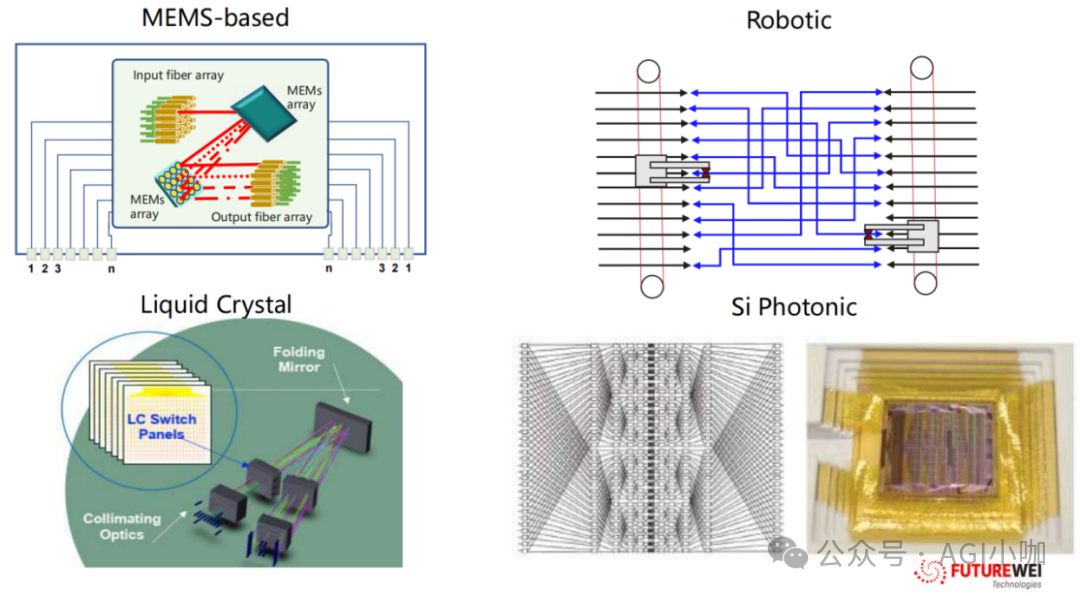

综合行业分析,2025年OCS技术主要分为以下4种流派:

流派一:Google 3D MEMS

目前技术相对最成熟的方案。通过高压静电驱动的2D Mirror Array在3D空间内实现光束的精密偏转与交叉连接。得益于MEMS OCS对波长和速率的天然透明性,它克服了硬件迭代压力。除了Google,Lumentum发布的R300也实现了300x300端口规模,且插入损耗控制在 <1.5dB。

流派二:Piezo(压电陶瓷)

利用压电材料的逆压电效应驱动光纤准直器进行物理位移来实现光路切换。核心优势在于速度与暗光纤特性,可实现纳秒级切换速度且光学损耗极低。在对时延极度敏感的金融高频交易及量子计算网络中占主导,但受限于致动器体积,难以实现超高端口密度。

流派三:Robotic(机械臂/自动跳线)

在标准机架内使用精密的机械臂物理地抓取并插入光纤接头,本质是一个全自动化的配线架。Telescent提供的方案主要用于解决大规模光纤管理的复杂性,实现数据中心内部物理布线的自动化,其缺点是故障切换时间较长(秒级至分钟级)。

流派四:SiPh硅光

利用马赫-曾德尔干涉仪或微环谐振器在硅基芯片上实现光路开关。剑桥大学的研究展示了基于SOI平台的4x4x4λ空间波长选择开关,实现了纳秒级切换速度和紧凑尺寸,具备真正的“光包交换”潜力,是CPO时代的理想搭档。当前主要瓶颈在于插入损耗较高和偏振敏感性。

图3:主流OCS技术实现路径示意图

| 维度 |

3D MEMS |

Piezo |

Robotic |

SiPh |

| 产业代表 |

Google / Lumentum |

Huber+Suhner (Polatis) |

Telescent |

Enablence / Cambridge |

| 切换机制 |

微镜翻转 |

压电对准 |

机械臂插拔 |

热光效应 |

| 切换速度 |

ms |

ns/µs |

s |

ns |

| 插入损耗 |

<2 dB |

<1.5 dB |

<0.5 dB |

>3 dB |

| 应用场景 |

AI训练集群核心交换 |

量子网络、HFT |

物理层重构、运维 |

CPO集成、边缘交换 |

| 成熟度(2025) |

商用主流 |

特种商用 |

试商用 |

研发/早期商用 |

表1:四大技术流派横向对比矩阵

3 生态融合与行业展望

Google OCS的核心MEMS芯片制造高度依赖瑞典的Silex Microsystems。Silex拥有顶尖的纯MEMS代工工艺,能满足Google对镜面平整度、一致性和良率的极高要求。

Lumentum作为Google最大的光学组件供应商,其角色正从纯组件商向子系统供应商转型。其最新发布的R300(300x300端口)和R64系列OCS产品已获得部分超大规模客户送样,旨在为其他云厂商提供标准化设备以搭建全光集群,降低人工智能计算准入门槛。

随着网络架构向全光演进,传统可插拔光模块面临价值被稀释的风险。行业龙头通过研发光交换子系统提前布局,以占据未来光交换节点的价值链。

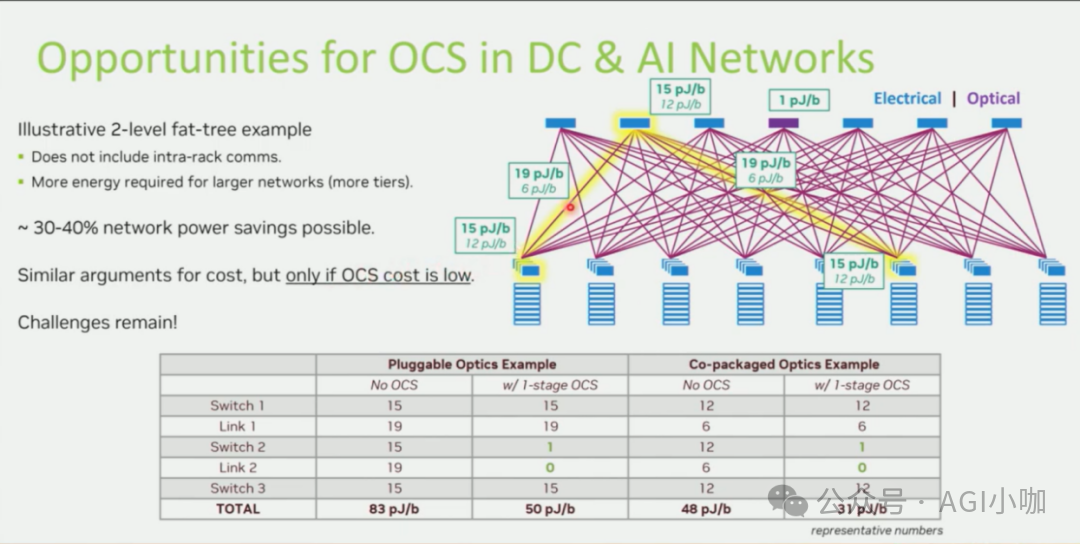

OCS技术的发展终将与CPO(共封装光学)技术在未来的某个奇点交汇。预计在2026-2028年,CPO将进入规模化商用阶段。CPO将光引擎直接封装在计算芯片的基板上,极大地缩短电信号传输距离,提高带宽密度。正如行业展示的数据模型所示,在CPO时代引入OCS,有望通过消除Spine层电交换机的开销,将网络/系统整体能耗进一步降低30%-40%。

图4:OCS与CPO结合带来的能效优势分析

CPO解决了芯片出光的“第一公里”密度问题后,单芯片带宽可达51.2T以上。如此巨大的带宽必须直接接入OCS进行全光路由,否则电交换机将面临过热和布线无法管理的难题。NVIDIA展示的基于硅光的Spectrum-X/Quantum-X概念,已经预示了交换芯片内部集成光路的大趋势。

未来,数据中心架构可能演进为“全面CPO计算单元 + 一层OCS交换层 + 编排调度控制层”的模式。数万个CPO计算节点通过高端口密度的OCS互联,编译器不仅能生成计算拓扑,还能生成网络拓扑。对于每一个训练任务,OCS都可以物理地重构出一个最优的互联拓扑。当CPO与OCS分别解决了出芯片和跨机柜的光互联问题,数据从HBM流出后将可能在全光域内完成流转,最终构建起真正的行星级全光计算织物。