新年伊始,当Qwen发布Image-2512模型时,DeepSeek团队在arXiv上悄然公开了论文《mHC: Manifold-Constrained Hyper-Connections》(arXiv:2512.24880),这无疑是其在深度学习基础架构领域投下的一颗重磅炸弹。本文旨在解析mHC架构如何通过流形约束重构ResNet的经典残差连接。

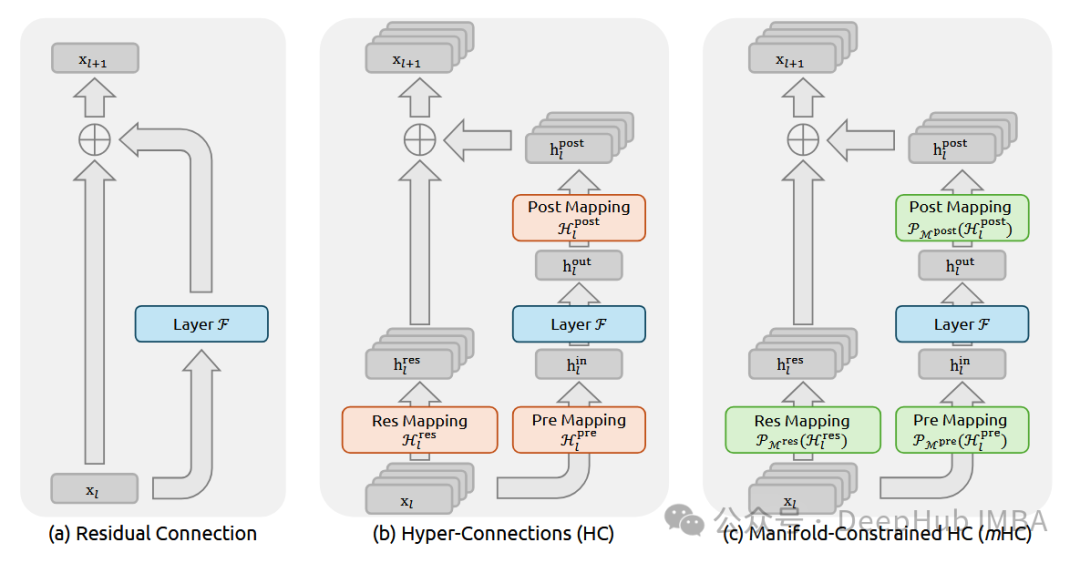

当前主流大模型的底层架构,基本依赖于堆叠Transformer模块。而过去十年间,对于层间堆叠的处理,ResNet所提出的残差连接公式y = x + f(x)几乎被视为行业“公理”。它通过恒等映射(Identity Mapping)确保了信号在前向传播中无损传递,同时梯度在反向传播中也能顺畅回流,这是我们将模型深度扩展至数百甚至上千层而保持稳定的关键。

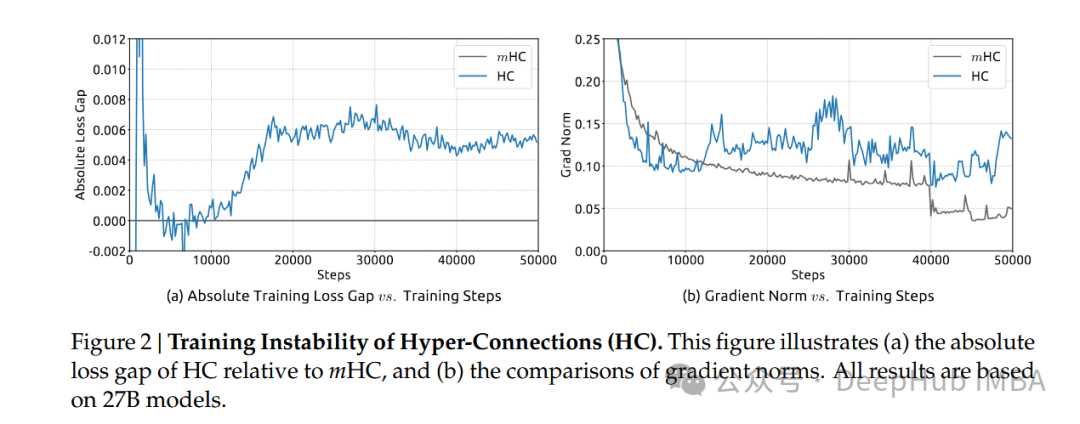

然而,DeepSeek团队在去年九月左右提出的超连接(Hyper-Connections,HC)概念,对简单的相加操作提出了挑战。HC旨在通过更复杂的连接方式拓宽层间的信息通路,但一旦改变了“相加”这一核心操作,恒等映射的特性便会丧失,随之而来的是梯度传播的不稳定,这种现象被团队称为“跷跷板效应”(Seesaw Effect),极易导致训练崩溃。

这篇最新的mHC论文,正是为了填补这一理论漏洞而诞生的。

mHC的核心:流形约束

mHC的核心创新在于引入了“流形约束”。简单来说,之前的HC允许连接权重自由学习,结果导致了模型行为的“失控”;而mHC则为这些权重矩阵施加了数学上的限制。DeepSeek在论文中从数学上证明,通过将超连接的权重矩阵强制投影到一个特定的流形空间,能够在保留HC高带宽、多通路优势的同时,重新找回近似恒等映射的属性。

这相当于在数学层面构建了一个“鱼与熊掌兼得”的结构:既要求连接方式足够复杂,以捕捉更高级的特征交互;又要求信号传播像ResNet一样平滑稳定,避免在深层网络中迷失方向。

具体而言,这里的“流形”由两个关键的数学性质定义:

- 谱范数约束:强制要求连接矩阵W的谱范数 ∥W∥₂ ≤ 1。这在动力系统理论中被称为“非扩张”性质。只有当矩阵的最大奇异值被限制在1附近,信号在深层传播时的能量才不会爆炸性增长或衰减。

- 双重随机矩阵:这是一类行和与列和均为1的非负矩阵。它具备极佳的闭包性——任意两个双重随机矩阵的乘积仍然是双重随机矩阵。这一性质保证了无论网络堆叠多深,整体变换的数学特性保持不变。更重要的是,这使得每一层的输出成为其输入的凸组合,从理论上奠定了训练稳定性的基础。

论文包含了扎实的理论推导,对信号传播的分析尤为深入,直接指出了先前架构在超深层网络中遭遇瓶颈的根源,并阐明了mHC如何通过约束奇异值分布来解决这一问题。(值得一提的是,DeepSeek的实验规模也反映了其研究实力的增长——mHC实验使用了27B参数模型,而早期HC论文仅使用了7B模型。)

从动态系统视角看稳定性

论文中有一段精彩的理论分析,是从动态系统的角度审视深层网络。如果将网络层数视为离散的时间步,那么一个深度网络就是一个离散动态系统。该论文证明,在流形约束下,该系统的李雅普诺夫指数是可控的。通过一种类似“投影”的技术,确保权重矩阵在迭代更新过程中始终保持良好的谱性质。通俗地讲,这意味着无论参数如何更新,这些矩阵在数学上必须始终近似于一个“略微扭曲的恒等矩阵”,而非一个完全随机、性质未知的矩阵。

这部分理论工作,为理解mHC为何能稳定堆叠至成百上千层提供了坚实的数学解释,是对现有神经网络的深层稳定性理论的重要补充。过去我们或许只知道“加入残差连接有效”,而现在mHC告诉我们:“只要沿着正确的流形路径前进,即使采用更复杂的连接方式,系统依然稳健。”

系统效率与未来影响

熟悉DeepSeek研究风格的读者知道,他们从不空谈数学,必定会兼顾系统效率。mHC架构显然经过了严格的基础设施优化。如果一种新架构仅理论优美却严重拖慢训练速度,DeepSeek绝不会采纳。论文中提到,这种特殊的连接方式配合专门优化的CUDA内核,可以将额外的计算开销压缩到几乎可以忽略不计的水平。

这带来一个极具吸引力的前景:在几乎不增加算力成本的前提下,显著提升了模型的表达能力上限,且在实际的大规模训练中未造成明显的吞吐量损失。

那么,这对行业意味着什么?

这可能预示着“后Transformer时代”的一个重要方向。以往我们扩展模型,主要依赖于简单地增加层数或宽度,属于“堆料”式发展。而mHC揭示了一个新的维度:层与层之间的拓扑结构本身,尚存在巨大的探索空间。

如果这种基于流形约束的连接方式能够成功扩展到万亿参数级别(论文指出其在671B的MoE模型上验证有效),那么未来设计大模型的思路将发生转变——我们不仅需要研究“积木”(模块)本身,更需要精心设计“积木之间的粘合剂”(连接方式)。

mHC的出现不仅修复了Hyper-Connections的缺陷,更重要的是将深度学习架构设计的视角,从单纯的“连接图”提升到了“参数流形”的高度。随着基础模型对效率与能力的要求日益严苛,mHC所代表的几何约束设计理念,极有可能成为未来几年AI基础设施演进的核心范式之一。

论文链接:https://arxiv.org/abs/2512.24880

本文对前沿AI架构进行了深度解读,更多关于计算机科学原理、架构设计与优化的讨论,欢迎访问云栈社区进行交流。