随着人工智能训练、高性能计算 (HPC) 和大规模数据处理的需求持续增长,GPU 已成为现代计算架构的基石。在 NVIDIA GPU 架构中,CUDA Core 是最基础、最关键的计算执行单元。

本文将对 CUDA Core 进行系统而深入的分析——从基本概念到架构设计——阐明其在 NVIDIA GPU 生态系统中的作用。

一、什么是CUDA Core?

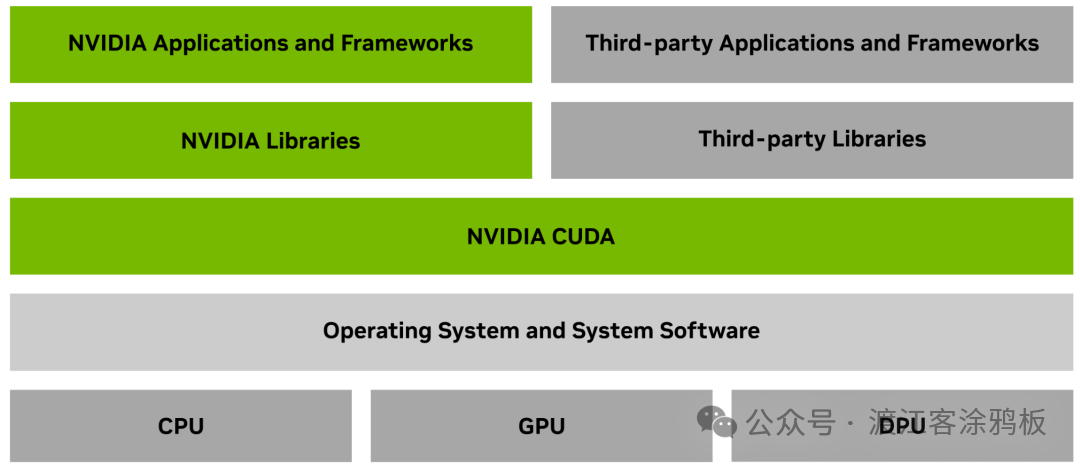

要理解 CUDA Core,首先需要了解 NVIDIA CUDA(Compute Unified Device Architecture)。CUDA 是一种专有的并行计算平台和编程模型,是 GPU 加速计算的基础。 它能够帮助开发人员“解锁” GPU 的强大算力,将大量并行任务(如图形渲染、AI 训练和数值模拟)从 CPU 卸载到 GPU 上执行。

CUDA Core 是 NVIDIA GPU 中独立的并行处理单元。 在 NVIDIA GPU 架构中,核心计算资源主要由三类单元构成:CUDA Core、Tensor Core 与 RT Core。CUDA Core 是专为多线程性能设计,能够同时处理数千次计算,因此对于那些可分解为并行进程的任务来说,效率极高。

二、CUDA Core在NVIDIA GPU中的作用

CUDA 平台为开发人员提供了直接访问 NVIDIA GPU 并行计算能力的途径,包括虚拟指令集和内存层次结构。借助 CUDA,GPU 不再局限于图形渲染,还能处理计算密集型工作负载,从而显著减轻 CPU 负载,让 CPU 能专注于其他系统任务。

在 CUDA 架构中,CUDA Core 负责执行实际的数学计算。 它们作为并行执行的基本处理单元,运行由 CUDA 程序调度的计算任务。通常,拥有更多 CUDA Core 的 GPU 可以同时处理更大规模的并行任务,从而获得更强的并行计算性能。

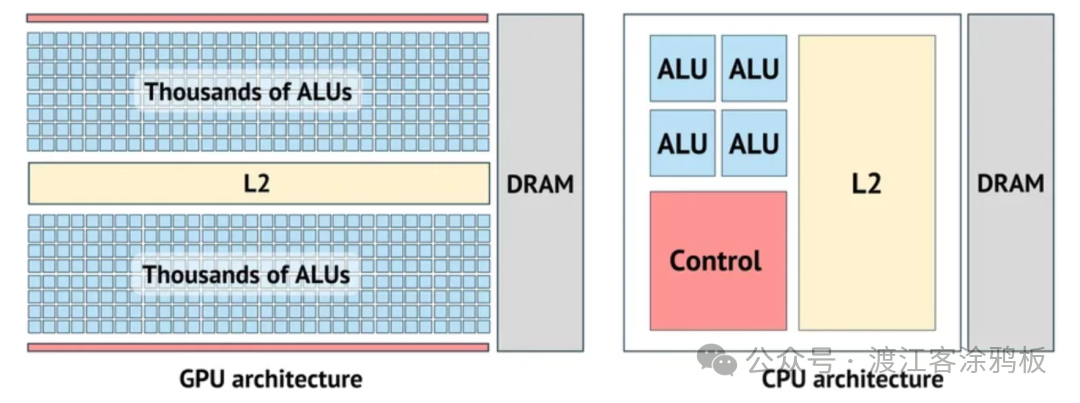

从概念上讲,CUDA Core 常与 CPU Core 类比,但两者的设计目标和运行模式差异显著。CPU 核心针对顺序执行进行优化,通常处理数量有限的软件线程。相比之下,CUDA Core 属于大规模并行架构,能够同时调度和执行数万个线程。

这种并行架构特别适合能够分解为独立计算步骤的工作负载。例如,在图像处理中,每个像素可以独立处理,从而将任务分配到多个 CUDA Core 并行执行,显著提升了吞吐量。

三、CUDA Core设计架构

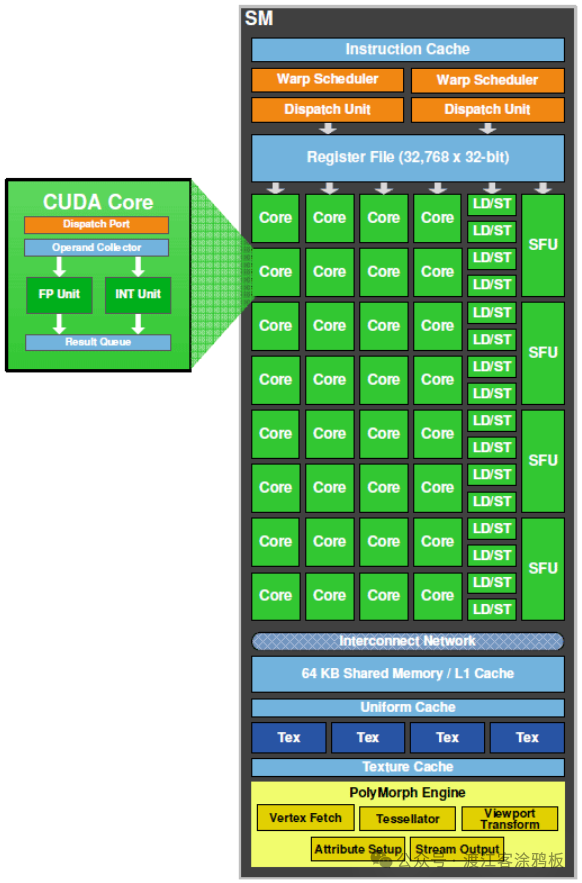

CUDA 的基本计算单元是流式多处理器(SM)。在硬件架构方面,多个 CUDA Core 集成到一个 SM 中,单个 SM 可以同时调度和执行数百个线程。这是 CUDA 高吞吐量并行计算能力的关键基础。

此外,每个 SM 模块都包含各种计算单元:CUDA Core(整数和浮点运算)、Tensor Core(AI 矩阵运算)和 Ray Tracing Cores(图形渲染)。以 2022 年发布的 Hopper 架构为例,单个 H100 GPU 包含 144 个 SM 模块,每个 SM 配置有 64 个 CUDA Core 和 8 个 Tensor Core,支持超过 200 万个并发线程。

CUDA Core 架构包含几个关键组件:

- 算术逻辑单元: 用于执行各种算术和逻辑运算,是 CUDA Core 承担主要计算任务的部分,广泛应用于图形处理和物理模拟。

- 寄存器文件: CUDA Core 内部的高速存储区域,用于存储计算过程中所需的变量和中间数据。寄存器文件的大小和访问效率直接影响核心性能。

- 共享内存: 同一 SM 内的多个 CUDA Core 可以访问一个低延迟的共享内存,用于核心间的数据交换和同步,从而减少访问全局内存的开销。

除了基本的整数和浮点计算能力,CUDA Core 还支持三角函数、指数运算、对数运算等复杂的数学运算,能够适应各种计算类型。同时,CUDA Core 可以访问 GPU 的多级内存架构,为不同的计算场景提供灵活的数据访问方式。

四、CUDA Core vs. CPU Core

CUDA Core 和 CPU Core 都执行计算任务,但它们在架构、设计目标和理想用例上存在显著差异。

设计架构

CUDA Core 是 GPU 高度并行计算架构中的基本执行单元,设计重点在于大规模并行处理能力。GPU 通过大量 CUDA Core 同时运行数千个线程,适合执行结构相对一致、并行性高的计算密集型任务,这正是现代 人工智能 和 高性能计算 场景的核心需求。

相比之下,CPU Core 更侧重于低延迟的顺序处理能力。每个 CPU Core 通常同时处理有限数量的线程,但对复杂的控制逻辑、条件判断和分支执行具有更强的处理能力,更适合以串行为主或并行度较低的工作负载。

性能与效率对比

凭借其并行架构,CUDA Core 在可并行化任务(如图像处理、科学计算和机器学习训练)中可以实现极高的性能。然而,当任务涉及大量分支判断或复杂的决策逻辑时,CUDA Core 的效率可能会受到限制;这类任务则更适合 CPU Core。CPU Core 功能更丰富,能处理更广泛的任务,但在可并行化任务上可能不如 CUDA Core 高效。

内存访问

CUDA Core 可以访问 GPU 特有的多级内存,包括全局内存、共享内存和线程本地内存。合理利用不同类型的 GPU 内存资源是提升 CUDA 程序性能的关键因素。CPU 则采用由寄存器、高速缓存和主内存(RAM)构成的分层内存结构。

编程与软件

为 CUDA Core 开发需要并行编程经验。NVIDIA 的 CUDA 平台和编程模型允许开发人员使用 C、C++ 和 Fortran 等语言编写并行程序,从而充分利用 GPU 的并行计算能力。相比之下,CPU Core 在编程语言和开发范式上更为灵活,支持更广泛的软件生态系统,并与各种操作系统和开发工具兼容。

总而言之,CUDA Core 在并行计算密集型任务中具有明显优势,而 CPU Core 在通用计算和复杂控制逻辑方面表现更为稳定。CUDA Core 就像一个协同工作的团队,擅长同时处理大量相似任务;而 CPU Core 则更像全能专家,善于处理需要复杂逻辑判断的多样化工作负载。

五、CUDA Core的实际应用

游戏

在游戏中,图形质量和帧率对用户体验至关重要。随着对沉浸式视觉效果需求的增长,GPU 性能成为关键因素。CUDA Core 通过加速图形渲染和物理计算来提升游戏性能。

阴影、纹理映射和抗锯齿等渲染任务涉及大量并行计算。例如,在着色过程中,每个像素可以独立处理,允许多个 CUDA Core 同时渲染像素。这种并行性显著减少了渲染时间,实现了更流畅、更逼真的视觉效果。

CUDA Core 在游戏物理模拟(包括碰撞检测和流体动力学)中也扮演着重要角色。将这些计算卸载到 GPU 上,可以实现更真实、更身临其境的游戏体验。

机器学习与人工智能

机器学习工作负载,尤其是深度学习,严重依赖大规模矩阵运算,这些运算高度并行,非常适合 CUDA Core。

在神经网络训练期间,单个神经元的计算通常可以独立进行。这些操作可以分布在数千个 CUDA Core 上,从而显著缩短训练时间,并支持训练更大、更复杂的模型。

CUDA Core 在推理阶段(即使用训练好的模型对新数据进行预测)同样至关重要。在自动驾驶和语音识别等实时应用中,CUDA Core 有助于提供更快的推理速度和更低的延迟。

人工智能的许多子领域,包括计算机视觉和自然语言处理,也受益于基于 CUDA 的加速。图像识别和语言翻译等任务涉及大量并发计算,可以高效地映射到 CUDA Core 上。

六、核心数量越多越好吗?你需要多少CUDA Core?

所需的 CUDA Core 数量取决于具体的应用场景和计算负载。 不同类型的任务对并行计算能力的要求差异显著。

- 游戏需求: 通常需要 3,584 至 4,864 个或更多 CUDA Core。在游戏应用中,CUDA Core 主要用于图形渲染和物理计算。图形复杂度和分辨率越高,对并行计算能力的需求就越大。需要注意的是,CUDA Core 数量并非唯一决定因素。GPU 架构、CUDA Core 以及 Tensor Core、RT Core 等专用单元的协调也显著影响实际游戏性能。

- 内容创作: 通常需要 8,704 个或更多 CUDA Core。在视频编辑、3D 建模、动画渲染和图形设计等内容创作场景中,CUDA Core 数量直接影响工作流效率。更多的 CUDA Core 可加速渲染、特效计算和编/解码过程,显著缩短项目处理时间。

- 机器学习与人工智能: 通常需要 10,572 至 16,384 个或更多 CUDA Core。在机器学习和 AI 应用中,CUDA Core 主要用于并行矩阵计算。模型结构越复杂、数据集越大,对 CUDA Core 的需求就越高;而较简单的模型或小规模训练任务对核心的需求则相对较低。在模型训练中,更多的 CUDA Core 可以并行处理更多数据,显著缩短训练周期。在推理中,CUDA Core 的数量直接影响吞吐量和响应速度。例如,拥有 10,000 个以上 CUDA Core 的高端 GPU 已成为深度学习训练和 AI 开发的常见选择,而拥有 16,000 个以上 CUDA Core 的设备则更适合大模型训练和高负载推理任务。

- 科学模拟: 通常需要 16,384 个或更多 CUDA Core。在物理、化学、生物和工程模拟等科学计算场景中,需要进行大规模数值计算和复杂模拟。高数量的 CUDA Core 可以显著缩短计算周期,提高模拟精度和效率,适用于高性能计算和科学研究场景。

七、选择CUDA Core时需考虑的关键因素

- 架构与核心效率: 评估 CUDA Core 数量时不应脱离 GPU 架构。由于指令执行、调度和缓存设计等方面的改进,更新的架构通常能带来更高的单核心性能。

- 系统平衡: GPU 性能必须与 CPU 性能、内存容量和存储带宽相平衡。性能羸弱的 CPU 或内存不足可能会成为瓶颈,即使搭配最强大的 GPU 也是如此。

- 功耗与散热: 通常,更多的 CUDA Core 意味着更高的功耗和发热量。电源供应能力、散热解决方案和机箱风道直接影响系统的稳定性和持续性能。

- 性价比与实际工作负载: 更高的 CUDA Core 数量会增加硬件成本。在利用率较低的场景下,大部分性能可能被闲置。最佳的 GPU 选择应在实际工作负载需求和预算约束之间取得平衡。

- 软件生态与兼容性: CUDA 版本支持、驱动稳定性以及与 TensorFlow、PyTorch 等主要框架的兼容性,通常比单纯的 CUDA Core 数量更能决定实际性能。

CUDA Core 数量是衡量 GPU 并行计算能力的一个重要指标,但并非越多越好。 不同的应用场景对 CUDA Core 数量的需求差异显著。合理的 GPU 选择应基于对应用类型、系统配置、功耗散热条件以及软件生态系统的综合评估。只有与实际工作负载相匹配的 CUDA Core 规模,才能真正转化为可感知的性能提升。

结束语

CUDA Core 是 NVIDIA GPU 的基本计算单元,负责处理高度并行的计算任务。通过 CUDA 架构,GPU 不仅能高效处理图形渲染,还在 AI、科学计算和大规模数据处理等领域发挥着关键作用。了解 CUDA Core 的架构设计和应用特性,有助于充分挖掘 GPU 计算潜力,优化计算任务性能。如果你想了解更多关于并行计算和硬件架构的深度解析,可以关注 云栈社区 的相关技术讨论。