很多人选购服务器时,第一眼就看CPU主频,认为越高越好?这可不一定。

我曾遇到过这样一个真实的坑:采购了一批标注着高主频的机器来跑数据库,实际性能表现却反而不如之前主频较低的一批老机器。问题出在哪里?核心架构不同。这就好比开着法拉利跑车,却堵在晚高峰的二环路上,速度可能还不如旁边骑电动车的大爷。

要真正量化评估CPU性能,我们需要从多个维度入手。

1. 最易被忽视的:指令集与微架构

即便核心数相同、标称主频一致,如果采用更新的微架构(例如Cascade Lake对比Broadwell),其性能差异也可能是巨大的。这里的核心指标是 IPC(每时钟周期指令数)。这个关键参数通常不会出现在供应商的宣传彩页上,需要我们通过实际测试来揭示。

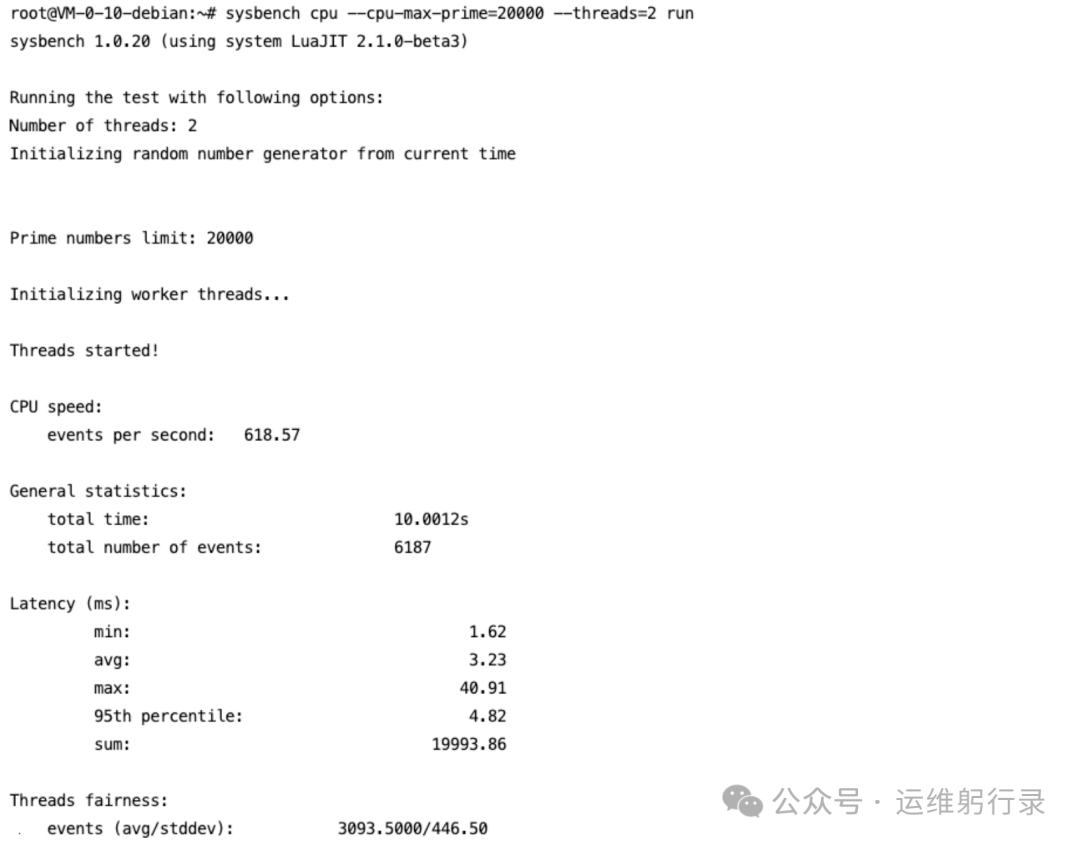

2. 实战测试:Sysbench

Sysbench是一款多功能的基准测试工具,用于测试CPU性能非常直观。

它的CPU测试原理是计算质数。虽然这看起来是一项简单的数学任务,但对CPU的整数运算单元构成了持续且可重复的计算压力。

测试示例:

如果系统未安装,请先安装:

apt update

apt install -y sysbench

假设你想全面测试机器的“实力”,可以启用4个线程(假设机器为4核),计算至20000以内的质数。

sysbench cpu --cpu-max-prime=20000 --threads=4 run

这里需要注意 线程数(--threads) 这个参数。如果你想评估单核性能,就设置为 --threads=1。许多业务(如早期Redis的单线程模型,或Node.js的主进程)非常依赖单核性能。此时核心数量再多也无济于事,单核性能弱就是根本性的瓶颈。

如果你想测试机器满载时的表现,则将 --threads 设置为CPU的总逻辑核心数。

如何解读结果?

不要只看 total time,这太笼统。应该关注 events per second(每秒事件数)。

CPU speed:

events per second: 618.57

如果A机器跑出1500分,B机器只有1200分,性能高下立判。

3. UnixBench:业界的经典综合测试

虽然这个工具的“年龄”可能比许多刚入行的工程师都大,但其综合跑分(Index Score)仍然具有很强的参考价值。它不仅仅测试计算能力,还包括文件复制、进程创建、管道吞吐、系统调用开销等多个维度。

这对于评估Web服务器性能尤其有参考意义,因为Web服务经常涉及进程派生、管道通信和系统调用。

执行测试(耗时较长,通常需要30分钟以上):

./Run

测试完成后会给出一个总分。在早年,双核机器能跑到1000分已属优秀,如今动辄数千分。这个分数是一个综合性能指标,如果A机器比B机器的分数高出30%,那么前者在大多数综合负载下都可能具有压倒性优势。

4. 隐藏的陷阱:NUMA架构

有时你会发现机器硬件配置很强,但运行某些特定程序时却异常缓慢。这时,请查看 lscpu 命令的输出。

如果显示 NUMA node(s): 2 或更多,就需要警惕了。这意味着这台物理服务器有两个或更多的“CPU插槽”及对应的内存控制器组。如果你的应用程序进程无意中跨NUMA节点访问内存,其延迟会让你怀疑人生。在性能测试时,若未考虑NUMA绑核优化,得出的数据很可能具有误导性。

内存:容量大,更要速度快

谈及内存,业务方通常只关心:“是64G还是128G?”

但作为技术人员,我们必须追问:带宽多少?延迟多少?

我曾接手一个Java应用,频繁发生Full GC,各种JVM调优手段收效甚微。最终发现根源是服务器上混插了一根低频内存条,将整台机器的内存频率拉低,导致内存吞吐量上不去,对象回收速度缓慢。

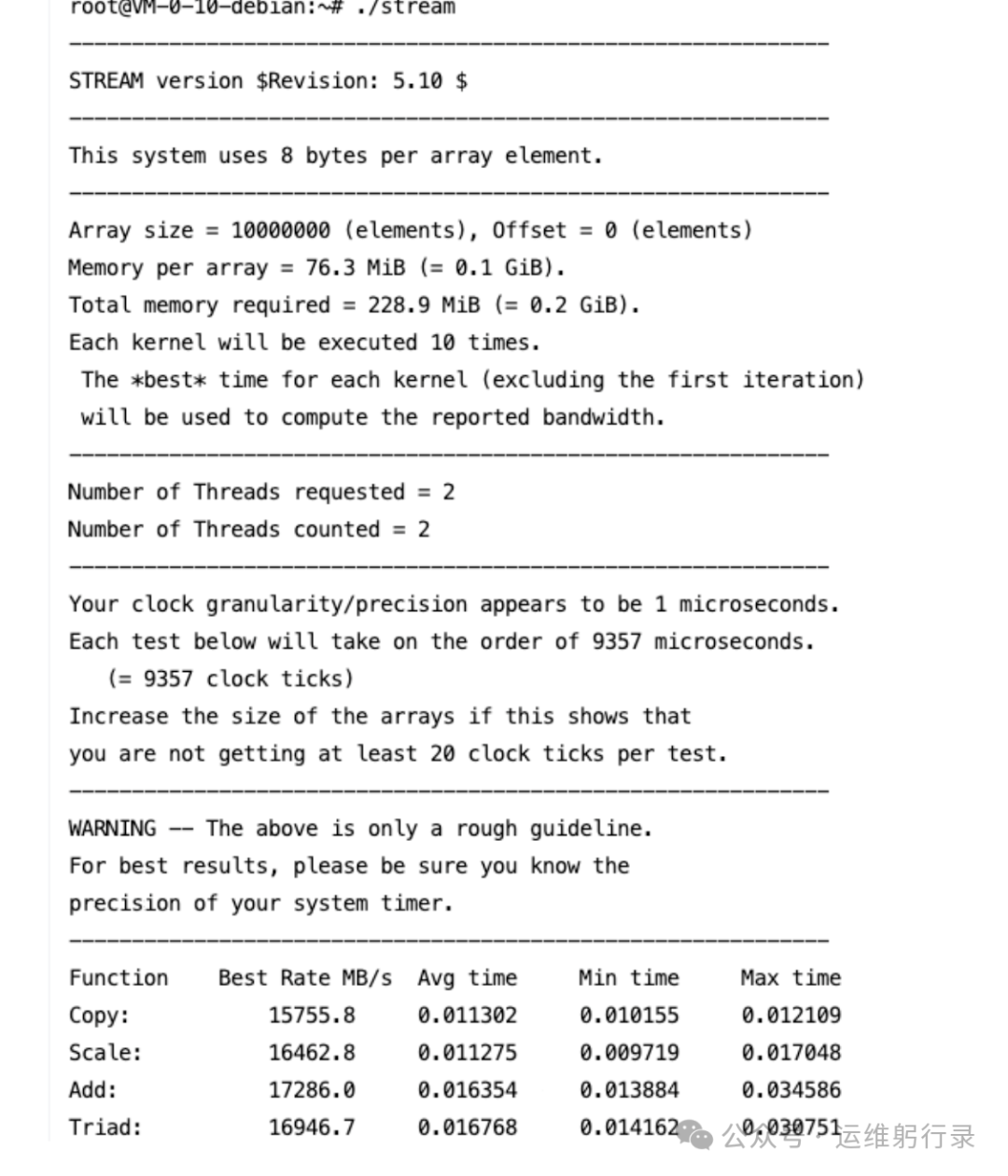

1. 吞吐量测试:Stream

这是一个经典的内存带宽测试工具。它主要测试四个操作:Copy(复制)、Scale(标量乘法)、Add(加法)、Triad(三元混合运算)。

我们需要下载并编译它(由C语言编写):

# 下载源码

wget https://raw.githubusercontent.com/jeffhammond/STREAM/master/stream.c

# 编译(启用OpenMP并行)

gcc -O2 -fopenmp stream.c -o stream

执行测试:

./stream

关注什么指标?

关注 Copy 和 Triad 操作的数值,单位是 MB/s。

- A机器:80000 MB/s

- B机器:120000 MB/s

这个差距是巨大的。如果你的业务是像Spark、Hadoop这类内存计算密集型的应用,B机器的表现将绝对碾压A机器,即便A机器的CPU更强也无济于事。

2. 延迟测试:Intel MLC (Memory Latency Checker)

下载地址:https://www.intel.com/content/www/us/en/download/736633/intel-memory-latency-checker-intel-mlc.html

Intel官方出品的利器。虽然是Intel工具,在AMD平台上通常也能运行(可能会有些警告信息,可忽略)。

为何要测试延迟?

对于高频交易系统,或Redis这类对延迟极度敏感的内存数据库,内存带宽往往不是瓶颈,但延迟哪怕只增加一点点,就可能导致QPS(每秒查询率)大幅下降。

./mlc --latency_matrix

该命令会输出一个矩阵,显示从某一个CPU核心访问另一个核心所属内存的延迟(单位:纳秒)。你会清晰看到,跨NUMA节点访问的延迟可能是本地访问的2-3倍。通过这个测试,你可以判断机器的内存子系统设计是否合理。

磁盘:最容易“翻车”的部件

磁盘存储是性能参数“水分”最多的领域。SATA SSD、NVMe SSD、SAS HDD,以及各类云硬盘,种类繁多。

供应商宣称:最大读写速度 3000MB/s。

你买回来实测:只有几百MB/s。

去找供应商理论,对方解释:哦,那是顺序读写速度,您测试的是随机读写。

但实际业务中,除了数据备份、批量导入导出,有多少场景是纯粹的顺序读写?绝大多数生产负载都是随机IO。

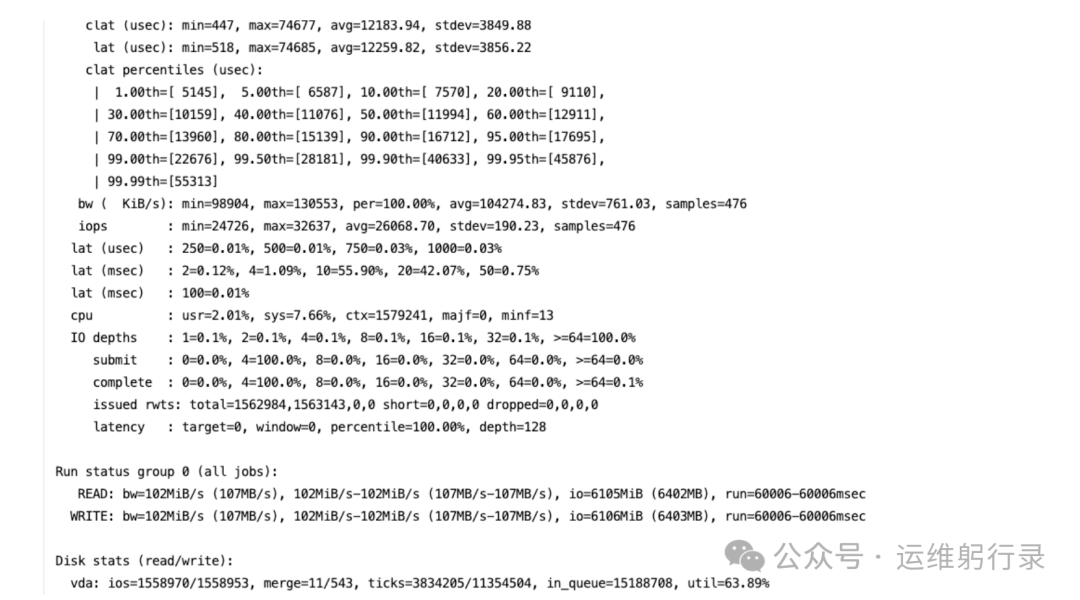

测试神器:FIO

请不要使用 dd 命令测试磁盘!它只能测个大概,且受操作系统缓存影响极大,完全没有参考价值。专业的磁盘测试请使用 FIO。

不过,FIO的参数极其复杂,如果脚本编写不当,测出的数据毫无意义。

如何设计一个可靠的磁盘测试方案?

必须分场景进行:

场景一:模拟数据库负载(随机读写,对延迟敏感)

数据库操作多以4KB或8KB的小块随机读写为主。

fio -filename=/data/testfile -direct=1 -iodepth=128 -thread -rw=randrw -ioengine=libaio -bs=4k -size=10G -numjobs=4 -runtime=60 -group_reporting -name=mytest

参数拆解(知识点):

-direct=1:关键! 绕过操作系统页缓存(Page Cache),直接对磁盘进行I/O。不加此参数,你测的可能是内存速度。-iodepth=128:I/O队列深度。现代NVMe SSD需要足够的队列深度才能发挥其并发性能。-rw=randrw:随机读写混合模式。-bs=4k:4KB块大小,这是最能考验磁盘随机IOPS(每秒读写次数)的设定。

如何解读结果?

重点关注两个值:

- IOPS:每秒的输入/输出操作次数。普通SATA SSD可能只有几万IOPS,而优秀的NVMe SSD可以达到几十万甚至上百万。

- lat (usec/msec):延迟。这是最重要的指标! 查看95th(95%分位)或99th(99%分位)的延迟值。

如果A机器IOPS很高,但其99%的请求延迟都超过了10毫秒(ms),那么这块盘在高并发业务高峰期必然会引起卡顿。我们需要的是既快又稳,而非单纯的峰值速度。

场景二:模拟日志写入(顺序写)

这属于吞吐量(带宽)测试。

fio -filename=/data/testfile -direct=1 -rw=write -bs=1M ...

将块大小(-bs)改为1MB,模式改为顺序写(write)。此时关注带宽(BW, Bandwidth)指标,例如是500MB/s还是2GB/s。

必须执行的操作:磁盘预热

如果你测试的是一块全新的SSD,务必先进行一次全盘顺序写入(填满),然后再进行上述测试。空盘(Fresh State)和脏盘(Used State)的性能可能相差一倍。许多云厂商提供的新盘跑分非常漂亮,但使用一段时间后性能骤降,往往是因为垃圾回收(GC)机制未能及时工作。

网络:带宽不是唯一指标

在网络方面,很多人认为:都是万兆(10Gbps)网卡,有什么可测的?

并非如此。

我曾遇到一个案例:两台均为万兆网卡的机器,A机器在运行Nginx时,并发连接稍高,系统负载就急剧上升。后来发现,A机器的网卡型号较老,不支持某些硬件卸载(Offload) 功能,且中断亲和性(IRQ Affinity)未优化,导致大量CPU时间被用于处理网络中断,而非业务逻辑。

1. 基础带宽测试:iperf3

这是最基础的测试。

- 服务端:

iperf3 -s

- 客户端:

iperf3 -c <服务器IP> -t 60

但这只能告诉你“道路的最大宽度”,无法反映“道路是否平坦、有无拥堵”。

2. 丢包与抖动测试:UDP模式

有时TCP测试显示带宽已跑满,但实际应用仍然很慢。可以尝试UDP测试。

iperf3 -c <IP> -u -b 1000M

观察 Jitter(抖动) 和 Packet Loss(丢包率)。

如果丢包率超过0.1%,对于Etcd、ZooKeeper这类对网络敏感的分布式协调服务而言,可能就是灾难性的。

3. PPS(每秒数据包转发率):真正的压力测试

对于网关、代理、防火墙等设备,PPS比纯带宽更重要。很多时候,带宽仅使用了1Gbps,网卡或CPU就已达瓶颈,因为处理的是海量的小数据包(如64字节)。

测试小包转发能力:

iperf3 -c <IP> -l 64 -t 60

强制使用64字节的小包进行测试。观察此时的带宽,并换算成PPS(PPS = 带宽 / (包大小 + 开销))。A机器可能跑到50万PPS时CPU就满载了,而B机器(如果配备了支持智能网卡(SmartNIC) 或更优网络栈)可能轻松处理500万PPS。

综合实战:拉出来溜溜,模拟真实业务

前面提到的都属于微基准测试(Micro-benchmarking),虽然专业,但有时与真实业务场景存在脱节。

最能反映机器综合性能的,是流量回放或模拟真实业务负载。

1. 编译Linux内核

这是一个经典且有效的“土方法”。编译内核过程涉及海量小文件的读写、密集的CPU计算和频繁的内存分配,能较好地考验机器的综合I/O、计算和内存子系统性能。

下载内核源码,使用最大并行编译:

make -j $(nproc)

记录编译耗时。

如果A机器耗时5分钟,B机器耗时8分钟。那么对于开发编译服务器或CI/CD构建服务器而言,A机器的效率优势是决定性的。

2. 数据库压测实战

如果你采购服务器主要用于运行MySQL,那么直接用 sysbench 对MySQL进行压测是最直接的。

准备测试数据:

sysbench oltp_read_write --table-size=1000000 --tables=10 prepare

执行压测:

sysbench oltp_read_write --table-size=1000000 --tables=10 --threads=64 --time=300 run

这里需要重点观察 TPS(每秒事务数) 和 QPS(每秒查询数)。

一个关键细节: 在运行压测时,务必在另一个终端窗口使用 iostat -x 1 和 top 命令监控系统资源。

观察A、B两台机器在达到相同QPS时,各自的资源消耗情况。

- A机器:QPS 5000,CPU使用率40%。

- B机器:QPS 5000,CPU使用率80%。

显然,A机器的资源利用效率更高,应对突发流量的余量更大。性能/资源消耗比(效率) 是衡量机器好坏的另一重要维度。在进行数据库选型与压测时,这类综合考量尤为重要。

那些“软”指标:看不见,但很要命

除了上述硬碰硬的性能数据,还有几个基于经验总结出的关键点:

1. 功耗与散热(针对物理服务器)

有些机器跑分很高,但功耗惊人,散热风扇噪音巨大。更严重的是,持续高负载下,CPU可能因温度过高而触发降频(Thermal Throttling)。

我曾踩过坑:测试时只跑了5分钟,性能卓越。上线后满载运行两小时,机箱过热,CPU主频被锁定在最低档,导致业务中断。

因此,性能测试必须包含压力测试(Burn-in Test)!至少满载运行1小时以上,观察性能曲线是否平稳。如果是一条明显的下降曲线,这台机器的散热设计就是不合格的。

2. 扩展性

A机器只有2个PCIe插槽,B机器有6个。现阶段可能看不出区别,但当未来业务需要添加NVMe硬盘扩展卡、GPU卡或额外万兆网卡时,A机器就可能面临淘汰。这虽非直接性能指标,却是评估机器长期价值的重要“加分项”。

3. 固件与驱动兼容性

有些新上市的服务器,硬件规格顶尖,但配套的固件(Firmware)或驱动(Driver)不成熟。安装CentOS 7找不到RAID卡驱动,安装Ubuntu后网卡时不时断连。

这种“软实力”的差距在短期测试中很难发现,需要查阅该型号服务器的用户社区反馈或官方的硬件兼容性列表(HCL)。

如何撰写给决策者的评估报告?

如果你直接把上面所有命令的原始输出扔给老板或采购部门,他们大概率会感到困惑。

你需要将数据提炼、对比并可视化。

建议的对比维度:

- 计算密度:单核心的Sysbench得分。

- I/O延迟分布:使用FIO测得的95%/99%延迟对比(用柱状图展示,一目了然)。

- 网络吞吐成本:结合采购成本,计算每Gbps有效带宽的成本。

- 业务模拟结果:MySQL在相同压力下的TPS对比。

最终形成结论,例如:

“综合评估,虽然B机型采购成本比A机型高10%,但在模拟我司核心数据库业务场景下,其TPS提升30%,且P99延迟降低50%。考虑到未来三年的业务增长预期和总拥有成本(TCO),建议采购B机型。”

这才是专业的运维或架构师应该提供的决策支持。更多此类实战经验与选型讨论,欢迎在云栈社区的技术论坛进行交流。

总结

判断两台服务器的优劣,绝不能仅看CPU核心数、内存容量这些表面参数。

- 看CPU:既要测单核性能(Sysbench),也要查多核协作有无NUMA瓶颈。

- 看内存:带宽(Stream)决定数据处理上限,延迟(MLC)决定响应速度下限。

- 看磁盘:别轻信最大顺序速度,要紧盯随机读写IOPS和访问延迟(FIO)。

- 看网络:带宽是基础,小包转发率(PPS)和稳定性(丢包/抖动)才是硬实力。

- 看实战:用编译内核、压测数据库等模拟真实场景,检验综合表现。

- 看稳定性:长时间满载压力测试,性能不衰减才是真可靠。

作为技术人员,我们需要具备“用数据说话”的严谨态度。供应商的宣传仅供参考,一行行命令跑出来的实测结果才值得信赖。数据从不说谎,前提是你得掌握正确的“询问”(测试)方法。希望这套涵盖CPU、内存、磁盘、网络的实测方法论,能帮助你在下次服务器选型时,做出更明智、更自信的决策。