1.1.1 背景与动机

在 Transformer 架构出现之前,循环神经网络(RNN)及其变体长短期记忆网络(LSTM)、门控循环单元(GRU)在 NLP 领域占据主导地位。这些模型能够处理序列数据,通过隐藏状态传递信息,从而捕捉文本中的上下文关系。然而,RNN 存在严重的梯度消失和梯度爆炸问题,尤其是在处理长序列时,模型很难学习到远距离的依赖关系,导致性能受限。卷积神经网络(CNN)虽然在图像识别等领域取得了巨大成功,但其卷积操作在处理序列数据的全局依赖关系时也存在不足。因此,研究人员迫切需要一种新的架构来突破这些限制,Transformer 架构应运而生。

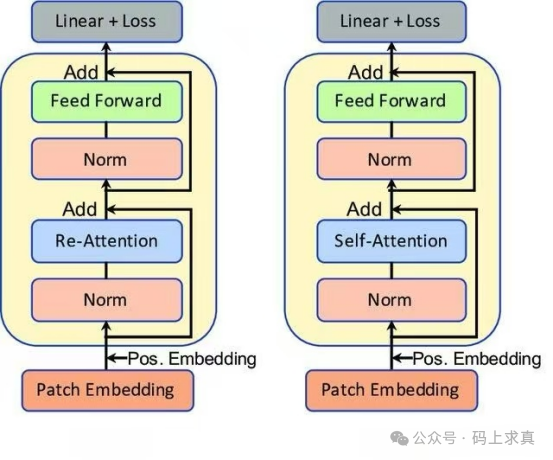

自注意力机制:Transformer 架构的核心创新之一是自注意力机制(Self-Attention)。与 RNN 按顺序处理序列不同,自注意力机制允许模型在处理每个位置的元素时,同时关注输入序列中的其他所有元素,通过计算元素之间的相关性,动态地分配权重,从而更有效地捕捉序列中的长距离依赖关系。例如,在翻译句子时,模型可以同时考虑句子中各个单词的信息,确定每个单词在翻译时的重要性,而不是像 RNN 那样依次处理每个单词。

多头注意力:为了进一步增强模型捕捉不同类型关系的能力,Transformer 引入了多头注意力(Multi-Head Attention)。它通过多个不同的注意力头并行计算,每个头关注输入序列的不同方面,然后将这些头的输出拼接起来,经过线性变换得到最终结果。这种方式使得模型能够从多个角度提取信息,丰富了表示能力,提高了对复杂语义关系的理解。

位置编码:由于自注意力机制本身不考虑序列中元素的顺序信息,Transformer 通过位置编码(Positional Encoding)为输入序列中的每个位置添加位置信息。它使用正弦和余弦函数生成与位置相关的向量,将其与输入的词向量相加,从而让模型能够感知到单词在序列中的位置,这对于理解语言的顺序性至关重要。

编码器 - 解码器架构:Transformer 采用了经典的编码器 - 解码器(Encoder - Decoder)架构。编码器部分由多个相同的编码器层堆叠而成,负责将输入序列转换为一系列上下文向量表示。解码器同样由多个解码器层组成,它在编码器输出的基础上,结合目标序列的部分信息(在训练时)或已生成的部分结果(在推理时),逐步生成目标序列。这种架构在机器翻译等序列到序列的任务中表现出色,能够有效地处理输入和输出之间的复杂映射关系。

1.1.3 对NLP领域的初步影响

原始 Transformer 架构在提出后,首先在机器翻译任务中展现出了巨大的优势。它打破了传统 RNN 和 CNN 在处理长序列时的局限,能够更好地捕捉句子之间的语义关系,实现更准确的翻译。与之前的模型相比,Transformer 的训练速度更快,能够利用大规模的并行计算资源,这使得在更短的时间内训练出更强大的模型成为可能。同时,Transformer 的成功也激发了学术界和工业界对其进一步研究和改进的热情,为后续一系列基于此架构的模型(如 GPT, BERT 等)Deep Learning 革命奠定了基础,并最终引领了如今的大模型时代。

常言道,程序员的世界由0和1构成,但我逐渐意识到——更多的时候,我们面对的是“咦?这怎么又出错了?” 希望本次对Transformer基础架构的解析,能帮助你更好地理解当代AI技术的基石。如果你对这类技术原理探讨感兴趣,欢迎来 云栈社区 与更多开发者交流。

|