在探讨下一代AI应用架构时,MCP(Model Context Protocol)与A2A(Agent to Agent Protocol)是两个无法绕开的核心协议。它们分别解决不同层面的问题:

- MCP 解决 “工具与数据如何安全、可控地暴露给 AI”。

- A2A 解决 “智能体之间如何高效、标准化地协作”。

AI 系统集成面临的新挑战

在构建复杂AI应用时,开发者常遇到以下痛点:

- 工具调用零散:每个团队都在重复封装自己的 function calling,鉴权、配额、审计逻辑重复造轮子。

- 数据接入割裂:数据库、知识库、云盘、业务 API 彼此孤立,模型上下文难以在不同任务间复用。

- 多智能体协作难:单个 Agent 能处理单点任务,但跨团队、跨系统的“接力赛”流程经常断链。

- 维护成本高:业务需求一旦变化,整个调用链就需要重新对接;安全策略、日志追踪也难以统一管理。

这正是 MCP 与 A2A 诞生的背景:一个管理“AI 如何连接工具与数据”,一个规定“Agent 之间如何对话”。它们并非替代模型本身的能力,而是为上层AI应用提供了“操作系统层”的标准化规范。

一、MCP(Model Context Protocol):让 AI 安全、可控地使用工具与数据

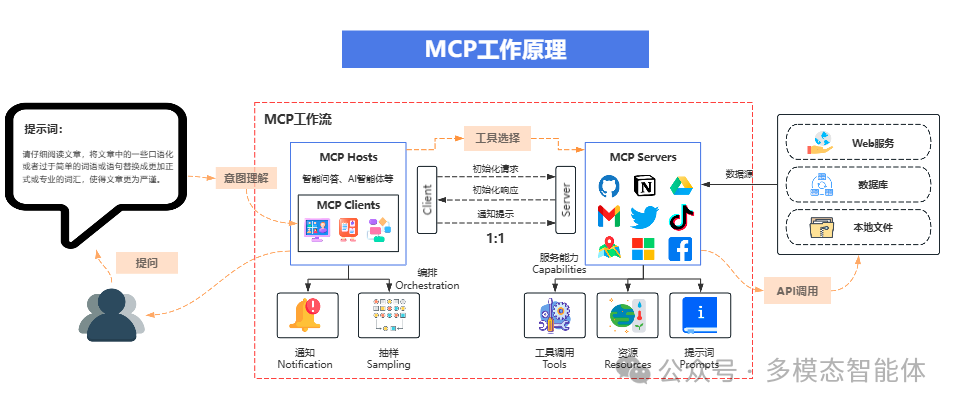

MCP 的核心是为大模型提供一套标准化的方式来发现、调用外部资源和工具,同时确保安全性和可观测性。

1.1 核心架构与角色分工

MCP 协议主要涉及四种角色:

- Host:承载与编排AI交互的环境,例如聊天客户端、IDE插件或专门的 Agent 运行时。

- Client:代表模型与MCP Server交互的一方,负责发起对工具、资源的调用请求。

- Server:将具体的资源、工具或提示模板以统一的MCP协议暴露出来。一个Host可以连接多个Server。

- 数据/服务:真实的后端数据源与业务API,如数据库、文件系统、内部微服务等。

典型工作链路是:Host(如一个聊天应用)内置 MCP Client,然后连接多个 MCP Server(分别对接CRM、文档库、内部审批系统)。每个 Server 再连接到真实的业务数据或服务。这样,Host 无需直接接触企业系统的敏感凭证,Server 可以按需授予 AI “只读资源”或“受控工具”的访问权限。

1.2 MCP 三大核心能力

MCP Server 主要暴露三种类型的能力,形成清晰的权限和职责边界:

- Resources(资源):只读的数据接口。让模型“看得见但改不了”,例如数据库的查询结果、文件目录列表、知识库条目。优点是安全、可缓存、易于审计。

- Tools(工具):可执行的函数或API。模型按照预定义的结构化格式(schema)进行调用,便于实现限流、重试、审计与精细化的权限管理。

- Prompts(提示模板):可复用的交互或工作流模板。将最佳实践沉淀为“可调用的提示”,使复杂的多步骤流程能保持一致性和可控性,减少模型的“幻觉”。

1.3 与传统 Function Calling 的区别

虽然都涉及模型调用外部功能,但MCP与传统的Function Calling定位不同:

- 定位不同:Function Calling(FC)更像是“模型的能力接口”,关注如何让模型触发一个函数;而 MCP 是“系统基础设施协议”,关注如何发现、鉴权、编排、审计这些函数与资源。

- 扩展性:MCP 支持动态的服务注册、能力声明和远程资源发现;FC 通常是单次模型会话内预定义的静态函数列表。

- 可整合性:两者并不冲突,可以协同工作。例如,Cherry Studio 这类工具既可以作为 MCP Client 挂载各类 MCP Server,同时在对话中仍可利用模型原生的 FC 来触发一些轻量级函数,将更重的操作交给背后的MCP工具链。

1.4 实战:如何快速实现一个 MCP Server

实现MCP Server通常有两条路径:将现有API快速适配为MCP,或使用轻量框架从零构建。

方案A:用 FastAPI 暴露业务能力,再“适配”为 MCP

适用场景:已有稳定的 REST 或 GraphQL 服务,希望以最小改造成本接入 MCP 生态。

示意代码如下(核心思想是将已有服务封装为 MCP 的 Tools 和 Resources,保持接口结构化与读写分离):

# mcp_server.py (示意)

from typing import List, Dict

from fastapi import FastAPI

from pydantic import BaseModel

# 1) 你现有的业务 API(这里用FastAPI示例)

api = FastAPI()

class Order(BaseModel):

id: str

status: str

amount: float

FAKE_DB: Dict[str, Order] = {

"1001": Order(id="1001", status="paid", amount=199.0),

"1002": Order(id="1002", status="shipped", amount=299.0),

}

@api.get("/orders/{order_id}", response_model=Order)

def get_order(order_id: str):

return FAKE_DB[order_id]

@api.post("/orders/{order_id}/refund")

def refund(order_id: str):

FAKE_DB[order_id].status = "refunded"

return {"ok": True}

# 2) MCP 适配层(核心:声明 Resources/Tools/Prompts)

# 下面以“伪代码风格”示意,实际请以所用 MCP SDK 文档为准

from mcp_runtime import MCPServer, resource, tool, prompt # 假设的 SDK 符号

mcp = MCPServer(name="orders-mcp")

@resource(path="orders/{order_id}", title="Order Detail", readonly=True)

def order_resource(order_id: str) -> dict:

# 将只读数据查询作为 Resource 暴露

return FAKE_DB[order_id].model_dump()

@tool(name="refund_order", desc="Refund an order by id")

def refund_tool(order_id: str) -> dict:

# 将可变更的操作作为 Tool 暴露,便于集中权限控制与审计

return refund(order_id)

@prompt(name="check_and_refund")

def check_and_refund_prompt():

# 预置流程模板,指导模型先查询再决策

return """你是客服助手:

1. 调用 resource: orders/{order_id} 读取订单状态

2. 若状态为 paid,调用 tool: refund_order

3. 产出简洁处理结果"""

if __name__ == "__main__":

# 常见传输方式:stdio / WebSocket;按 SDK 启动方法选择

mcp.run_stdio()

关键要点:

- 把只读查询封装为 Resource,强制建立“只读边界”。

- 把修改类操作封装为 Tool,实现单点鉴权与操作审计。

- 把标准操作步骤固化为 Prompt,降低模型生成“幻觉式流程”的风险。

方案B:使用 FastMCP 等轻量库快速构建

适用场景:快速构建概念验证(PoC),追求极简开发体验,一个文件即可启动服务。

示意代码如下(以 fastmcp 风格展示,具体 API 请以库的实际文档为准):

# server.py (示意)

from fastmcp import MCP, tool, resource, prompt

app = MCP("files-and-search")

@resource("files/{path}", title="Read File", readonly=True)

def read_file(path: str) -> str:

with open(path, "r", encoding="utf-8") as f:

return f.read()

@tool

def web_search(q: str, top_k: int = 3) -> list[str]:

# 调用你现有的搜索 API 或第三方 SDK

return [f"Result for {q} - {i}" for i in range(top_k)]

@prompt

def research_flow():

return """步骤:

1) 调用 tool:web_search 搜索综述

2) 读取 resource:files/{path} 参考内部规范

3) 输出带引用的结论"""

if __name__ == "__main__":

app.run_stdio()

适用场景与优势:

- 快速将企业内部系统以最小侵入方式暴露给 AI 使用。

- 统一能力声明与权限边界(Resources/Tools 分层清晰)。

- 服务可被多个不同的 Host 或 Agent 复用,减少重复对接成本。

- 便于审计与观测(每次调用均为结构化数据,易于追踪)。

二、A2A(Agent to Agent Protocol):智能体间的“通用语”

如果说 MCP 定义了 AI 与世界的交互方式,那么 A2A 则定义了 AI 与 AI 之间的协作方式。

2.1 设计目标:强调互操作性,而非透明性

- 核心理念:允许来自不同厂商、不同架构、不同模态的 Agent 保持高度自治。它们不共享内部内存、提示词或工具清单,只通过交换“结构化信息”和“可协作的任务语义”来完成合作。

- 核心好处:实现了可插拔、低耦合与跨平台演进,在不暴露各自内部实现细节的前提下完成高效协作。

2.2 六大核心组件

A2A 协议围绕以下六个核心组件构建协作模型:

- Agent Card:Agent 的“自述文件”,用于服务发现。包含名称、能力描述、认证需求、速率限制、可处理的任务类型等元数据。

- Task:一个可被多轮推进的协作任务单元。包含状态机(如待分配、进行中、等待输入、完成、失败)、任务上下文、超时设置、所有者等信息。

- Message:指令与对话的载体。既可以承载自然语言对话,也可以附带结构化的 JSON 指令。

- Artifact:任务产出的成果。可以是报告、代码片段、文件链接或任何结构化的结果,并能被后续参与协作的 Agent 消费。

- Push Notification:异步回调或事件订阅机制。便于 Agent 主动向上游推送进度更新或异常通知,避免低效的轮询。

- Streaming:支持流式输出。提升终端用户或上游 Agent 的实时交互体验,例如边思考边产出中间结论。

2.3 典型应用场景

- 多智能体协作:客服前台 Agent 判断用户问题“超出我的知识范围”后,将当前

Task 移交给“票务专家 Agent”。专家处理完成后,将结果 Artifact 回传给前台 Agent,由它继续与用户对话。

- 跨系统 RPA:一个中央的“流程编排 Agent”负责拆解复杂任务并分派;多个“执行 Agent”分别连接财务、人事、报销等不同企业系统,在各自权限内完成自动化操作,并通过 A2A 汇报进度和结果。

- 生态互通:让来自不同平台(例如 Coze 和 Dify)的 Agent 能够协作。双方无需共享各自的工具实现细节,仅通过 A2A 协议交换

Task、Message 和 Artifact 即可完成跨平台任务接力。

三、MCP vs A2A:如何选择与定位?

理解两者的差异是正确应用它们的关键。

3.1 核心对比一览

| 维度 |

MCP (Model Context Protocol) |

A2A (Agent to Agent Protocol) |

| 核心用途 |

解决 “AI ↔ 工具/数据” 的安全连接与调用问题。 |

解决 “Agent ↔ Agent” 之间的任务协作与通信问题。 |

| 交互对象 |

对接的是资源与工具(如数据库、API)。 |

对接的是任务与产物(如Task, Artifact)。 |

| 状态性 |

偏向“调用即用”,会话级状态管理较少。 |

内建任务状态机,支持多轮推进与复杂状态管理。 |

| 自主性 |

假定一个主导的 Agent 或用户去调用工具。 |

假定多个自治的 Agent 进行协商、接力与协作。 |

3.2 使用场景归纳

- 优先使用 MCP 当:你的 AI 需要查询数据库、读取知识库、执行受控的 API 操作,或者你想把企业内部“系统能力”进行标准化封装以供AI调用。

- 优先使用 A2A 当:你需要多个 Agent 进行跨平台的任务接力、协商、转交、合并结果,并且这些协作需要产出可以被后续环节消费的结构化

Artifact。

3.3 协同使用的常见架构

在实际的复杂系统中,MCP 和 A2A 往往是协同工作的:

- A2A 负责宏观的任务编排与接力,决定“哪位 Agent 在何时上场”。

- 每个 Agent 内部则通过 MCP 来安全、高效地访问自身所需的专用工具链与数据源。

这种架构的优势在于,将“对外的智能体协作”和“对内的工具调用”分别用不同的协议规范化。既能实现生态级的解耦与互操作,又能确保对企业内部系统的治理和安全控制。

四、进化方向:协议生态与开发新范式

MCP 与 A2A 的兴起,预示着 AI 应用开发范式正在发生深刻变化:

- 开发范式迁移:从“把功能硬编码在单个应用里”,转向“注册能力、声明边界、按协议接入”。开发者将更多精力花在“搭建连接、定义协议、实现可观测性与治理”上。

- 可插拔生态形成:遵循开放协议的工具与 Agent 可以被即插即用地组合,AI 应用从“单体智能”走向“拼装式智能”。

- 企业落地红利:统一的协议层带来了统一的审计入口、配额控制点和追踪链路,对接新系统的边际成本显著下降。

- 人机协作更可控:通过

Prompts 固化流程,通过 Resources/Tools 实现分权,通过 A2A 进行有明确边界的任务协作,使得 AI 系统的行为更加可控、可预测。

五、总结

MCP 与 A2A 的出现,标志着 AI 系统集成正从“手工作坊”模式迈向“标准化流水线”的关键一步。它们共同构成了一套清晰的分层规范:

- MCP 在底层解决了 AI 如何安全、可控地调用外部能力。

- A2A 在上层解决了多个 AI 之间如何可靠、高效地接力协作。

对于开发者和架构师而言,真正的启示在于从“埋头实现功能”转向“抬头定义接口”。与其让每个团队重复封装工具、孤立地接入数据、硬编码智能体调用链,不如尽早拥抱协议化思维:

- 用 MCP 统一“能力层”,将工具、数据、流程模板标准化,让 AI 系统能够像插件一样便捷、安全地接入企业服务。

- 用 A2A 统一“协作层”,让不同角色、不同平台的智能体能够基于任务和产物进行顺畅对话,共同完成复杂的跨系统业务流程。

这不仅带来了开发效率的质变,更是系统治理能力的升级:审计追踪、权限控制、故障定位从此有了统一的协议抓手。未来,强大的AI应用或许不再是一个个体积庞大的“单体智能”,而是一个个通过标准协议连接、各司其职、协同工作的“模块化组件”。MCP与A2A,正是构建这个未来所依赖的、至关重要的“接线图”与“对话规则”。对于希望深入探讨AI智能体与微服务化集成的开发者,欢迎在云栈社区交流更多实战经验。