当通用大语言模型面对特定业务场景,如公司产品客服或内部行政流程时,往往会因缺乏领域专业知识而表现不佳。仅依赖提示词工程强行注入知识,不仅消耗大量算力与电量,还受限于上下文窗口。模型微调技术则能以最小的计算成本,让模型学会“说内行话”。

本文将带你在个人设备上(如搭载M1芯片的MacBook),使用参数量仅为5亿的轻量级模型Qwen2.5-0.5B,通过LoRA(Low-Rank Adaptation)技术完成一次完整的微调实践。我们将从零开始准备与清洗数据,解析LoRA的核心原理,并解决微调中常见的“模型崩坏”与“欠拟合”问题。

一、基于Alpaca格式的数据准备与清洗

假设我们有一批从数据库或Excel导出的原始业务数据,保存在lora_train_data.csv文件中。数据模拟了特定的“回答风格”与“业务逻辑”,旨在让模型学会以专业口吻回答问题。

原始数据示例:

instruction,input,output

回答关于飞跃云产品的问题,扩容 1TB 多少钱?,"您好!飞跃云的专业版套餐提供 1TB 的大容量存储空间,其资费标准为每月 29 元人民币。您可以登录个人中心直接进行升级。"

回答关于飞跃云产品的问题,免费空间有多大?,"您好!感谢您的咨询。飞跃云为每一位注册用户提供 15GB 的基础免费存储空间,足以满足日常文档备份需求。"

指导用户进行技术集成,怎么安装 SDK?,"您好!安装飞跃云 SDK 非常简单。请在您的终端运行命令 `pip install feiyue-sdk` 即可完成安装。"

解答行政流程疑问,我可以天天在家办公吗?,"抱歉,根据公司现行政策,远程办公需要提前 24 小时在钉钉申请,且每周远程办公的天数上限为 2 天,无法每天在家办公哦。"

解释安全规定,机房可以带水进去吗?,"为了保障服务器运行安全,严禁携带任何液体进入 A1 机房。请您在进入前将水杯放置在门口的储物柜中。"

我们需要编写数据清洗逻辑,将这些原始数据转换为模型可读的json格式。

import re

import pandas as pd

import json

import os

def clean_text(text):

"""基础清洗逻辑"""

if not isinstance(text, str):

return ""

# 1. 去除多余的空白字符

text = re.sub(r'\s+', ' ', text).strip()

# 2. 去除一些特定噪声(如HTML标签,若有)

text = re.sub(r'<.*?>', '', text)

return text

def process_data(input_file, output_file, is_for_finetuning=False):

"""

处理数据流程

is_for_finetuning: 如果是微调数据,通常需要格式化为 {instruction, input, output}

"""

# 确保输出目录存在

output_dir = os.path.dirname(output_file)

if output_dir and not os.path.exists(output_dir):

os.makedirs(output_dir)

try:

df = pd.read_csv(input_file)

except FileNotFoundError:

print(f"错误:找不到输入文件 {input_file}")

return

# 应用清洗

df['output'] = df['output'].apply(clean_text)

if is_for_finetuning:

# 构造微调格式 (Alpaca 风格)

data = []

for _, row in df.iterrows():

data.append({

"instruction": "回答以下关于特定领域的问题:",

"input": row.get('input', ''),

"output": row.get('output', '')

})

with open(output_file, 'w', encoding='utf-8') as f:

json.dump(data, f, ensure_ascii=False, indent=2)

else:

# 仅保存清洗后的文本用于RAG

df.to_csv(output_file, index=False)

print(f"数据处理完成,已保存至 {output_file}")

if __name__ == "__main__":

process_data("./data/input/lora_train_data.csv", "./data/output/train_data.json", is_for_finetuning=True)

清洗后的数据./data/output/train_data.json格式如下,专为指令微调设计:

[

{

"instruction": "回答以下关于特定领域的问题:",

"input": "扩容 1TB 多少钱?",

"output": "您好!飞跃云的专业版套餐提供 1TB 的大容量存储空间,其资费标准为每月 29 元人民币。您可以登录个人中心直接进行升级。"

},

// ... 其他数据

]

在Alpaca格式中,instruction、output为必填项。其关键作用在于:

- instruction (指令):定义任务类型(例如:“你是一个客服”)。

- input (输入):提供具体的问题或上下文。

- output (输出):提供预期的标准答案。

这种分离的设计有助于模型更好地泛化,理解不同指令下应如何处理对应的输入。

二、LoRA原理、模型下载与微调实战

我们使用ModelScope(一个由阿里巴巴通义实验室等发起的模型开源平台)来下载模型。选择Qwen/Qwen2.5-0.5B-Instruct这个仅5亿参数的轻量模型,非常适合在个人笔记本上进行模型微调实验。

LoRA核心原理

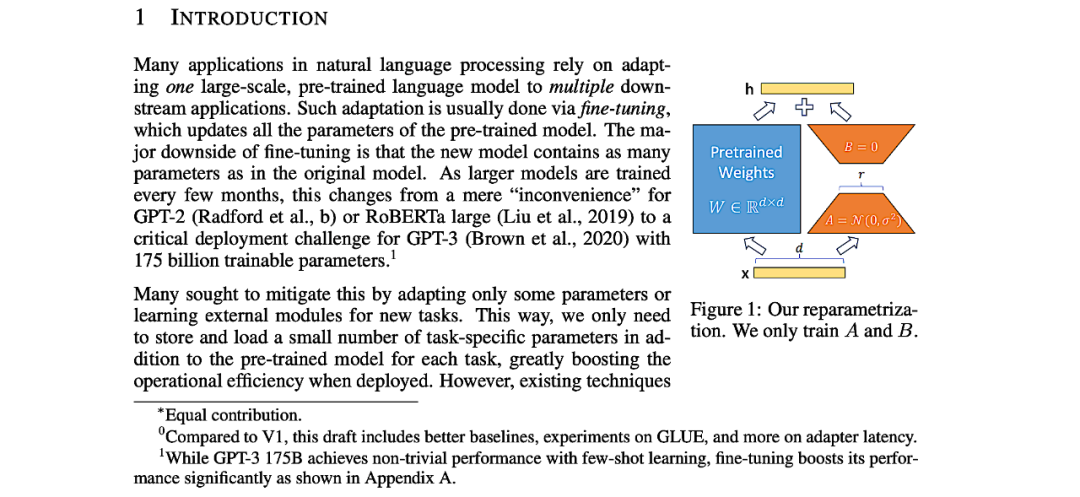

LoRA的核心思想是在预训练大模型旁添加一组可训练的“旁路矩阵”,而不是直接更新巨大的原始权重。其公式可简化为:微调后的权重 = 原始权重 + ΔW,其中ΔW被分解为两个低秩矩阵B和A的乘积(ΔW = B * A)。这极大地减少了需要训练的参数数量。例如,若原始权重维度为(4096, 4096),参数量约1600万。设置秩r=8,则B的维度为(4096, 8),A为(8, 4096),新增参数量仅约6.5万。

完整的下载与微调代码如下:

import os

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

from peft import LoraConfig, get_peft_model, TaskType

from trl import SFTTrainer, SFTConfig

from datasets import load_dataset

from modelscope import snapshot_download

MODEL_ID = "Qwen/Qwen2.5-0.5B-Instruct"

DATA_PATH = "./data/output/train_data.json"

OUTPUT_DIR = "./model/lora_adapter"

def train_lora():

# 1. 通过ModelScope下载并加载模型

model_dir = snapshot_download(MODEL_ID)

tokenizer = AutoTokenizer.from_pretrained(model_dir)

model = AutoModelForCausalLM.from_pretrained(

model_dir,

device_map="auto",

torch_dtype="auto"

)

# 2. 配置LoRA

peft_config = LoraConfig(

task_type=TaskType.CAUSAL_LM,

inference_mode=False,

r=8, # LoRA 秩

lora_alpha=32,

lora_dropout=0.1

)

model = get_peft_model(model, peft_config)

model.print_trainable_parameters() # 查看可训练参数量

# 3. 加载数据集

dataset = load_dataset("json", data_files=DATA_PATH, split="train")

# 4. 定义Prompt格式化函数

def formatting_prompts_func(example):

text = f"### Instruction:\n{example['instruction']}\n\n### Input:\n{example['input']}\n\n### Response:\n{example['output']}"

return text

# 5. 配置训练参数

sft_config = SFTConfig(

output_dir=OUTPUT_DIR,

max_length=512,

per_device_train_batch_size=1, # M1 Mac建议设为1

gradient_accumulation_steps=4,

num_train_epochs=3,

learning_rate=2e-4,

logging_steps=1,

save_strategy="no",

packing=False,

)

# 6. 初始化Trainer并开始训练

trainer = SFTTrainer(

model=model,

train_dataset=dataset,

args=sft_config,

peft_config=peft_config,

formatting_func=formatting_prompts_func,

)

trainer.train()

# 7. 保存LoRA适配器

model.save_pretrained(OUTPUT_DIR)

print("LoRA 微调完成,模型已保存。")

if __name__ == "__main__":

train_lora()

执行成功后,损失函数(loss)通常会有明显下降。生成的adapter_config.json文件记录了微调的关键配置,例如秩r=8,以及微调的目标模块(如q_proj, v_proj)。

三、微调效果评估与常见问题分析

使用以下代码加载微调后的模型并进行测试:

import torch

import os

from transformers import AutoModelForCausalLM, AutoTokenizer

from peft import PeftModel

def test():

# 路径配置(请根据实际情况调整)

lora_path = "./model/lora_adapter"

base_model_path = "/本地/模型/缓存/路径/Qwen/Qwen2.5-0.5B-Instruct"

tokenizer = AutoTokenizer.from_pretrained(base_model_path)

model = AutoModelForCausalLM.from_pretrained(

base_model_path,

torch_dtype=torch.float16,

device_map="auto"

)

model = PeftModel.from_pretrained(model, lora_path)

# 准备Prompt,格式需与训练时一致

instruction = "回答关于飞跃云产品的问题"

user_input = "免费空间有多大?"

prompt = f"### Instruction:\n{instruction}\n\n### Input:\n{user_input}\n\n### Response:\n"

# 生成回答

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

with torch.no_grad():

output = model.generate(**inputs, max_new_tokens=100)

response = tokenizer.decode(output[0], skip_special_tokens=True)

print(response.split("### Response:\n")[-1]) # 提取回答部分

在初次微调后,你可能会遇到两种典型问题:

- 模型崩坏:输出变为无意义字符(如一连串“!!!”)。这通常与学习率过大、训练轮数过多导致过拟合有关。

- 欠拟合:模型未学到数据中的关键信息(例如,始终回答“免费10GB”,而非数据中的“15GB”)。这常因训练数据量太少、学习率过小或训练轮数不足导致。

四、关键调优:数据量与秩(Rank)的影响

对于参数量达数亿的模型,仅用十几条数据微调,梯度更新信号可能过于微弱。一个有效的策略是增加高质量训练数据的曝光次数。例如,可以将关键样本(如包含“15GB”答案的数据)复制多份,以强化模型记忆。

同时,调整LoRA的秩(r) 也是一个重要手段。更小的秩(如从8降至4)意味着更少的可训练参数,有时反而能让小数据集上的优化过程更稳定、高效。

通过“增加关键数据重复次数”与“适当降低秩”的组合策略进行调优后,损失函数(loss)显著下降,模型最终能输出符合预期的专业回答:“您好!感谢您的咨询。飞跃云为每一位注册用户提供 15GB 的基础免费存储空间...”。

本次实践表明,对Qwen2.5-0.5B这类小参数模型进行LoRA微调,在个人电脑上完全可行。关键在于平衡数据量、秩大小、学习率与训练轮数。通过细致的调优,能够以极低的成本让轻量级模型获得优秀的领域自适应能力。